Inteligencia Artificial

Este nuevo LIDAR logra que un coche autónomo vea el mundo casi como un humano

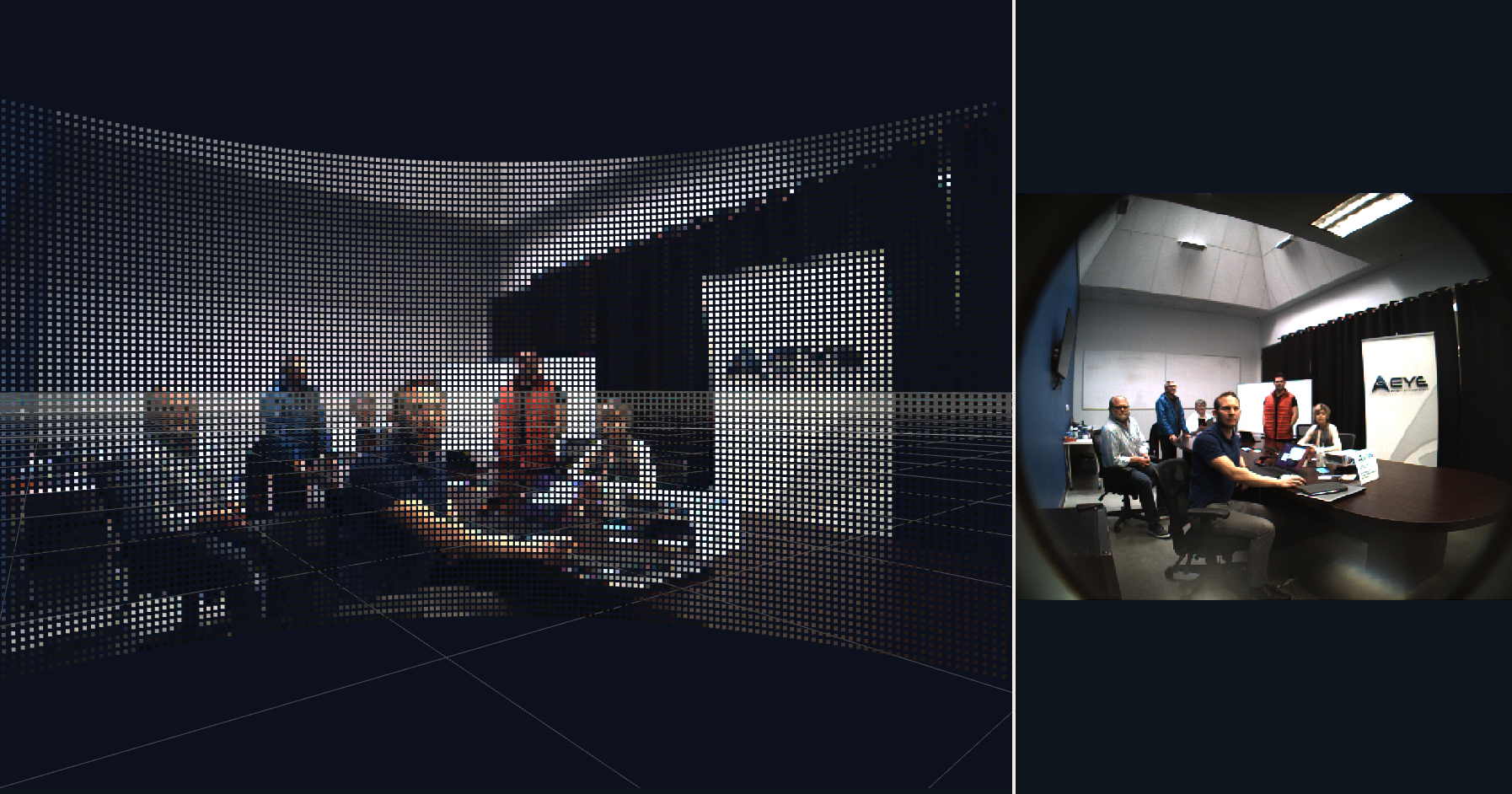

Combina una cámara LIDAR de estado sólido e inteligencia artificial integrada para procesar imágenes en tiempo real que le permiten decidir dónde centrar su atención en función del entorno. Aunque aún no se sabe su precio, su responsable adelanta que competirá con los de alta gama

Al mirar fijamente a través del parabrisas de un vehículo nadie ve el mundo de la misma manera que una cámara instalada en el salpicadero. El funcionamiento interno del cerebro humano distorsiona la imagen para dar prioridad los detalles centrales de la escena mientras se mantiene la atención en las zonas periféricas para detectar el peligro. El CEO de la start-up AEye, Luis Dussan, está intentando que los coches autónomos adquieran esta misma habilidad con un nuevo tipo de sensor híbrido.

El dispositivo contiene un LIDAR de estado sólido, una cámara para luz tenue y varios chips que ejecutan algoritmos de inteligencia artificial (IA) integrados que se pueden reprogramar sobre la marcha. Eso permite que el sistema priorice su ubicación para dar a los vehículos una visión más refinada del mundo.

Dussan trabajó en laboratorios de electrónica y óptica en Lockheed Martin, Northrop Grumman y el Laboratorio de Propulsión a Chorro de la NASA, y paralizó su doctorado en física computacional para lanzar la start-up. Si idea inicial era trabajar en sistemas de inteligencia artificial para mejorar la capacidad de los vehículos de conducir de forma autónoma. Pero pronto descubrió que los sensores disponibles no podían proporcionar los datos que él quería usar. El responsable cuenta: "Nos dimos cuenta de que necesitábamos construir nuestro propio hardware. Y así lo hicimos".

La mayoría de los automóviles autónomos utilizan sensores LIDAR, que hacen rebotar los rayos láser en los objetos cercanos para crear mapas precisos en 3D de su entorno. Las mejores versiones disponibles en el mercado, hechas por Velodyne, son bastante buenas, pero presentan un par de problemas. En primer lugar, son caros (ver Los 'ojos' 'low cost' del coche autónomo no son seguros para viajar por carretera). En segundo, no son nada flexibles porque los láseres apuntan a ángulos predeterminados. Eso significa que un automóvil podría capturar una vista muy detallada del cielo cuando, por ejemplo, se eleva por una colina o mirar demasiado lejos durante la conducción a baja velocidad de la ciudad, y no hay forma de cambiarlo.

La alternativa al LIDAR mecánico es el LIDAR de estado sólido, que utiliza electrónica para dirigir rápidamente un rayo láser hacia adelante y hacia atrás para lograr el mismo efecto que los dispositivos mecánicos. Muchas empresas se han aprovechado de la tecnología porque puede fabricarse a bajo precio. Pero los sensores resultantes, que se ofrecen por solo unos 100 euros, escanean una cuadrícula rectangular regular invariable y no ofrecen el estándar de datos requerido para conducir a velocidades de autopista.

AEye también apuesta por los dispositivos de estado sólido, pero quiere usarlos de forma distinta. Su idea consiste en programarlos para dirigir rayos láser a las áreas de mayor interés en lugar de una cuadrícula fija. La empresa aún no ha revelado detalles sobre la precisión con la que puede guiar los rayos, pero afirma que debería poder ver hasta 300 metros con una resolución angular de solo 0,1°. Eso iguala los resultados de los dispositivos mecánicos líderes del mercado.

Pero el rendimiento viene con una advertencia: la configuración de AEye no escanea una escena completa con altos niveles de detalle todo el tiempo. Se limita a escanear toda el área en una resolución más baja o escanear áreas más pequeñas en una resolución más alta.

Aun así, el hecho de que pueda ser reprogramado a voluntad es una característica útil. Dussan detalla: "Se puede cambiar la resolución, la tasa de revisión de escenas y el alcance en cualquier momento. El mismo sensor puede adaptarse". En autopista, su vista podría centrarse principalmente en el carril, como un ojo humano, y reunir menos puntos de datos en la periferia de la imagen. En calles urbanas, podría abarcar todo el campo de visión por igual, pero cambiar al azar de dónde se adquieren los puntos para minimizar las posibilidades de obviar un obstáculo.

El dispositivo también puede usar datos de su cámara de varias maneras ingeniosas. En primer lugar, puede añadir color a las imágenes brutas del LIDAR. Eso difiere un poco de la forma en que la mayoría de los coches autónomos procesan los datos, ya que los envían a un ordenador central para que los fusione con los datos de otros sensores. Un procesamiento tan rápido como el de AEye resulta útil para detectar rápidamente objetos en los que el color es importante, como las luces de freno.

Pero su innovación clave es cómo puede ser utilizada la cámara para dirigir dónde se enfocan los rayos del LIDAR. Con algoritmos de reconocimiento de imágenes de alta velocidad ejecutados en sus chips, explica Dussan, el LIDAR puede dirigir su mirada para prestar especial atención a los automóviles, peatones o cualquier otra cosa que la inteligencia artificial de abordo le pida que priorice.

El profesor adjunto de ingeniería de la información de la Universidad de Oxford (Reino Unido) y fundador de Oxbotica, una spin-off de conducción autónoma (ver Cualquier coche antiguo se vuelve autónomo gracias a este software), Ingmar Posner, dice que ese tipo de imágenes adaptativas "es bueno para la interpretación de alto nivel del mundo". Sin embargo, sugiere que las empresas de coches autónomos probablemente no elegirían este sistema porque sí. En su lugar, podrían optar por emplear un conjunto de sensores corrientes que complementen a un dispositivo como el de AEye por razones de seguridad.

De cualquier forma, hay un detalle que no hay que obviar: el dispositivo de AEye solo tiene un campo de visión de 70°, lo que significa que un coche necesitaría cinco o seis sensores repartidos por el vehículo para cubrir los 360°. Y eso plantea una pregunta clave: ¿cuánto costará? Dussan rehúsa comprometerse con una cifra, pero deja claro que será una opción de gama alta. No podrá competir con dispositivos de estado sólido de 100 euros. sino que desafiará a los dispositivos de alta resolución como los que fabrica Velodyne. Para un conjunto completo de sensores que rodee del vehículo, dice: "Si comparas sin mezclar churras con merinas, vamos a ser el sistema de menor coste".

Algunas personas ya parecen estar convencidas de la idea. AEye dice que actualmente está trabajando con "uno de los principales fabricantes del planeta" para probar sus sensores en taxis robóticos.