Investigadores de McAfee han logrado engañar a un sistema de reconocimiento facial para que identifique a la persona de una fotografía como si fuera otra. Su trabajo intenta demostrar lo vulnerables que son estos sistemas, cada vez más utilizados en procesos como la vigilancia y la contratación

Un equipo de investigación ha demostrado que puede engañar a un moderno sistema de reconocimiento facial para que crea que ve a alguien que no está allí.

Los investigadores de la empresa de ciberseguridad McAfee organizaron el ataque contra un sistema de reconocimiento facial similar a los que se utilizan actualmente en los aeropuertos para la verificación de pasaportes. Mediante aprendizaje automático, crearon una imagen que parecía una persona para el ojo humano, pero que el algoritmo de reconocimiento facial identificaba como otra diferente, un ejemplo de cómo engañar a la máquina para permitir que alguien suba a un avión a pesar de no aparecer en la lista de pasajeros.

El autor principal del estudio, Steve Povolny, detalla: "Si nos colocamos frente a una cámara en directo que utiliza reconocimiento facial para identificar e interpretar a quién ve y compararlo con una foto de pasaporte, podemos provocar ese tipo de clasificación errónea dirigida de manera realista y repetida".

Cómo funciona

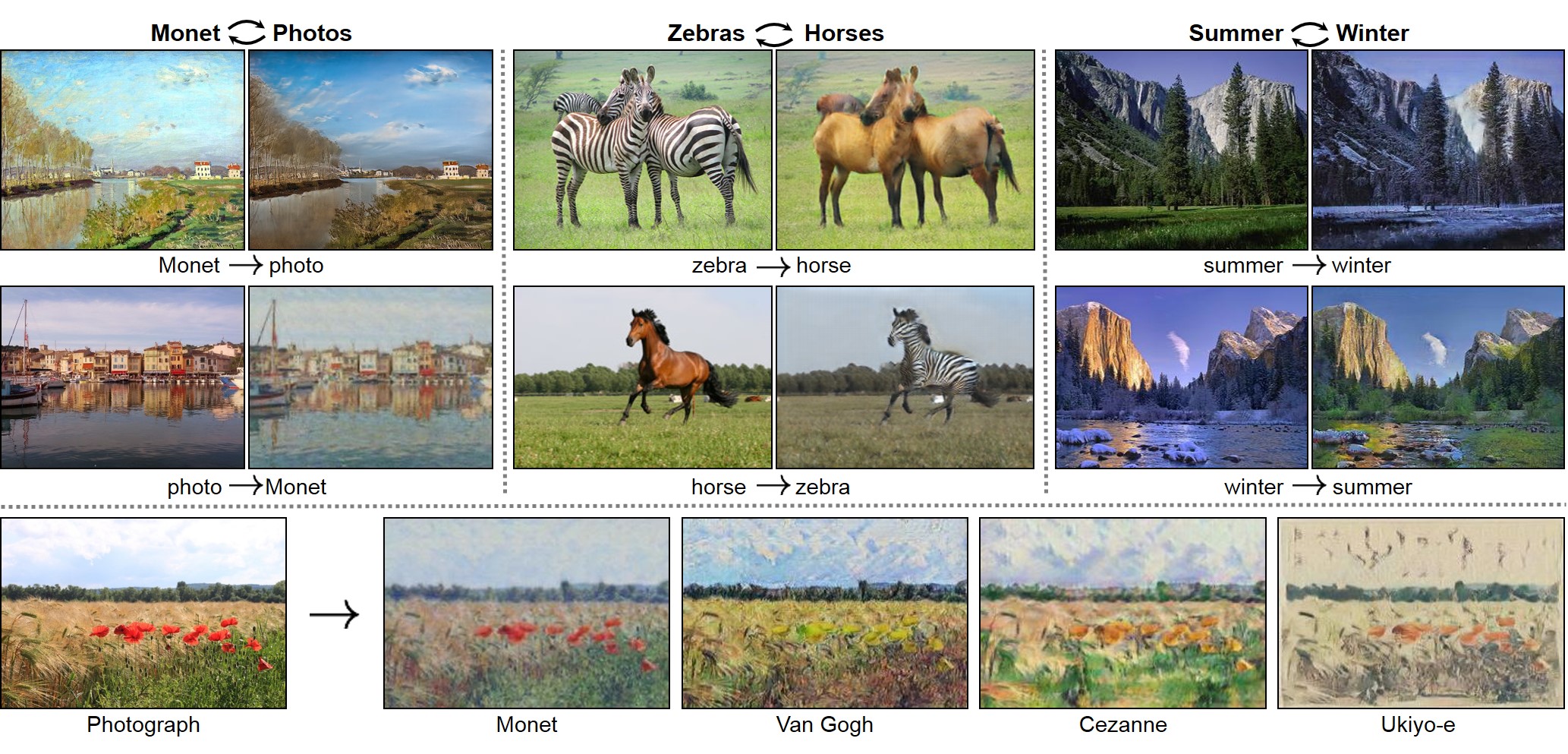

Para confundir al algoritmo, los investigadores utilizaron otro algoritmo de traducción de imágenes conocido como CycleGAN, especializado en transferencias de estilo de una fotografía a otra. Por ejemplo, puede hacer que una foto de un puerto parezca pintada por Monet, o que una foto de montañas tomada en verano parezca que fue captada en invierno.

El equipo de McAfee usó 1.500 fotos de los dos autores principales del proyecto y las introdujo en CycleGAN para transformarlas entre sí. Al mismo tiempo, utilizó el algoritmo de reconocimiento facial para comprobar las imágenes generadas por CycleGAN para ver a quién reconocía. Después de generar cientos de imágenes, CycleGAN finalmente creó una imagen falsa que a simple vista se parecía a la persona A, pero que engañó al reconocimiento facial para que creyera que era la persona B.

Aunque el estudio plantea claras preocupaciones sobre la seguridad de los sistemas de reconocimiento facial, existen algunas reservas. Primero, los investigadores no tenían acceso al sistema real que utilizan los aeropuertos para identificar a los pasajeros. En lugar de eso, lo aproximaron a un algoritmo de código abierto de última generación. Povolny matiza: "Creo que para un atacante eso sería la parte más difícil de superar, ya que no tiene acceso al sistema objetivo". No obstante, dadas las grandes similitudes entre los algoritmos de reconocimiento facial, considera que es probable que el ataque funcione incluso en el sistema aeroportuario real.

Cómo funcionan las GAN Las redes generativas antagónicas (GAN, por sus siglas en inglés) son un tipo de algoritmo que hábilmente enfrenta a las redes neuronales entre sí para generar mejores resultados. En una GAN tradicional, solo hay dos redes: una generativa que se entrena con un conjunto de datos, por ejemplo, con los paisajes de verano, para crear más paisajes estivales; y otra discriminativa o antagónica que compara los paisajes generados con el mismo conjunto de datos para decidir si son reales o falsos. CycleGAN modifica este proceso al tener dos redes generativas y dos antagónicas. También hay dos conjuntos de imágenes, como paisajes de verano y paisajes de invierno, que representan los tipos de fotos que se quieren mezclar. Esta vez la primera red generativa se entrena con las imágenes de los paisajes estivales con el objetivo de intentar generar paisajes invernales. La segunda red generativa, por su parte, se entrena con las imágenes de los paisajes invernales para generar paisajes estivales. Ambas redes discriminatorias trabajan duro para descubrir las imágenes falsas hasta que los paisajes falsos sean indistinguibles de los reales.

En segundo lugar, actualmente un ataque de este tipo requiere mucho tiempo y recursos. CycleGAN necesita ordenadores potentes y experiencia para entrenar y ejecutar.

Pero los sistemas de reconocimiento facial y de control automatizado de pasaportes se utilizan cada vez más para la seguridad de los aeropuertos en todo el mundo, un cambio acelerado por la pandemia de coronavirus (COVID-19) y por la demanda de sistemas sin contacto. Esta tecnología también se usa ampliamente por gobiernos y corporaciones en áreas como la aplicación de la ley, contratación y seguridad de eventos, aunque muchos grupos han pedido una moratoria sobre tales desarrollos y algunas ciudades han prohibido esta tecnología.

Existen otros intentos técnicos de obstaculizar el reconocimiento facial. Un equipo de la Universidad de Chicago (EE. UU.) lanzó recientemente la herramienta Fawkes, destinada a "camuflar" los rostros alterando ligeramente sus fotos en las redes sociales para engañar a los sistemas de inteligencia artificial (IA) que dependen de las bases de datos con miles de millones de esas imágenes. Los investigadores de la empresa de inteligencia artificial Kneron también mostraron cómo las máscaras pueden engañar a los sistemas de reconocimiento facial que ya se utilizan en todo el mundo.

Los investigadores de McAfee afirman que su objetivo consiste en demostrar las vulnerabilidades inherentes en estos sistemas de IA y dejar claro que los seres humanos deben mantenerse involucrados.

Povolny concluye: "La inteligencia artificial y el reconocimiento facial son herramientas increíblemente poderosas para ayudar en el proceso de identificación y comprobación de personas. Pero cuando simplemente se cogen y sustituyen ciegamente un sistema existente que se basa completamente en un trabajo humano, sin tener ningún tipo de control adicional, entonces de repente quizás se ha introducido una debilidad mayor que la que existía antes".