Mientras otras áreas de la IA, como la conducción autónoma, han sido bien reguladas, los usos comerciales de esta tecnología en áreas como la selección de personal y contratación son cada vez más comunes a pesar de su nulo respaldo científico y de su enorme impacto sobre la vida de la gente

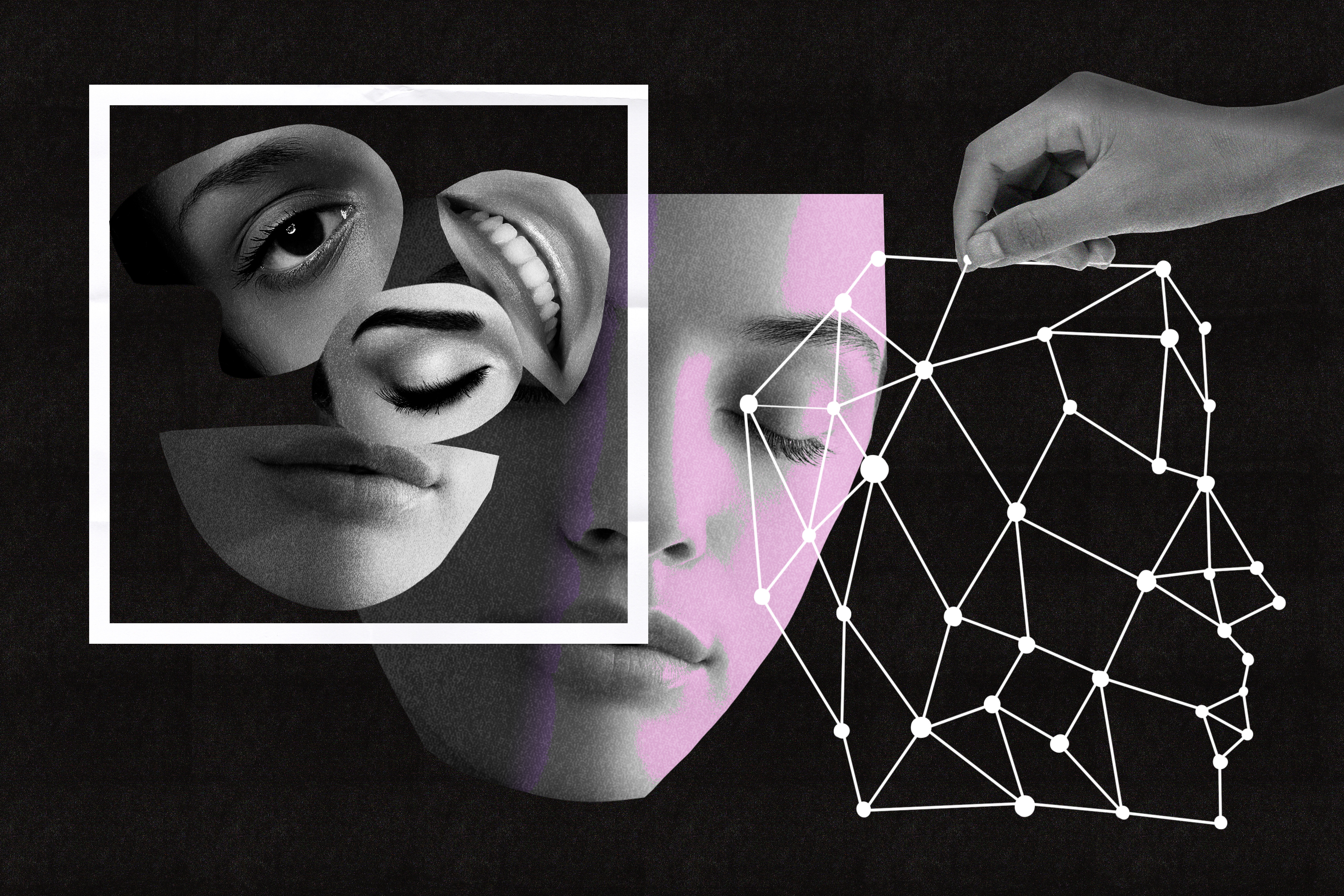

Quizá haya oído hablar de sistemas de inteligencia artificial (IA) capaces de realizar entrevistas de trabajo. Puede que incluso usted mismo ya haya sido entrevistado por una. Algunas empresas como HireVue afirman que su software es capaz de analizar entrevistas en vídeo para determinar el "nivel de empleabilidad" de cada candidato. Estos algoritmos no solo se fijan en las expresiones y en la postura, también indican a los empleadores si el entrevistado es tenaz o bueno para trabajar en equipo, una evaluación que podría podrían influir mucho en el futuro de un candidato. En EE. UU. y Corea del Sur, donde la contratación asistida por IA se ha vuelto muy popular, los consultores laborales han empezado a preparar a sus clientes para que sepan abordar una entrevista liderada por un algoritmo. Este tipo de tecnología también se está implementando en las aulas escolares y ya se ha utilizado en distintos estudios para detectar mentiras en vídeos en las salas del poder judicial.

Pero muchas de las cosas que prometen estos sistemas de IA no cuentan con ningún tipo de respaldo científico. No existen estudios sólidos ni revisados por expertos que demuestren que analizar la postura corporal o las expresiones faciales ayuda a identificar a los mejores candidatos (en parte porque las empresas no revelan sus métodos). Como resultado, todo el bombo alrededor del reconocimiento de emociones, cuya industria se prevé que superará los 23.000 millones de euros para 2023, ha provocado el rechazo de los especialistas en ética tecnológica y de los activistas. Todos ellos temen que esta tecnología genere el mismo tipo de problemas de discriminación que las condenas predictivas y los algoritmos que deciden a quién alquilar un inmueble.

La creciente popularidad de la tecnología también preocupa a los investigadores. Muchos coinciden en que su trabajo, en el que utilizan varias técnicas (como análisis de microexpresiones y de la voz) para distinguir e interpretar las expresiones humanas, se está incorporando y utilizando con fines comerciales que no se basan en la ciencia. Creen que la falta de regulación gubernamental no solo es mala para los usuarios. También lo es para ellos.

Cosas buenas y malas

El reconocimiento de emociones, un subconjunto de la computación afectiva, sigue siendo una tecnología reciente. Mientras los investigadores de IA probaban los límites de lo que realmente era posible medir y cuantificar sobre el comportamiento humano y lo que no, la subyacente ciencia de las emociones siguió desarrollándose.

En el campo todavía hay varias teorías sin demostrar, por ejemplo, si cada emoción se pueden distinguir de forma individual o se agrupan en subconjuntos. Además, las mismas expresiones pueden significar cosas diferentes en función de la cultura. En julio, un metaestudio concluyó que observar la cara de una persona no es suficiente para juzgar sus emociones. El estudio tuvo una amplia difusión mediática, incluida la de este propio medio: La IA es incapaz de identificar emociones a partir de la expresión facial.

Los investigadores del reconocimiento de emociones son plenamente conscientes de sus limitaciones. Los que entrevistamos para nuestro artículo tuvieron mucho cuidado con las afirmaciones sobre lo que su trabajo es capaz de hacer y lo que no. Muchos destacaron que el reconocimiento de emociones en realidad no sirve para evaluar las emociones internas y la experiencia de una persona. Solo permite estimar cómo otras personas percibirían las emociones de ese individuo, o sugerir tendencias generales basadas en la población (como una película que provoca, de media, una reacción más positiva que otra). "Ningún investigador serio afirmaría que es capaz de analizar las partes que se mueven en la cara y saber lo que piensa la gente", asegura la experta en informática afectiva de la Universidad de Augsburgo (Alemania) Elisabeth André.

Los investigadores también señalan que el reconocimiento de emociones implica mucho más que simplemente mirar la cara de alguien. También incluye un análisis de la postura del cuerpo, la forma de caminar y otras características, así como el uso de sensores biométricos y de audio para reunir datos más globales.

Estos matices son positivos e importantes, pues permiten descalificar las aplicaciones como HireVue, que afirman evaluar la competencia inherente de un individuo (HireVue no respondió a una solicitud de comentarios), y dar respaldo a otras, como las tecnologías que intentan convertir a las máquinas en colaboradores más inteligentes y compañeros para los humanos.

Un robot humanoide podría sonreír cuando lo hagan sus compañeros humanos, una acción de reflejo que los propios humanos suelen hacer para que las interacciones parezcan más naturales. Un dispositivo portátil podría recordarnos que hagamos un descanso si detecta niveles altos de cortisol (la hormona del estrés) en el cuerpo. Ninguna de estas aplicaciones requiere que un algoritmo analice nuestros pensamientos o sentimientos; solo necesitan estimar una respuesta adecuada frente a los niveles de cortisol o al lenguaje corporal identificados. Tampoco toman decisiones de alto impacto sobre la vida de un individuo, a diferencia de los algoritmos de contratación sin respaldo científico. La científica principal de datos de la organización sin ánimo de lucro DataPop Alliance, Nuria Oliver, afirma: "Si queremos que los ordenadores y los sistemas informáticos nos ayuden, sería bueno que tuvieran una idea de cómo nos sentimos".

Pero una gran parte de este matiz se pierde cuando la investigación de reconocimiento de emociones acaba siendo utilizada en lucrativas aplicaciones comerciales. Los mismos algoritmos de control de estrés en un dispositivo móvil podrían ser utilizados por una empresa que quiera asegurarse de que sus empleados trabajan lo suficiente. Incluso para empresas como Affectiva, fundada por investigadores que destacan la importancia de la privacidad y de la ética, los límites son difíciles de definir. Esta compañía ha vendido su tecnología a HireVue . (Affectiva no quiso comentar sobre compañías concretas).

Hace falta regulación urgente

En pasado diciembre, el instituto de investigación AI Now solicitó que las tecnologías de reconocimiento de emociones se prohíban "en la toma de importantes decisiones que influyen en la vida de las personas". Es uno de los primeros llamamientos para prohibir una tecnología que ha recibido menos atención regulatoria que otras aplicaciones de inteligencia artificial, a pesar de que su uso en la selección de personal y en las aulas podría tener efectos graves.

Pero el Congreso de EE. UU. parece estar haciendo justo lo contrario: acaba de celebrar su tercera audiencia sobre reconocimiento facial en menos de un año, y se ha convertido en una cuestión importante para las elecciones estadounidenses de 2020. Los activistas intentan boicotear las tecnologías de reconocimiento facial, y varios representantes reconocen la necesidad de regulación tanto en el sector público como en el privado. Pero, de momento, no ha habido campañas específicas ni grupos de trabajo especializados en la informática afectiva, y los intentos de regularla han sido limitados. Y aunque la Comisión Federal de Comercio de EE. UU. recibió una solicitud de investigar a HireVue, no ha anunciado si tiene intención de hacerlo.

Aunque muchos investigadores creen que la prohibición resulta demasiado generalizada, están de acuerdo en que el vacío regulatorio también es perjudicial. Oliver detalla: "Hemos definido claramente los procesos para certificar que ciertos productos que usamos, ya sean los alimentos que comemos, o los medicamentos que tomamos, son seguros para su consumo, y hacen lo que dicen que hacen. Pero estos mismos procesos no se aplican al ámbito tecnológico". La experta cree que las compañías cuyas tecnologías pueden afectar significativamente a la vida de las personas deberían demostrar que cumplen un cierto estándar de seguridad.

La profesora del MIT Media Lab (EE. UU.) que cofundó Affectiva y La start-up de informática afectiva Empatica, Rosalind Picard, opina igual. Señala una regulación existente que podría servir de modelo: la La Ley de Protección de los Empleados en cuanto al Polígrafo, que limita el uso de los detectores de mentiras y que, según ella, básicamente son una tecnología de informática afectiva. Por ejemplo, la ley prohíbe a la mayoría de los empleadores privados utilizar polígrafos y no permite que pregunten por los resultados de las pruebas de detección de mentiras.

Sugiere que cualquier uso de tales tecnologías debería ser optativo y que las empresas deben informar sobre cómo se probaron sus tecnologías y cuáles son sus limitaciones. Picard advierte: "La situación actual es que [las compañías] pueden hacer estas afirmaciones escandalosas que son simplemente falsas, porque en este momento el comprador no está muy bien informado. Y no deberíamos exigir que los compradores estén tan bien informados". (Picard, quien asegura que dejó Affectiva en 2013, no respalda las afirmaciones de HireVue).

Por otra parte, la científica investigadora de Universidad de Nueva York (EE. UU.) y codirectora de AI Now, Meredith Whittaker, destaca la diferencia entre la investigación y la comercialización: "No estamos impugnando todo el campo de la informática afectiva. Solo estamos haciendo un llamamiento por el uso no regulado, no validado, científicamente infundado de las tecnologías de reconocimiento con fines comerciales. Ahora mismo, la comercialización podría perjudicar a la gente porque lanza afirmaciones que determinan el acceso de las personas a algunos recursos".

La prohibición de usar el reconocimiento de emociones en áreas como la contratación ayudaría a evitar que la comercialización vaya más deprisa que la ciencia. Whittaker detalla que primero habría que detener el uso de estas tecnologías y luego habría que invertir en investigación. Si la investigación confirma que estas tecnologías funcionan tal y como afirman las empresas, entonces se podría considerar la posibilidad de suavizar la prohibición.

No obstante, aún harían falta otras regulaciones para garantizar la seguridad de la gente: al fin y al cabo, la credibilidad científica no es el único factor involucrado, argumenta Whittaker, y concluye: "Cuando estos sistemas se usan en contextos sensibles, debemos asegurarnos de que se puedan impugnar, de que se usen de manera justa y de que no provoquen grandes desequilibrios de poder entre las personas que los usan y sobre las que se usan".