Aunque la plataforma asegura que lucha contra las burbujas de contenido, el extremismo y la información falsa, su nueva estrategia para que los usuarios pasen más tiempo en ella podría resultar aún más perjudicial, según varios expertos

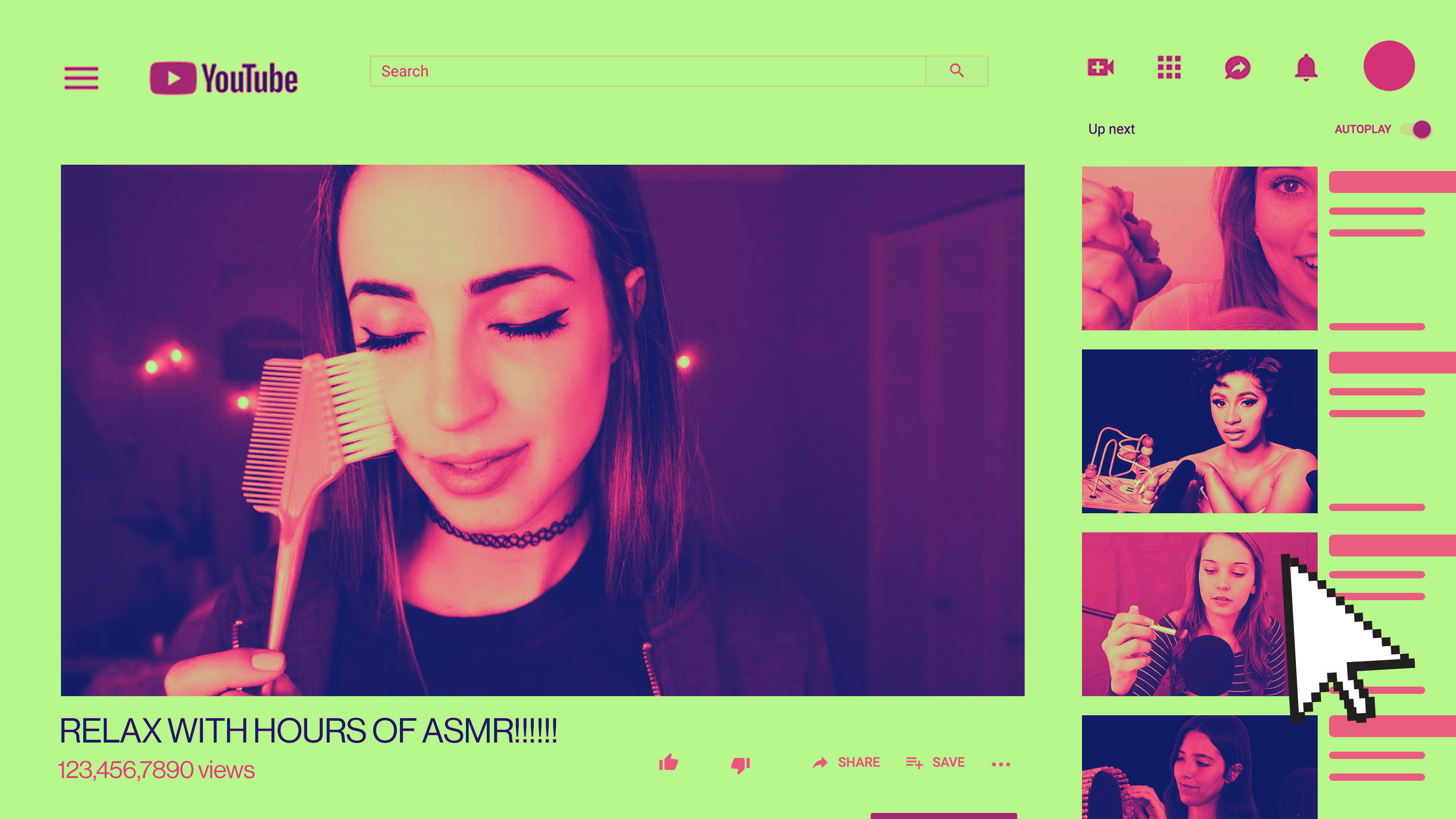

Los algoritmos de recomendación son unos de los sistemas de aprendizaje automático actuales más potentes gracias a su capacidad de dar forma a la información que consumimos. En especial, el algoritmo de YouTube tiene una influencia descomunal. Se estima que a esta plataforma solo la supera Google en el tráfico de la web, y el 70 % de lo que ven los usuarios les llega mediante las recomendaciones.

En los últimos años, esta influencia ha sido objeto de un intenso análisis. Como el algoritmo está optimizado para que las personas se enganchen a los vídeos, tiende a ofrecer opciones que refuerzan lo que al usuario ya le gusta, algo que puede crear una especie de adicción que excluye otros puntos de vista. Este enfoque suele beneficiar los vídeos más extremos y controvertidos, que según los estudios pueden empujar a las personas a un profundo agujero de contenido y a la radicalización política.

Aunque YouTube ha asegurado públicamente que intenta solucionar estos problemas, un nuevo trabajo de Google, propietario de YouTube, parece mostrar algo diferente. La investigación propone una actualización del algoritmo de Youtube para que recomiende contenido aún más específico a los usuarios con el fin de aumentar su actividad en la plataforma.

Así es como funciona actualmente el sistema de recomendaciones de YouTube. Para crear la barra lateral con vídeos recomendados, primero prepara una breve lista de varios cientos de vídeos que coincidan con el tema y otras características del vídeo que el usuario está viendo. Luego reordena la lista en función de las preferencias del usuario, algo que aprende introduciendo sus clics, me gusta y otras interacciones en un algoritmo de aprendizaje automático.

Entre las actualizaciones propuestas, los investigadores abordan específicamente un problema al que se refieren como "sesgo implícito", es decir, la influencia de las propias recomendaciones sobre el comportamiento del usuario. Este sesgo implícito dificulta la tarea de averiguar si hizo clic en un vídeo porque le gustó o porque era muy recomendable. El efecto es que, con el tiempo, el sistema puede alejar a los usuarios cada vez más de los vídeos que realmente quieren ver.

Para reducir este sesgo, los investigadores proponen un cambio en el algoritmo: cada vez que un usuario haga clic en un vídeo, se tendrá en cuenta para su posición en la barra lateral de recomendaciones. De esta forma, los vídeos que estén más arriba tendrán menos peso en el algoritmo de aprendizaje automático que los que están al final, puede que para llegar a ellos, el usuario debe desplazarse hacia abajo. Al probar esta estrategia en directo en YouTube, los investigadores se encontraron con que los usuarios interactuaban más con la plataforma.

Aunque el trabajo no especifica si el nuevo sistema se implementaría de forma permanente, el exingeniero de YouTube que ahora dirige AlgoTransparency.org, Guillaume Chaslot, afirma que está "bastante seguro" de que este cambio llegará dentro de poco. El experto detalla: "Han explicado que el tiempo de visualización aumenta en un 0,24 %. Si hacemos los cálculos, este aumento puede suponer beneficios decenas de millones de euros".

Varios expertos que revisaron el estudio coinciden en que las modificaciones podrían tener efectos perversos. El miembro del Centro Berkman Klein para Internet y Sociedad Jonas Kaiser alerta: "En nuestra investigación, hemos encontrado que los algoritmos de YouTube han creado una comunidad aislada de extrema derecha, han empujado a otros usuarios hacia vídeos con niños y han promovido la información falsa. Este cambio podría [...] fomentar la formación de comunidades todavía más aisladas". El director de la iniciativa forense digital en el Centro Tow para el Periodismo Digital, Jonathan Albright, explica que, aunque "reducir el sesgo de la posición es un buen comienzo para frenar la retroalimentación de contenido de baja calidad", este cambio podría favorecer aún más el contenido extremo.

La exinvestigadora de Data & Society especializada en el extremismo online Becca Lewis cree que será difícil saber qué efectos tendrán esos cambios. La experta señala: "Eso también se refiere al funcionamiento interno de YouTube. La plataforma alberga muchas comunidades diferentes, distintas formas de usarla y contenidos de muchos tipos, así que las implicaciones serán diferentes en mucho sentido. Nos convertimos en conejillos de Indias para YouTube".

Ante la solicitud de comentarios al respecto, un portavoz de YouTube comentó que sus ingenieros y equipos de productos habían determinado que los cambios no provocarían burbujas de filtro. De hecho, la compañía espera que estos cambios las disminuyan y diversifiquen las recomendaciones.

Los tres investigadores externos con los que contactó MIT Technology Review recomiendan que YouTube dedique más tiempo a analizar el impacto de los cambios algorítmicos mediante las entrevistas, encuestas y comentarios de los usuarios. Aunque, según su portavoz, ya lo han hecho al intentar eliminar el contenido extremo como el discurso de odio en su plataforma.

"YouTube debería dedicar más energía a comprender qué actores favorecen y amplifican sus algoritmos y no tanta a mantener los usuarios en su plataforma", opina Kaiser. Por su parte, Lewis señala: "Lo frustrante es que YouTube no tiene ningún interés comercial para hacerlo. Pero existe el imperativo ético".