Esta tecnología cada vez es más usada por empresas y gobiernos con distintos fines. Más allá del problema de los sesgos, la capacidad de reconocer caras puede atentar contra los derechos civiles de las personas. Es necesario reforzar la regulación para evitar que se abuse de ella

En los últimos años, se ha producido un drástico aumento en la incorporación de la tecnología de reconocimiento, detección y análisis facial (ver Reconocer caras: un negocio que vale millones y revoluciona industrias).

Probablemente los que más nos suenen sean los sistemas de reconocimiento, como los de Facebook y FaceID de Apple que sugieren las etiquetas en las fotos y pueden identificar a personas específicas. Los sistemas de detección se centran en determinar si hay una cara. Y los sistemas de análisis intentan identificar aspectos como el género y la raza. Todos estos sistemas ya se usan para varios objetivos, desde la contratación y la venta al por menor hasta la seguridad y la vigilancia.

Muchas personas creen que estos sistemas son muy precisos e imparciales. Según esta lógica, el personal de seguridad del aeropuerto puede cansarse y la policía puede juzgar mal a los sospechosos, pero un sistema de inteligencia artificial (IA) bien entrenado debería ser capaz de identificar o categorizar constantemente cualquier imagen de una cara.

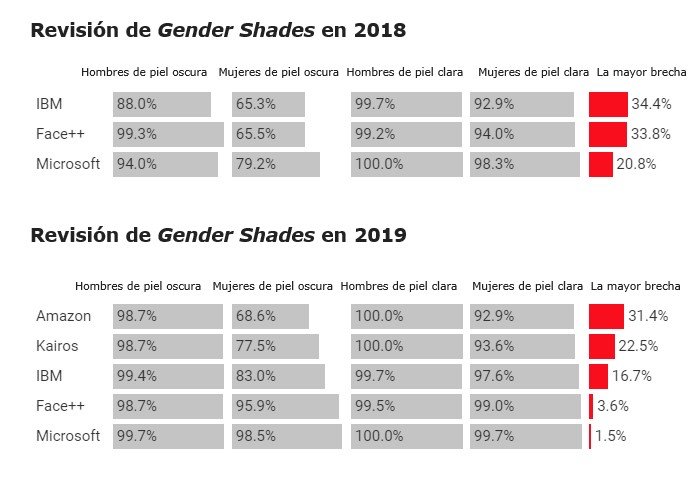

Pero en la práctica, las investigaciones han demostrado repetidamente que estos sistemas funcionan son mucho más inexactos con algunos grupos demográficos que con otros (ver La precisión de los sistemas de reconocimiento facial de la policía depende de la raza). El año pasado, el estudio Gender Shades, dirigido por la investigadora Joy Buolamwini del MIT Media Lab, descubrió que los sistemas de clasificación de género vendidos por IBM, Microsoft y Face ++ tenían un índice de error de hasta 34,4 % más alto para las mujeres de piel más oscura que para los hombres de piel más clara. La Unión Estadounidense por las Libertades Civiles (ACLU por sus siglas en inglés) del norte de California (EE.UU.) también encontró que la plataforma de Amazon tenía más probabilidades de identificar erróneamente a los miembros del Congreso que no eran blancos que a los blancos.

El problema es que los sistemas de reconocimiento y análisis de rostros a menudo están entrenados con conjuntos de datos sesgados que incluyen un porcentaje mucho menor de imágenes de mujeres y personas con piel oscura que de hombres y personas con la piel clara. Y mientras que muchos de estos sistemas son supuestamente probados para ver si son justos, esas pruebas no verifican el rendimiento en un rango suficientemente amplio de caras, como descubrió Buolamwini. Estas disparidades mantienen y consolidan aún más las injusticias existentes y llevan a unas consecuencias que solo empeoran a medida que aumentan los desafíos (ver La IA que evalúa a delincuentes perpetúa la injusticia hacia las minorías).

Tres nuevos artículos publicados la semana pasada se centran en este problema. A continuación una breve descripción de cada uno de ellos.

Artículo # 1. El jueves pasado, Buolamwini publicó una actualización de Gender Shades en la que volvió a comprobar los sistemas que había examinado anteriormente y amplió su revisión para incluir el sistema Rekognition de Amazon y un nuevo sistema de una pequeña empresa de inteligencia artificial llamada Kairos. Sus conclusiones ofrecen buenas noticias. La investigadora descubrió que IBM, Face ++ y Microsoft han mejorado su precisión de clasificación de género para las mujeres de piel más oscura, y Microsoft ha reducido su tasa de error a menos del 2 %. Por otro lado, las plataformas de Amazon y Kairos todavía tenían brechas de precisión del 31 % y el 23 %, respectivamente, entre los hombres más blancos y mujeres de piel más oscura. Buolamwini afirma que el estudio muestra que estas tecnologías deben ser revisadas externamente para que sean técnicamente responsables.

Gráficos: Precisión en la clasificación por género. Fuente: Joy Buolamwini y Timnit Gebru.

Artículo # 2. El domingo, un estudio del Laboratorio de Inteligencia Artificial e Informática del MIT (CSAIL, por sus siglas en inglés) demostró la efectividad de un nuevo algoritmo para reducir los sesgos en un sistema de detección de facial incluso cuando está entrenado con datos muy sesgados. A medida que se entrena, también identifica qué ejemplos no están suficientemente representados en los datos y les dedica más tiempo de análisis para compensar este déficit. Cuando los investigadores probaron el sistema con el conjunto de datos de Gender Shades de Buolamwini, encontraron que ayudó a cerrar su mayor brecha de precisión, la que aparece entre los hombres de piel más clara y oscura, en comparación con un algoritmo de entrenamiento estándar (aunque no lo eliminó por completo).

Artículo # 3. Esta semana, IBM Research publicó un documento que identifica docenas de variables para medir la diversidad más allá del color de la piel y el género, incluido el largo de la cabeza, el ancho de la cara, la distancia intraocular y la edad. Los hallazgos se basan en las investigaciones previas sobre los rostros humanos. El coautor de la investigación John Smith afirma: "Si no tenemos medidas sobre la diversidad facial no podemos aplicarlas para entrenar a los sistemas de reconocimiento facial". Conjuntamente, el equipo publicó un nuevo grupo de datos con un millón de imágenes de caras, registradas con estas nuevas medidas.

Foto: Diferentes medidas de la diversidad facial, presentadas en el nuevo artículo de IBM Research. Créditos: IBM Research.

Cada uno de estos estudios da pasos importantes para abordar el sesgo en el reconocimiento facial. Depositan la responsabilidad en empresas, ofrecen nuevos algoritmos y amplían nuestra comprensión sobre la diversidad de los datos. Pero crear sistemas más justos y precisos solo supone la mitad del trabajo.

Incluso los sistemas más justos y precisos pueden ser utilizados para coartar las libertades civiles de las personas. El año pasado, una investigación del The Daily Beast descubrió que Amazon estaba cediendo activamente datos de su plataforma de vigilancia facial al Servicio de Inmigración y Control de Aduanas de EE. UU., más conocido como ICE, para ayudar a controlar a las comunidades de migrantes (ver Cómo Amazon colabora con la dura política migratoria de EE. UU.). Otra investigación deThe Intercept también descubrió que IBM creó una función para identificar el origen étnico de las caras como parte de una colaboración con el Departamento de Policía de Nueva York (EE.UU.). Esta tecnología se implementó en las cámaras de vigilancia públicas, sin el conocimiento de los residentes de la ciudad. La Policía Metropolitana de Reino Unido ya utiliza el reconocimiento facial para analizar a las multitudes en busca de individuos que figuran en sus listas de vigilancia, y China lo utiliza para la vigilancia masiva de todos los residentes, con distintos fines incluyendo el de seguimiento de los disidentes.

En respuesta a la rápida proliferación de estos sistemas, cada vez más activistas de derechos civiles y tecnólogos están alzando la voz para que se regulen de forma más estricta. Google incluso ha suspendido la venta de sus sistemas hasta que defina una estrategia clara para evitar que se les den malos usos. "Sin una justicia algorítmica, la precisión y la equidad de los algoritmos pueden dar lugar a herramientas de IA que se usen como armas", concluye Buolamwini.