Inteligencia Artificial

"Es imposible diseñar un sistema de conducción autónoma que lidie con todo"

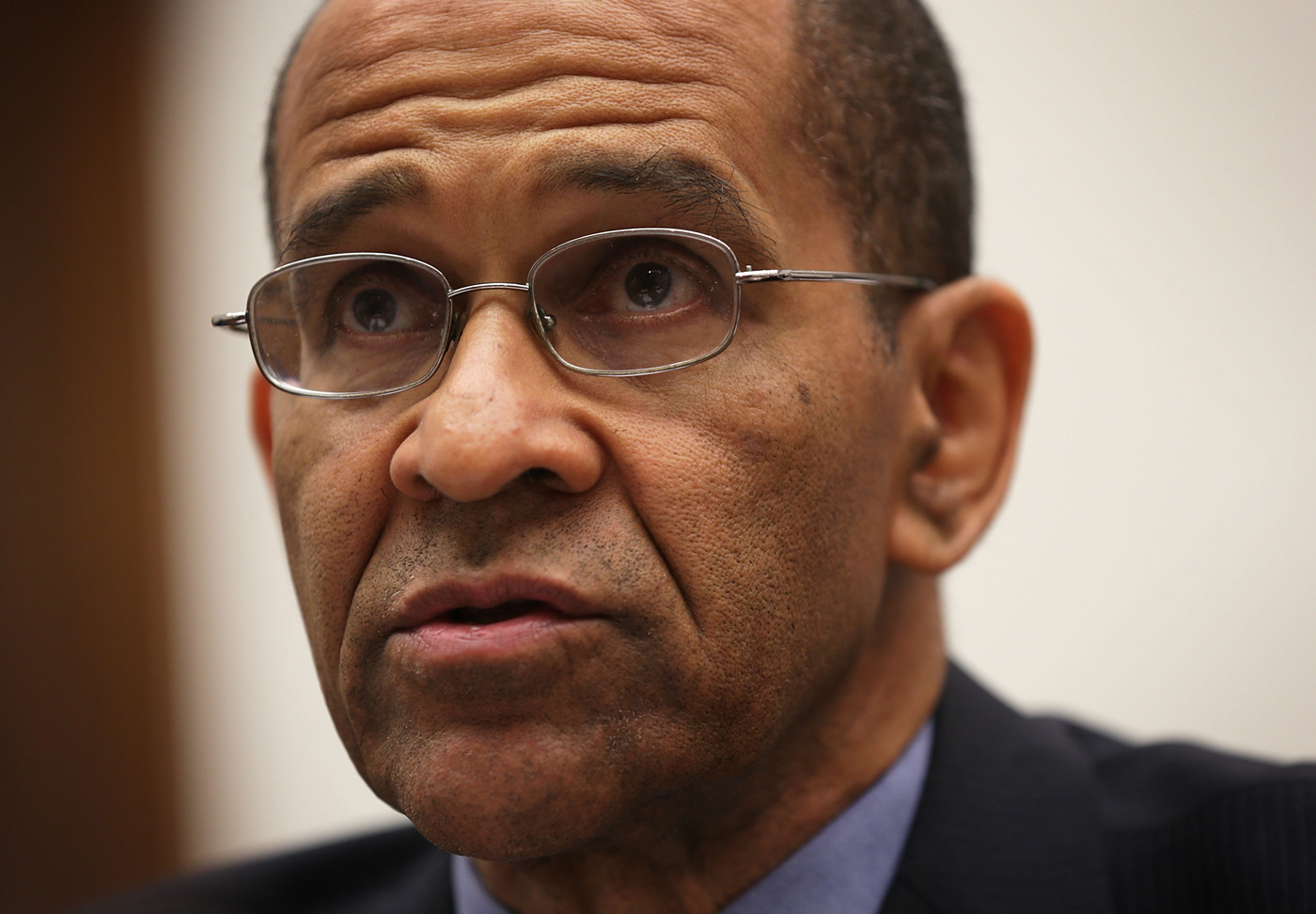

El director de la Junta Nacional de Seguridad del Transporte, Christopher Hart, no cree que los coches lleguen a conducirse solos al 100% y pide al Gobierno central que regule las decisiones éticas

Foto: Christopher Hart. Crédito: Alex Wong (Getty Images).

Foto: Christopher Hart. Crédito: Alex Wong (Getty Images).

Los accidentes de tráfico matan a más de 33.000 estadounidenses cada año, más que los homicidios y las sobredosis con fármacos recetados. Las empresas que trabajan en los coches autónomos, como Alphabet y Ford, afirman que su tecnología podría diezmar esa cifra al eliminar comportamientos humanos como los de utilizar el móvil estando al volante, y conducir bajo la embriaguez y la fatiga. Pero el director de la Junta Nacional de Seguridad del Transporte (NTSB, por sus siglas en inglés), Christopher Hart, explica que la experiencia de su agencia investigando accidentes en los que han participado sistemas de piloto automático en trenes y aviones sugieren que los humanos no pueden ser apartados totalmente del control de los vehículos. Hart contó a MIT Technology Review que los futuros vehículos serán mucho más seguros, pero que aún necesitarán que las personas los copiloten. A continuación ofrecemos una transcripción resumida de la conversación.

¿Cuán optimista es usted sobre las posiblidades de que los coches autónomos reduzcan la tasa de mortalidad?

Me siento muy optimista. Durante décadas hemos estudiado cómo mitigar las lesiones al producirse una colisión. Disponemos de cinturones de seguridad, airbags y carrocerías más robustas. Ahora mismo, tenemos la oportunidad de evitar la colisión por completo. Y eso va a salvar decenas de miles de vidas. Ese es el destino final ideal: la ausencia total de colisiones.

Los sistemas de piloto automático también pueden generar nuevos peligros. La NTSB ha dicho que la excesiva dependencia de los pilotos en la automatización ha provocado accidentes. ¿Le preocupa que este fenómeno se convierta en un problema para los coches también?

El escenario ideal del que acabo de hablar, salvar decenas de miles de vidas cada año, da por hecho una automatización total, sin ninguna participación humana en absoluto. No estoy seguro de que vayamos a llegar nunca a ese punto. No creo que el sueño de la automatización completa se produzca en un futuro próximo.

A algunas personas simplemente les gusta conducir. Otras no se fiarán de la automatizacion, por lo que querrán conducir. [Y] no existe en todo el mundo un diseñador de software que sea lo suficientemente inteligente como para anticiparse a todas las circunstancias en potencia con las que este software se encontrará. El perro que sale a la carretera, la persona que la cruza corriendo, el ciclista, el policía o el obrero. O el puente que se derrumba durante una inundación. Es imposible diseñar un sistema capaz de lidiar con todo.

El reto llega con la semiautomatización, en la que todavía hay una importante participación humana. Ahí es cuando la complacencia se convierte en un problema. Así que nuestro reto es: ¿cómo lidiar con lo que probablemente será un escenario a largo plazo que seguirá incluyendo algún grado de participación humana en este sistema sobre todo automatizado?

La reciente muerte de un conductor que utilizaba la prestación Autopilot de Tesla podría representar un fallo de la automatización. ¿Por qué está investigando la NTSB ese accidente?

No investigamos la mayoría de los accidentes de coche. Lo que traemos a la mesa es la experiencia con escenarios de introducir automatización en compejos sistemas centrados en humanos, cosa que desde luego es. Estamos investigando este accidente porque vemos que se avecina la automatización de los coches y nos gustaría intentar ayudar a enriquecer ese proceso con nuestra experiencia con otros tipos de automatización.

¿Cómo cuáles?

Bueno, investigamos un accidente de un vehículo automatizado de transporte de pasajeros dentro de un aeropuerto. Colisionó con otro vehículo similar. Y nuestra investigacion encontró que el problema era de mantenimiento. Incluso cuando se elimina al operador, permanece el factor del error humano procedente de las personas que lo diseñaron, las personas que lo fabricaron, las personas que lo mantienen.

Algunos dicen que los coches autónomos tendrán que tomar decisiones éticas, por ejemplo decidir a quién hacer daño cuando un accidente sea inevitable. ¿Es realmente un problema?

Te puedo dar un ejemplo que he visto mencionado en varios sitios. Mi coche autónomo se enfrenta a un camión de 36.500 kilos en mi carril. Ahora el coche ha de decidir si chocar contra este camión y me mata a mí, el conductor, o se sube a la acera y mata a 15 peatones. Esto tendría que ser programado dentro del sistema. ¿Proteger a ocupantes u otras personas? Para mí, hará falta una respuesta del Gobierno federal para abordar eso. Ese tipo de decisiones éticas serán inevitables.

Pero al margen de las decisiones éticas, ¿qué pasa si falla el sistema? ¿Fallará de una manera que minimice los daños sufridos por el público, otros coches, ciclistas? El Gobierno federal estará involucrado.

¿Qué aspecto podría tener ese proceso?

La Administración Federal de Aviación tiene una esquema que dicta que si algo tiene menos de una probabilidad de uno entre 1.000 millones, no hace falta incluir una trayectoria de carga alternativa [una estructura alternativa para soportar el peso del avión]. Para algo con una probabilidad mayor hay que incluir un mecanismo de seguridad. A no ser que se pueda demostrar que la probabilidad de un fallo de la verga del ala que se separe el ala del avión sea inferior a uno entre 1.000 millones, es "probable" que pase. Entonces hay que incluir un plan B.

Ese mismo proceso tendrá que producirse con los coches. Creo que el Gobierno tendrá que entrar en juego y decir: "Tienen que demostrar menos de X probabilidades de fallos, o tienen que incorporar una medida de seguridad que asegure que este fallo no mate gente". Fijar los límites es algo que creo que corresponderá al dominio del Gobierno federal, no de los Gobiernos estatales. No quiero 50 límites [distintos].