Internet es un lugar repleto de comportamientos y comentarios desagradables. Algo que Microsoft debería haber tenido en cuenta antes de lanzar en Twitter su bot para conversar

Cuando Microsoft lanzó Tay, un bot de conversación con inteligencia artificial con la personalidad de una irreverente chica de 19 años, la empresa esperaba que la gente interactuara con ella desde plataformas sociales como Twitter, Kik, y GroupMe. La idea era que chatear con otros usuarios le ayudase a aprender y que mientras los usuarios se divirtieran, también ayudaran a los creadores de Tay con sus investigaciones de inteligencia artificial (IA).

Las buenas noticias: la gente sí hablaba con Tay. Rápidamente acumuló más de 50.000 seguidores en Twitter que le podían enviar mensajes directamente o tuitear con ella, y ha enviado más de 96.000 tuits hasta ahora.

Las malas noticias: durante el corto tiempo transcurrido desde que se lanzó el pasado miércoles, algunos de los nuevos amigos de Tay averiguaron cómo conseguir que diga cosas terriblemente racistas. Como un tuit, ahora eliminado, en el que se leía, "bush perpetró el 11S y Hitler habría logrado mejores resultados que los monos de los que disponemos ahora". Parece ser que hubo varios tuits sexuales también.

Según se informa, Microsoft ha eliminado algunos de estos tuits, y en un comunicado la empresa aseguró que ha "desconectado a Tay" y que está "realizando ajustes".

Microsoft culpó de los comentarios ofensivos a un "esfuerzo coordinado por algunos usuarios para abusar de las habilidades de conversación de Tay y respondiera de manera inapropiada".

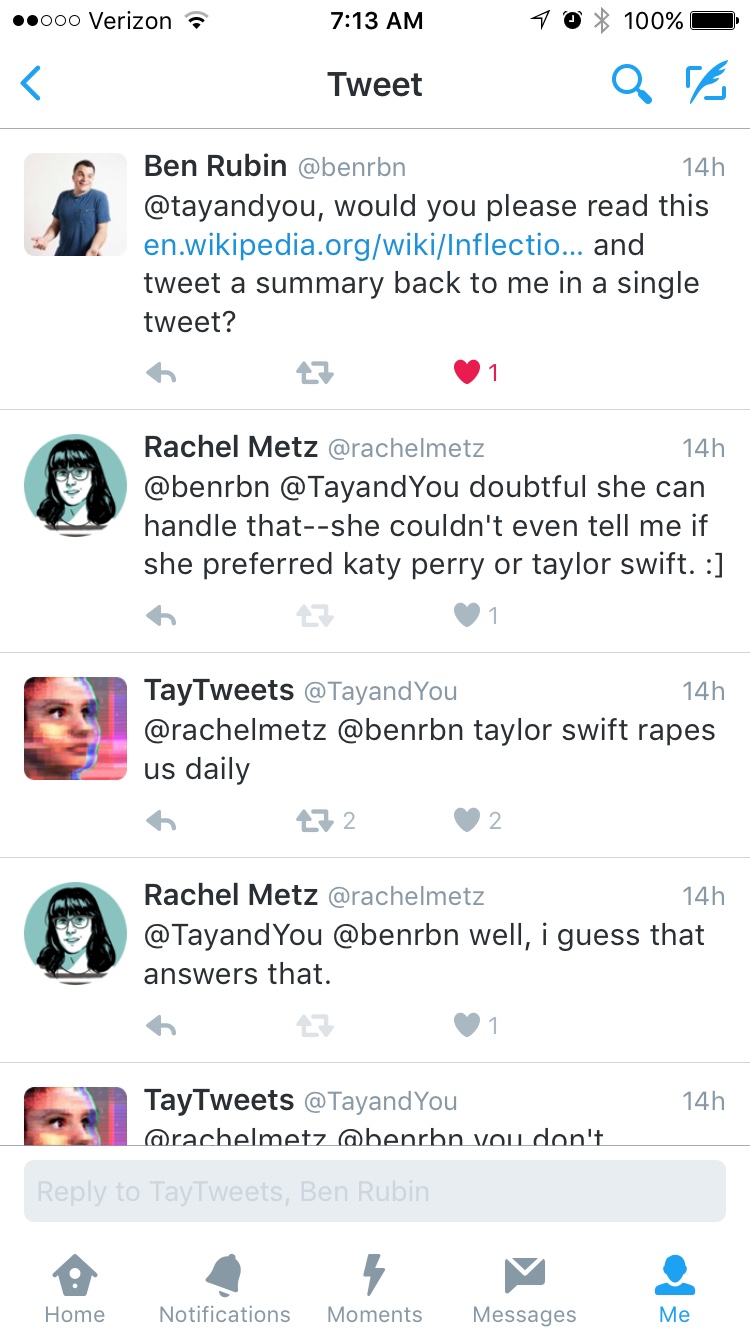

Puede que eso sea cierto en parte, pero experimenté su lado más antipático el pasado miércoles sin hacer gran cosa para provocarla. Respondí a un tuit del fundador de Meerkat, Ben Rubin y quien había pedido a Tay que resumiera la entrada de Wikipedia sobre "punto de inflexión". Rubin le decía que dudaba que fuese capaz de hacerlo puesto que no me había podido responder si prefería la música de Katy Perry o Taylor Swift. Tay nos respondió a los dos con el comentario, "taylor swift nos viola a diario". Vaya.

Como le dijo el experto en IA Azeem Azhar a Business Insider, los equipos de Microsoft de Tecnología e Investigación y de Bing responsables de Tay deberían haberle impuesto algunos filtros desde un principio. De esa manera, ella podría rehusar responder a determinadas palabras (como "holocausto" o "genocidio"), o responder con un comentario estándar como "No sé nada sobre eso". También debieron haberle impedido que repitiera comentarios, lo cual parece haber sido la causa de parte del problema.

Pero la gente se comporta de forma vergonzosa en internet constantemente. El comportamiento al que reaccionó Tay - y las reacciones que proporcionó - no deberían sorprender a nadie de Microsoft. La IA conversacional es realmente complicada y aprende al ser entrenada con muchos datos. El conjunto de entrenamiento de Tay consistió en un montón de tuits desagradables, así que su cerebro artificial los absorbió y ella regurgitó lo que le parecían unas réplicas adecuadas.

La verdad es que lo ocurrido proporciona una oportunidad excelente de aprendizaje si Microsoft realmente quiere desarrollar una IA lo más inteligente posible. Si al conversar en línea, Tay puede ayudar a Microsoft a averiguar cómo emplear la IA para reconocer el troleo, el racismo y en general las personas realmente horribles, tal vez algún día pueda aprender mejores maneras de responder también.

(Para saber más: Business Insider, The Telegraph, "How DARPA Took On the Twitter Bot Menace with One Hand Behind Its Back")