Inteligencia Artificial

Los nuevos asistentes de OpenAI y Google auguran la próxima batalla de la IA

Prometen estar muy por delante de herramientas como Siri o Alexa.

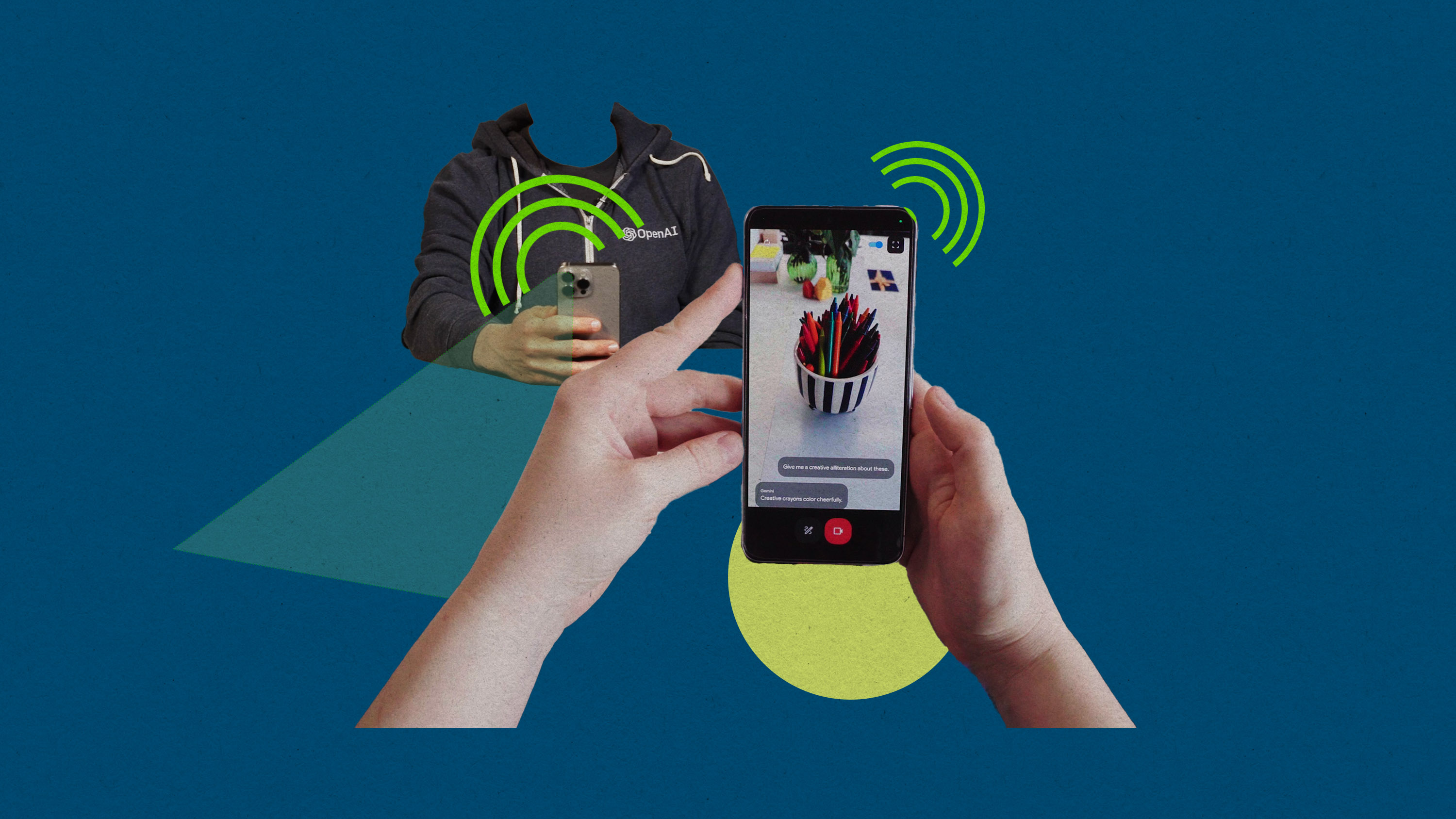

Esta semana, Google y OpenAI han anunciado la creación de asistentes de inteligencia artificial súper potentes: herramientas que pueden conversar contigo en tiempo real y retomar la conversación cuando les interrumpes, analizar tu entorno mediante vídeo en directo y traducir conversaciones sobre la marcha.

OpenAI se adelantó el lunes, cuando presentó su nuevo modelo insignia GPT-4o. La demostración en directo mostraba cómo leía cuentos antes de dormir y ayudaba a resolver problemas matemáticos, todo ello con una voz que sonaba inquietantemente parecida a la de la novia IA de Joaquin Phoenix en la película Her (un rasgo que no pasó desapercibido al consejero delegado Sam Altman).

El martes, Google anunció sus propias herramientas, incluido un asistente conversacional llamado Gemini Live, que puede hacer muchas cosas iguales a las de GPT-4o. También reveló que está construyendo una especie de agente de IA "que lo hace todo", actualmente en desarrollo, pero que no verá la luz hasta finales de este año.

Pronto podrás comprobar por ti mismo si estas herramientas te resultarán tan útiles en tu día a día como esperan sus creadores, o si son más bien un truco de ciencia ficción que acabará perdiendo su encanto. Esto es lo que debes saber sobre cómo acceder a estas nuevas herramientas, para qué podrías utilizarlas y cuánto costarán.

GPT-4o de OpenAI

De qué es capaz: El modelo puede hablar contigo en tiempo real, con un retardo de respuesta de unos 320 milisegundos, equiparable a una conversación humana natural, según OpenAI. Puedes pedirle que interprete cualquier cosa a la que apuntes con la cámara de tu smartphone y puede ayudarte en tareas como codificar o traducir texto. También puede resumir información y generar imágenes, fuentes y representaciones en 3D.

Cómo acceder: OpenAI dice que empezará a desplegar las funciones de texto y visión de GPT-4o en la interfaz web, así como en la aplicación GPT, pero no ha fijado una fecha. La empresa afirma que añadirá las funciones de voz en las próximas semanas, aunque tampoco ha fijado una fecha exacta para ello. Los desarrolladores ya pueden acceder a las funciones de texto y visión en la API, pero el modo de voz sólo se lanzará inicialmente para un "pequeño grupo" de desarrolladores.

¿Cuánto cuesta?: El uso de GPT-4o será gratuito, pero OpenAI establecerá límites sobre cuánto se puede utilizar el modelo antes de tener que pasar a un plan de pago. Quienes se unan a uno de los planes de pago de OpenAI, que empiezan en 20 dólares al mes (18,50 euros), tendrán cinco veces más capacidad en GPT-4o.

Gemini Live de Google

¿Qué es Gemini Live?: Es el producto de Google más parecido a GPT-4o: una versión del modelo de IA de la empresa con la que puedes hablar en tiempo real. Google dice que también podrás utilizar la herramienta para comunicarte a través de vídeo en directo "este mismo año". La compañía promete que será un asistente conversacional útil para cosas como preparar una entrevista de trabajo o ensayar un discurso.

Cómo acceder: Gemini Live se lanzará en "los próximos meses" a través del plan premium de IA de Google, Gemini Advanced.

Cuánto cuesta: Gemini Advanced ofrece un periodo de prueba gratuito de dos meses y cuesta 20 dólares al mes (18,50 euros) a partir de entonces.

¿Qué es exactamente el Proyecto Astra?: Astra es un proyecto para crear un agente de inteligencia artificial que lo haga todo. Se ha presentado en la conferencia I/O de Google, pero no saldrá a la venta hasta finales de este año.

La gente podrá utilizar Astra a través de sus smartphones y posiblemente desde sus ordenadores, pero la compañía también está explorando otras opciones, como incrustarlo en gafas inteligentes u otros dispositivos, dijo Oriol Vinyals, vicepresidente de investigación de Google DeepMind, a MIT Technology Review.

¿Cuál es mejor?

Es difícil saberlo sin tener en nuestras manos las versiones completas de estos modelos. Google mostró el Proyecto Astra en un vídeo muy cuidado, mientras que OpenAI optó por presentar el GPT-4o en una demostración en directo aparentemente más auténtica, pero en ambos casos se pidió a los modelos que hicieran cosas que los diseñadores probablemente ya habían practicado. La verdadera prueba llegará cuando se presenten a millones de usuarios con nuevas exigencias.

Dicho esto, si se comparan los vídeos publicados por OpenAI con los de Google, las dos herramientas principales parecen muy similares, al menos en su facilidad de uso. Por generalizar, GPT-4o parece estar ligeramente por delante en audio, demostrando voces realistas, fluidez conversacional e incluso canto, mientras que Project Asta muestra capacidades visuales más avanzadas, como ser capaz de "recordar" dónde has dejado las gafas. La decisión de OpenAI de desplegar las nuevas funciones más rápidamente podría significar que su producto tendrá más uso al principio que el de Google, que no estará totalmente disponible hasta finales de este año. Es demasiado pronto para saber qué modelo "alucina" con menos frecuencia con información falsa o crea respuestas más útiles.

¿Son seguros?

Tanto OpenAI como Google afirman que sus modelos están bien probados: OpenAI dice que GPT-4o fue evaluado por más de 70 expertos en campos como la desinformación y la psicología social, y Google ha dicho que Gemini "tiene las evaluaciones de seguridad más completas de cualquier modelo de IA de Google hasta la fecha, incluyendo sesgos y toxicidad".

Pero estas empresas están construyendo un futuro en el que los modelos de IA buscan, examinan y evalúan la información del mundo por nosotros para ofrecernos una respuesta concisa a nuestras preguntas. Incluso más que con los chatbots más sencillos, conviene seguir siendo escéptico sobre lo que nos dicen.

Información adicional de Melissa Heikkilä.