El nuevo buque insignia gratuito de la compañía, el "omnimodelo", parece una versión sobrealimentada de asistentes como Siri o Alexa.

OpenAI acaba de presentar GPT-4o, un nuevo tipo de modelo de IA con el que puedes comunicarte en tiempo real a través de conversaciones de voz en directo, retransmisiones de vídeo desde tu teléfono y mensajes de texto. El modelo se irá desplegando en las próximas semanas y será gratuito para todos los usuarios, tanto a través de la aplicación GPT como de la interfaz web, según la empresa. Los usuarios que se suscriban a los niveles de pago de OpenAI, a partir de 20 dólares al mes (unos 18,50 euros), podrán realizar más solicitudes.

Mira Murati, CTO de OpenAI, realizó la demostración en directo de la nueva versión un día antes de que Google presente sus propios avances en IA en su conferencia I/O del martes 14 de mayo.

GPT-4 ofrecía capacidades similares, dando a los usuarios múltiples formas de interactuar con las ofertas de IA de OpenAI. Pero las agrupaba en modelos separados, lo que provocaba tiempos de respuesta más largos y, presumiblemente, costes de computación más elevados. GPT-4o ha fusionado estas funciones en un único modelo, que Murati ha denominado "omnimodelo". Esto se traduce en respuestas más rápidas y transiciones más fluidas entre tareas.

El resultado, según sugiere la demostración de la empresa, es un asistente conversacional muy parecido a Siri o Alexa, pero capaz de responder a peticiones mucho más complejas.

"Estamos ante el futuro de la interacción entre nosotros y las máquinas", explica Murati sobre la demostración. "Creemos que GPT-4o está cambiando realmente ese paradigma hacia el futuro de la colaboración, donde esta interacción se vuelve mucho más natural".

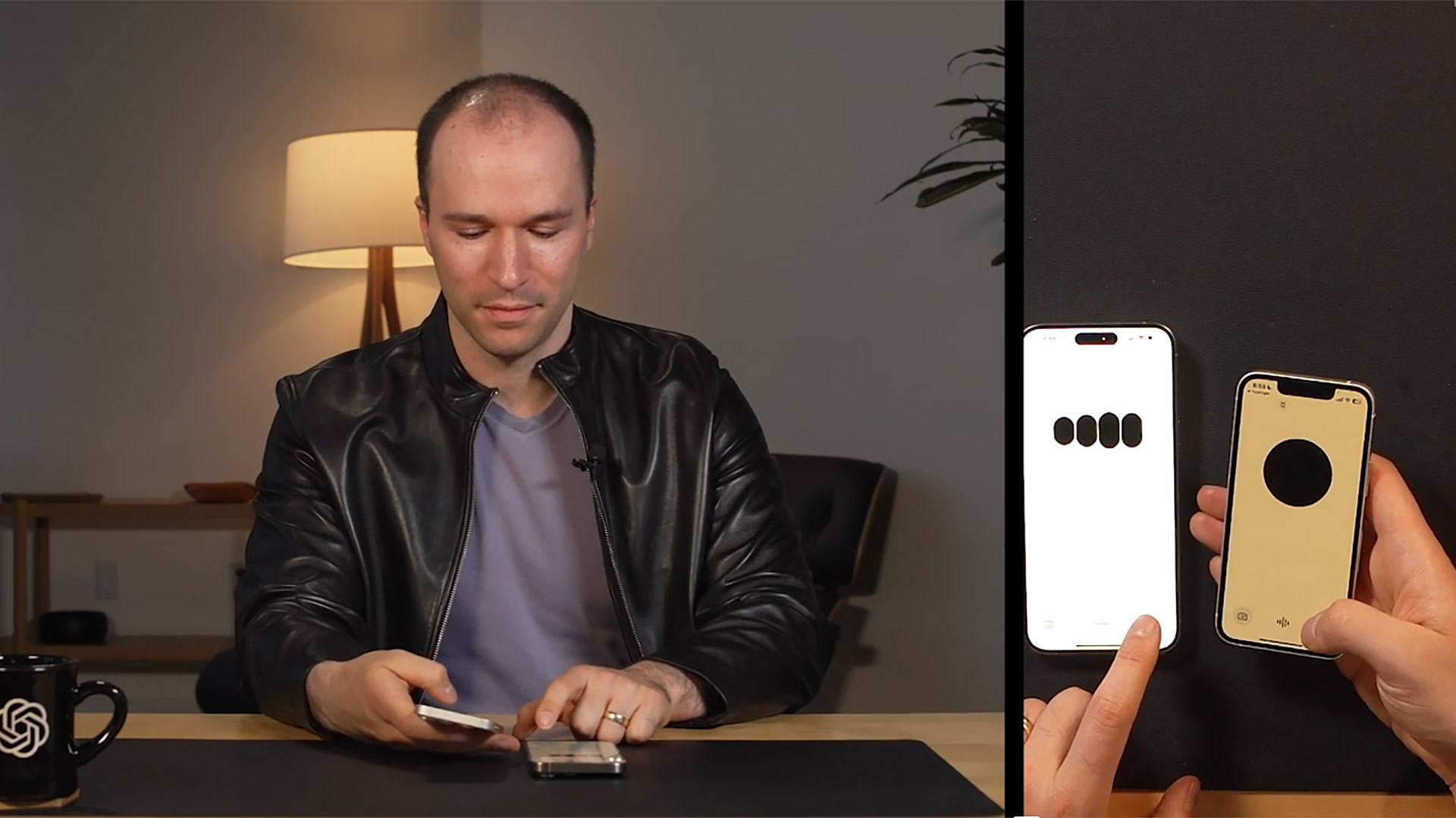

Barret Zoph y Mark Chen, ambos investigadores de OpenAI, hicieron un recorrido por varias de las aplicaciones del nuevo modelo. La más impresionante fue su facilidad para la conversación en directo. Se puede interrumpir al modelo durante sus respuestas y éste se detendrá, escuchará y corregirá el rumbo.

OpenAI también mostró la posibilidad de cambiar el tono del modelo. Chen pidió al modelo que leyera un cuento "sobre robots y amor", y rápidamente le pidió una voz más dramática. El modelo se fue volviendo cada vez más teatral hasta que Murati le pidió que cambiara rápidamente a una voz de robot convincente (lo que hizo de maravilla). Aunque, como era de esperar, hubo algunas pausas breves durante la conversación mientras el modelo razonaba qué decir a continuación, se trató de una conversación de IA con un ritmo extraordinariamente natural.

El modelo también puede razonar problemas visuales en tiempo real. Con su teléfono, Zoph se grabó a sí mismo escribiendo una ecuación de álgebra (3x + 1 = 4) en una hoja de papel, mientras GPT-4o le seguía. Le pidió que no le diera respuestas, sino que le guiara como lo haría un profesor.

"El primer paso es obtener todos los términos con x en un lado", dice el modelo en tono amistoso. "¿Qué crees que deberíamos hacer con ese más uno?".

GPT-4o almacenará registros de las interacciones de los usuarios con él, lo que significa que el modelo "ahora tiene un sentido de continuidad a través de todas tus conversaciones", según Murati. Otros aspectos destacados son la traducción en directo, la posibilidad de realizar búsquedas en las conversaciones con el modelo y el poder de buscar información en tiempo real.

Como suele ocurrir en las demostraciones en directo, hubo problemas y fallos. La voz de GPT-4o podía saltar de forma incómoda durante la conversación. Apareció para comentar el atuendo de uno de los presentadores, aunque no se le había pedido que lo hiciera. Pero se recuperó bien cuando le dijeron que se había equivocado. Parece capaz de responder con rapidez y de manera útil a través de varios medios que otros modelos aún no han fusionado con tanta eficacia.

Anteriormente, muchas de las funciones más potentes de OpenAI, como el razonamiento a través de imagen y vídeo, estaban detrás de un muro de pago. GPT-4o marca la primera vez que estas funciones al público general, aunque aún no está claro cuántas interacciones se podrán tener con el modelo antes de que se cobre. OpenAI afirma que los suscriptores de pago "seguirán teniendo hasta cinco veces más capacidad que nuestros usuarios gratuitos".

Información adicional de Will Douglas Heaven.