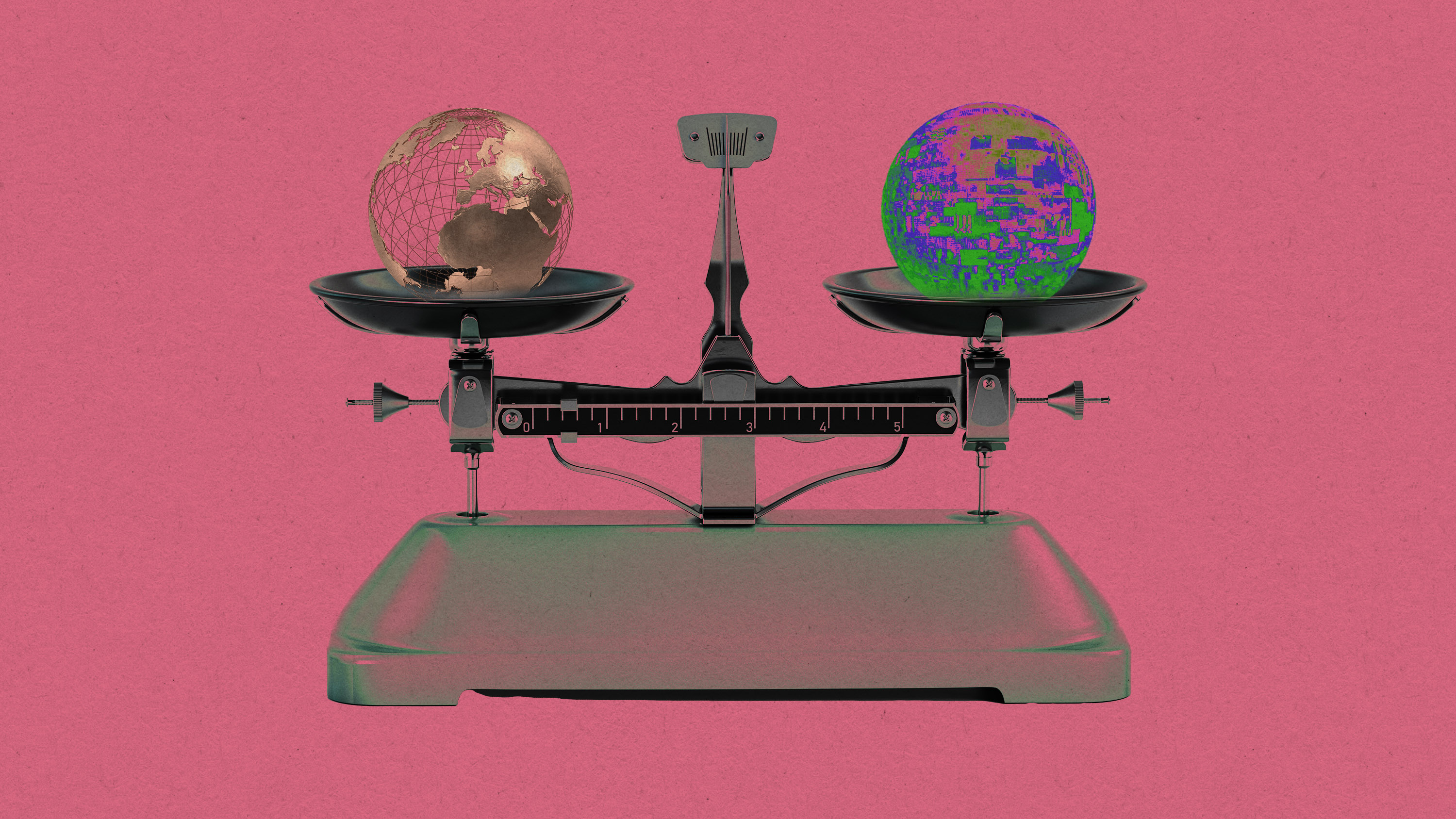

Este año entran en vigor las primeras leyes de gran alcance sobre IA, con esfuerzos globales para que las empresas tecnológicas rindan cuentas.

La serie ‘What's Next’ de ‘MIT Technology Review’ analiza distintos sectores, tendencias y tecnologías para ofrecerte un vistazo anticipado al futuro. Puedes leer el resto de nuestra serie aquí.

En 2023, la política y la regulación de la IA pasaron de ser un tema de nicho a ser noticia de primera plana. Esto se debe en parte a ChatGPT de OpenAI, que ayudó a que la IA se generalizara, pero que también mostró a la gente cómo funcionan —y no funcionan— los sistemas de IA. Ha sido un año monumental para la política: hemos visto la primera ley de gran alcance sobre IA acordada en la Unión Europea, audiencias en el Senado y órdenes ejecutivas en EE UU, y normas específicas en China para cosas como los algoritmos de recomendación.

Si 2023 fue el año en que los legisladores acordaron una visión, 2024 será el año en que las políticas empiecen a transformarse en acciones concretas. Esto es lo que cabe esperar.

Estados Unidos

La IA entró de lleno en el debate político en Estados Unidos en 2023. Pero no fue solo debate. También hubo acción, que culminó con la orden ejecutiva del presidente Biden sobre IA a finales de octubre, una amplia directiva que exigía más transparencia y nuevas normas.

A través de esta actividad, ha empezado a surgir una política de IA propia de Estados Unidos: una política favorable a la industria de la IA, que hace hincapié en las mejores prácticas, en la confianza en las distintas agencias para que elaboren sus propias normas y en un enfoque matizado que regula cada sector de la economía de forma diferente.

El año que viene se aprovechará el impulso de 2023, y se promulgarán muchos de los puntos detallados en la orden ejecutiva de Biden. También oiremos hablar mucho del nuevo Instituto de Seguridad de la Inteligencia Artificial de EE UU, que se encargará de ejecutar la mayoría de las políticas contempladas en la orden.

Desde el punto de vista del Congreso, no está claro qué ocurrirá exactamente. El líder de la mayoría en el Senado, Chuck Schumer, ha señalado recientemente que, además de la orden ejecutiva, es posible que se promulguen nuevas leyes. Ya hay varias propuestas legislativas en juego que afectan a varios aspectos de la IA, como la transparencia, los deepfakes y la responsabilidad de las plataformas. Pero no está claro cuál de estos proyectos de ley ganará fuerza el año que viene, si es que alguno lo hace.

Lo que sí podemos esperar es un enfoque que clasifique los tipos y usos de la IA en función del riesgo que planteen, un marco similar a la Ley de IA de la UE. El Instituto Nacional de Normas y Tecnología ya ha propuesto un marco de este tipo que cada sector y agencia tendrá que poner ahora en práctica, afirma Chris Meserole, director ejecutivo del Frontier Model Forum, un grupo de normalización del sector.

Otra cosa está clara: las elecciones presidenciales estadounidenses de 2024 influirán en gran parte del debate sobre la regulación de la IA. Como hemos visto con el impacto de la IA generativa en las plataformas de redes sociales y la desinformación, podemos esperar que el debate sobre cómo prevenir los daños de esta tecnología se vea condicionado por lo que ocurra durante la temporada electoral.

Europa

La Unión Europea ha aprobado recientemente la Ley de Inteligencia Artificial, la primera de este tipo en el mundo.

Tras un intenso trabajo técnico y su aprobación oficial por los países europeos y el Parlamento de la UE en el primer semestre de 2024, la Ley de IA entrará en vigor con bastante rapidez. En el escenario más optimista, la prohibición de ciertos usos de la IA podría aplicarse a finales de año.

Todo esto significa que 2024 será un año ajetreado para el sector de la IA, que se prepara para cumplir las nuevas normas. Aunque la mayoría de las aplicaciones de IA quedarán exentas de la Ley de IA, las empresas que desarrollen modelos y aplicaciones de base que se consideren de "alto riesgo" para los derechos fundamentales, como las destinadas a sectores como la educación, la sanidad y la policía, tendrán que cumplir las nuevas normas de la UE. En Europa, la policía no podrá utilizar la tecnología en lugares públicos, a menos que obtenga primero la aprobación judicial para fines específicos como la lucha contra el terrorismo, la prevención del tráfico de seres humanos o la búsqueda de una persona desaparecida.

Otros usos de la IA estarán totalmente prohibidos en la UE, entre ellos la creación de bases de datos de reconocimiento facial como las de Clearview AI o el uso de tecnología de reconocimiento de emociones en el trabajo o en las escuelas. La Ley de IA obligará a las empresas a ser más transparentes sobre el modo en que desarrollan sus modelos, y hará que tanto ellas como las organizaciones que utilicen sistemas de IA de alto riesgo asuman mayor responsabilidad de los daños resultantes.

Las empresas que desarrollen modelos fundacionales —los modelos en los que se basan otros productos de IA, como el GPT-4— tendrán que cumplir la ley en el plazo de un año a partir de su entrada en vigor. Otras empresas tecnológicas tienen dos años para aplicar las normas.

Para cumplir los nuevos requisitos, las empresas de IA tendrán que ser más cuidadosas a la hora de desarrollar sus sistemas y documentar su trabajo de forma más rigurosa para que pueda ser auditado. La ley obligará a las empresas a ser más transparentes sobre cómo se han entrenado sus modelos y garantizará que los sistemas de IA considerados de alto riesgo se entrenen y prueben con conjuntos de datos suficientemente representativos para minimizar los sesgos, por ejemplo.

La UE cree que los modelos de IA más potentes, como GPT-4 de OpenAI y Gemini de Google, podrían suponer un riesgo "sistémico" para los ciudadanos y, por tanto, necesitan un trabajo adicional para cumplir las normas de la UE. Las empresas deben tomar medidas para evaluar y mitigar los riesgos y garantizar que los sistemas sean seguros, y se les exigirá que informen de incidentes graves y compartan detalles sobre su consumo de energía. Corresponderá a las empresas evaluar si sus modelos son lo bastante potentes para entrar en esta categoría.

Las empresas de IA de código abierto están exentas de la mayor parte de los requisitos de transparencia de la Ley de IA, a menos que desarrollen modelos tan intensivos en computación como GPT-4. El incumplimiento de las normas puede acarrear multas elevadas o el bloqueo de sus productos en la UE.

La UE también está trabajando en otro proyecto de ley, la Directiva sobre responsabilidad civil en materia de IA, que garantizará que las personas perjudicadas por la tecnología puedan obtener una compensación económica. Las negociaciones al respecto siguen su curso y es probable que se reanuden este año.

Otros países adoptan una postura más indiferente. Por ejemplo, el Reino Unido, sede de Google DeepMind, ha dicho que no tiene intención de regular la IA a corto plazo. Sin embargo, cualquier empresa de fuera de la UE, la segunda economía más grande del mundo, tendrá que cumplir la Ley de IA si quiere hacer negocios en el bloque comercial.

Anu Bradford, catedrática de Derecho de la Universidad de Columbia, ha llamado a esto el "efecto Bruselas": al ser la primera en regular, la UE puede establecer la norma mundial de facto, configurando la forma en que el mundo hace negocios y desarrolla la tecnología. La UE lo consiguió con su estricto régimen de protección de datos, el RGPD, que se ha copiado en todas partes, desde California hasta la India. Espera repetir la jugada en lo que respecta a la IA.

China

Hasta ahora, la regulación de la IA en China ha sido muy fragmentada y poco sistemática. En lugar de regular la IA en su conjunto, el país ha promulgado leyes individuales cada vez que un nuevo producto de IA cobra importancia. Por eso China tiene un conjunto de normas para los servicios de recomendación algorítmica (aplicaciones tipo TikTok y motores de búsqueda), otro para los deepfakes y otro para la IA generativa.

El punto fuerte de este enfoque es que permite a Pekín reaccionar rápidamente a los riesgos que surgen de los avances tecnológicos, tanto para los usuarios como para el Gobierno. Pero el problema es que impide que se desarrolle una perspectiva más panorámica y a largo plazo.

Eso podría cambiar el año que viene. En junio de 2023, el Consejo de Estado de China, máximo órgano de gobierno, anunció que en su agenda legislativa figura "una ley de inteligencia artificial". Esta ley lo abarcaría todo, como la Ley de Inteligencia Artificial para Europa. Debido a su ambicioso alcance, es difícil decir cuánto durará el proceso legislativo. Podríamos ver un primer borrador en 2024, pero podría tardar más. Mientras tanto, no sería de extrañar que los reguladores chinos de Internet introdujeran nuevas normas para hacer frente a las nuevas herramientas populares de IA o a los tipos de contenidos que surjan el año que viene.

Hasta ahora se ha publicado muy poca información al respecto, pero un documento podría ayudarnos a predecir la nueva ley: los académicos de la Academia China de Ciencias Sociales, un instituto de investigación de propiedad estatal, publicaron en agosto una versión con "sugerencias de expertos" de la ley china sobre IA. Este documento propone una "oficina nacional de IA" para supervisar el desarrollo de la IA en China, exige un "informe de responsabilidad social" anual independiente sobre los modelos fundacionales y establece una "lista negativa" de áreas de IA con mayores riesgos, que las empresas ni siquiera pueden investigar sin la aprobación del Gobierno.

En la actualidad, las empresas chinas de IA ya están sujetas a numerosas normativas. De hecho, cualquier modelo fundacional debe ser registrado ante el Gobierno antes de que pueda darse a conocer al público chino (a finales de 2023, 22 empresas habían registrado sus modelos de IA).

Esto significa que la IA en China ya no es el salvaje Oeste. Pero aún no se sabe exactamente cómo se aplicará esta normativa. En el próximo año, las empresas de IA generativa tendrán que tratar de averiguar la realidad del cumplimiento normativo, especialmente en torno a las revisiones de seguridad y la infracción de la propiedad intelectual.

Al mismo tiempo, dado que las empresas extranjeras de IA no han recibido ninguna aprobación para comercializar sus productos en China (y probablemente no la reciban en el futuro), el entorno comercial nacional resultante protege a las empresas chinas. Puede ayudarles a obtener una ventaja frente a las empresas occidentales de IA, pero también puede reprimir la competencia y reforzar el control chino de la expresión en línea.

El resto del mundo

Es probable que a lo largo del próximo año veamos cómo se introducen más normativas sobre IA en otras partes del mundo. Una región a tener en cuenta será África. Es probable que la Unión Africana publique una estrategia de IA para el continente a principios de 2024, con el fin de establecer políticas que los distintos países puedan replicar para competir en IA y proteger a los consumidores africanos de las empresas tecnológicas occidentales, afirma Melody Musoni, responsable de políticas del Centro Europeo de Gestión de Políticas de Desarrollo.

Algunos países, como Ruanda, Nigeria y Sudáfrica, ya han elaborado estrategias nacionales de IA y están trabajando para desarrollar programas educativos, potencia informática y políticas favorables a la industria para apoyar a las empresas de IA. Organismos mundiales como la ONU, la OCDE, el G20 y las alianzas regionales han empezado a crear grupos de trabajo, consejos consultivos, principios, normas y declaraciones sobre la IA. Grupos como la OCDE pueden resultar útiles para crear una coherencia normativa entre las diferentes regiones, lo que podría aliviar la carga de cumplimiento para las empresas de IA.

Desde el punto de vista geopolítico, es probable que veamos diferencias cada vez mayores entre la forma en que los países democráticos y los autoritarios fomentan (y convierten en armas) sus industrias de IA. Será interesante ver hasta qué punto las empresas de IA priorizan la expansión global o la especialización doméstica en 2024. Puede que tengan que tomar algunas decisiones difíciles.