Un estudio de 'MIT Technology Review' ha descubierto que estos gigantes tecnológicos están pagando millones de dólares a operadores de páginas 'clickbait', lo que patrocina el deterioro de los ecosistemas de información en todo el mundo

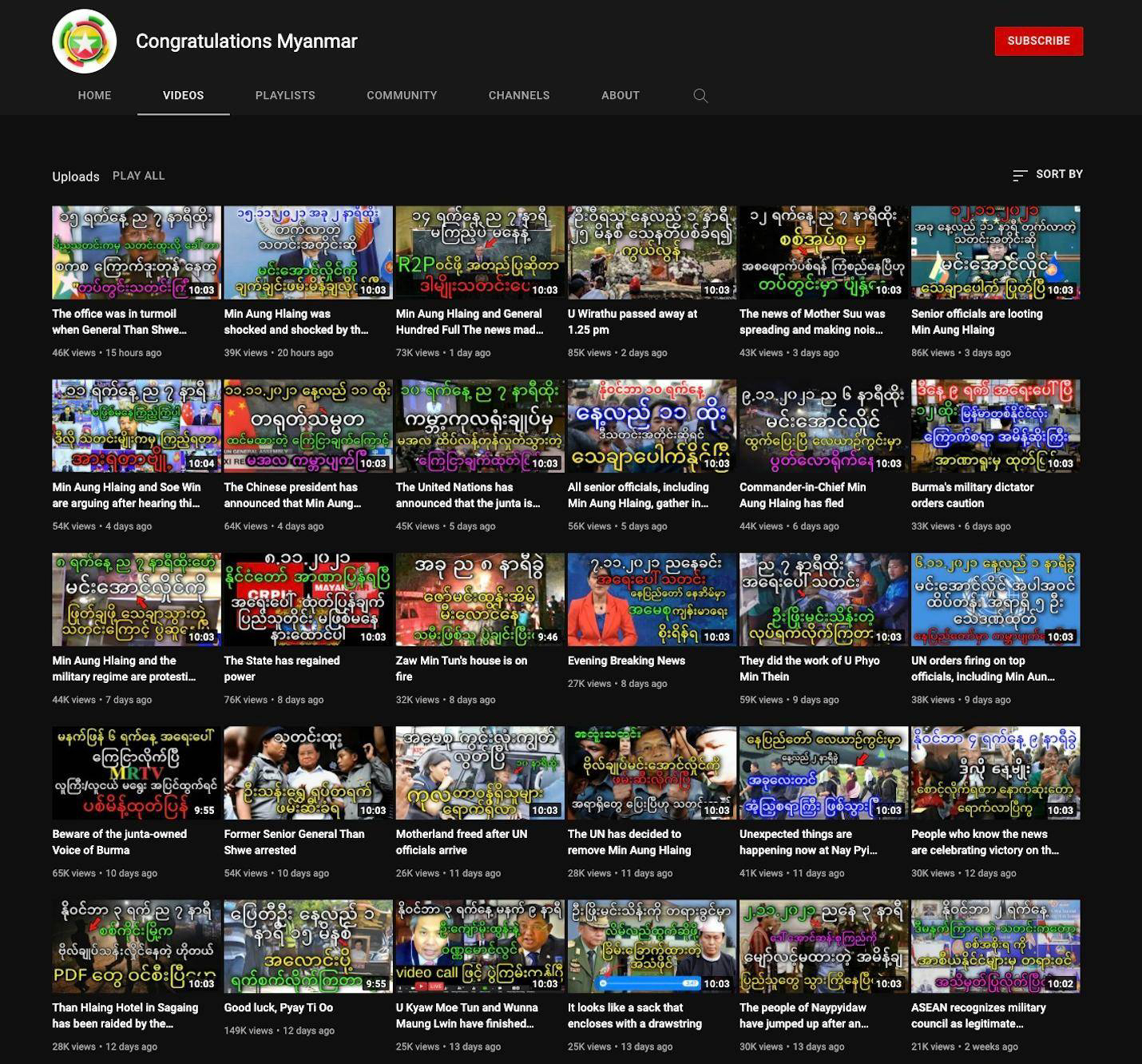

Myanmar, marzo de 2021.

Un mes después de la caída del Gobierno democrático.

Un vídeo de Facebook Live mostró a centenares de personas protestando contra el golpe militar en las calles de Myanmar (antes Birmania).

Se compartió casi 50.000 veces y tuvo más de 1,5 millones de visualizaciones, en un país con poco más de 54 millones de habitantes.

Los analistas, incapaces de ver estos acontecimientos sobre el terreno, utilizaron las imágenes, junto con cientos de otras transmisiones en directo, para seguir y documentar esa nueva situación. (MIT Technology Review difuminó los nombres y las imágenes para no poner en peligro la seguridad de los creadores de las publicaciones).

Pero menos de un día después, el mismo vídeo se retransmitía de nuevo varias veces, y siempre afirmando estar en directo.

En medio de una enorme crisis política, ya no había forma de distinguir qué era real y qué no.

En 2015, seis de los 10 sitios web en Myanmar con mayor engagement en Facebook eran medios de comunicación legítimos, según los datos de la herramienta CrowdTangle, gestionada por Facebook. Un año más tarde, Facebook (que recientemente cambió su nombre a Meta) ofreció acceso global a Instant Articles, el programa que podían usar los publishers o editores (creadores de contenido y distribuidores de este, además de propietarios de algún soporte digital en el cual se pueden poner anuncios) para monetizar su contenido.

Un año después de ese lanzamiento, los publishers legítimos del top 10 de Facebook en Myanmar eran solo dos. En 2018, no había ninguno. En cambio, casi toda la participación de los usuarios de Facebook se había ido a los sitios web de clickbait y a las noticias falsas. En un país donde Facebook es sinónimo de internet, el contenido de baja calidad supera y mucho a otras fuentes de información.

Fue durante esta rápida degradación del entorno digital de Myanmar cuando en agosto de 2017 un grupo militante de la minoría étnica rohinyá (mayoritariamente musulmana) atacó y mató a una docena de miembros de las fuerzas de seguridad. Cuando la policía y el ejército empezaron a tomar medidas enérgicas contra la comunidad rohinyá y a difundir la propaganda antimusulmana, se volvieron virales las publicaciones de noticias falsas que capitalizaban ese sentimiento. Afirmaban que los musulmanes iban armados, que se estaban organizando en grupos de 1.000 personas, que se encontraban a la vuelta de la esquina y que venían a matar.

Todavía no está claro si esas noticias falsas provenían principalmente de los operadores políticos o de los otros motivados por el dinero. Pero de cualquier manera, el gran volumen de noticias falsas y clickbait era como echar más leña al fuego de las ya peligrosas tensiones étnicas y religiosas. Eso cambió la opinión pública y agravó el conflicto, que finalmente provocó la muerte de 10.000 miembros de la comunidad rohinyá, según las estimaciones conservadoras, y el desplazamiento de 700.000 más.

En 2018, una investigación de Naciones Unidas determinó que la violencia contra la minoría rohinyá constituía un genocidio y que Facebook había tenido un "papel determinante" en esas atrocidades. Varios meses después, Facebook admitió que no había hecho lo suficiente "para ayudar a evitar que nuestra plataforma se utilizara para fomentar la división e incitar a la violencia offline".

Durante las últimas semanas, las revelaciones del conjunto de documentos internos Facebook Papers, proporcionados por la denunciante Frances Haugen al Congreso de EE. UU. y a un consorcio de medios de comunicación, han reafirmado algo que los grupos de la sociedad civil llevan demandando durante años: la amplificación algorítmica del contenido provocativo en Facebook, junto con la incapacidad de la empresa para priorizar la moderación del contenido fuera de EE. UU. y Europa, ha impulsado la propagación del discurso de odio y de la desinformación, lo que ha desestabilizado peligrosamente a distintos países de todo el mundo.

Pero falta una pieza crucial en esa historia. Facebook no solo potencia la desinformación.

Esta empresa también la financia.

Una investigación de MIT Technology Review, basada en entrevistas con expertos, análisis de datos e informes que no se incluyeron en Facebook Papers descubrió que Facebook y Google estaban pagando millones de dólares por la publicidad para financiar a los operadores de clickbait, lo que había fomentado el deterioro de los ecosistemas de información alrededor del mundo.

La anatomía de una granja de clickbait

Facebook lanzó su programa de Instant Articles en 2015 con un puñado de publishers estadounidenses y europeos. La compañía presentó el programa como una forma de mejorar los tiempos de carga de las publicaciones y crear una experiencia más fluida para el usuario.

Esa fue la presentación pública. Pero así también atrajo el dinero para la publicidad de Google y de manera muy oportuna. Antes de Instant Articles, lo que se publicaba en Facebook se redirigía a un navegador, donde se abría el propio sitio web del publisher. El proveedor de anuncios, generalmente Google, sacaba provecho de la cantidad de las visualizaciones del anuncio o de los clics. Con el nuevo esquema, las publicaciones se abrían directamente dentro de la app de Facebook, y el propietario del espacio publicitario era Facebook. Si un publisher participante también quisiera monetizar con la red de publicidad de Facebook, denominada Audience Network, Facebook podía introducir anuncios en las historias del publisher y quedarse con un 30 % de los ingresos.

Instant Articles perdió rápidamente el apoyo de su primer grupo de grandes publishers. Para ellos, los pagos no fueron lo suficientemente altos en comparación con otras formas disponibles de monetización. Sin embargo, no fue así para los editores del sur global, que Facebook empezó a aceptar en el programa en 2016. En 2018, la compañía informó haber pagado 1.500 millones de dólares (1.334 millones de euros) a los creadores y distribuidores de contenido y desarrolladores de apps (que también pueden participar en Audience Network). En 2019, esa cifra había alcanzado varios miles de millones.

Al principio, Facebook realizaba poco control de calidad sobre los tipos de publishers que se unían al programa. El diseño de la plataforma tampoco penalizaba suficientemente a los usuarios por publicar contenido idéntico en distintas páginas de Facebook; de hecho, recompensaba esa actividad. Publicar lo mismo en varias páginas podía duplicar la cantidad de usuarios que hacían clic en esa publicación y generar ingresos publicitarios.

Las granjas de clickbait de todo el mundo aprovecharon este fallo como estrategia, que todavía siguen practicando hoy en día:

Una granja creará un sitio web o varios sitios web...

… para publicar contenido en su mayoría plagiado.

Los registra en Instant Articles y Audience Network,

que introducen anuncios en sus publicaciones.

Luego, estas publicaciones aparecen en un grupo de docenas de páginas de Facebook a la vez.

Los operadores de clickbait surgieron en Myanmar de la noche a la mañana. Con la fórmula acertada para producir contenido atractivo y sugerente, podían generar al mes miles de dólares estadounidenses como ingresos publicitarios, o 10 veces el salario mensual promedio, que les pagaba Facebook directamente.

Scammers used to make their $$ from naive people. Now they get their payments straight from some of the world's biggest tech companies. Sorry David -- but this is NOT equivalent. https://t.co/mhMZMTNi6e pic.twitter.com/hgqYBcHw8U

— Victoire Rio (@riovictoire) September 19, 2021

If this is wild - let's check out @google, who officially says it does not enable monetisation in Myanmar (too risky) but in practice turns a blind eye and finds no issue with making payments into Myanmar bank accounts

The rules https://t.co/vCdrTpkGbf https://t.co/gX2FbeIa00 pic.twitter.com/dYV3eJp2eH— Victoire Rio (@riovictoire) September 20, 2021

Un informe interno de Facebook, publicado por primera vez por MIT Technology Review el pasado octubre, muestra que ya en 2019 Facebook estaba al tanto del problema. El autor del informe, el excientífico de datos de Facebook Jeff Allen, descubrió que estas tácticas exactas habían permitido que las granjas de clickbait de Macedonia del Norte y Kosovo llegaran a casi medio millón de estadounidenses un año antes de las elecciones presidenciales de EE. UU. de 2020. Las granjas también se habían abierto camino en Instant Articles y Ad Breaks, el programa similar de monetización para introducir anuncios en los vídeos de Facebook. En un momento dado, según el informe, hasta el 60 % de los dominios registrados en Instant Articles estaban utilizando las tácticas de spam empleadas por las granjas de clickbait. Allen no hizo comentarios sobre el informe debido a un acuerdo de confidencialidad que había firmado con Facebook.

A pesar de la presión de los investigadores internos y externos, Facebook se resistía a contener ese abuso. Mientras tanto, la empresa implementaba más programas de monetización para abrir nuevas fuentes de ingresos. Además de Ad Breaks para vídeos, apareció IGTV Monetization para Instagram e In-Stream Ads para vídeos en directo. La investigadora de derechos digitales Victoire Rio, que lucha contra los daños provocados por las plataformas en Myanmar y en otros países del sur global, afirma: "Como aquel tremendo esfuerzo para incrementar el número de los usuarios que vimos antes, en la actualidad estamos viendo otro impulso bestial para el aumento de los editores".

MIT Technology Review ha descubierto que este problema ocurre actualmente a escala global. Han surgido miles de operadores de clickbait, principalmente en los países donde los pagos de Facebook proporcionan una fuente de ingresos más grande y estable que otras formas de trabajo disponible. En algunos casos se trata de equipos de personas, mientras que en otros son individuos, apoyados por las herramientas automatizadas baratas que les ayudan a crear y distribuir contenido a gran escala. Ya no se limitan solo a publicar contenido. Lanzan vídeos en directo y manejan cuentas de Instagram que monetizan directamente o las usan para generar más tráfico en sus sitios web.

Google también es culpable. Su programa AdSense impulsó las granjas de Macedonia del Norte y Kosovo que se dirigieron al público estadounidense en el período previo a las elecciones presidenciales del país en 2016. Además, AdSense incentiva a los nuevos operadores de clickbait en YouTube para que publiquen contenido escandaloso y desinformación viral.

En la actualidad, muchas granjas de clickbait monetizan tanto con Instant Articles como con AdSense, y reciben pagos de ambas compañías. Y como los algoritmos de Facebook y YouTube potencian todo lo que atrae a los usuarios, han creado un ecosistema de información en el que el contenido que se vuelve viral en una plataforma a menudo se recicla en la otra para maximizar la distribución y los ingresos.

"Estos operadores no existirían si no fuera por las plataformas", asegura Rio.

En respuesta a las pruebas detalladas que proporcionamos a ambas empresas sobre este comportamiento, el portavoz de Meta, Joe Osborne, cuestionó nuestros hallazgos principales y resaltó que habíamos entendido mal el problema. Afirmó: "De todas formas, hemos invertido durante muchos años en la creación de nuevas soluciones escalables y dirigidas por expertos para estos problemas complejos, y continuaremos haciéndolo.

Google confirmó que ese comportamiento violó sus políticas y canceló los canales de YouTube que MIT Technology Review había identificado como difusores de desinformación. La portavoz de YouTube, Ivy Choi, especificó: "Trabajamos arduamente para proteger a los espectadores del clickbait o del contenido engañoso en nuestras plataformas y hemos invertido mucho en los sistemas diseñados para promover la información fidedigna".

Las granjas de clickbait no solo se dirigen a sus países de origen. Siguiendo el ejemplo de los operadores de Macedonia del Norte y Kosovo, las más recientes se han dado cuenta de que no es necesario comprender ni el contexto local de un país ni su idioma para convertir la indignación política en ingresos.

MIT Technology Review colaboró con Allen (que actualmente dirige la organización sin ánimo de lucro Integrity Institute, que realiza investigaciones sobre el abuso de las plataformas) para identificar posibles operadores de clickbait en Facebook. Nos hemos centrado en las páginas que se administran desde Camboya y Vietnam, dos de los países donde la gestión de clickbait está sacando provecho de la situación en Myanmar.

Obtuvimos datos de CrowdTangle (cuyo equipo de desarrollo Facebook había disuelto a principios de este año) y de las listas de editores de Facebook, que enumeran a los publishers registrados en los programas de monetización. Allen escribió un algoritmo específico de agrupación para encontrar las páginas que publican contenido de una manera muy coordinada y dirigido a hablantes de idiomas que se utilizan principalmente fuera de los países donde operan. Luego analizamos qué grupos tenían al menos una página registrada en algún programa de monetización o promocionaban fuertemente el contenido de alguna página registrada en el programa.

Hemos encontrado más de 2.000 páginas en ambos países involucradas en este comportamiento similar al de clickbait. (Ese número podría resultar incompleto, porque CrowdTangle no rastrea todas las páginas de Facebook). Muchas tienen millones de seguidores y probablemente lleguen a todavía más usuarios de Facebook. En su informe de 2019, Allen descubrió que el 75 % de los usuarios que estuvieron expuestos al contenido de clickbait de las granjas gestionadas desde Macedonia del Norte y Kosovo nunca habían seguido ninguna de esas páginas. En cambio, el sistema de recomendación de contenido de Facebook lo había incluido en su feed de noticias.

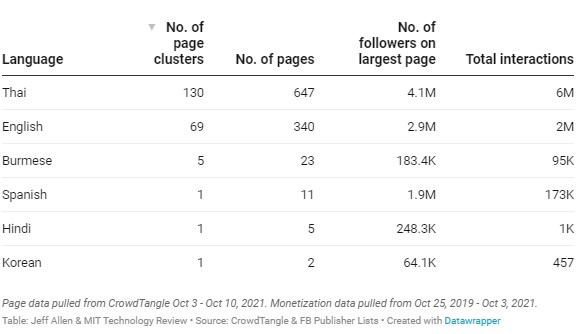

Tabla: Grupos de páginas en idiomas extranjeros administradas desde Camboya registrados en los programas de monetización de Facebook durante los últimos dos años

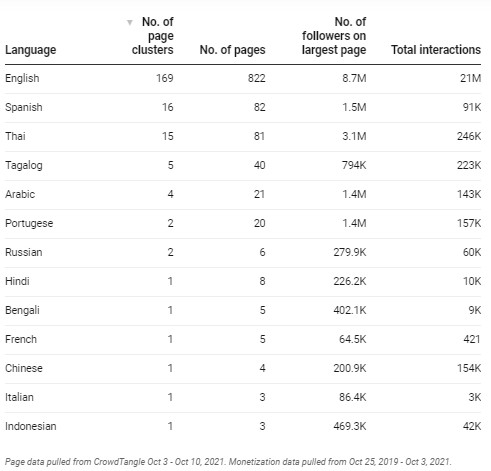

Tabla: Grupos de páginas en idiomas extranjeros administradas desde Vietnam registrados en los programas de monetización de Facebook durante los últimos dos años

Cuando MIT Technology Review envió a Facebook la lista de estas páginas y una explicación detallada de nuestra metodología, Osborne calificó el análisis como "defectuoso". "Si bien algunas páginas de estas podrían haber estado en nuestras listas de editores, muchas de ellas en realidad no habían monetizado en Facebook", respondió.

En efecto, estos números no indican que todas estas páginas generaran ingresos publicitarios. En realidad, se trata de una estimación, basada en los datos que Facebook había hecho públicamente disponibles, de la cantidad de páginas asociadas con los operadores de clickbait en Camboya y Vietnam que Facebook había habilitado para monetizar en su plataforma.

Osborne también confirmó que un mayor número de las páginas similares a clickbait administradas desde Camboya del que habíamos encontrado nosotros se habían registrado directamente en alguno de los programas de monetización de Facebook. En nuestro análisis, descubrimos que en los últimos dos años lo habían hecho el 35 % de las páginas de nuestro grupo. El otro 65 % habría generado ingresos publicitarios indirectamente promoviendo el contenido de alguna página registrada a un público más amplio. Osborne aclaró que, de hecho, aproximadamente la mitad de las páginas que habíamos encontrado, o aproximadamente 150 páginas más, se habían registrado directamente en algún momento dado en algún programa de monetización, principalmente en Instant Articles.

Poco después de comunicarnos con Facebook, los operadores de las páginas de clickbait en Myanmar empezaron a quejarse en los foros online de que sus páginas habían sido sacadas de Instant Articles. Osborne no ha querido responder a nuestras preguntas sobre las últimas acciones y medidas coercitivas que ha tomado la empresa.

Facebook ha procurado continuamente eliminar a estos operadores de sus programas. Por ejemplo, Osborne especificó que solo 30 de las páginas administradas desde Camboya todavía están monetizando. Pero nuestros datos de las listas de publishers de Facebook muestran que ese esfuerzo a menudo se retrasa y resulta incompleto; las páginas de clickbait pueden permanecer dentro de los programas de monetización durante cientos de días antes de que se eliminen. Los mismos operadores también abren nuevas páginas cuando las antiguas se desmoneticen.

Allen acaba de publicar el código abierto que hemos usado para animar a otros investigadores independientes a profundizar y desarrollar aún más nuestro trabajo.

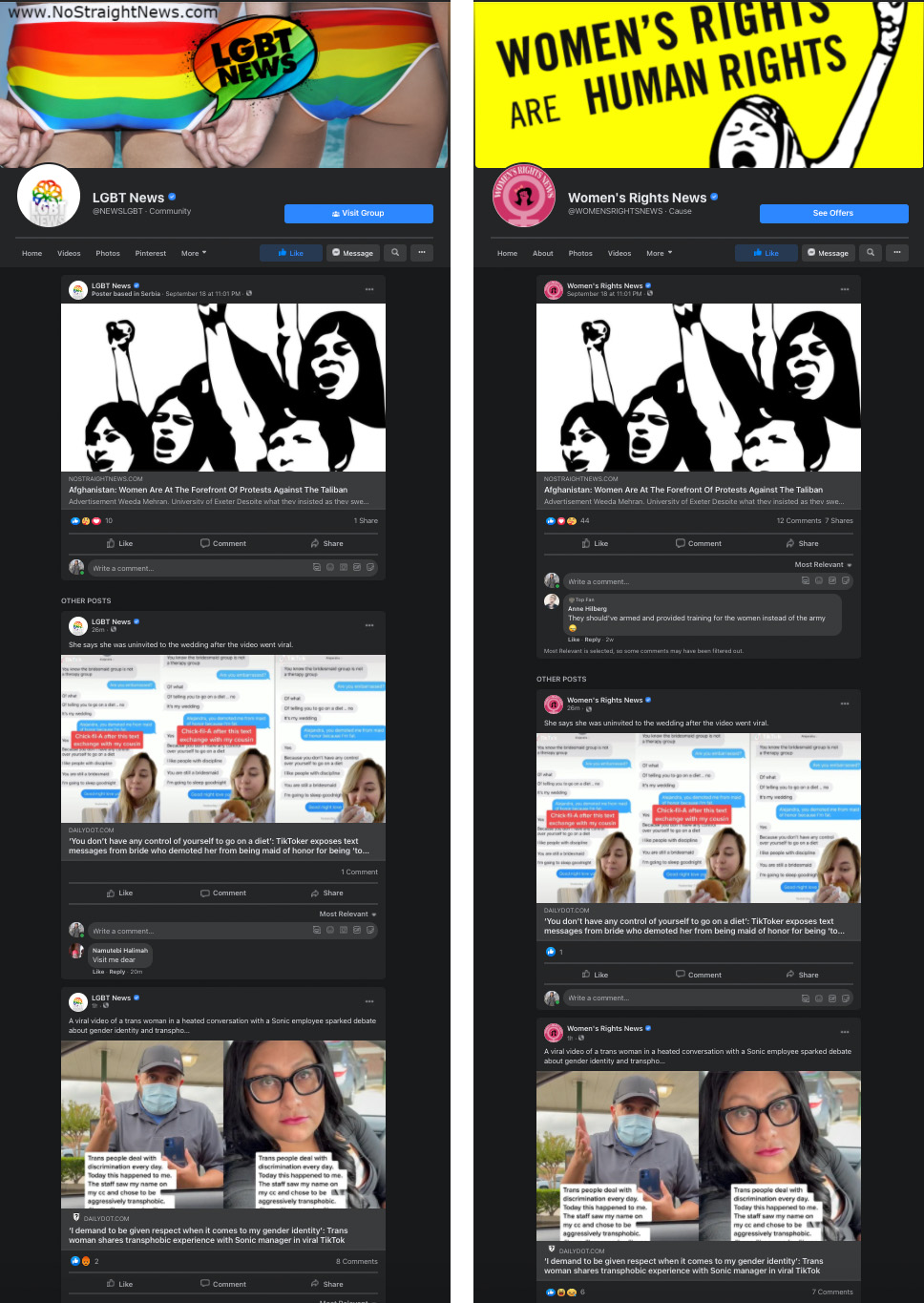

Con la misma metodología, también hemos encontrado más de 400 páginas administradas desde el extranjero, dirigidas principalmente al público estadounidense, en los grupos que aparecieron en las listas de editores de Facebook durante los últimos dos años. (No hemos incluido las páginas de los países cuyo idioma principal es el inglés). En el conjunto aparece un grupo de monetización gestionado en parte desde Macedonia del Norte y dirigido a mujeres y a la comunidad LGBTQ. Tiene ocho páginas de Facebook, incluidas dos verificadas con más de 1,7 millones y 1,5 millones de seguidores respectivamente, y publica contenido de cinco sitios web, cada uno registrado en Google AdSense y Audience Network. También tiene tres cuentas de Instagram, que monetizan a través de las tiendas de regalos y colaboraciones y al dirigir a los usuarios a los mismos sitios web plagiados en su mayoría. Los administradores de las páginas de Facebook y de las cuentas de Instagram no respondieron a nuestras solicitudes de comentarios.

Foto: Las páginas de LGBT News y Women's Rights News en Facebook publican contenido idéntico de cinco de sus propios sitios afiliados que monetizan con Instant Articles y Google AdSense, así como de otros medios de comunicación con los que parece que tienen acuerdos de pago.

Osborne ha asegurado que Facebook ya está investigando las cuentas, después de nuestra llamada de atención a la compañía. Choi afirmó que Google había eliminado en el pasado los anuncios de AdSense de centenares de páginas en estos sitios debido a las infracciones de sus políticas, pero los propios sitios todavía podían monetizar en función de las evaluaciones periódicas de la empresa.

Si bien es posible que los macedonios que administran estas páginas se preocupen por la política de Estados Unidos y por los derechos de las mujeres y de las personas LGBTQ, es innegable que el contenido genera ingresos. Esto significa que lo que promueven probablemente se guíe por las preferencias del algoritmo de feed de noticias de Facebook.

La investigadora de la Universidad de Columbia (EE. UU.) Camille François, que estudia las campañas de desinformación organizadas en las redes sociales, señala que la actividad de una sola página o de un grupo de páginas puede no parecer tan significativa. Pero cuando cientos o miles de operadores hacen lo mismo, amplificando el mismo contenido y llegando a millones de personas, eso puede afectar al debate público. "Lo que la gente ve como una conversación local sobre un tema en realidad puede ser algo completamente diferente", destaca François. "Es un grupo de personas pagadas que fingen no tener ninguna relación entre sí, optimizando lo que publican".

Osborne resaltó que Facebook había creado en los últimos dos años varias políticas nuevas y protocolos de implementación para abordar este problema, incluida la penalización de las páginas que se administran fuera de un país pero que se comportan como si fueran del país del que no son, así como la penalización de las páginas que construyen una audiencia basándose en un tema y luego pasan a otro distinto. Sin embargo, tanto Allen como Rio señalan que las medidas de la compañía no han logrado cerrar las lagunas fundamentales en las políticas y diseños de la plataforma, ni esas vulnerabilidades que están provocando una crisis global de información.

"Afecta, sobre todo, a los países fuera de EE. UU., pero también presenta un enorme riesgo para EE. UU. a largo plazo", opina Rio. "Va a afectar prácticamente a cualquier parte del mundo cuando haya acontecimientos intensos como unas elecciones".

La desinformación por encargo

En respuesta al primer reportaje de MIT Technology Review sobre el informe interno de Allen de 2019, que habíamos publicado en su totalidad, el director de la unidad de Facebook que se encarga de luchar contra las amenazas políticas globales, David Agranovich, tuiteó: "Las páginas a las que se hace referencia aquí, basándose en nuestra propia investigación de 2019, son spammers con motivaciones económicas, no operaciones de influencia explícita. Se trata de serios desafíos en ambos casos, pero son diferentes. Mezclarlos no ayuda a nadie". En respuesta a nuestros hallazgos, Osborne repitió que estábamos mezclando los dos grupos.

Pero los expertos en desinformación creen que es engañoso separar tan estrictamente los spammers con motivos económicos de las operaciones de influencia política.

Hay una diferencia en cuanto el objetivo: los spammers motivados por el dinero no se involucran en el contenido que publican. Van dondequiera que estén los clics y el dinero, permitiendo que el algoritmo de feed de noticias de Facebook dicte los próximos temas que cubrir. En cambio, las operaciones políticas buscan impulsar una agenda específica.

Pero en la práctica, eso no importa: en sus tácticas e impacto, a menudo parecen iguales. En un día normal, un sitio de clickbait con motivaciones económicas puede estar repleto de noticias sobre los famosos, animales adorables o historias muy emotivas, y todo eso genera un tráfico seguro. Luego, cuando ocurre alguna crisis política, giran hacia las noticias hiperpartidistas, hacia la desinformación y el cebo de indignación, porque genera más participación de los usuarios.

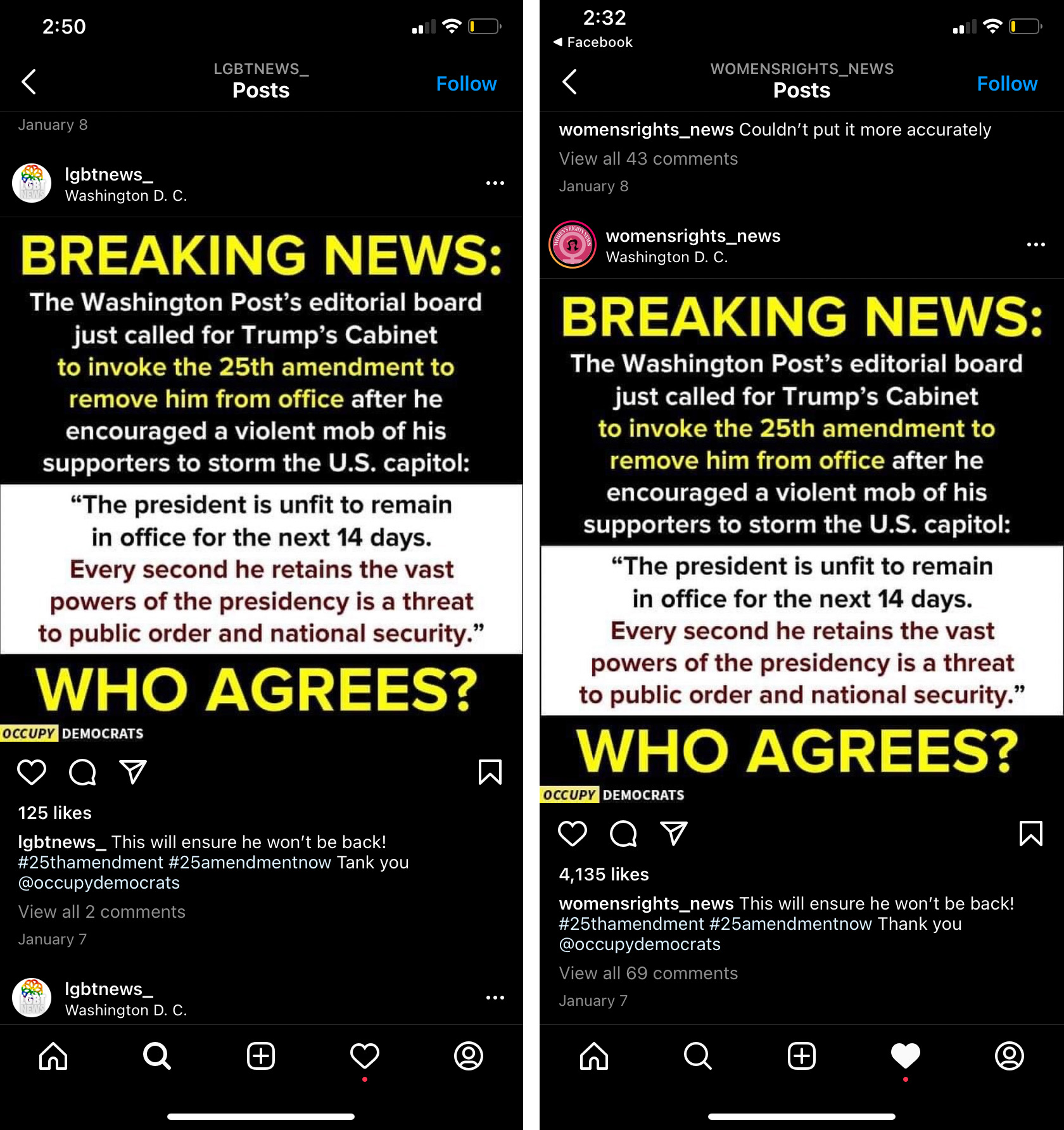

El grupo de páginas de Macedonia del Norte es un buen ejemplo de eso. En su mayoría, el contenido promueve los derechos de las mujeres y de las personas LGBTQ. Pero el grupo difundió el contenido político especialmente intenso en los acontecimientos como las elecciones presidenciales de EE. UU. en 2020, el asalto al Capitolio estadounidense del 6 de enero y la aprobación del proyecto de ley 'del latido del corazón' contra el aborto en Texas (EE. UU.). Muchas de sus publicaciones circulaban ampliamente por las páginas legítimas con un gran número de seguidores, incluidas las gestionadas por Occupy Democrats, The Union of Concerned Scientists y Women's March Global.

Foto: Un ejemplo de una publicación muy política que al final se eliminó de uno de los cinco sitios afiliados del grupo. Los sitios de clickbait a menudo eliminan las publicaciones antiguas de sus páginas.

Mientras tanto, las operaciones de influencia política pueden publicar contenido sobre los famosos y animales para construir sus páginas de Facebook y obtener así a muchos seguidores. Luego, también cambian hacia los temas políticos durante algunos acontecimientos políticos delicados y capitalizan las enormes audiencias que ya tienen a su disposición.

Los operadores políticos a veces también pagan a los spammers motivados por el dinero para que difundan propaganda en sus páginas de Facebook, o compran páginas para reutilizarlas luego en sus campañas de influencia. Rio ya ha visto evidencia de un mercado negro donde los operadores de clickbait venden sus grandes audiencias de Facebook.

En otras palabras, las páginas parecen inofensivas hasta que dejan de serlo. Allen escribió en el informe: "Hemos empoderado a los actores no auténticos para que acumulen un gran número de seguidores con fines en gran parte desconocidos".

Este cambio ha ocurrido muchas veces en Myanmar desde el auge de las granjas de clickbait, en particular durante la crisis de la comunidad rohinyá y de nuevo en el período previo y posterior al golpe militar de este año. (Este último fue provocado por las acciones muy similares a las que llevaron a la insurrección del 6 de enero en Estados Unidos, incluidas las falsas afirmaciones difundidas de elecciones robadas).

En octubre de 2020, Facebook eliminó una serie de páginas y grupos que participaban en un comportamiento coordinado de clickbait en Myanmar. En un análisis de esas acciones, Graphika, la empresa de investigación que estudia la difusión de información online, descubrió que esas páginas se centraban mayoritariamente en noticias de celebridades y cotilleo, pero publicaban también la propaganda política, la peligrosa retórica antimusulmana y la desinformación sobre la COVID-19 durante los períodos clave de los momentos de crisis. Decenas de páginas tenían más de 1 millón de seguidores cada una, y la más grande llegaba a más de 5 millones.

El mismo fenómeno ocurrió en Filipinas en el período previo a las elecciones de 2016 con el presidente Rodrigo Duterte, que ha sido comparado con Donald Trump por su política populista, retórica grandilocuente e inclinaciones autoritarias. Durante su campaña, una granja de clickbait, registrada oficialmente como la empresa Twinmark Media, pasó de dedicarse a los famosos y al entretenimiento a promocionarlo a él y su ideología.

En ese momento, se creía extensamente que los políticos habían contratado a Twinmark para realizar una campaña de influencia. Pero en varias entrevistas con periodistas e investigadores, los exempleados de Twinmark admitieron que simplemente buscaban ganancias. A través de la experimentación, los empleados descubrieron que el contenido pro-Duterte sobresalía en esas elecciones tan tensas. Incluso pagaban a otros famosos e influencers para que compartieran sus publicaciones con el fin de obtener más clics y generar más ingresos publicitarios, según una investigación de los especialistas en medios y comunicación Jonathan Ong y Jason Vincent A. Cabañes.

En los últimos meses de la campaña, Duterte dominaba el discurso político en las redes sociales. El propio Facebook lo nombró el "rey indiscutible de los debates en Facebook" cuando descubrió que era el tema del 68 % de las discusiones relacionadas con las elecciones, en comparación con el 46 % de su mayor rival.

Tres meses después de las elecciones, la CEO de la empresa de medios Rappler y ganadora del Premio Nobel de la Paz por su trabajo en la lucha contra la desinformación, Maria Ressa, publicó un artículo que describe cómo el clickbait coordinado y la propaganda en Facebook "cambiaron la opinión pública sobre temas clave".

"Es la estrategia de la 'muerte por mil cortes', cuestionando los hechos, utilizando medias verdades que crean una realidad alternativa fusionando el poder de los bots y de las cuentas falsas en las redes sociales para manipular a personas reales", escribió.

En 2019, Facebook eliminó finalmente 220 páginas y 73 cuentas de Facebook y 29 cuentas de Instagram vinculadas a Twinmark Media. Hasta entonces, Facebook y Google ya habían pagado a esta granja hasta 8 millones de dólares (7,14 millones de euros o 400 millones de pesos filipinos).

Ni Facebook ni Google confirmaron esta cantidad. Osborne, de Meta, puso en duda la idea de que Facebook había influido en las elecciones.

Una amenaza en evolución

Facebook realizó un gran esfuerzo para eliminar las granjas de clickbait de Instant Articles y de Ad Breaks en la primera mitad de 2019, según el informe interno de Allen. En concreto, se empezó a verificar la originalidad del contenido de los editores y a desmonetizar a aquellos que publicaban contenido en gran parte no original.

Pero estos controles automatizados resultan limitados. Se centran principalmente en evaluar la originalidad de los vídeos y no, por ejemplo, en si una publicación ha sido plagiada. Incluso si lo hicieran, dichos sistemas solo serían tan buenos como las capacidades de inteligencia artificial (IA) de la empresa en un idioma determinado. Los países con idiomas no priorizados por la comunidad de investigación de IA reciben mucha menos atención, si es que reciben alguna. "En el caso de Etiopía hay 100 millones de personas y seis idiomas. Facebook solo admite dos de esos idiomas para los sistemas de integridad", afirmó Haugen durante su testimonio ante el Congreso.

Rio asegura que también hay lagunas en el control. Los infractores se sacan del programa pero no de la plataforma, y pueden apelar para que se les reintegre. Las apelaciones son procesadas por un equipo separado del otro que se encarga del control y realiza solo unas verificaciones temáticas básicas antes de reintegrar al infractor. (Facebook no respondió a las preguntas sobre lo que realmente analizan estas comprobaciones). Como resultado, un operador de clickbait puede tardar unas horas en volver a unirse una y otra vez después de su eliminación. "De alguna manera, los equipos no se hablan entre sí", resalta Rio.

Así es como Rio se encontró en estado de pánico en marzo de este año. Un mes después de que los militares arrestaran a la exlíder democrática Aung San Suu Kyi y tomaran el control del Gobierno, los manifestantes seguían enfrentándose de forma violenta con el nuevo régimen. El ejército cortaba esporádicamente el acceso a internet y a las redes de transmisión, y Rio estaba aterrorizada por la seguridad de sus amigos en el país.

Entonces empezó a buscarlos en los vídeos de Facebook Live. "La gente veía estos vídeos de manera muy activa porque así es como se hacía un seguimiento de los seres queridos", asegura. A Rio no le preocupaba ver que los vídeos provenían de páginas con problemas de credibilidad, porque creía que los streamers usaban páginas falsas para proteger su anonimato.

Entonces sucedió lo imposible: vio dos veces el mismo vídeo en directo. Lo recordaba porque era horrible: cientos de niños, que parecían de 10 años, en una fila con las manos en la cabeza, subían a los camiones militares.

Cuando empezó a investigar, descubrió que los vídeos no iban en directo. Los vídeos en vivo se idearon para indicar una transmisión en tiempo real e incluyen metadatos importantes sobre la hora y el lugar de esa actividad. Estos vídeos que encontró Rio se habían descargado de otro lugar y se retransmitían en Facebook utilizando herramientas de terceros para que parecieran transmisiones en directo.

Había cientos de ellos, que acumulaban decenas de miles de reacciones y cientos de miles de visualizaciones. A principios de noviembre, MIT Technology Review encontró decenas de falsos vídeos en directo duplicados y aún activos. En dos vídeos duplicados con más de 200.000 y 160.000 visualizaciones cada uno, se proclamaba en birmano: "Soy el único que transmite en directo desde todo el país en tiempo real". Facebook eliminó varios de ellos después de llamarle la atención, pero aún quedan decenas más, así como las páginas que los habían publicado. Osborne aseguró que la empresa estaba al tanto del problema y que durante el año pasado había reducido significativamente estos falsos vídeos directos y su distribución.

Irónicamente, Rio cree que estos vídeos probablemente fueron extraídos de otros vídeos de crisis subidos a YouTube como evidencia de derechos humanos. En otras palabras, las escenas son, efectivamente, de Myanmar, pero todas fueron publicadas desde Vietnam y Camboya.

Durante el último medio año, Rio ha rastreado e identificado varios grupos de páginas que se administraban desde Vietnam y Camboya. Muchos usaban falsos vídeos en directo para aumentar rápidamente su número de seguidores e impulsar a los espectadores a unirse a los grupos de Facebook disfrazados como comunidades a favor de la democracia. A Rio le preocupa que el último lanzamiento de anuncios in-stream de Facebook en los vídeos en vivo incentive aún más a los operadores de clickbait a publicarlos de forma falsa. Un grupo de Camboya con 18 páginas empezó a publicar desinformación política muy dañina, y alcanzó en cuatro meses un total de 16 millones de reacciones y un público de 1,6 millones de personas. Facebook eliminó las 18 páginas en marzo, pero los nuevos grupos siguen apareciendo mientras otros permanecen.

Según la información de la que dispone Rio, estos operadores vietnamitas y camboyanos no hablan birmano. Es probable que no comprendan la cultura birmana ni la política del país. La clave es que eso no es necesario si roban su contenido.

Desde entonces, Rio ha encontrado varios de los grupos privados de Facebook y Telegram de los camboyanos (uno con más de 3.000 personas), donde intercambian herramientas y consejos sobre las mejores estrategias para ganar dinero. MIT Technology Review revisó los documentos, imágenes y vídeos que Rio había reunido, y contrató a un traductor de jémer (idioma oficial de Camboya) para entender el vídeotutorial que guía a los espectadores paso a paso sobre el trabajo de clickbait.

Los materiales muestran cómo los operadores camboyanos recopilan investigaciones sobre el contenido de mejor rendimiento en cada país y lo plagian para sus sitios web clickbait. Una carpeta de Google Drive compartida dentro de la comunidad tiene dos docenas de hojas de enlaces a los grupos de Facebook más populares en 20 países, incluidos EE. UU., Reino Unido, Australia, India, Francia, Alemania, México y Brasil.

El vídeotutorial también muestra cómo encuentran los vídeos de YouTube más virales en diferentes idiomas y utilizan una herramienta automatizada para convertir cada uno en una publicación en su sitio. Encontramos 29 canales de YouTube que difunden desinformación política sobre la situación actual en Myanmar, por ejemplo, que se estaban convirtiendo en clickbait y redistribuyendo a nuevas audiencias en Facebook.

Foto: Uno de los canales de YouTube que difunde desinformación política en Myanmar. Al final, Google lo eliminó.

Después de nuestra llamada de atención sobre los canales, YouTube los eliminó a todos por violar sus normas comunitarias, incluidos siete canales que la empresa determinó que habían sido parte de operaciones coordinadas de influencia vinculadas a Myanmar. Choi señaló que anteriormente YouTube también había dejado de publicar anuncios en casi 2.000 vídeos en estos canales. "Seguimos monitoreando activamente nuestras plataformas para impedir los intentos de los malos actores de abusar de nuestra red a favor de su beneficio", afirmó la portavoz.

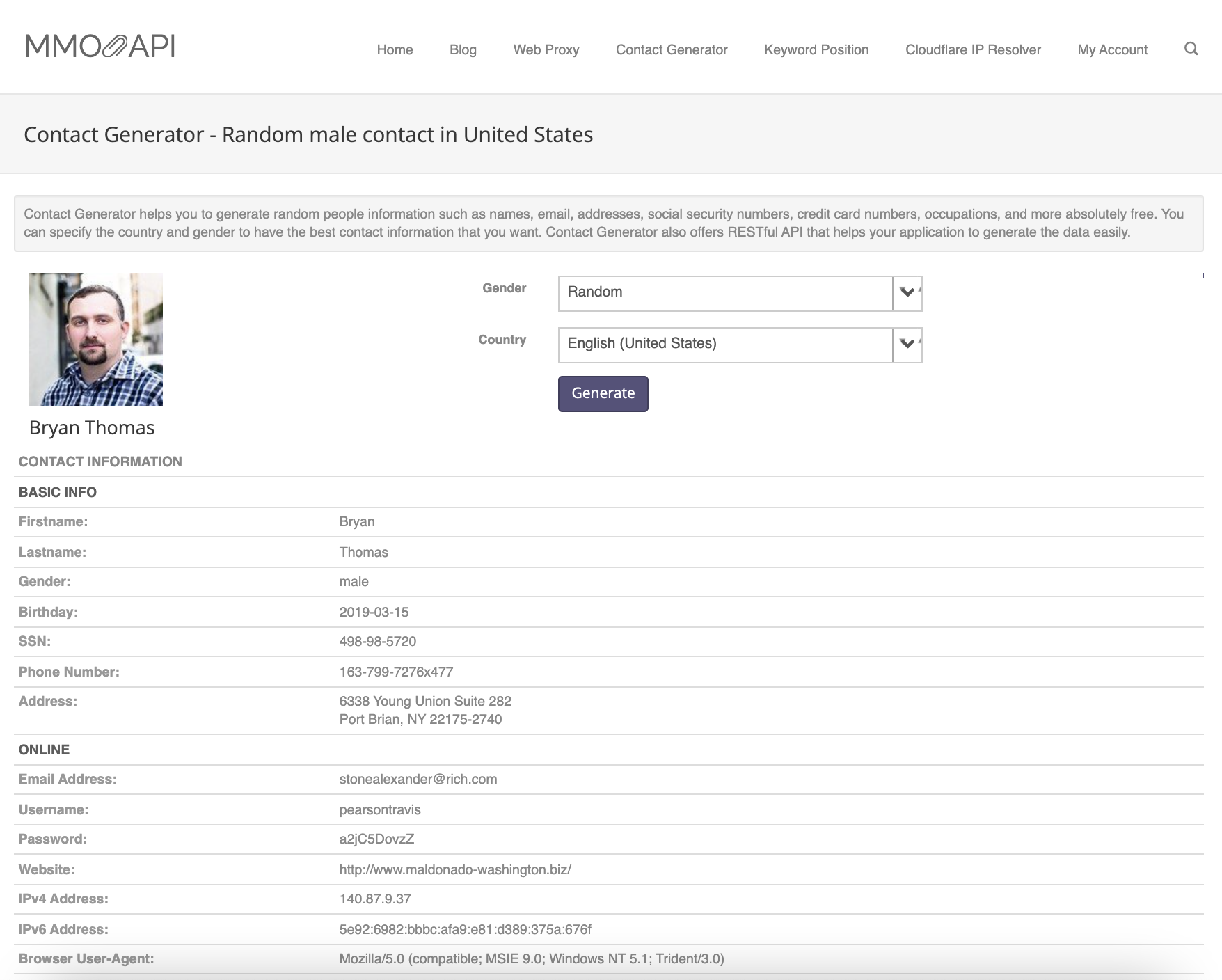

También hay otras herramientas, incluida una que permite que los vídeos pregrabados aparezcan como vídeos falsos de Facebook Live. Otra genera aleatoriamente detalles de perfil para hombres estadounidenses, junto con la imagen, el nombre, la fecha de nacimiento, el número de seguridad social, el número de teléfono y la dirección, para que otra herramienta produzca en masa falsas cuentas de Facebook utilizando parte de esa información.

Actualmente resulta fácil que muchos camboyanos operen solos de esta manera. Rio los llama microempresarios. En el escenario más extremo, Rio ha encontrado a individuos que administran hasta 11.000 cuentas de Facebook por sí solos.

Los microempresarios exitosos también están capacitando a otros para realizar este trabajo en su comunidad. "Va a empeorar", advierte. "Cualquier persona en el mundo podría estar afectando su entorno de información sin que usted se dé cuenta".

Beneficio por encima de la seguridad

Durante su testimonio en el Senado de EE. UU. en octubre de este año, Haugen destacó los defectos fundamentales del enfoque basado en contenidos de Facebook relacionados con el abuso de la plataforma. La estrategia actual, centrada en lo que puede aparecer en la plataforma y lo que no, solo puede ser reactiva y nunca integral, explicó. No solo requiere que Facebook enumere todas las formas posibles de abuso, sino también que la empresa sea competente para moderar en todos los idiomas. Facebook ha fallado en ambos aspectos, y las personas más vulnerables del mundo han pagado el precio más alto, aseguró Haugen.

El principal culpable, según Haugen, es el deseo de Facebook de maximizar la participación de los usuarios, que ha convertido su algoritmo y el diseño de su plataforma en una megafonía gigante para el discurso de odio y la desinformación. Una investigación de MIT Technology Review de principios de este año, basada en docenas de entrevistas con los directivos de Facebook, exempleados y algunos actuales, expertos de la industria y otros externos, corrobora esta calificación.

Su testimonio también se hizo eco de lo que Allen había escrito en su informe y de lo que Rio y otros expertos en desinformación habían detectado repetidamente a través de su investigación. Para las granjas de clickbait, entrar en los programas de monetización es el primer paso, pero la cantidad de dinero que ganan depende de hasta qué punto los sistemas de recomendación de contenido de Facebook impulsen sus publicaciones. No prosperarían, ni plagiarían ese contenido tan dañino, si sus tácticas turbias no funcionaran tan bien en la plataforma.

Como resultado, eliminar las granjas en sí no es la solución: los actores muy motivados siempre podrán crear nuevos sitios web y nuevas páginas para ganar más dinero. En cambio, son los algoritmos y los mecanismos de recompensa de contenido los que se deben abordar.

En su informe, Allen propuso una posible forma de que Facebook pudiera lograrlo: utilizando lo que se conoce como medición de autoridad según los gráficos (Graph Authority) para clasificar el contenido. Esto amplificaría las páginas de mayor calidad como noticias y medios y disminuiría las páginas de menor calidad como clickbait, revirtiendo la tendencia actual.

Haugen enfatizó que el fracaso de Facebook de arreglar su plataforma no fue por falta de soluciones, herramientas o capacidad. Destacó: "Facebook puede cambiar, pero claramente no lo hará por sí solo. Mi temor es que, sin medidas, los comportamientos divisivos y extremistas que vemos en la actualidad son solo el inicio. Lo que vimos en Myanmar y estamos viendo en Etiopía son solo los primeros capítulos de una historia tan aterradora de la que nadie quiere ver el final".

(Osborne explicó que Facebook tenía un enfoque fundamentalmente diferente para Myanmar hoy en día, con un mayor conocimiento de los problemas de derechos humanos del país y un equipo dedicado y tecnología para detectar el contenido peligroso, como el discurso de odio, en birmano).

En octubre, la enviada especial saliente de la ONU en Myanmar admitió que el país se había deteriorado hasta llegar a una guerra civil. Desde entonces, miles de personas han huido a países vecinos como Tailandia e India. A mediados de noviembre, los operadores de clickbait continuaban publicando noticias falsas cada hora. En una publicación, la líder democrática 'Madre Suu' había sido asesinada. En otra, por fin había sido liberada.