Encontró que el sistema oficial de medida del dolor no representaba correctamente a los pacientes negros. Para lograrlo, en lugar de entrenar a la inteligencia artificial para imitar a los radiólogos, analizó el problema desde un ángulo diferente, un enfoque que podría ayudar a reducir las desigualdades médicas

En los últimos años, distintas investigaciones han demostrado que el aprendizaje profundo puede igualar el desempeño de expertos humanos a la hora de interpretar imágenes médicas para la detección temprana del cáncer y el diagnóstico de enfermedades oculares. Pero también hay motivos para la cautela. Otra investigación ha señalado que el aprendizaje profundo tiende a perpetuar la discriminación. Si el sistema de atención médica ya está plagado de disparidades, las apps de aprendizaje profundo hechas sin cuidado podrían empeorar aún más la situación.

Un nuevo artículo publicado en Nature Medicine propone una forma de desarrollar algoritmos médicos capaz de ayudar a revertirla desigualdad existente, en lugar de exacerbarla. Según el profesor asociado de la Universidad de California en Berkeley (EE. UU.) que supervisó la investigación, Ziad Obermeyer, la clave es dejar de entrenar los algoritmos con el objetivo de que igualen el desempeño de los expertos humanos.

El artículo analiza un ejemplo clínico específico de las diferencias que existen en el tratamiento de la osteoartritis de rodilla, una enfermedad que causa dolor crónico. Evaluar el nivel de dolor ayuda a los médicos a prescribir el tratamiento adecuado, que puede incluir fisioterapia, medicamentos y cirugía. Esto lo suele llevar a cabo un radiólogo que revisa una radiografía de la rodilla y califica el dolor del paciente en la escala de Kellgren-Lawrence (KLG), que calcula los niveles de dolor en función de la presencia de diferentes características radiográficas, como el grado de la pérdida de cartílago o el daño estructural.

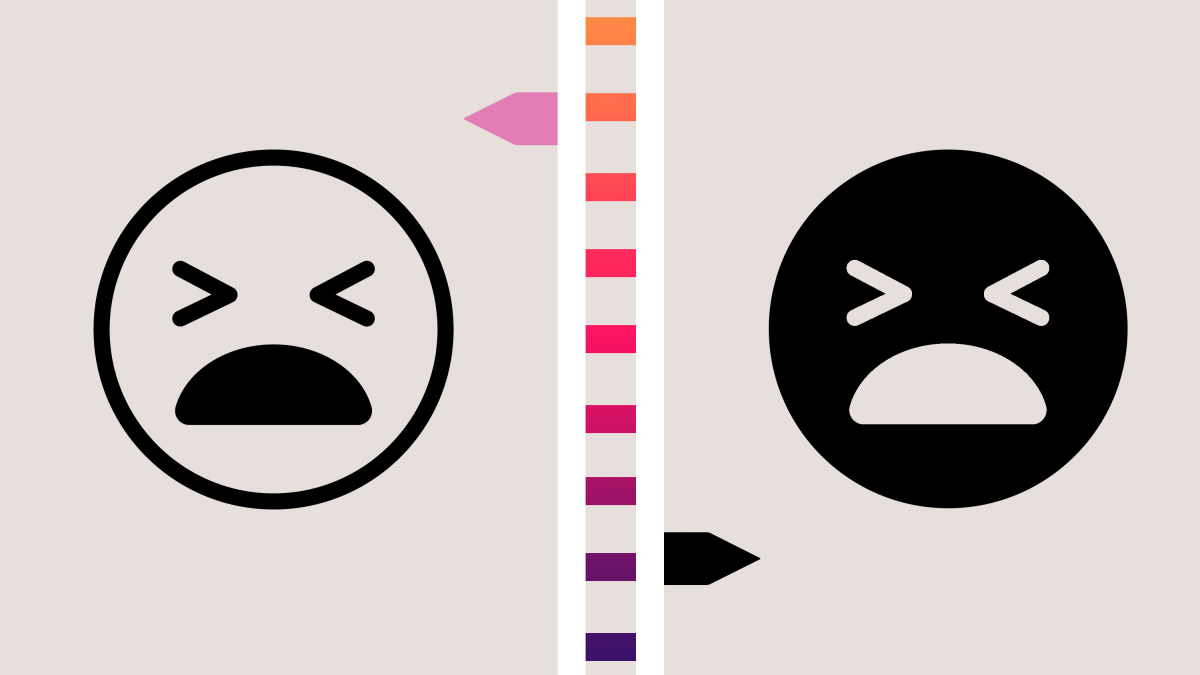

Pero los datos recopilados por el Instituto Nacional de Salud de EE. UU. han encontrado que los médicos que utilizan este método puntúan sistemáticamente el dolor de los pacientes negros en una medida mucho menos grave de lo que ellos mismos aseguran estar experimentando.

Los pacientes informan de sus niveles de dolor mediante un cuestionario en el que se les pregunta cuánto les duele al realizar distintas acciones, como enderezar completamente la rodilla. Pero los niveles de dolor manifestados por los propios pacientes tienen menos peso que la puntuación KLG que emite el radiólogo para prescribir el tratamiento. En otras palabras, los pacientes de raza negra que muestran la misma cantidad de pérdida de cartílago que los pacientes de raza blanca manifiestan niveles más altos de dolor.

Esto es algo que lleva tiempo incomodando a los expertos médicos. Una de sus hipótesis consistía en que los pacientes de raza negra podrían estar expresando niveles más altos de dolor para que los médicos los traten con mayor seriedad. Pero hay una explicación alternativa. La propia metodología KLG podría estar sesgada, ya que se desarrolló hace varias décadas con poblaciones británicas blancas.

Algunos expertos médicos argumentan que la lista de indicadores radiográficos que analizan los médicos podría no incluir todas las posibles fuentes físicas de dolor dentro de una población más diversa. Dicho de otra manera, podría haber indicadores radiográficos de dolor que aparecen con mayor frecuencia en personas de raza negra y que simplemente no forman parte de la categoría de KLG.

Para comprobar esta posibilidad, los investigadores entrenaron un modelo de aprendizaje profundo para predecir el nivel de dolor que expresan los pacientes a partir de su radiografía de rodilla. Si el modelo resultante tuviera una mala precisión, sugeriría que el dolor expresado por los pacientes es bastante arbitrario. Pero si el modelo mostrara una precisión realmente buena, proporcionaría una prueba de que el dolor expresado está correlacionado con los indicadores radiográficos de la radiografía.

Después de realizar varios experimentos, incluidos algunos diseñados para descartar cualquier factor de confusión, los investigadores encontraron que el modelo era mucho más preciso que el sistema KLG para predecir los niveles de dolor expresados por los pacientes blancos y negros, pero especialmente en el caso de los negros. Redujo a casi la mitad la disparidad racial en cada nivel de dolor.

El objetivo no es necesariamente comenzar a utilizar este algoritmo en un entorno clínico. Pero, al superar la metodología KLG, el estudio reveló que la forma estándar de medir el dolor es defectuosa y que los errores afectan mucho más a la población negra. Esto debería alertar a la comunidad médica para investigar qué indicadores radiográficos podría tomar en cuenta el algoritmo y actualizar su metodología de evaluación.

Obermeyer detalla: "En realidad, este trabajo pone de manifiesto una parte realmente fascinante de dónde podría encajar este tipo de algoritmos en el proceso de descubrimiento médico. Nos indica si hay algo que vale la pena analizar y que no entendemos. Establece la base para que los médicos humanos intervengan y, utilizando estos algoritmos como herramientas, intenten averiguar qué está pasando".

"Lo ingenioso de este artículo es que plantea las cosas desde una perspectiva completamente diferente", asegura la investigadora del MIT Irene Chen, que estudia cómo reducir las desigualdades en la atención médica en el aprendizaje automático y que no participó en el estudio. En vez de entrenar el algoritmo con un conocimiento bien establecido de los expertos, los investigadores optaron por tratar la autoevaluación de los pacientes como un indicador verdadero, señala Chen. De esa manera, se descubrieron importantes lagunas en lo que el campo médico suele considerar como la medida del dolor más "objetiva".

"Ese era el misterio", coincide Obermeyer. Si los algoritmos solo se entrenan para igualar el desempeño de los expertos humanos, simplemente perpetuarán las carencias e inequidades existentes. Y concluye: "Este estudio es una muestra de un proceso más general que podremos utilizar cada vez más en la medicina para generar nuevos conocimientos".