Inteligencia Artificial

DALL·E y CLIP dan un paso más hacia el futuro de la inteligencia artificial

OpenAI ha usado GPT-3 para crear dos nuevos modelos que combinan procesamiento del lenguaje natural con reconocimiento de imágenes. Gracias a esta mezcla, son capaces de identificar objetos que no han visto y de crear imágenes a partir de nuevas descripciones de texto

Con GPT-3 OpenAI demostró que era posible entrenar un modelo de aprendizaje profundo para usar el lenguaje de diversas formas con solo introducirle grandes cantidades de texto. Luego mostró que al intercambiar el texto por píxeles, el mismo enfoque se podría usar para entrenar una inteligencia artificial (IA) para completar imágenes a medio terminar. GPT-3 imita cómo los seres humanos usamos las palabras; el sistema GPT-3 para imágenes predice lo que vemos.

Bajo este enfoque, OpenAI ha creado dos nuevos modelos, DALL·E y CLIP, que combinan el lenguaje e imágenes para que la IA comprenda mejor las palabras y a qué se refieren las mismas. El científico jefe de OpenAI Ilya Sutskever afirma: "Vivimos en un mundo visual. En el futuro, habrá modelos que entiendan tanto el texto como las imágenes. La IA podrá comprender mejor el lenguaje porque verá el significado de las palabras y de las frases".

A pesar del estilo de GPT-3, sus resultados pueden parecer ajenos a la realidad, como si no supiera de qué habla. Eso es porque realmente no lo sabe. Al basar el texto en imágenes, los investigadores de OpenAI y de otras empresas tratan de dar a los modelos de lenguaje una mejor comprensión de los conceptos cotidianos que las personas utilizan para dar sentido a las cosas.

DALL·E y CLIP abordan este problema desde diferentes puntos. A primera vista, CLIP (acrónimo en inglés de entrenamiento previo de contrastante imagen y lenguaje) parece un sistema más de reconocimiento de imágenes. Su diferencia radica en que no ha aprendido a reconocer imágenes a partir de ejemplos etiquetados en los conjuntos de datos seleccionados, como la mayoría de los modelos existentes, sino a partir de las imágenes y sus descripciones publicadas en internet. CLIP aprende qué hay en una imagen en función de una descripción en vez de una etiqueta de una palabra como "gato" o "plátano".

CLIP fue entrenado con la orden de predecir cuál de las 32.768 descripciones de una selección aleatoria era la correcta para una imagen determinada. Para lograrlo, CLIP aprendió a vincular una amplia variedad de objetos con sus nombres y las palabras que los describen. Esto le permite identificar objetos en imágenes que no pertenecen a su conjunto de entrenamiento.

La mayoría de los sistemas de reconocimiento de imágenes se entrenan para identificar ciertos tipos de objetos, como rostros en los vídeos de vigilancia o edificios en las imágenes de satélite. Al igual que GPT-3, CLIP puede generalizar entre tareas sin necesidad de entrenamiento adicional. También es menos propenso que otros modelos de reconocimiento de imágenes de última generación a dejarse engañar por algunos ejemplos contradictorios, alterados sutilmente de distintas formas que suelen confundir los algoritmos, aunque las personas no noten la diferencia.

En vez de reconocer las imágenes, DALL·E (que supongo que es un juego de palabras WALL·E / Dalí) las dibuja. Este modelo es una versión más pequeña de GPT-3 que también ha sido entrenada con parejas de texto-imagen sacadas de internet. Con una breve descripción en lenguaje natural, como "un cuadro de un capibara en un campo al amanecer" o "una vista de sección transversal de una nuez", DALL·E genera muchas imágenes que coinciden con ella: docenas de capibaras de todas las formas y tamaños en los fondos naranjas y amarillos; varias filas de nueces (aunque no todas en sección transversal).

La parte surrealista

Los resultados son sorprendentes, aunque varían bastante. La descripción "una vidriera con la imagen de una fresa azul" genera muchos resultados correctos, pero también algunos que tienen ventanas azules y fresas rojas. Otros no contienen nada que se parezca a una ventana o una fresa. Los resultados mostrados por el equipo de OpenAI en una publicación de blog no han sido seleccionados a mano, sino clasificados por CLIP, que ha elegido las 32 imágenes DALL·E para cada pie de foto que cree que corresponde mejor a la descripción.

"La creación de una imagen desde el texto es un desafío de investigación que lleva tiempo existiendo. Pero este es un conjunto impresionante de ejemplos", asegura el experto en el procesamiento del lenguaje natural (PLN o PNL, por sus siglas en inglés) y creatividad computacional en el Instituto de Tecnología de Georgia en Atlanta (EE. UU.) Mark Riedl.

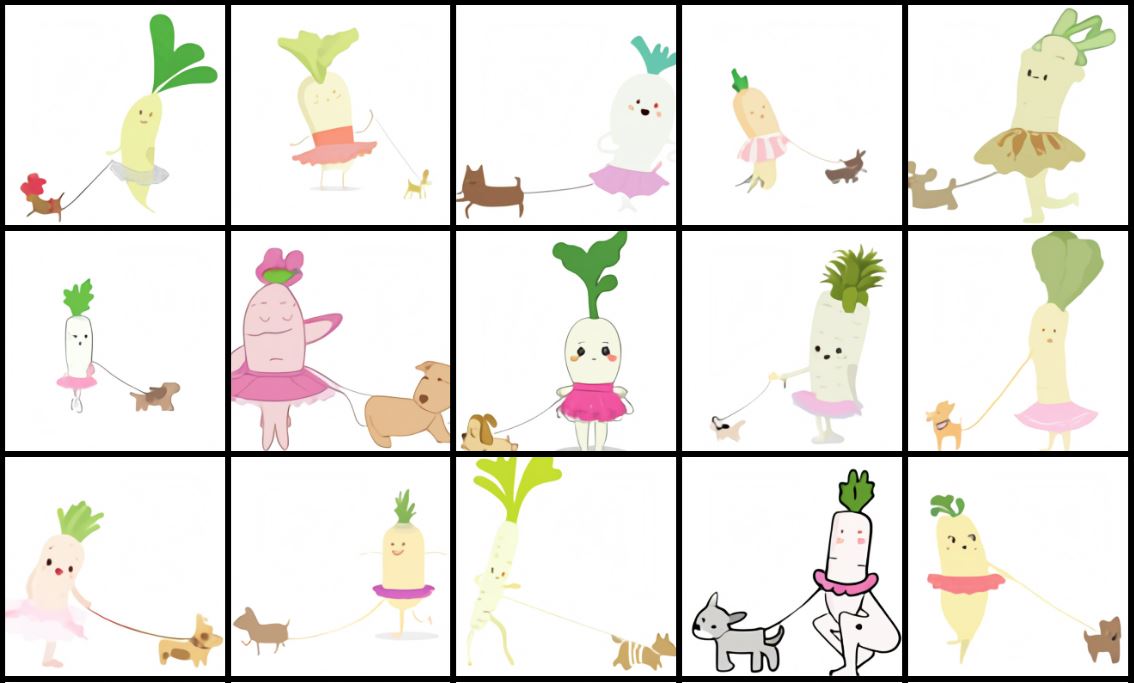

Foto: Imágenes dibujadas por DALL·E para el pie de foto "Un bebé rábano con un tutú paseando a un perro"

Para probar la capacidad de DALL·E para trabajar con conceptos nuevos, los investigadores le dieron pies de fotos que describían objetos que pensaban que no habría visto antes, como "un sillón de aguacate" y "una ilustración de un bebé rábano en tutú paseando a un perro." En ambos casos, la IA generó imágenes que combinaron los conceptos de manera plausible.

Los sillones en concreto parecen sillas y aguacates. La especialista en DALL·E Aditya Ramesh afirma: "Lo que más me sorprendió es que el modelo puede tomar dos conceptos no relacionados y unirlos de una manera funcional". Esto probablemente se deba a que un aguacate cortado a la mitad se parece un poco a un sillón de respaldo alto, con el hueso como cojín. Para otros pies de foto, como "un caracol de arpa", los resultados no son tan buenos, con imágenes que juntan caracoles y arpas de formas extrañas.

DALL·E es el tipo de sistema que Riedl imaginó para la prueba Lovelace 2.0, el experimento mental que se le ocurrió en 2014 cuyo objetivo era sustituir la prueba de Turing como punto de referencia para medir la inteligencia artificial. Asume que una señal de la inteligencia es la capacidad de combinar conceptos de manera creativa. Riedl sostiene que pedirle a un ordenador que dibuje a un hombre sosteniendo a un pingüino es una prueba de inteligencia que mejor pedirle a un chatbot que engañe a un humano en una conversación, porque es más abierto y menos fácil de engañar.

"La verdadera prueba es ver hasta dónde se puede empujar la IA fuera de su zona de confort", opina Riedl.

Foto: Imágenes dibujadas por DALL·E para el pie de foto "caracol hecho de arpa"

"La capacidad del modelo para generar imágenes sintéticas a partir de texto fantasioso parece muy interesante. Los resultados parecen obedecer a la semántica deseada, lo que creo que es bastante impresionante", admite el experto del Instituto Allen de Inteligencia Artificial (AI2), Ani Kembhavi, que también ha desarrollado un sistema que genera imágenes a partir de texto. El colega de Kembhavi, Jaemin Cho, también está impresionado: "Los generadores de imagen a partir de un texto existentes no han mostrado este nivel de control al dibujar múltiples objetos o las habilidades de razonamiento espacial de DALL·E".

Sin embargo, DALL·E ya muestra signos de tensión. Incluir demasiados objetos en un pie de foto reduce su capacidad de saber qué dibujar. Y reformular un pie de foto con palabras que significan lo mismo a veces crea diferentes resultados. También hay indicios de que DALL·E imita las imágenes que ha encontrado online en vez de generar imágenes nuevas.

Riedl señala: "Tengo dudas sobre el ejemplo del rábano, que sugiere estilísticamente que puede haber memorizado algo de internet", y señala que una búsqueda rápida muestra muchas imágenes de dibujos animados de rábanos antropomorfizados. "GPT-3, en el que se basa DALL·E, es conocido por su buena memoria", destacan.

Aun así, la mayoría de los investigadores de IA están de acuerdo en que basar el lenguaje en la comprensión visual es una buena manera de hacer que las IA sean más inteligentes. "El futuro va a consistir en los sistemas como este. Y ambos modelos son un paso más hacia eso", concluye Sutskever.