En lugar de enseñar a las máquinas todos los detalles de cada uno de nuestros movimientos, esta investigación propone darles únicamente los rasgos generales de nuestras acciones para que su capacidad de cómputo se concentre en tomar mejores decisiones y ejecutarlas correctamente

Pensemos un momento en todos los procesos subconscientes que realizamos mientras conducimos. A medida que recibimos información sobre los vehículos de nuestro alrededor, anticipamos cómo creemos que se moverán y decidimos sobre la marcha cómo responderíamos a esas maniobras. Incluso un conductor podría pensar en cómo influiría en los otros conductores en función de lo que ellos creen que él podría hacer.

Si los robots aspiran a introducirse en nuestro mundo de forma eficaz, tendrán que hacer lo mismo. Para lograrlo, investigadores de la Universidad de Stanford y Virginia Tech (ambas en EE. UU.) proponen una nueva técnica para ayudarles a realizar este tipo de modelado de comportamiento. La idea consiste en que el robot resuma solo los rasgos generales de los movimientos de otros agentes en lugar de capturarlos con detalles precisos. Esto les permite predecir de manera ágil sus próximas acciones y sus propias respuestas sin atascarse con grandes cálculos.

Una teoría de la mente diferente

Los métodos tradicionales para ayudar a los robots a trabajar con los humanos se inspiran en una idea de la psicología denominada teoría de la mente. Sugiere que las personas interfieren y sienten empatía entre ellas al desarrollar una comprensión de las posturas de los demás, una habilidad que desarrollamos de pequeños. Los investigadores que se basan en esta teoría se centran en lograr que los robots construyan un modelo de la intención subyacente de sus colaboradores como base para predecir sus acciones.

La profesora asistente en la Universidad de Stanford Dorsa Sadigh cree que este enfoque es muy ineficiente. Explica: "Si pensamos en las interacciones entre humanos, realmente nosotros no hacemos eso. Si queremos mover una mesa juntos, no hacemos modelos de intenciones". En cambio, sostiene que cuando dos personas mueven una mesa se fijan en unas simples señales como la fuerza que sienten que el otro está ejerciendo para empujar o tirar de la mesa. Y añade: "Así que creo que lo que realmente ocurre es que cuando los seres humanos realizan una tarea juntos, prestan atención a algo que tiene una dimensión mucho menor".

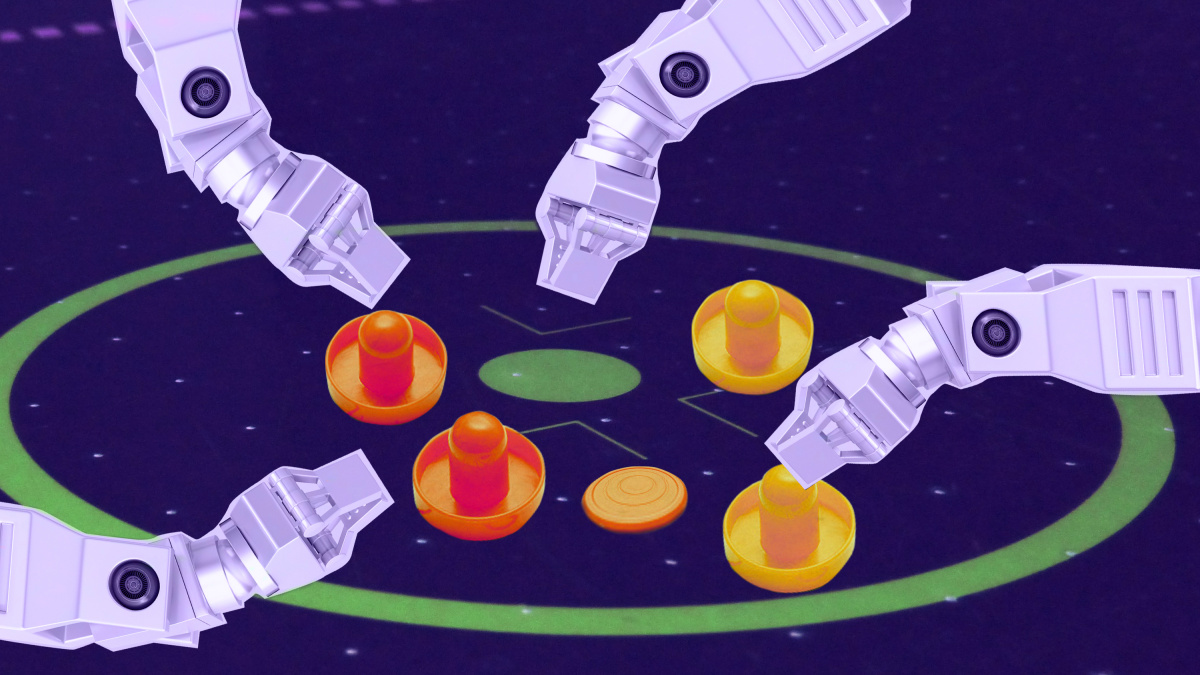

Bajo su nuevo enfoque, un robot podría registrar descripciones muy simples de las acciones de sus agentes circundantes. En un juego de air hockey (o hockey de aire), por ejemplo, podría identificar los movimientos de sus oponentes con una sola palabra: "derecha", "izquierda" o "centro". Luego, podría usar estos datos para entrenar dos algoritmos separados: uno de aprendizaje automático que prediga hacia dónde se moverá el oponente a continuación y otro de aprendizaje reforzado para determinar cómo debe responder. El segundo algoritmo también realizaría un seguimiento de cómo el oponente cambia de dirección en función de su propia respuesta, para que pueda aprender a influir en las acciones del oponente.

La idea clave es el escaso peso de los datos de entrenamiento, que es lo que permite al robot realizar todo este entrenamiento paralelo sobre la marcha. Un enfoque más tradicional acumularía las coordenadas de toda la trayectoria de los movimientos del oponente, no solo su dirección. Aunque lo de menos es más puede parecer contradictorio, vale la pena recordar la teoría de Sadigh sobre la interacción humana. Nosotros también influimos en las personas que nos rodean a grandes rasgos.

Los investigadores probaron esta idea en simulación con un coche autónomo y en el mundo real con un juego robótico de air hockey. En cada una de las pruebas, la nueva técnica superó a los métodos anteriores a la hora enseñar a los robots a adaptarse a los agentes circundantes. También aprendieron a influir en los que los rodeaban de forma eficaz.

Retos por delante

Todavía hay algunos detalles que las futuras investigaciones deberán resolver. El trabajo actual, por ejemplo, supone que cada interacción en la que participa un robot es finita, explica el profesor asistente de la Universidad de Toronto (Canadá) Jakob Foerster, que no participó en el trabajo.

En la simulación de conducción autónoma, los investigadores asumieron que el coche robótico experimentaba solo una interacción claramente vinculada con otro coche durante cada ronda de entrenamiento. Pero, conducir no funciona de esa manera, por supuesto. Las interacciones suelen ser continuas y requerirían un coche autónomo que aprenda y adapte su comportamiento con cada interacción, no solo con una de ellas.

Otro desafío, según Sadigh, consiste en que este método da por sentado que el conocimiento es la mejor manera de describir el comportamiento de un colaborador. Los propios investigadores tuvieron que determinar las etiquetas "derecha", "izquierda" y "centro" en el juego de hockey de aire para describir al robot las acciones de su oponente. Esas etiquetas no siempre serán tan obvias en algunas interacciones más complicadas.

No obstante, Foerster ve promesas en la contribución del trabajo, y concluye: "Cerrar la brecha entre el aprendizaje de múltiples agentes y la interacción humanos-IA es una vía muy importante para la futura investigación. Estoy muy ilusionado por ver cuándo estas cosas se pondrán en marcha".