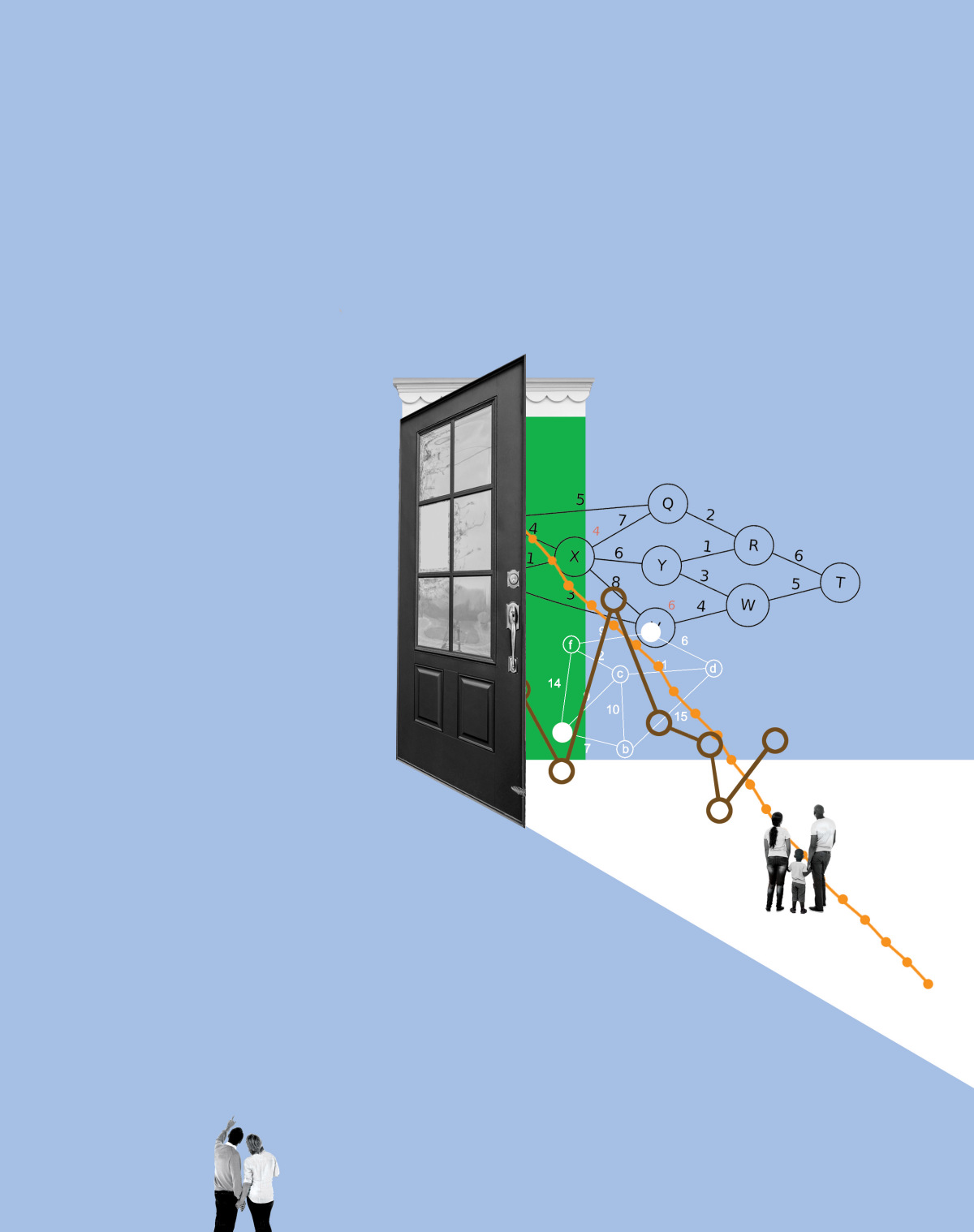

La inteligencia artificial aplicada al mercado de la vivienda ha replicado los históricos sesgos racistas, dificultando aún más el acceso a personas negras. Tres expertos debaten sobre el fenómeno y plantean ideas para intentar que la propia tecnología sea parte de la solución

Uno de los problemas más antiguos y difíciles de abordar en EE. UU. es su desigualdad racial. Esta injusticia está particularmente arraigada en forma de discriminación en el acceso a la vivienda.

Un largo historial de políticas de bancos, compañías de seguros e inmobiliarias ha negado a las personas de color una oportunidad justa de convertirse en propietarios de una vivienda, ha concentrado la riqueza y la propiedad en manos de personas blancas y sus comunidades y ha perpetuado la segregación de facto. A pesar de que estas políticas (con nombres como redlining, blockbusting, zonificación racial, convenios restrictivos y dirección racial) ya no son legales, sus consecuencias persisten y, a veces, todavía se siguen practicando de manera encubierta o involuntaria.

En algunos casos, la tecnología ha intensificado el sesgo racial de Estados Unidos. Por ejemplo, está demostrado que el reconocimiento facial basado en algoritmos, la vigilancia policial predictiva y las decisiones de sentencia y fianza, generan peores resultados para las personas negras. Y este problema también se da en las cuestiones de vivienda.

Una reciente investigación de la Universidad de California (UC) en Berkeley (EE. UU.) demuestra que un sistema de préstamos hipotecarios basado en la inteligencia artificial (IA) cobraba tasas más altas a los prestatarios negros e hispanos que a las personas blancas por los mismos préstamos.

¿Puede la tecnología ayudar a mitigar el sesgo en el acceso a la vivienda? Reunimos a tres expertos para discutir las posibilidades. Estos expertos son:

-

Lisa Rice. Presidenta y CEO de National Fair Housing Alliance, el consorcio más grande de organizaciones dedicadas a acabar con la discriminación en materia de vivienda.

-

Bobby Bartlett. Profesor de Derecho de la UC Berkeley que dirigió la investigación y proporcionó algunas de las primeras pruebas a gran escala de cómo la inteligencia artificial crea la discriminación en los préstamos hipotecarios.

-

Charlton McIlwain. Profesor de Medios, Cultura y Comunicación de la Universidad de Nueva York (NYU, EE. UU.) y autor del libro Black Software: The Internet & Racial Justice, from the Afronet to Black Lives Matter.

McIlwain: Cuando presté mi declaración ante el Congreso de EE. UU. en diciembre pasado sobre el impacto de la automatización y la inteligencia artificial en la industria de servicios financieros, cité un reciente estudio que encontró que, a diferencia de los responsables de préstamos humanos, los sistemas automatizados de préstamos hipotecarios aprobaban de manera justa los préstamos hipotecarios, sin discriminar por motivos de raza. Sin embargo, los sistemas automatizados todavía cobran precios significativamente más altos a los prestatarios negros e hispanos por esos préstamos.

Esto me hace dudar de que la IA pueda hacerlo mejor que los humanos. Bobby, este era su estudio. ¿Había sacado las mismas conclusiones?

Bartlett: Tuvimos acceso a un conjunto de datos que nos permitió identificar al prestamista registrado y si con ese prestamista se utilizó un sistema totalmente automatizado, sin ninguna intervención humana, al menos en términos de aprobación y contratación. Teníamos información sobre la raza y el origen étnico del prestatario registrado y pudimos verificar si los precios de los préstamos aprobados diferían según la raza. Resultó que sí, con una diferencia de aproximadamente 676 millones de euros al año.

¿Por qué estos algoritmos, que ignoran la raza o el origen étnico del prestatario, discriminan de esta manera? Nuestra hipótesis de trabajo es que los algoritmos a menudo simplemente intentan maximizar el precio. Supuestamente, el diseñador del algoritmo desconoce la consecuencia racial de este enfoque hacia la rentabilidad. Pero debe entender que existe esta dinámica racial, que, con toda probabilidad, la discriminación está en las variables e indicadores que usa. En cierto sentido, hay una línea roja que pasa por el código. Se parece a lo que ocurre en el mercado hipotecario en general. Sabemos que los agentes ofrecerán precios más altos a los prestatarios de grupos minoritarios, sabiendo que algunos acabarán rechazándolo, pero es más probable que otros lo acepten por una gran cantidad de razones.

McIlwain: Tengo la teoría de que una de las razones por las que tenemos sistemas sesgados, incluso cuando fueron creados para ser menos discriminatorios, es porque las personas que los diseñan no comprenden realmente la complejidad subyacente del problema. Me parece que hay una cierta ingenuidad al pensar que un sistema estaría libre de sesgo solo porque es "indiferente a la raza".

Rice: Bueno, Charlton, teníamos la misma opinión en la década de 1990 y principios de 2000. Prohibimos a las instituciones financieras el uso de sistemas de calificación de seguros, precios basados en riesgos o de calificación crediticia, solo con este propósito. Nos dimos cuenta de que los propios sistemas manifestaban los sesgos. Pero luego comenzamos a decir que solo se pueden usar si ayudan a las personas, amplían el acceso o generan precios más justos.

McIlwain: ¿Se equivocan las personas que diseñan estos sistemas porque realmente no comprenden el problema subyacente de la discriminación en el acceso a la vivienda? ¿Su optimismo proviene del hecho de que usted y las organizaciones como la suya comprenden esa complejidad?

Rice: Somos una organización de derechos civiles. Eso es lo que somos. Hacemos todo nuestro trabajo a través de una lente de equidad racial. Somos una organización antirracista.

Para resolver los casos de redlining, alentamos a las instituciones financieras y agencias de seguros a reconsiderar sus modelos de negocio, a repensar sus estrategias de venta, sus pautas de contratación y los productos que desarrollaban. Y creo que la razón por la que pudimos llevarlo a cabo es porque somos una agencia de derechos civiles.

Comenzamos ayudando a las corporaciones a comprender la historia de la vivienda y las finanzas en Estados Unidos y cómo todas nuestras políticas en este ámbito se han aplicado a través de una lente racial. No se puede comenzar de cero en términos de desarrollo de un sistema y pensar que el sistema será justo. Hay que desarrollarlo de una manera que utilice tecnologías y metodologías antirracistas.

McIlwain: ¿Podemos todavía hacer mella en este problema de manera realista utilizando las herramientas tecnológicas disponibles? Si es así, ¿por dónde empezamos?

Rice: Sí, cuando terminó la crisis financiera de 2008 y pudimos levantar la cabeza, fue como si la tecnología nos hubiera superado. Y entonces decidimos que si no podíamos vencerlo, tal vez mejor unirnos. Pasamos mucho tiempo tratando de aprender cómo funcionan los sistemas basados en algoritmos, cómo funciona la IA y, de hecho, hemos llegado al punto en el que creemos que ya podemos usar la tecnología para disminuir los resultados discriminatorios.

Si logramos entender cómo estos sistemas manifiestan el sesgo, podemos llegar a las profundidades y eliminar el sesgo de esos sistemas, y construir nuevos sistemas con las técnicas de la eliminación de sesgo incorporadas dentro de ellos.

Realmente no tenemos agencias reguladoras que sepan cómo realizar un examen a una institución crediticia para averiguar si su sistema está sesgado o no.

Pero, cuando miramos lo lejos que estamos de la curva, resulta realmente abrumador pensar en todo el trabajo que hay que hacer, en toda la investigación que se tiene que realizar. Necesitamos a más personas como Bobby en el mundo. Pero también toda la educación posible para que los científicos de datos comprendan estos problemas.

Rice: Estamos intentando que los reguladores comprendan cómo los sistemas manifiestan el sesgo. Pero, realmente no tenemos un órgano de examinadores en las agencias reguladoras que sepa realizar un examen a una institución crediticia para averiguar si su sistema (su sistema de contratación automatizada, su sistema de marketing, su sistema de servicio) está sesgado. Las propias instituciones desarrollan sus propias políticas organizativas que podrían ayudar en eso.

Otra cosa que tenemos que hacer es aumentar la diversidad en el ámbito tecnológico. Tenemos que conseguir más estudiantes de diversos orígenes en los campos STEM y en el espacio tecnológico para ayudar a fomentar el cambio. Puedo pensar en una serie de ejemplos en los que el solo hecho de tener a una persona de color en el equipo marcó una gran diferencia en términos de aumentar la equidad de la tecnología que se estaba desarrollando.

McIlwain: ¿Qué papel tiene la política? Tengo la sensación de que, de la misma manera que las organizaciones de derechos civiles estaban detrás de la industria ayudando a comprender cómo funcionan los sistemas algorítmicos, muchos de nuestros legisladores están detrás de la curva. No sé cuánta fe depositaría en su capacidad para servir de manera realista como control efectivo del sistema, o de los nuevos sistemas de inteligencia artificial que se abren camino rápidamente en el campo de las hipotecas.

McIlwain: Sigo siendo escéptico. Por ahora, para mí, la magnitud del problema aún supera con creces tanto nuestra voluntad humana colectiva como las capacidades de nuestra tecnología. Bobby, ¿cree que la tecnología podría solucionar este problema?

Bartlett: Tengo que responder como un abogado: "Depende". Lo que estamos notando, por lo menos en el contexto de los préstamos, es que resulta posible eliminar la fuente de sesgo y la discriminación detectada con interacciones cara a cara a través de algún tipo de toma de decisiones algorítmica. La otra cara de la moneda es que, si se implementa de manera incorrecta, podría terminar con un aparato de toma de decisiones tan malo como un régimen de redlining. Así que, depende de la ejecución, del tipo de tecnología y del cuidado con el que se implemente. Pero, ¿un régimen de préstamos justo que se pone en práctica mediante la toma de decisiones automatizada? Creo que es una propuesta realmente desafiante. Y que aún no se sabe.