Un modelo de inteligencia artificial ha aprendido a generar nuevas imágenes a partir de pies de foto, una tarea compleja, ya que requiere tener un conocimiento visual implícito sobre los objetos. Aunque todavía no son realistas, el avance demuestra que los algoritmos han mejorado su comprensión conceptual del mundo

De todos los modelos de inteligencia artificial (IA) del mundo, el GPT-3 desarrollado por OpenAI es el que más ha captado la atención del público. Puede crear poemas, relatos y canciones con poca ayuda, y se ha demostrado que engaña a los lectores haciéndoles creer que sus resultados fueron escritos por un ser humano. Pero su elocuencia es más bien un truco y no debe confundirse con la inteligencia real.

No obstante, los investigadores creen que las técnicas usadas para crear GPT-3 podrían contener el secreto de una IA más avanzada. GPT-3 fue entrenada con una enorme cantidad de datos de texto. ¿Qué pasaría si los mismos modelos fueran entrenados tanto con texto como con imágenes?

La nueva investigación del Instituto Allen de Inteligencia Artificial (AI2) ha llevado esta idea al siguiente nivel. Los investigadores han desarrollado un nuevo modelo de texto e imagen, también conocido como modelo de lenguaje visual, que puede generar imágenes basadas en los pies de foto. Las imágenes parecen inquietantes y extrañas, nada que ver con los deepfakes hiperrealistas generados por las redes generativas antagónicas (GAN), pero podrían demostrar una nueva dirección prometedora para lograr una inteligencia más generalizable y quizás incluso robots más inteligentes.

Algoritmo: complete el espacio en blanco

GPT-3 forma parte de un grupo de modelos conocidos como "transformadores", que se hizo popular por primera vez con el éxito de BERT de Google. Antes del desarrollo de BERT, los modelos de lenguaje eran bastante deficientes. Tenían suficiente capacidad predictiva para resultar útiles en aplicaciones como autocompletar, pero no lo bastante como para generar una frase larga que siguiera las normas gramaticales y tuviera sentido común.

BERT logró eso al introducir una nueva técnica llamada enmascaramiento, que consiste en ocultar diferentes palabras en una frase y pedir al modelo que complete el espacio en blanco. Por ejemplo:

-

La mujer fue al ___ para hacer ejercicio.

-

Compraron una ___ de pan para hacer sándwiches.

La idea es que, si el modelo se ve obligado a hacer estos ejercicios, a menudo millones de veces, comienza a descubrir patrones sobre cómo se unen las palabras para formar frases y sobre cómo las frases forman párrafos. Debido a ello, puede generar e interpretar mejor el texto, acercándose a la comprensión del significado del lenguaje. De hecho, Google ahora usa BERT para ofrecer resultados de búsqueda más relevantes en su motor de búsqueda. Después de que el enmascaramiento se demostrara altamente efectivo, los investigadores buscaron aplicarlo a los modelos de lenguaje visual ocultando las palabras en los pies de fotos, de la siguiente manera:

Foto: Una ____ se encuentra en un camino de tierra cerca de un árbol. Créditos: AI2

Esta vez, el modelo podría analizar tanto las palabras circundantes como el contenido de la imagen para completar el espacio en blanco. Con millones de repeticiones, pudo descubrir no solo los patrones entre palabras, sino también las relaciones entre las palabras y los elementos de cada imagen.

El resultado son modelos que pueden relacionar las descripciones de texto con las referencias visuales, de la misma forma que los bebés son capaces de establecer conexiones entre las palabras que aprenden y las cosas que ven. Por ejemplo, los modelos pueden observar la siguiente foto, y escribir un pie de foto adecuado como: "Mujeres jugando al hockey sobre hierba". O pueden responder a preguntas sobre ella como "¿De qué color es la pelota?" conectando la palabra "pelota" con el objeto circular en la imagen.

Foto: Un modelo de lenguaje visual podría escribir una descripción lógica como pie de esta foto: "Mujeres jugando hockey sobre hierba". Créditos: John Torcasio / UNSPLASH

Una imagen vale más que mil palabras

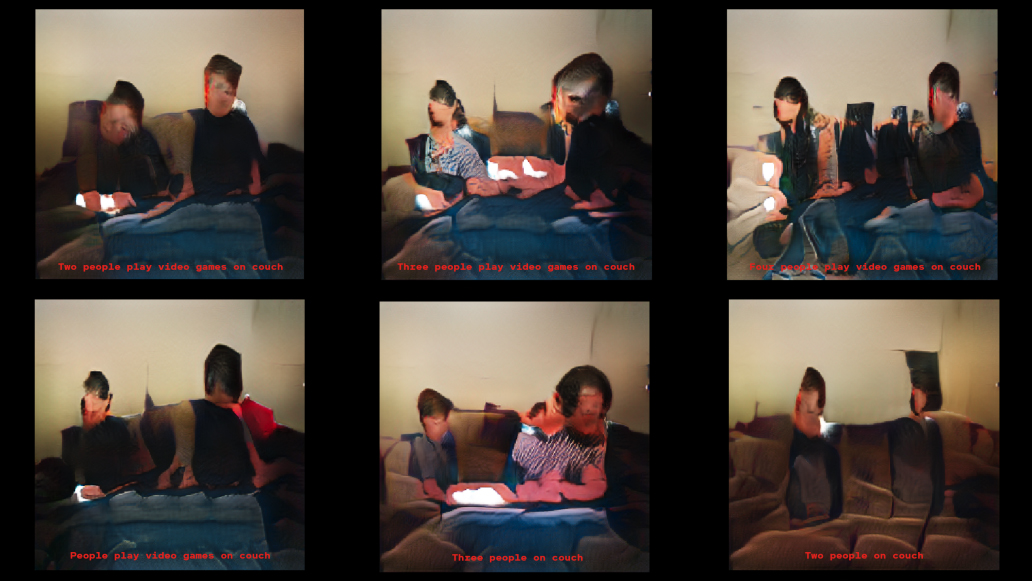

Los investigadores de AI2 han querido saber si estos modelos desarrollaron realmente una comprensión conceptual del universo visual. Un niño que ha aprendido la palabra que denomina a un objeto no solo es capaz de recordar la palabra para identificar el objeto, sino también de dibujar el objeto cuando se le menciona esa palabra, incluso si el objeto en sí no está presente. Por eso, los investigadores pidieron a los modelos de IA que hicieran lo mismo: generar imágenes a partir de los pies de fotos. Sin embargo, todos ellos han creado patrones de píxeles sin sentido.

Foto: ¡Es un pájaro! ¡Es un avión! No, es solo una imagen incomprensible generada por IA. Créditos: AI2

Esto tiene lógica: transformar el texto en imágenes es mucho más difícil que al revés. Un pie de foto no especifica todo lo que contiene una imagen, explica la directora del equipo de visión artificial de AI2, Ani Kembhavi. Por lo tanto, un modelo debe recurrir al sentido común sobre el mundo para completar los detalles.

Si se le pide que dibuje "una jirafa caminando por una carretera", por ejemplo, debe deducir que es más probable que la carretera sea gris que rosa fuerte y que esté al lado de un campo de hierba y no al lado del océano, aunque ninguno de estos datos estén especificados explícitamente.

Así que Kembhavi y sus colegas Jaemin Cho, Jiasen Lu y Hannaneh Hajishirzi decidieron probar si podían enseñar a un modelo todo este conocimiento visual implícito modificando el enfoque del enmascaramiento. En vez de entrenar al modelo solo para predecir las palabras ocultas en los pies de las fotos correspondientes, también lo entrenaron para predecir los píxeles enmascarados en las imágenes tomando como base sus correspondientes pies de foto.

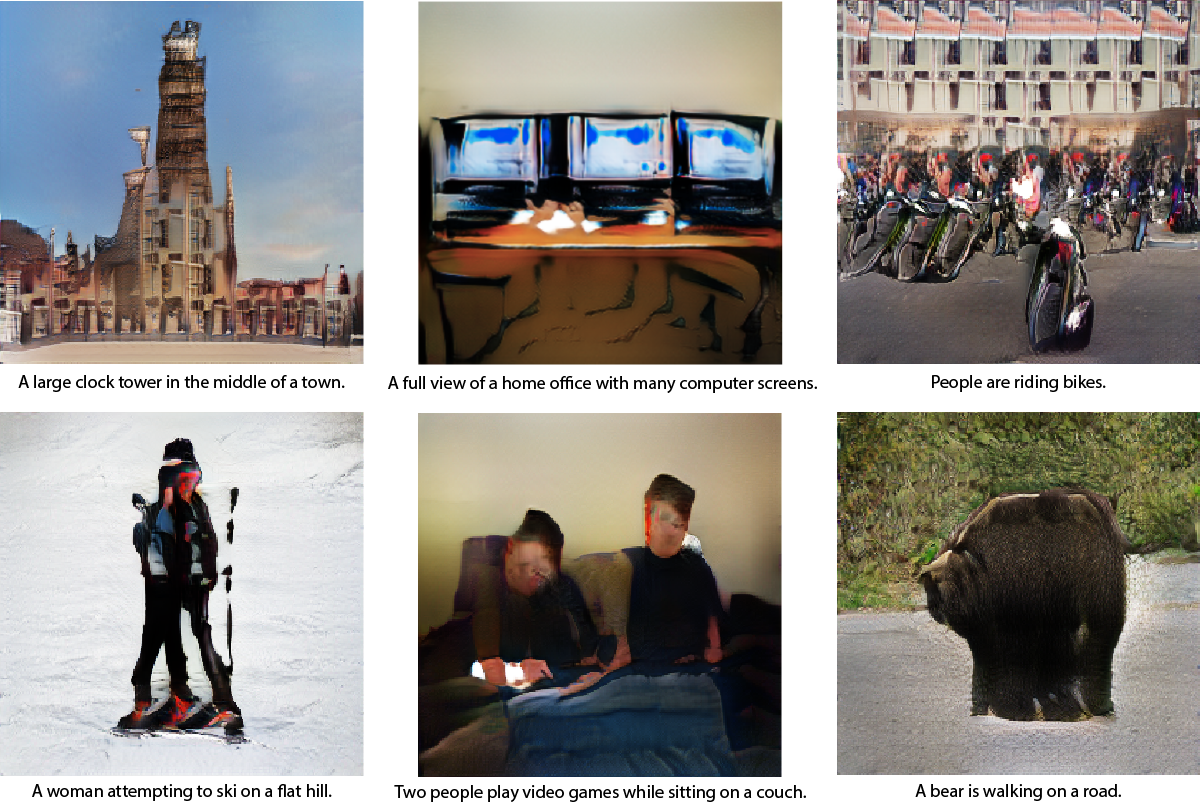

Las imágenes finales generadas por el modelo no son exactamente realistas. Pero eso no es lo importante. Contienen los conceptos visuales correctos: el equivalente en IA de un niño que dibuja una figura trazando unas líneas para representar a una persona. (Puede probar el modelo aquí).

Foto: Ejemplos de imágenes generadas por el modelo de AI2 a partir de pies de fotos. Comenzando por arriba y de izqda. a dcha. 1. Una gran torre del reloj en medio de un pueblo. 2. Una visión completa de una oficina en casa. 3. Personas montando en bicicleta. 4. Una mujer intentando esquiar en una zona llana. 5. Dos personas juegan a videojuegos sentadas en un sofá. 6. Un oso camina en una carretera. Créditos: AI2.

La capacidad de los modelos de lenguaje visual para realizar este tipo de generación de imágenes representa un importante paso adelante en la investigación de la IA. No en vano, sugiere que el modelo es realmente capaz de lograr un cierto nivel de abstracción, una habilidad fundamental para comprender el mundo.

A largo plazo, esto podría influir en la robótica. Cuanto mejor comprenda un robot su entorno visual y utilice el lenguaje para comunicarse con él, más complejas serán las tareas que podrá llevar a cabo. A corto plazo, este tipo de visualización también podría ayudar a que los investigadores comprendan mejor qué están aprendiendo exactamente los modelos de IA de "caja negra", asegura Hajishirzi.

En el futuro, el equipo planea experimentar más para mejorar la calidad de la generación de imágenes y expandir el vocabulario visual y lingüístico del modelo para incluir nuevos temas, objetos y descripciones.

"La generación de imágenes ha sido realmente una pieza que faltaba en este rompecabezas", concluye Lu. "Consiguiendo esto, podemos hacer que el modelo aprenda mejores representaciones para representar el mundo".