OpenAI ha modificado su algoritmo GPT-2, especializado en texto, para que genere imágenes a partir de ejemplos. Sus creaciones no solo resultan convincentes sino que abren la puerta a un nuevo enfoque que facilita aún más la creación de 'deepfakes'

En febrero del año pasado, el laboratorio de investigación OpenAI anunció que su sistema de inteligencia artificial (IA) GPT-2 podía escribir pasajes de texto convincentes en inglés. Si se introduce el inicio de una frase o de un párrafo en el sistema, este es capaz de continuar la idea principal hasta escribir un ensayo con una coherencia casi humana. Tras este hito, hace un par de semanas, la entidad anunció la siguiente versión del programa, GPT-3, cuyas capacidades para generar texto en lenguaje natural exceden a las de su predecesor.

Pero, además, está explorando qué sucedería si el mismo algoritmo se alimentara con una parte de una imagen. Los resultados, que recibieron una mención de honor al mejor trabajo en la reciente Conferencia Internacional sobre Aprendizaje Automático, abren una nueva vía para crear imágenes, llena de oportunidades y consecuencias.

En esencia, GPT-2 es un poderoso motor de predicción que ha aprendido a comprender la estructura del inglés observando miles de millones de ejemplos de palabras, frases y párrafos, extraídos de muchos rincones de internet. Con esa estructura, puede combinar palabras para crear nuevas frases y predecir estadísticamente el orden en el que deberían aparecer.

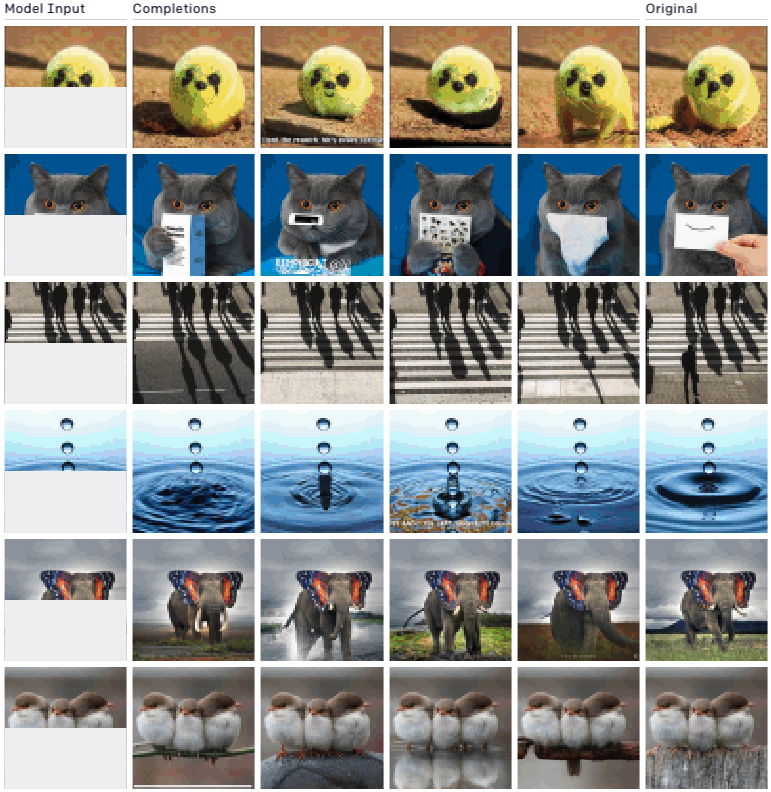

Ahora, los investigadores de OpenAI han decidido sustituir las palabras por píxeles y entrenar el mismo algoritmo con las imágenes de ImageNet, el banco de imágenes más popular para el aprendizaje profundo. Como el algoritmo fue diseñado para trabajar con datos unidimensionales (es decir, líneas de texto), desplegaron las imágenes en una sola secuencia de píxeles. Descubrieron que el nuevo modelo, denominado iGPT, era capaz de comprender las estructuras bidimensionales del mundo visual. Con la secuencia de píxeles para la primera mitad de una imagen, la IA podría predecir la segunda mitad de una manera que un ser humano consideraría razonable.

A continuación, puede ver algunos ejemplos. La columna del extremo izquierdo es la imagen introducida, la columna del extremo derecho es la imagen original y las columnas del medio son los acabados previstos por iGPT. (Ver más ejemplos aquí.)

Los resultados son asombrosamente impresionantes y demuestran un nuevo camino para utilizar el aprendizaje no supervisado, que se entrena en datos no etiquetados, en el desarrollo de sistemas de visión artificial. Aunque los primeros sistemas de visión artificial a mediados de la década de 2000 ya habían probado antes tales técnicas, perdieron su relevancia frente al aprendizaje supervisado, que utiliza datos etiquetados, pues este demostró ser mucho más exitoso. Sin embargo, el beneficio del aprendizaje no supervisado es que permite que un sistema de IA aprenda cosas sobre el mundo sin un filtro humano y reduce significativamente el trabajo manual de etiquetado de datos.

El hecho de que iGPT use el mismo algoritmo que GPT-2 también es un reflejo de su prometedora adaptabilidad. Esto va en línea con la principal ambición de OpenAI: conseguir una IA más generalizable.

Al mismo tiempo, este método presenta una nueva y preocupante forma de crear imágenes ultrafalsificadas, o deepfake. Las redes generativas antagónicas, o GAN (por sus siglas en inglés) la categoría más común de algoritmos utilizados para crear deepfakes, deben entrenarse en datos muy bien seleccionados. Si queremos que una GAN genere una cara, por ejemplo, sus datos de entrenamiento solo deben incluir rostros. iGPT, en cambio, simplemente aprende lo suficiente de la estructura del mundo visual mediante millones y miles de millones de ejemplos para crear imágenes que podrían existir dentro de él. Aunque entrenar un modelo sigue siendo computacionalmente costoso, siendo eso una barrera natural para su acceso, puede que no sea así por mucho tiempo.

OpenAI no respondió a una solicitud de entrevista, pero en una reunión interna del equipo de Políticas a la que asistió MIT Technology Review el año pasado, su director, Jack Clark, reflexionó sobre los futuros riesgos de la generación como la que hace GPT, incluido lo que sucedería si se aplicara a las imágenes. El responsable afirmó: "Lo próximo será el vídeo. Probablemente en cinco años, habrá una generación condicional de vídeo en un horizonte de cinco a 10 segundos". Luego procedió a describir cómo lo imaginaba él: se introducirá una foto de un político y una explosión junto a él, y se generaría un probable resultado de que ese político fuera asesinado.