La inteligencia artificial y la neurociencia llevan años impulsándose mutuamente. Ahora, un enfoque de aprendizaje reforzado de 2017 ha sido comparado con el comportamiento de las neuronas y resulta que funcionan igual, un hallazgo que podría revolucionar nuestra comprensión sobre la salud mental

En 1951, el por aquel entonces estudiante de la Universidad de Harvard (EE. UU.) Marvin Minsky usó algunas observaciones del comportamiento animal para intentar diseñar una máquina inteligente. A partir del trabajo del fisiólogo Ivan Pavlov, muy conocido por usar perros para mostrar cómo los animales aprenden por refuerzo positivo (recompensa) y negativo (castigo), Minsky creó un ordenador que aprendía continuamente a resolver un laberinto virtual a través de un refuerzo similar.

En aquella época, los neurocientíficos aún no habían descubierto los mecanismos cerebrales que permiten a los animales aprender de esta manera. Pero Minsky fue capaz de imitar dicho comportamiento, anticipando así la inteligencia artificial (IA). Varias décadas después, a medida que el aprendizaje reforzado siguió madurando, ayudó al campo de la neurociencia a descubrir esos mecanismos, lo que dio lugar a un círculo virtuoso de avances entre los dos campos.

En un artículo publicado recientemente en Nature, la filial de IA de Alphabet, DeepMind, ha utilizado de nuevo algunas lecciones del aprendizaje reforzado para proponer una nueva teoría sobre los mecanismos de recompensa dentro de nuestros cerebros. La hipótesis, respaldada por sus resultados experimentales iniciales, podría mejorar nuestra comprensión de la salud mental y de la motivación. Pero también podría validar la dirección actual de la investigación en IA hacia la creación de una inteligencia general parecida a la humana.

El aprendizaje reforzado se inspira en los conocimientos generados por los perros de Pavlov, y los lleva a un nivel: es posible enseñar a un sujeto a dominar tareas complejas y nuevas a través de reacciones positivas y negativas. Cuando un algoritmo empieza a aprender una tarea determinada, predice una acción aleatoria para intentar llevarse una recompensa, la lleva a cabo, analiza la recompensa que recibe y ajusta su siguiente predicción en función del margen de error. Tras millones o incluso miles de millones de pruebas, los errores de predicción del algoritmo se reducen hasta desaparecer, y ese es el momento en el que el algoritmo sabe con precisión qué acciones debe realizar para maximizar su recompensa y completar su tarea.

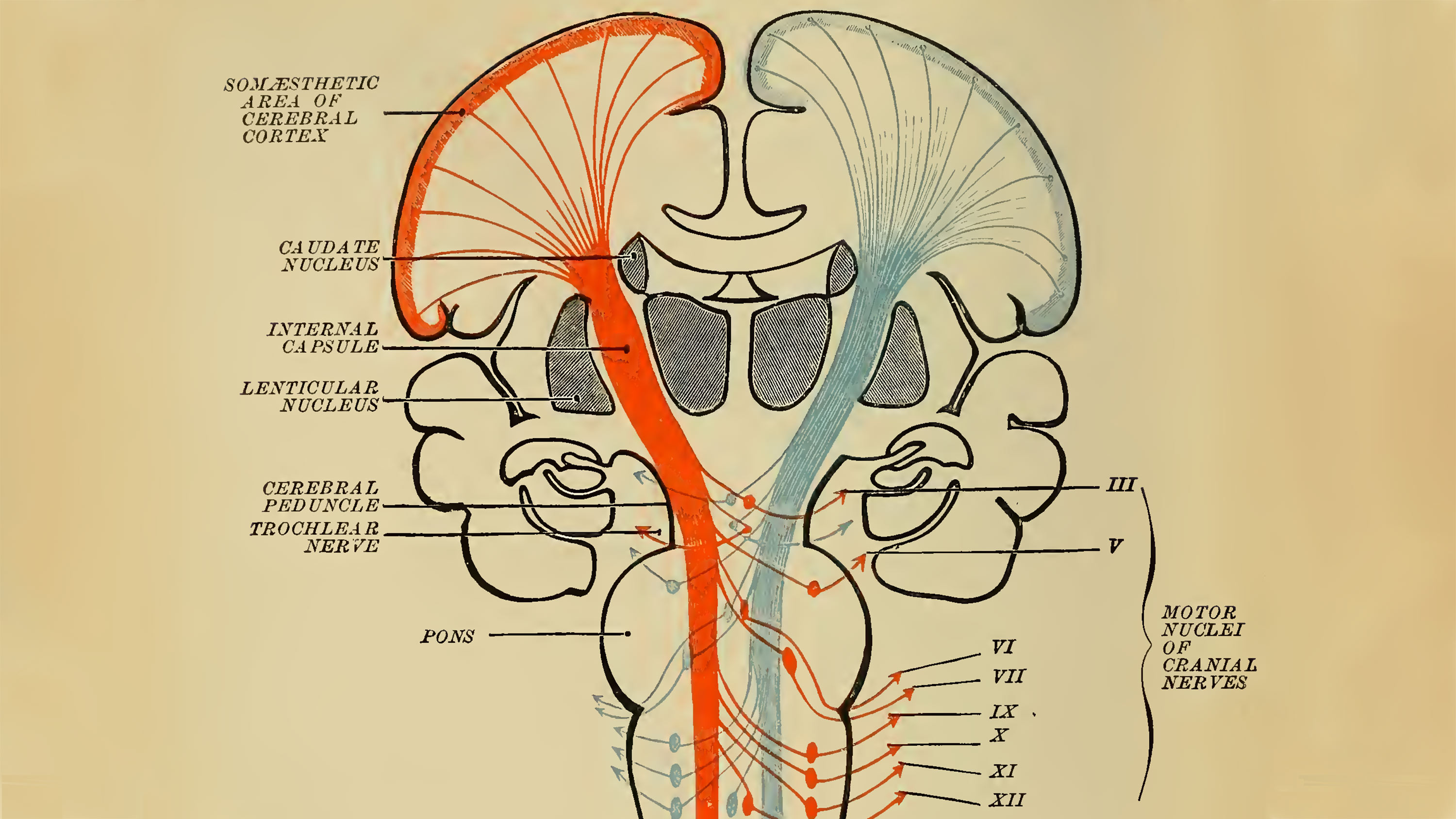

Resulta que el sistema de recompensa del cerebro funciona de la misma manera, según un descubrimiento realizado en la década de 1990, inspirado en los algoritmos de aprendizaje reforzado. Cuando un humano o un animal quiere realizar una acción, sus neuronas de dopamina hacen una predicción sobre la recompensa esperada. Al recibir la recompensa real, se activa una cantidad de dopamina que depende del error de la predicción. Si la recompensa resulta mejor de la esperada, el cerebro produce una fuerte liberación de dopamina, mientras que si es peor de lo esperado, se suprime la reacción química. En otras palabras, la dopamina actúa como señal de corrección que informa a las neuronas para que ajusten sus predicciones hasta que coincidan con la realidad. Este fenómeno, conocido como error en la predicción de la recompensa, funciona como un algoritmo de aprendizaje reforzado.

El nuevo trabajo de DeepMind se basa en la estrecha conexión entre los mecanismos de aprendizaje natural y artificial. En 2017, sus investigadores presentaron un algoritmo mejorado de aprendizaje reforzado cuyo rendimiento en diversas tareas ha ido aumentando de forma impresionante desde entonces. Ahora, los investigadores creen que este nuevo método podría ofrecer una explicación aún más precisa de cómo funcionan las neuronas de dopamina en el cerebro.

Este algoritmo mejorado predice sus las recompensas de una forma diferente. Mientras que el enfoque anterior calculaba las recompensas como un número único, que tenía que igualar la media del resultado esperado, el nuevo enfoque las representa con mayor precisión en forma de distribución. (Como por ejemplo una máquina tragaperras: se puede ganar o perder según la distribución. Pero en ningún caso se recibe la media del resultado esperado).

Esa modificación permite plantear una nueva hipótesis: ¿las neuronas de dopamina también predicen las recompensas de manera distributiva?

Para comprobar su teoría, DeepMind se asoció con un grupo de la Universidad de Harvard para observar el comportamiento de las neuronas de dopamina en ratones. Dieron a los animales una tarea, los recompensaban en función del resultado de una tirada de dados, y midieron los patrones de activación de sus neuronas de dopamina en todo momento. Descubrieron que cada neurona liberaba diferentes cantidades de dopamina, lo que significaba que cada una había pronosticado un resultado diferente. Mientras que algunas eran demasiado "optimistas", prediciendo recompensas más altas de lo que realmente recibían, otras eran más "pesimistas", rebajando la recompensa real. Cuando los investigadores trazaron la distribución de esas predicciones, comprobaron que se parecían mucho a la distribución de las recompensas reales. Estos resultados ofrecen una prueba convincente de que el cerebro usa predicciones de recompensas distribucionales para fortalecer su algoritmo de aprendizaje.

Gráfico: Al medir el comportamiento de las neuronas de dopamina en ratones, los investigadores descubrieron que la distribución de las predicciones de las neuronas (decodificadas, en azul oscuso) se acercaba a la distribución de las recompensas reales (verdad fundamental, en gris). Créditos: DeepMind

En un correo electrónico, el pionero del comportamiento de las neuronas de dopamina Wolfram Schultz, que no participó en este estudio, escribió: "Esta es una buena ampliación de la noción de la codificación del error en la predicción de la recompensa de la dopamina. Resulta fascinante cómo esta simple respuesta de dopamina sigue de forma previsible los patrones intuitivos de los procesos básicos del aprendizaje biológico que ahora se está convirtiendo en un componente de la IA".

El estudio tiene implicaciones tanto para la IA como para la neurociencia. Primero, valida el aprendizaje reforzado distributivo como un camino prometedor hacia capacidades de la IA más avanzadas. Durante una rueda de prensa, el director de investigación de Neurociencia de DeepMind y uno de los principales autores del artículo, Matt Botvinick, afirmó: "Si el cerebro lo está usando, probablemente sea una buena idea. Creemos que se trata de una técnica computacional capaz de escalar en las situaciones del mundo real. Va a encajar bien con otros procesos computacionales".

En segundo lugar, podría ofrecer una importante actualización de una de las teorías neurocientíficas convencionales sobre los sistemas de recompensa en el cerebro, lo que a su vez podría mejorar nuestra comprensión de muchos aspectos, desde la motivación hasta la salud mental. ¿Qué podría significar, por ejemplo, tener neuronas de dopamina "pesimistas" y "optimistas"? Si el cerebro usa unas u otras de forma selectiva, ¿podría eso conducir a desequilibrios químicos e inducir la depresión?

Lo fundamental es que los resultados también arrojan luz sobre cómo se genera la inteligencia humana, al seguir los procesos de decodificación en el cerebro. Botvinick concluyó: "Nos da una nueva visión sobre lo que sucede en nuestro cerebro en la vida cotidiana".