Su modelo ERNIE ha derrotado a Google y a Microsoft en una reciente competición sobre lenguaje natural gracias a una técnica llamada enmascaramiento y al hecho de que los investigadores se vieran obligados a adaptarla al chino. Es un ejemplo de cómo la inteligencia artificial se beneficia de la diversidad

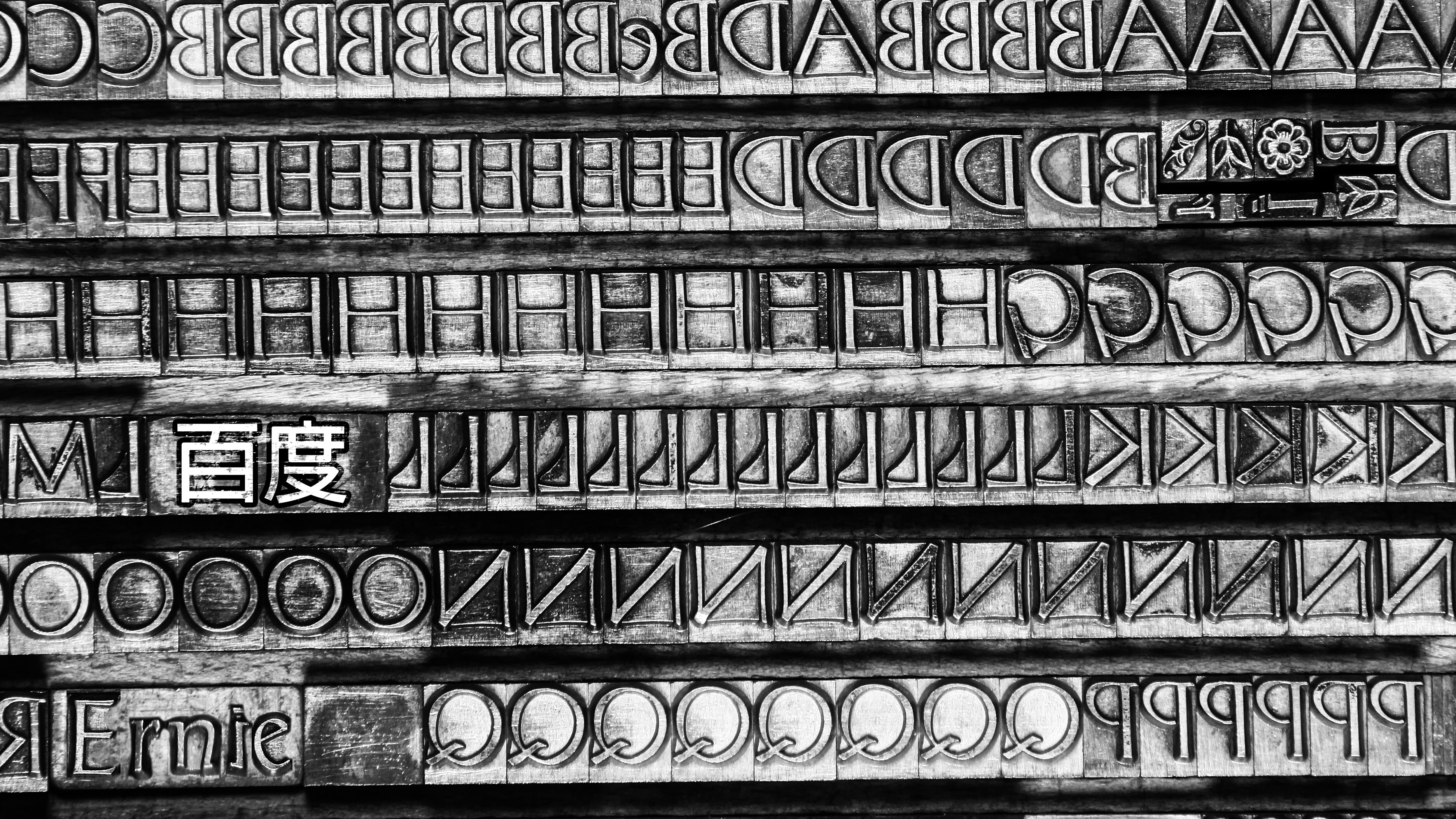

A finales de 2019 y de forma silenciosa, un gigante tecnológico chino derrotó a Microsoft y Google en una competición de inteligencia artificial (IA). La compañía era Baidu, conocida como el Google chino, y la competición era la Evaluación de la comprensión general del lenguaje (también conocida como GLUE, por sus siglas en inglés).

GLUE se ha convertido en un indicador ampliamente aceptado sobre lo bien que un sistema de inteligencia artificial comprende el lenguaje humano. Se compone de nueve pruebas diferentes en las que se pide, por ejemplo, encontrar nombres de personas y organizaciones en una frase y descubrir a qué se refiere un pronombre como "eso" cuando hay varias posibles opciones. Un modelo de lenguaje con buena puntuación en GLUE puede manejar diversas tareas de comprensión lectora. De un total de 100 puntos, una persona promedio obtiene alrededor de 87 puntos. Ahora, Baidu se ha convertido en el primer equipo en superar los 90 puntos con su modelo ERNIE.

La tabla de clasificación pública de GLUE cambia constantemente, y es muy probable otro equipo supere a Baidu dentro de poco. Pero lo extraordinario del logro de Baidu es que ilustra cómo la investigación de IA se beneficia de la diversidad. Para crear ERNIE, Los investigadores de Baidu tuvieron que desarrollar una técnica específica para el idioma chino, lo que pasa es que esa misma técnica también mejora la comprensión del inglés.

El antecesor de ERNIE

Para entender lo que representa ERNIE, hay que analizar el modelo en el que se inspiró: BERT de Google. (Sí, ambos llevan nombres de personajes de la versión estadounidense de Barrio Sésamo).

Antes de que BERT naciera a finales de 2018, los modelos de lenguaje natural no eran muy buenos. Su capacidad de predecir la siguiente palabra en una frase era bastante buena, por lo que resultaban buenos para aplicaciones como Autocompletar. Pero no podían seguir un solo hilo de pensamiento, ni siquiera en un pequeño párrafo, ya que no comprendían el significado, como por ejemplo a qué se podría referir la palabra "eso".

Pero con BERT todo cambió. Los modelos anteriores aprendían a predecir e interpretar el significado de una palabra a través del análisis del contexto que aparecía antes o después de la misma, pero nunca ambos al mismo tiempo. Eran, en otras palabras, unidireccionales.

En cambio, BERT analiza el contexto que aparece antes y después de una palabra a la vez, de forma bidireccional. Para ello usa una técnica conocida como "enmascaramiento". En un fragmento de texto, BERT oculta aleatoriamente el 15 % de las palabras y luego trata de predecirlas a partir de las restantes. Esto le permite hacer predicciones más precisas porque tiene el doble de pistas para trabajar. Por ejemplo, en la frase "El hombre fue al ___ a comprar leche", tanto el inicio como el final de la frase dan pistas sobre la palabra que falta. El ___ es un lugar al que se puede ir y un lugar donde se puede comprar leche.

El uso del enmascaramiento es una de las principales innovaciones responsables de las enormes mejoras en las tareas relacionadas con el lenguaje natural y es parte de la razón por la cual modelos como el asombroso GPT-2 de OpenAI pueden escribir prosa extremadamente convincente sin desviarse del tema central.

Del inglés al chino y viceversa

Cuando los investigadores de Baidu empezaron a desarrollar su propio modelo de lenguaje, querían añadir la técnica de enmascaramiento. Pero se dieron cuenta de que debían ajustarla para adaptarla al chino.

En inglés, las palabras son unidades semánticas, lo que significa que una palabra sacada completamente de contexto mantiene su significado. Pero no se puede decir lo mismo de los caracteres en chino. Aunque ciertos símbolos tienen un significado inherente, como fuego (火, huŏ), agua (水, shuĭ) o madera (木, mù), la mayoría no lo tienen hasta que se unen con otros. El símbolo 灵 (líng), por ejemplo, puede significar inteligente (机灵, jīlíng) o alma (灵魂, línghún), en función del símbolo que le acompañe. Y los caracteres en un nombre propio como Boston (波士顿, bōshìdùn) o EE. UU. (美国, měiguó) no significan lo mismo por separado.

Por eso, los investigadores entrenaron a ERNIE con una nueva versión de enmascaramiento que oculta caracteres en vez de símbolos individuales. También lo entrenaron para distinguir entre las series con significado y las aleatorias para que pudiera ocultar las combinaciones de caracteres correctas en ese sentido. Como resultado, ERNIE tiene una mayor comprensión de cómo las palabras codifican la información en chino y predice con mucha más precisión las que faltan. Esto resulta útil para las aplicaciones como traducción y recuperación de información de un documento de texto.

Los investigadores descubrieron rápidamente que este enfoque también funciona mejor para el inglés. Aunque no tanto como el chino, el inglés también tiene series de palabras que no significan lo mismo que la suma de sus partes. Los nombres propios como "Harry Potter" y expresiones como "de tal palo, tal astilla" no se pueden analizar separándolos en palabras individuales.

Por eso, para la frase:

Harry Potter es una serie de novelas de fantasía escritas por J. K. Rowling.

BERT podría enmascararlo de la siguiente manera:

[máscara] Potter es una serie [máscara] novelas de fantasía [máscara] de J. [máscara] Rowling.

Pero ERNIE lo enmascararía así:

Harry Potter es [máscara] [máscara] [máscara] novelas de fantasía de [máscara] [máscara] [máscara].

ERNIE aprende a hacer predicciones más completas a partir del significado en vez de por los patrones estadísticos sobre el uso de palabras.

Diversidad de ideas

La última versión de ERNIE también utiliza otras técnicas de entrenamiento. Analiza el orden de las frases y las distancias entre ellas, por ejemplo, para comprender la progresión lógica de un párrafo. Sin embargo, lo más importante es que utiliza un método llamado entrenamiento continuo para entrenarse con nuevos datos y nuevas tareas sin olvidar las que aprendió antes. Esto le permite mejorar cada vez más en la realización de una amplia gama de tareas a lo largo del tiempo con una mínima interferencia humana.

Baidu ya utiliza a ERNIE para ofrecer resultados de búsqueda más aplicables a sus usuarios, para eliminar los artículos duplicados en su fuente de noticias y para mejorar la capacidad de su asistente de inteligencia artificial Xiao Du para responder con precisión a las preguntas. La empresa ha descrito la última arquitectura de ERNIE en un artículo que se presentará este año en la conferencia de la Asociación para el Avance de la Inteligencia Artificial. De la misma manera que su equipo se basó en el trabajo de Google con BERT, los investigadores esperan que otros también se beneficien de su trabajo con ERNIE.

El principal artífice de Baidu Research, Hao Tian, concluye: "Cuando empezamos este trabajo, pensábamos específicamente en ciertas características del idioma chino. Pero pronto descubrimos que se podía aplicar incluso más allá".