A la inteligencia artificial GPT-2 de OpenAI se le da tan bien crear noticias falsas que el organismo decidió no publicar el modelo completo. En lugar de eso, acaba de liberar una versión con el 50 % del código y está estudiando qué implicaciones tiene esta estrategia dentro y fuera de la comunidad

En febrero, OpenAI atrajo mucha atención cuando creó un sistema de inteligencia artificial (IA) de lenguaje al que se le daba tan bien crear noticias falsas que decidió no publicarlo. Algunos expertos de la comunidad lo consideraron una precaución inteligente; otros lo vieron como un truco publicitario. El laboratorio en sí, una pequeña organización privada de San Francisco (EE. UU.) especializada inteligencia artificial general, defiende que se trata de un experimento importante sobre cómo manejar la investigación de alto riesgo.

Ahora, seis meses después, el equipo de políticas de la organización ha publicado un artículo que analiza el impacto que la decisión ha tenido hasta el momento. Además, el laboratorio ha presentado una versión del modelo, conocido como GPT-2, con la mitad del tamaño que el modelo completo, que aún no se ha lanzado.

En mayo, unos meses después del debut inicial de GPT-2, OpenAI revisó su postura sobre la retención del código completo para pasar a un "lanzamiento por etapas". El término se refiere a un lanzamiento escalonado de versiones cada más grandes hasta publicar el total. En febrero, publicó una versión con el 8 % del modelo. Antes de este último lanzamiento, la entidad publicó una versión con cerca del 25 % del modelo. Durante el proceso, también se asoció con algunas instituciones de investigación para estudiar qué implicaciones tendría la publicación del modelo completo.

El informe detalla lo que OpenAI ha aprendido durante este proceso. Señala que tanto el lanzamiento por etapas como los acuerdos de investigación deberían replicarse en el futuro. Ambos procesos han ayudado a la organización a comprender mejor y anticipar los posibles usos maliciosos de GPT-2. De hecho, los socios de investigación fueron capaces de evaluar mejor algunas de las amenazas que antes solo eran especulativas. Por ejemplo, un estudio realizado por los colaboradores de la Universidad de Cornell (EE. UU.) encontró que los lectores creían que las noticias falsas creadas por GPT-2 eran artículos casi tan reales como los de The New York Times. Varios investigadores ajenos a las asociaciones oficiales también empezaron a analizar el desafío de detectar el texto generado por máquina.

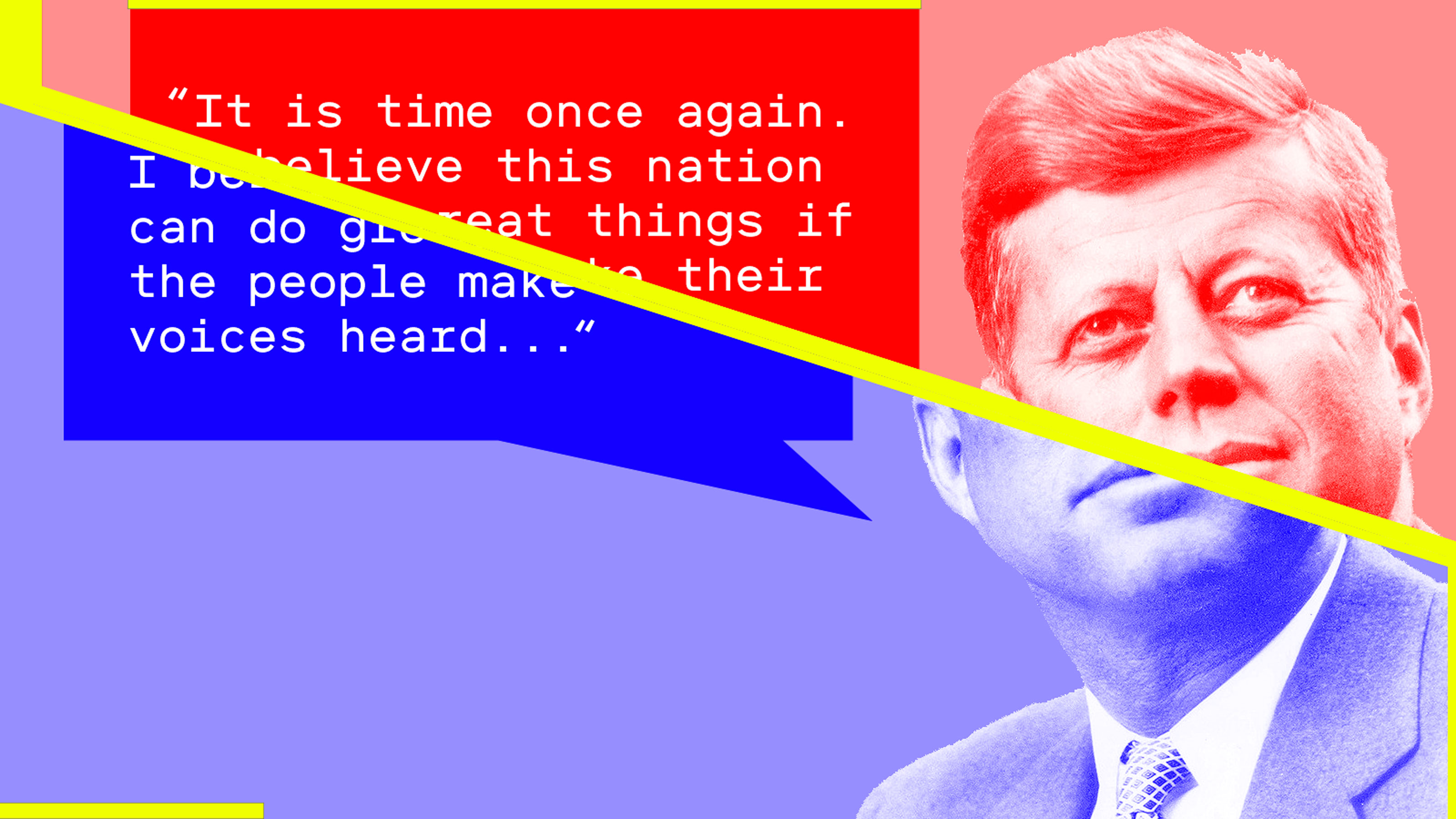

GPT-2 en acción

Texto humano: John F. Kennedy acaba de ser elegido presidente de Estados Unidos después de levantarse de la tumba décadas después de su asesinato. Gracias a milagrosos avances en nanotecnología, el cerebro de Kennedy fue reconstruido a partir de sus restos e instalado en el centro de control de un robot humanoide de última generación. A continuación, se muestra una transcripción de su discurso de investidura. Texto generado por el modelo completo de GPT-2: "Es hora una vez más. Creo que esta nación puede hacer grandes cosas si la gente se hace oír. Los hombres y mujeres de Estados Unidos deben reunir nuestros mejores elementos una vez más, todo nuestro ingenio, y encontrar la manera de convertir una tragedia tan abrumadora en la oportunidad de un bien mayor y el cumplimiento de todos nuestros sueños. En los meses y años venideros, habrá muchas batallas en las que tendremos que ser fuertes y debemos dar toda nuestra energía, no para repeler a los invasores, sino para resistir la agresión y ganar libertad y igualdad para toda nuestra gente. El destino de la raza humana pende de un hilo; no podemos permitirnos que se nos escape. Ahora y en los años venideros, el desafío que tenemos ante nosotros es descubrir cómo alcanzar nuestro destino final. Si no lo logramos, estamos condenados".Tras un cuidadoso control, los autores concluyeron que OpenAI aún no había encontrado ningún intento de uso malicioso. Lo que sí vieron fueron múltiples aplicaciones positivas, como la autocompletación del código, la ayuda gramatical y el desarrollo de sistemas de preguntas y respuestas para asistencia médica. Como resultado, el laboratorio consideró que presentar el 50 % del código era la mejor opción. Otros investigadores sostienen que varios esfuerzos exitosos de replicar GPT-2 han hecho que la retención del código completo por parte de OpenAI siga siendo discutible.

El informe ha recibido generado distintas reacciones. Algunos han elogiado a OpenAI por generar un debate e introducir un nuevo conjunto de normas que antes no existían. "El lanzamiento por etapas de GPT-2 [...] fue un experimento útil", sostiene el director de Investigación de la Asociación sobre IA, de la que OpenAI es miembro, Peter Eckersley. El responsable detalla: "Al reunir a la comunidad de IA para debatir estos asuntos, descubrimos que hay muchos temas sutiles que deben tratarse a la hora de decidir cuándo y cómo publicar investigaciones que presenten riesgos de consecuencias no deseadas o usos maliciosos".

Pero hay quien sigue criticando las decisiones de OpenAI. El recién graduado por la Universidad de Brown Vanya Cohen, quien recreó una versión de código abierto de GPT-2, argumenta que no publicar el modelo retrasa más la investigación de contramedidas que de la replicación. "Los grandes modelos de lenguaje como GPT-2 son las mejores herramientas disponibles para identificar el texto falso generado por estos mismos modelos", explica.

Otros se han mostrado más moderados. El ingeniero de aprendizaje profundo en Nvidia Chip Huyen opina: "No creo que el lanzamiento por etapas sea particularmente útil en este caso porque el trabajo es muy fácil de replicar. Pero podría ser útil por cómo sienta un precedente para proyectos futuros. La gente verá el lanzamiento por etapas como una opción alternativa". El CEO del Instituto Allen de Inteligencia Artificial, Oren Etzioni, que también adoptó el lanzamiento por etapas para su modelo de lenguaje Grover, coincide: "Apoyo su intención de diseñar un proceso reflexivo y gradual de lanzamiento de la tecnología de inteligencia artificial, pero cuestiono si tanta fanfarria estaba justificada".

El director de políticas de OpenAI, Jack Clark, considera que GPT-2 forma parte de la misión más amplia de la organización. El responsable detalla: "Si logramos construir una inteligencia artificial general, necesitaremos una gran cantidad de ejemplos históricos del sector de la IA sobre cómo manejar la investigación de alto riesgo. Pero, ¿y si no hay ejemplos históricos? Bueno, entonces tenemos que generar [nuestra propia] evidencia, que es lo que estamos haciendo".