Las redes neuronales tradicionales tienen dificultades para modelar procesos continuos. Un equipo de investigadores ha desarrollado una técnica diferente que reemplaza las capas discretas por ecuaciones diferenciales. Las aplicaciones de inteligencia artificial en el ámbito médico podrían beneficiarse del nuevo diseño

El investigador de inteligencia artificial (IA) de la Universidad de Toronto (Canadá) David Duvenaud estaba colaborando en un proyecto relacionado con datos médicos cuando descubrió un defecto importante en la IA. Su objetivo era desarrollar un modelo de aprendizaje profundo que pudiera predecir la salud de un paciente a lo largo del tiempo. Pero los datos de los registros médicos son un poco confusos: a lo largo de nuestra vida, visitamos al médico en diferentes momentos y por distintos motivos, generando unas cuantas mediciones en unos intervalos arbitrarios.

Una red neuronal tradicional tiene problemas para gestionar este problema. Su diseño requiere un aprendizaje de los datos con unas claras etapas de observación. Por lo tanto, es una herramienta deficiente para hacer un modelo de procesos continuos, especialmente aquellos que se miden de manera irregular a lo largo del tiempo.

Este reto llevó a Duvenaud (El hallazgo de hace 30 años en el que se basa toda la inteligencia artificial actual) y a sus colaboradores de la universidad y del Instituto Vector (Canadá) a rediseñar las redes neuronales tal y como las conocemos. Hace unos días, su investigación fue nombrada una de "las mejores publicaciones" en la Conferencia sobre sistemas de procesamiento de información neuronal (NIPS por sus siglas en inglés), uno de los eventos más importantes sobre investigación de inteligencia artificial (IA).

Las redes neuronales son el ingrediente principal para que el aprendizaje profundo sea tan potente. Una red neuronal tradicional está formada por capas de sencillos nodos computacionales que trabajan juntas para encontrar patrones en los datos. Las capas discretas son las que le impiden hacer un modelo de los procesos continuos (llegaremos a eso después).

Para solucionarlo, el diseño de este equipo de investigación elimina las capas por completo (Duvenaud indica que la idea no se les ocurrió a ellos, sino que simplemente fueron los primeros en implementarla de manera generalizada). Para comprender cómo funciona, veamos qué es lo que hacen las capas en primer lugar.

El proceso más común para entrenar una red neuronal (también conocido como aprendizaje supervisado) implica proporcionarle un montón de datos etiquetados. Pongamos que queremos desarrollar un sistema que reconozca diferentes animales.

Para ello, tendríamos que entrenar una red neuronal con imágenes de animales con los correspondientes nombres de esos animales. Internamente, se comienza a resolver un rompecabezas matemático. La red observa todas las parejas de nombres e imágenes y descubre una fórmula que de manera confiable relaciona una (la imagen) con la otra (la categoría). Una vez ese rompecabezas se resuelve, se puede reutilizar la fórmula una y otra vez para categorizar correctamente cualquier foto de animal nuevo en la mayoría de ocasiones.

Pero encontrar una fórmula única que describa la transformación completa de imagen a nombre sería un trabajo demasiado amplio y daría como resultado un modelo de baja precisión. Sería como tratar de usar una sola norma para diferenciar los gatos de los perros. Se podría decir que los perros tienen las orejas caídas, pero algunos perros no las tienen así y algunos gatos sí las tienen de esa forma, por lo que terminaríamos con muchos falsos negativos y positivos.

Aquí es donde entran en juego las capas de una red neuronal: dividen el proceso de transformación en pasos y permiten que la red descubra una serie de fórmulas que describen cada una de las etapas del proceso.

De esta forma, la primera capa puede analizar todos los píxeles y utilizar una fórmula para elegir cuáles son más relevantes de los gatos y no de los perros. Una segunda capa podría usar otra fórmula para encontrar patrones a partir de grupos de píxeles y averiguar si la imagen tiene bigotes u orejas. Cada capa subsiguiente identificaría características cada vez más complejas del animal, hasta que la capa final decida si se trata de un "perro" basándose en todos los cálculos. Este desglose paso a paso del proceso permite que una red neuronal desarrolle modelos más sofisticados, lo que debería permitir que las predicciones sean más precisas.

El modelo de capas ha funcionado muy bien en el campo de la IA, pero también tiene un inconveniente. Si deseamos modelar algo que se transforme continuamente con el tiempo, también se debe poder dividir en pasos diferenciados. En la práctica, si volvemos al ejemplo de la salud, eso significaría agrupar nuestros informes médicos en periodos definidos como años o meses. Puedes imaginar lo inexacto que sería en este caso. Si fuimos al médico el 11 de enero y no hemos vuelto hasta el 16 de noviembre, los datos de ambas visitas se agruparán en el mismo año.

Por ello, la mejor manera de hacer un modelo de la realidad de la forma más exacta posible es añadir más capas para aumentar el nivel de detalle. (¿Por qué no dividir los informes en días o incluso horas? ¡Podríamos haber ido al médico dos veces en un día!) Llevado al extremo, esto significa que la mejor red neuronal para este trabajo tendría un número infinito de capas para modelar cambios infinitesimales. La pregunta es si esta idea es incluso práctica.

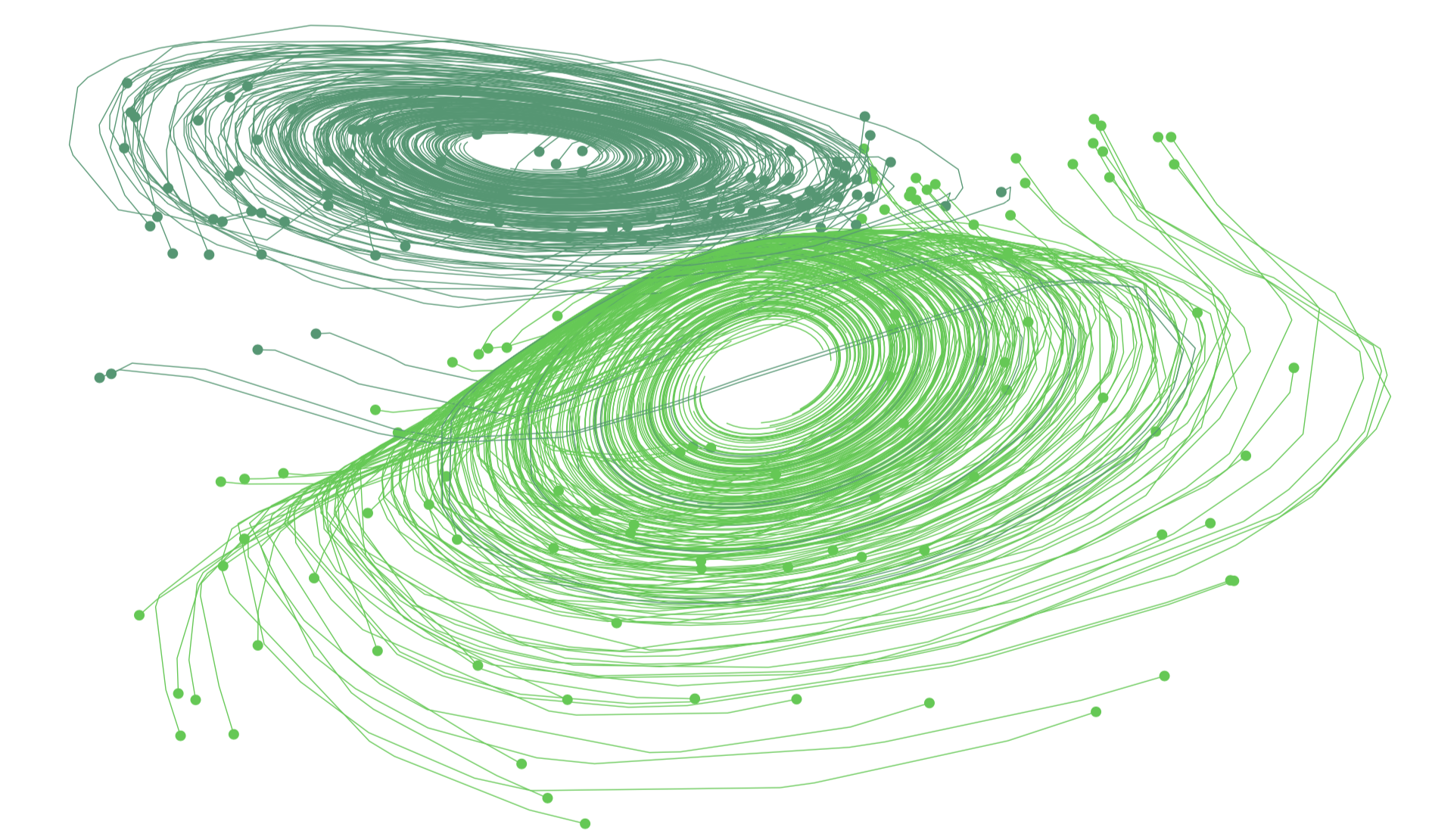

Si esto le está empezando a sonar familiar, es porque precisamente el cálculo matemático se ideó para resolver este tipo de problemas. Esta rama matemática ofrece las ecuaciones necesarias para calcular esta serie de cambios que tienen lugar a pasos infinitesimales. Es decir, ahorra el problema de tener que saltar a un modelo continuo a partir de unidades discretas. Esta es la magia del trabajo de Duvenaud y de sus colaboradores: reemplaza las capas discretas por ecuaciones.

El resultado final ya ni siquiera es una red: no hay más nodos y conexiones, solo un bloque de computación continuo. No obstante, siguiendo la convención, los investigadores llamaron a este diseño una "red EDO" (por ecuaciones diferenciales ordinarias), si bien aún tienen que trabajar en el nombre de su avance.

Si le duele la cabeza pensando en esto (créanme, la mía también me duele), aquí hay una buena analogía que Duvenaud usa para explicarlo todo. Piense en un instrumento musical continuo como un violín: puede deslizar su mano a lo largo de la cuerda para tocar la frecuencia que desee. Ahora piense en un piano, que tiene un número distinto de teclas para tocar un número limitado de frecuencias.

Una red neuronal tradicional es como un piano: por mucho que lo intente, no podrá deslizarse entre frecuencias. Solo podrá aproximarse a ese deslizamiento tocando una escala. Incluso si se ajusta el piano de modo que las frecuencias de las notas estuvieran muy juntas, todavía estaríamos aproximándonos a la frecuencia con una escala. Cambiar a una red EDO es como cambiar el piano por un violín. No siempre es la herramienta correcta, pero es la más adecuada para ciertas tareas.

Además de poder modelar el cambio continuo, una red EDO también modifica ciertos aspectos del aprendizaje. Con una red neuronal tradicional, al comienzo se debe especificar el número de capas que deseamos en la red y después esperar hasta que se complete el aprendizaje para averiguar lo preciso que es el modelo. El nuevo método permite especificar primero la precisión deseada y encontrar la manera más eficiente de entrenamiento solo dentro de ese margen de error.

Por otro lado, mientras que sabemos desde el principio cuánto tiempo llevará el aprendizaje a una red neuronal tradicional, no conocemos cuánto le llevará a una red EDO. Estas son las contrapartidas que los investigadores tendrán que tener en cuenta, explica Duvenaud, cuando decidan qué técnica usar en el futuro.

Actualmente, el documento ofrece una prueba de concepto para el diseño, "pero aún no está listo para su uso más amplio", dice Duvenaud. Al igual que cualquier técnica inicial propuesta en el campo, aún debe desarrollarse, experimentarse y mejorarse. Pero el método tiene el potencial de revolucionar el campo, de la misma manera que lo hizo el investigador Ian Goodfellow cuando publicó su artículo sobre las GAN (redes generativas antagónicas) (ver El señor de las GAN: el hombre que dio imaginación a las máquinas).

"Muchos de los principales avances en el campo del aprendizaje automático están relacionados con el área de las redes neuronales", afirma el director de investigación del Instituto Vector Richard Zemel, que no participó en el documento. "Es probable que el estudio estimule toda una serie de trabajos de seguimiento, particularmente en modelos de series de tiempo, que son esenciales en aplicaciones de inteligencia artificial como en la atención médica".

Así que si las redes EDO se empiezan a utilizar, recuerde que leyó sobre ellas aquí primero.