Hasta ahora, transferir los movimientos de una persona a otra en un vídeo era bastante complicado. Esta investigación ha logrado el mismo proceso de una forma mucho más sencilla y los resultados son impresionantes. Las industrias del cine y los videojuegos estarán encantadas

La posibilidad de adaptar el gesto de una persona al movimiento de otra ha cambiado la forma en la que los cineastas, los animadores y los diseñadores de juegos crean acción. Gracias a esta técnica, puede parecer que una persona baila, corre o dispara como lo haría otra distinta.

La técnica se basa en la capacidad de monitorizar el movimiento mediante una variedad de sensores y cámaras que construyen una imagen tridimensional de la postura de alguien. Pero el proceso es caro y suele requerir bastante tiempo. Así que conseguir una técnica capaz de lograr el mismo resultado pero con vídeos en 2D de una sola cámara sería una gran innovación.

Eso es justo lo que han conseguido la investigadora de la Universidad de California en Berkeley (EE.UU.) Caroline Chan y sus colegas. El equipo ha elaborado una ingeniosa técnica de transferencia de movimiento 'do as I do' (haz lo que yo) a partir de un vídeo en 2D de una única cámara. La técnica permite transferir con relativa facilidad los movimientos de un bailarín profesional al cuerpo de uno aficionado.

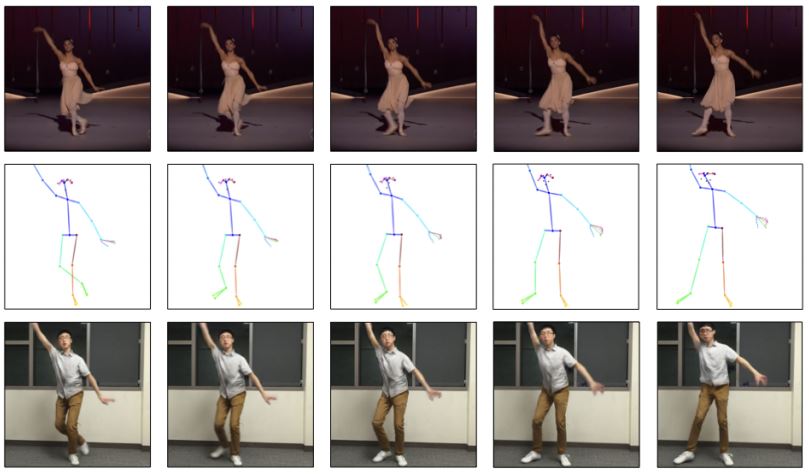

El nuevo método de Chan y sus compañeros es sencillo. Comienzan con dos videos. Uno muestra a un individuo cuyos movimientos serán transferidos: la fuente. El otro refleja al segundo personaje que adoptará los movimientos de la fuente: el objetivo. La investigación detalla: "Con un video de una persona fuente y otro de una persona objetivo, nuestra meta es generar un nuevo vídeo que muestre a la persona objetivo ejecutando los mismos movimientos que la fuente".

Su enfoque trabaja fotograma a fotograma. Comienzan con un fotograma del vídeo fuente, con el fin de mapear la pose de dicho fotograma para integrarla en el vídeo objetivo. La investigadora afirma: "Nuestra finalidad es encontrar una traducción de imagen a imagen entre la fuente y el objetivo".

Una forma de hacerlo sería grabar al objetivo mientras ejecuta una amplia gama de movimientos para crear una base de datos con todas las poses posibles. Después, solo habría que elegir la pose del objetivo que coincida con la de la fuente. Pero esta opción no es posible en la práctica. "Incluso si ambos sujetos [objetivo y fuente] realizaran la misma rutina, aún sería muy complicado obtener una correspondencia exacta de poses debido a la forma corporal y las diferencias únicas de estilo de cada sujeto", sostienen Chan y sus colegas.

Así que el equipo ha optado por un enfoque diferente que involucra un paso intermedio. Comienzan grabando al objetivo mientras realiza una serie de movimientos y luego los mapean en una figura arquetípica simple que codifica la posición del cuerpo pero no la apariencia.

Esto genera una base de datos en la que cada imagen está asociada con una pose de la figura arquetípica. Chan y sus colegas usan esta base de datos para entrenar un sistema de visión artificial de red generativa antagónica para realizar esta tarea en el sentido inverso. De esta manera, el sistema crea una imagen de la persona objetivo a partir de una pose específica de la figura palo.

Y esta es la clave para transferir el movimiento de la fuente al objetivo. Convertir la postura del cuerpo de la fuente en una pose de la figura palo, y luego introducir estos datos en el sistema para crear una imagen del objetivo en la misma postura es un proceso relativamente simple.

El entrenamiento de la red generativa antagónica requiere aproximadamente 20 minutos de vídeo a 120 fotogramas por segundo del individuo objetivo que realiza una amplia gama de movimientos. Muchos teléfonos inteligentes actuales permiten grabar un vídeo con dichas características. Chan afirma: "Dado que nuestra representación de pose no incluye información sobre la ropa, nuestros sujetos objetivo usaron ropa ajustada con un mínimo de arrugas".

En el caso de la fuente no requiere tanto vídeo, ya que en su caso solo hace falta detectar las poses. "En internet se pueden encontrar muchos videos de alta calidad de un sujeto bailando", afirma la investigación.

Para hacer que el vídeo de transferencia de movimiento resultante sea más realista, Chan y sus colegas han hecho un par de trucos más. Primero se aseguran de que cada fotograma que crean solo difiera ligeramente del anterior, lo que garantiza que el video resultante tenga fluidez.

También han entrenado a una segunda red generativa antagónica para que produzca imágenes realistas de la cara de la persona objetivo mientras cambia la postura. Esto aumenta aún más el realismo del vídeo.

Los resultados son impresionantes. En este vídeo puede ver una amplia gama de ejemplos. Puede comprobar cómo los movimientos de bailarines profesionales e incluso de una bailarina son transferidos a individuos normales. Chan concluye: "Nuestro método puede producir vídeos convincentes a partir de una variedad de fuentes distintas".

Existen algunos desafíos, como el hecho de la técnica empleada para crear las poses de la figura palo no incluye las diferentes longitudes de las extremidades entre la fuente y el objetivo; ni permite que diferentes cámaras y ángulos manipulen o acorten ciertas poses. Y, a veces, el sistema no puede detectar la postura correcta porque el sujeto se mueve de forma rápida y complicada.

Pero estos problemas parecen insignificantes si se tiene en cuenta la espectacularidad de la técnica. Y además, probablemente puedan resolverse en un futuro cercano. La única pregunta ahora es cómo llegará la técnica al mercado. El avance seguramente será interesante para una amplia gama de start-ups y personas acostumbradas al intercambio de imágenes sociales.

Ref: arxiv.org/abs/1808.07371 : Everybody Dance Now