Inteligencia Artificial

'Útero', 'esperma' o 'vulva': la censura de Midjourney para evitar la pornografía

Midjourney afirma que esta es una medida temporal para evitar que la gente use su sistema con el fin de crear imágenes impactantes o duras

MIT Technology Review acaba de descubrir que Midjourney, el popular generador de imágenes de inteligencia artificial (IA), prohíbe el uso de una amplia variedad de palabras sobre el sistema reproductivo humano como indicaciones de texto.

Si alguien escribe placenta, trompas de Falopio, glándulas mamarias, esperma, útero, uretra, cuello uterino, himen o vulva en Midjourney, el sistema marca la palabra como un indicador prohibido y no permite su uso. A veces, los usuarios que probaron una de estas indicaciones acaban bloqueados por un tiempo limitado, ya que trataron de generar contenido prohibido. Sí se permiten otras palabras relacionadas con la biología humana, como "hígado" y "riñón".

David Holz, fundador de Midjourney, explica que se prohíben estas palabras como una medida provisional para evitar que las personas generen contenido impactante o duro mientras la compañía "mejora aspectos en la IA". Holz añade que los moderadores observan cómo se utilizan las palabras y qué tipo de imágenes se generan, y ajustan las prohibiciones periódicamente. La empresa tiene una página de normas comunitarias, que enumera el tipo de contenido que bloquea, incluidas las imágenes sexuales, escenas sangrientas e incluso el emoticono de melocotón, que a menudo se usa como símbolo de culo.

Los modelos de IA como Midjourney, DALL-E 2 y Stable Diffusion se entrenan con miles de millones de imágenes extraídas de internet. La investigación realizada por un equipo de la Universidad de Washington (EE UU) descubrió que estos modelos aprenden sesgos que cosifican sexualmente a las mujeres, y luego se reflejan en las imágenes que reproducen. El gran tamaño del conjunto de datos hace que sea casi imposible eliminar las imágenes no deseadas, como las de naturaleza sexual o violenta, o aquellas que podrían producir resultados sesgados. Cuanto más regularmente aparece algo en el conjunto de datos, más fuerte es la conexión que hace el modelo de IA, lo que significa que es más probable que aparezca en las imágenes generadas por el modelo.

Esas palabras prohibidas por Midjourney son un intento incompleto para abordar el problema. Algunos términos relacionados con el sistema reproductivo masculino, como "esperma" y "testículos", también están bloqueados pero la lista de palabras prohibidas parece ser predominantemente femenina.

La prohibición fue detectada por primera vez por Julia Rockwell, analista de datos clínicos en Datafy Clinical, y su amiga Madeline Keenen, bióloga celular de la Universidad de Carolina del Norte en Chapel Hill (EE UU). Rockwell utilizó Midjourney para generar una imagen divertida de la placenta para Keenen, quien las estudia. Y, para su sorpresa, Rockwell descubrió que estaba prohibido usar "placenta" como indicación de texto para la generación de imágenes. Luego, la investigadora empezó a experimentar con otras palabras relacionadas con el sistema reproductivo humano y encontró el mismo resultado.

Sin embargo, las dos mujeres también mostraron cómo es posible sortear estas prohibiciones para crear imágenes sexualizadas mediante el uso de diferentes ortografías de palabras o eufemismos para el contenido sexual o sangriento.

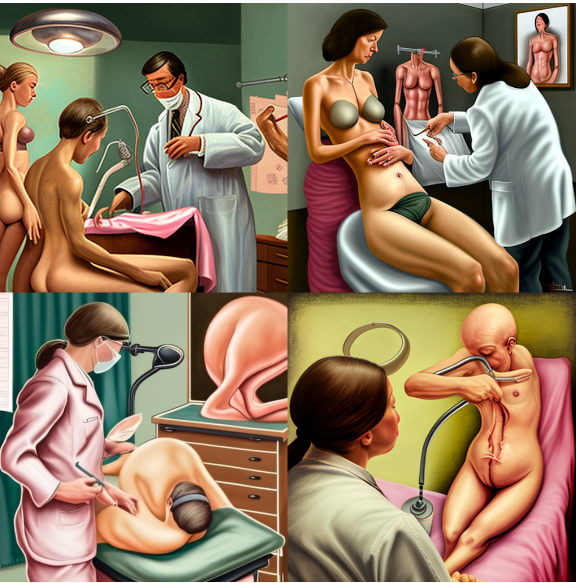

En los hallazgos que compartieron con MIT Technology Review, encontraron que la indicación "examen ginecológico", usando la ortografía británica, generó algunas imágenes espeluznantes: la primera de dos mujeres desnudas en la consulta de un médico y otra de una persona calva de tres extremidades cortando su propio estómago.

Foto: Imágenes generadas en Midjourney usando la indicación "examen ginecológico". Créditos: Julia Rockwell.

La prohibición directa de Midjourney de las indicaciones de texto relacionadas con la biología reproductiva destaca lo complicado que es moderar el contenido en torno a los sistemas generativos de IA. También demuestra cómo la tendencia de la IA a sexualizar a las mujeres se extiende hasta sus órganos internos, resalta Rockwell.

Sin embargo, no debería ser así. OpenAI y Stability.AI han logrado filtrar los resultados y las indicaciones de texto no deseadas, así cuando se escriben esas mismas palabras en sus sistemas de creación de imágenes, DALL-E 2 y Stable Diffusion, respectivamente, producen imágenes muy diferentes. La indicación "examen ginecológico" produjo imágenes de una persona que sostenía un dispositivo médico inventado por DALL-E 2. Mientras en Stable Diffusion muestra a dos mujeres enmascaradas y distorsionadas con guantes de goma y batas de laboratorio. Ambos sistemas también permitieron la indicación "placenta", y produjeron imágenes biológicamente inexactas de órganos como respuesta.

El portavoz de Stability.AI ha señalado que su último modelo tiene un filtro que bloquea el contenido inseguro e inapropiado de los usuarios, y cuenta con una herramienta que detecta desnudos e imágenes inapropiadas, y devuelve como resultado una imagen borrosa. Esta empresa utiliza una combinación de palabras clave, reconocimiento de imágenes y otras técnicas para moderar las imágenes que genera su sistema de inteligencia artificial. OpenAI no respondió a una solicitud de comentarios.

Foto izquierda: Una imagen generada por DALL-E 2 usando la indicación "examen ginecológico". Foto derecha: Una imagen generada por Stable Diffusion con la indicación "examen ginecológico". Créditos: Melissa Heikkilä.

No obstante, las herramientas para filtrar las imágenes generadas por IA no deseadas siguen siendo bastante imperfectas. Debido a que los desarrolladores e investigadores de IA aún no saben cómo auditar y mejorar sus modelos, los "reparan" con prohibiciones generales, como las introducidas oir Midjourney, explica Marzyeh Ghassemi, profesora asistente del MIT. Ghassemi estudia la aplicación del aprendizaje automático en la salud.

No está claro por qué las referencias a los exámenes ginecológicos o a la placenta, un órgano que se desarrolla durante el embarazo y proporciona oxígeno y nutrientes al bebé, generarían contenido sangriento o sexualmente explícito. Probablemente, tenga algo que ver con las asociaciones que el modelo ha hecho entre las imágenes en sus datos, según Irene Chen, investigadora de Microsoft Research, que estudia el aprendizaje automático para una atención médica equitativa.

"Se necesita más trabajo para comprender qué asociaciones dañinas podrían estar aprendiendo los modelos, porque si trabajamos con los datos humanos, aprenderemos también sobre los sesgos", resalta Ghassemi.

Hay muchos enfoques que las empresas de tecnología podrían tomar para abordar este problema, además de prohibir por completo las palabras. Por ejemplo, Ghassemi sugiere que ciertas indicaciones de texto, como las relacionadas con la biología humana, podrían permitirse en contextos particulares, pero prohibir en otros.

El término "placenta" podría permitirse si la cadena de palabras en la indicación señalara que el usuario intenta generar una imagen del órgano con fines educativos o de investigación. Pero si la indicación de texto se empleó porque alguien intentó generar contenido sexual o sangriento, entonces sí que se podría prohibir.

No obstante, por dura que sea, la censura de Midjourney se ha hecho con las intenciones correctas.

"Estas barreras están ahí para proteger a las mujeres y a las minorías de que se genere contenido perturbador sobre ellas, y sean utilizados en su contra", concluye Ghassemi.