Inteligencia Artificial

El día que los humanos empezaron a llorar a sus compañeros robots caídos en guerra

El siguiente gran reto de la inteligencia artificial es percibir y responder a las emociones humanas y, en consecuencia, tener una versión robótica de emociones propias. Pero, ¿sería bueno enviar a una situación de terror a una máquina capaz de sentir ese contexto?

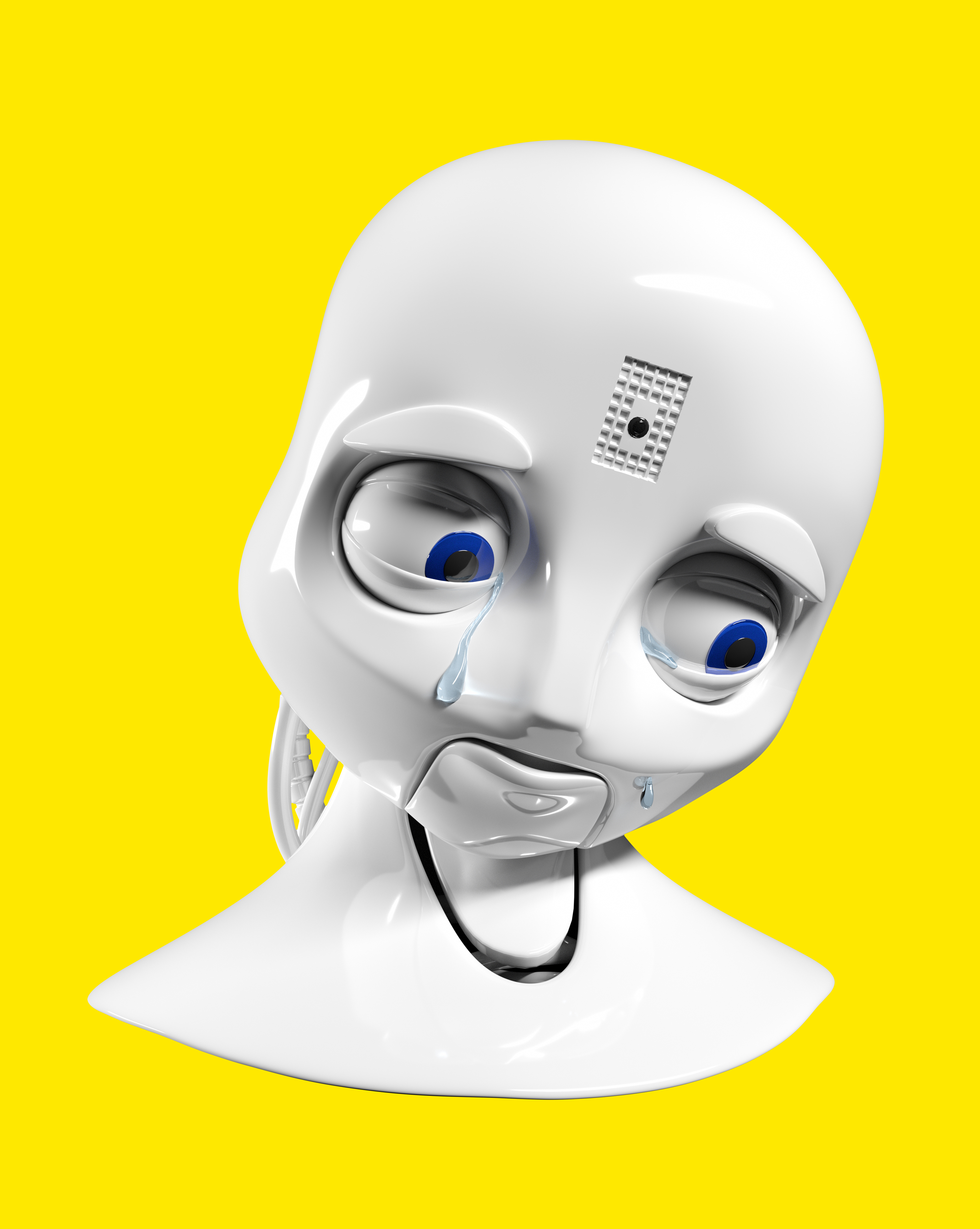

Octavia es un robot humanoide diseñado para combatir incendios en los buques de la Armada de EE. UU. Su rostro es capaz de producir una impresionante gama de expresiones faciales. Cuando está apagada, parece una muñeca de tamaño humano. Tiene la cara blanca y lisa, y la nariz respingona. Sus cejas de plástico descansan en su frente como dos pequeñas canoas del revés.

Pero cuando está encendida, sus párpados se abren y las emociones empiezan a fluir. Octavia puede asentir con la cabeza para ofrecer comprensión; puede agrandar sus ojos y arquear las cejas para dar un aspecto alarmista muy convincente. También puede inclinar la cabeza hacia un lado y torcer el gesto, replicando la confusión humana. Cómicamente, incluso puede arquear una ceja y entrecerrar el ojo opuesto mientras tamborilea sus dedos metálicos, como si planease actos robóticos maquiavélicos.

Pero la gama de expresiones faciales de Octavia no es su cualidad más impresionante. Lo sorprendente es que sus emociones responden de forma precisa a sus interacciones con los humanos. Parece complacida, por ejemplo, cuando reconoce a uno de sus compañeros de equipo. Parece sorprendida cuando otro le da una orden inesperada. Parece confundida si alguien dice algo que no comprende.

Muestra la emoción apropiada porque procesa cantidades ingentes de información sobre su entorno. Puede ver, oír y tocar. Controla visualmente su entorno mediante dos cámaras integradas en sus ojos y analiza características como rasgos faciales, complexión y vestimenta. Puede detectar las voces de las personas, gracias a cuatro micrófonos y un programa de reconocimiento de voz llamado Sphinx. Puede identificar 25 objetos diferentes mediante el tacto, tras haberlos aprendido manipulándolos con los dedos en varias posiciones y formas posibles. En conjunto, estas habilidades perceptivas forman parte de su "arquitectura cognitiva incorporada", que le permite, según sus creadores en el Centro de Investigación Aplicada en Inteligencia Artificial de la Marina, "pensar y actuar de manera similar a las personas".

Es una afirmación emocionante, pero no necesariamente impactante. Estamos acostumbrados a la idea de que las máquinas actúen como personas. Los autómatas creados en Francia en el siglo XVIII podían bailar, llevar el ritmo y tocar el tambor o el piano. Como niña que creció en la década de 1980, siempre quise una muñeca publicitada por su capacidad de orinarse en las bragas.

Foto: La robot Octavia es capaz de transmitir expresiones, pero resulta que no hacen falta las expresiones faciales para que las personas se sientan emocionalmente apegadas a sus robots. Crédito: Laboratorio de Investigación de la Armada de EE. UU.

Incluso estamos acostumbrados a la idea de que las máquinas piensen de formas parecidas a la nuestra. Muchas de nuestras apreciadas cotas máximas de la cognición humana, como la de vencer a un gran maestro en el ajedrez o la de componer un soneto métricamente preciso, ya han sido alcanzadas y superadas por las computadoras.

Pero las capacidades de Octavia parecen ir un paso más allá. Implican que, además de pensar como nosotros, también siente emociones humanas. Pero en realidad no es así.

Según el director de la Sección de Sistemas Inteligentes en el Centro de Inteligencia Artificial de la Marina, Gregory Trafton, el afecto emocional de Octavia solo tiene la intención de demostrar el tipo de pensamiento que está procesando y facilitar que las personas interactúen con ella. Pero no siempre es posible trazar una línea entre pensar y sentir. Como reconoce Trafton, "está claro que los pensamientos y las emociones de las personas son diferentes, pero se afectan entre sí". Y añade: "Las emociones influyen en la cognición y la cognición influye en la emoción". Así que la capacidad de Octavia para pensar, razonar y percibir apunta en la dirección de las grandes preguntas que acompañarán los avances de las máquinas inteligentes. ¿En qué momento las máquinas serán lo suficientemente inteligentes como para sentir algo? ¿Y cómo podríamos estar seguros de saberlo?

Sentimientos personalizados

Octavia ha sido programada con la teoría de la mente, lo que significa que puede prever los estados mentales de sus compañeros humanos. Entiende que las personas tienen creencias o intenciones potencialmente conflictivas. Cuando se le da una orden contraria a sus expectativas, ejecuta simulaciones para determinar qué podría estar pensando el compañero que dio la orden y por qué esa persona piensa que este objetivo inesperado es válido. Para ello, repasa sus propios modelos del mundo y los altera ligeramente, esperando encontrar uno que conduzca al objetivo establecido. Cuando inclina la cabeza hacia un lado y frunce el ceño, es señal de que está ejecutando estas simulaciones, tratando de entender mejor a su compañero de equipo.

Todavía nos falta mucho por saber sobre las emociones humanas.

Octavia no está programada con modelos emocionales. Su teoría de la mente es un patrón cognitivo. Pero se parece mucho a la empatía, la más apreciada de todas las emociones humanas.

Otros fabricantes de robots esquivan la cuestión de la inteligencia emocional de sus máquinas. SoftBank Robotics, por ejemplo, que comercializa a Pepper, un robot humanoide "agradable y simpático" construido para servir de acompañante humano, afirma que Pepper puede "percibir la emoción humana" y que "le encanta interactuar contigo; Pepper quiere aprender más sobre tus gustos, tus hábitos y, simplemente, quién eres". Pero aunque Pepper pudiera tener la capacidad de reconocer las emociones humanas, y aunque pudiera responder con sonrisas felices o expresiones de tristeza, nadie afirma que Pepper sienta en realidad tales emociones

¿Qué sería necesario para que un creador de robots proclamase eso? Para empezar, todavía nos falta mucho por saber sobre las emociones humanas.

Elementos analizados

- Culture and Human-Robot Interaction in Militarized Spaces: A War Story, de Julie Carpenter

(Routledge, 2016)- How Emotions Are Made: The Secret Life of the Brain, de Lisa Feldman Barrett

(Houghton Mifflin Harcourt, 2017)- La estrategia del Ejército de EE. UU. sobre Robótica y Sistemas Autónomos, marzo de 2017

En los últimos años, las revoluciones en psicología y neurociencia han redefinido radicalmente el propio concepto de emoción, por lo que ahora es incluso más difícil concretarlo y describirlo. Según científicos como la psicóloga y profesora de la Universidad Northeastern (EE. UU.) Lisa Feldman Barrett, cada vez está más claro que las emociones humanas varían en función de la cultura de origen. Incluso pueden ser muy diferentes para un mismo individuo en función del contexto. De hecho, aunque compartimos los sentimientos generales que conforman lo que se conoce como "afecto" (placer, disgusto, excitación y calma) con la mayoría de los demás humanos y muchos otros animales, nuestras emociones más agudas y específicas tienen a ser más variables que a seguir unas normas particulares. El miedo, por ejemplo, es un concepto culturalmente acordado, pero se refleja en nuestros cuerpos de innumerables maneras. Nace a raíz de diferentes estímulos, se manifiesta de manera diferente en nuestros cerebros y se expresa de diferentes maneras en nuestras caras. No hay un único "centro del miedo" o "circuito del miedo" en el cerebro, del mismo modo que no existe una expresión facial genuinamente temerosa: todos procesamos y mostramos nuestro miedo de maneras radicalmente diferentes, según la situación; maneras que, a través de interacciones con otras personas, aprendemos a identificar o etiquetar como "miedo".

Entonces, cuando hablamos de miedo, estamos hablando de un concepto aglutinador generalizado en lugar de algo que proviene de una parte específica del cerebro. Como dice Barrett, construimos las emociones sobre la marcha a través de la interacción de sistemas corporales. ¿Cómo podemos pretender entonces que los programadores modelen con precisión las emociones humanas en los robots?

Buenos soldados

El debate ético y moral sobre programar emociones en los robots también es una cuestión abierta. Un buen ejemplo del problema está en los robots militares que, como Octavia, están diseñados para acudir a situaciones aterradoras, dolorosas o potencialmente letales en lugar de compañeros humanos menos prescindibles.

En una conferencia de 2017 patrocinada por la Iniciativa del Científico Loco del Ejército de los EE. UU. (un nombre un tanto aterrador en sí mismo), el teniente general Kevin Mangum, subcomandante del Comando de Entrenamiento y Doctrina del Ejército, especificó que tales robots deberían ser autónomos. Magnum afirmó: "Según observamos en nuestro cada vez más complejo mundo, no hay duda de que la robótica, los sistemas autónomos y la inteligencia artificial desempeñarán un papel". La Estrategia de Sistemas Autónomos y Robótica del Ejército de 2017 predice la integración total de los sistemas autónomos para 2040, con el objetivo de sustituir a los actuales robots de desactivación de bombas y otras máquinas operadas en remoto por humanos.

Foto: Un instructor civil muestra a los paracaidistas cómo configurar la pantalla para un robot PackBot de campo de batalla. Tan inexpresivos como puedan parecer estos robots, los soldados en el campo desarrollan vínculos con ellos, viéndolos como parte del equipo.Crédito: Michael J. McLeod.

Cuando estos robots sean capaces de actuar y pensar por sí mismos, ¿deberían, como Octavia, ser programados con la apariencia de tener emociones humanas? ¿Deberían estar programados para tener realmente emociones humanas? Si los enviamos a la batalla, ¿no deberían sentir además de pensar junto a sus compañeros humanos?

Por un lado, por supuesto que no: si estamos diseñando robots con la misión expresa de exponerlos al peligro, sería sádico darles la capacidad de sufrir terror, trauma o dolor.

Pero por otro, si la emoción afecta a la inteligencia y viceversa, ¿podríamos estar seguros de que un robot sin emociones sería un buen soldado? ¿Qué pasaría si la falta de emoción condujese a decisiones estúpidas, riesgos innecesarios o represalias excesivamente crueles? ¿Podría un robot sin emociones llegar a la conclusión que la decisión más inteligente sería cometer lo que un soldado humano consideraría un crimen de guerra? ¿O tomaría mejores decisiones un robot sin acceso al miedo o la ira que un ser humano en la misma situación terrorífica y enloquecedora?

Y luego está la posibilidad de que, si la emoción y la inteligencia están intrínsecamente unidas, no pueda existir tal cosa como un robot verdaderamente inteligente que carece de emociones, en cuyo caso la pregunta de cuánta emoción debe tener un robot autónomo está, de alguna manera, fuera del control del programador que se ocupa de la inteligencia.

Apego emocional

También está la cuestión de cómo estos robots podrían afectar a sus compañeros humanos. En 2010, el Ejército de EE. UU. comenzó a desplegar una flota de aproximadamente 3.000 pequeños robots tácticos. La medida era, en gran parte, una respuesta al creciente uso de dispositivos explosivos improvisados (DEI) en la guerra. Estos robots sustituyen a los humanos a la hora de abordar carreteras expuestas, meterse en cuevas oscuras y atravesar puertas estrechas para detectar y desactivar DEI impredecibles.

Foto: Los soldados han reportado haberse sentido angustiados cuando compañeros de batalla como el Talon, que se muestra aquí, son destruidos en cumplimiento del deber. Crédito: QinetiQ.

Esta flota está compuesta principalmente por modelos de PackBot, de iRobot, y de Talon, de QinetiQ North America, aunque ninguno de ellos es demasiado avanzado. Se parecen un poco a WALL-E, con cuerpos metálicos de forma cuadrada y dispuestos sobre unas bandas de goma que les permiten moverse bien a través de terrenos rocosos, subir escaleras y bajar por oscuros pasillos. Tienen brazos articulados provistos de cámaras de vídeo para examinar su entorno, y garras para manipular dispositivos explosivos.

Son herramientas útiles, pero no son exactamente autónomas. Se controlan de forma remota, como coches de juguete, por soldados que tienen unos dispositivos que a veces están equipados con joysticks. Como ejemplo de inteligencia artificial, el PackBot no es mucho más avanzado que el producto más conocido de iRobot, el Roomba que aspira debajo de los sillones. Pero a pesar de la naturaleza inexpresiva de estos robots, los soldados humanos desarrollan vínculos con ellos. Julie Carpenter demuestra en Culture and Human-Robot Interaction in Militarized Spaces [Cultura e Interacción Humano-Robot en Espacios Militarizados] que estas relaciones son complicadas, a la vez gratificantes y dolorosas.

Cuando Carpenter le pidió a un militar que describiera sus sentimientos hacia un robot que había sido destruido, él respondió:

"Quiero decir, obviamente no estuvo... ni de lejos al mismo nivel que, como, ya sabes, un colega tuyo siendo herido o ver un miembro siendo amputado o algo así. Pero aun así había una cierta pérdida, una sensación de pérdida por algo que le sucedía a uno de tus robots".

Otro soldado comparó su robot con un perro mascota:

"Cuidas de esa cosa tan bien como al resto de los miembros de tu equipo. Y te aseguras de que se limpia, y de que las baterías están siempre cargadas. Y si no lo usas, te aseguras de que está bien guardado, porque sabes que, si algo le sucede al robot, pues bueno, es tu turno, y a nadie le gusta pensar eso".

Otro más explicó por qué su compañero de equipo le puso a su robot un nombre humano:

"A finales de nuestro periodo de servicio pasábamos más tiempo fuera de la base durmiendo en nuestros camiones que dentro. Podíamos dormir en nuestros camiones fuera de la base cinco o seis días a la semana, y había tres hombres en el camión, ya sabes, uno tumbado en los asientos delanteros; otro se tumba en la torreta. Pero no podíamos descargar los elementos delicados y dejarlos fuera del camión. Todo tiene que estar bajo llave, por lo que nuestro TALON estaba en el pasillo central de nuestro camión y nuestro recluta novato lo llamó Danielle para tener una mujer con la que acurrucarse por la noche".

"Lo que de verdad le dije al líder de mi equipo fue: 'Mi hermoso robot ha sido asesinado...'".

Todos estos hombres enfatizan que los robots son herramientas, no criaturas vivientes con sentimientos. Aun así, les dan nombres humanos y los guardan de forma segura por la noche. Bromean sobre ese impulso, pero hay una disonancia ligeramente inquietante en los chistes. Los soldados entrevistados por Carpenter parecen sentirse un poco atrapados entre dos sentimientos: entienden lo absurdo de cuidar un robot sin emociones diseñado para ser prescindible, pero sin embargo experimentan la tentación de preocuparse, al menos un poco.

Cuando Carpenter publicó sus entrevistas iniciales, recibió más mensajes de miembros del ejército que habían desarrollado vínculos reales con sus robots. Un antiguo técnico de eliminación de artefactos explosivos (EAE) escribió:

Como técnico de EAE durante ocho años y tres despliegues, puedo decirle que encontré su investigación extremadamente interesante. Estoy completamente de acuerdo con los otros técnicos entrevistados al decir que los robots son herramientas y, como tal, los enviaré a cualquier situación, independientemente del posible peligro.

Sin embargo, durante una misión en Irak en 2006, perdí un robot al que había llamado "Stacy 4" (en honor a mi esposa que también es técnica de EAE). Era una excelente robot que nunca me dio ningún problema, siempre funcionó impecablemente. Stacy 4 fue destruida y sólo pude recuperar piezas muy pequeñas del chasis. Inmediatamente después de la explosión que destruyó a Stacy 4, aún puedo recordar la sensación de rabia, y mucha. Y lo que de verdad le dije al líder de mi equipo fue: 'Mi hermoso robot ha sido asesinado...'. Después de completar la misión y recuperar del robot tanto como pude, lloré por su pérdida. Sentí como si hubiera perdido a un querido miembro de mi familia. Llamé a mi esposa esa noche y también se lo conté. Sé que suena tonto, pero aún odio pensar en ello. Sé que los robots que utilizamos son sólo máquinas y tomaría las mismas decisiones de nuevo, incluso conociendo el resultado.

Valoro la vida humana. Valoro las relaciones que tengo con personas reales. Pero le asegurod que echo de menos a Stacy 4; era una buena robot.

Si estos son los tipos de testimonios que pueden recopilarse de los soldados que interactúan con máquinas sin rostro como los PackBots y Talons, ¿qué dirían los soldados desplegados con robots como Octavia, que ven y oyen y tocan y pueden anticipar los estados de ánimo de sus compañeros humanos?

En las conversaciones populares sobre la ética de dar sentimientos a los robots, tendemos a centrarnos en los efectos de dicha innovación tecnológica sobre los propios robots. Películas y series de televisión desde Blade Runner a Westworld prestan atención al trauma que sufrirían los robots con emociones si los humanos los usaran para su entretenimiento. Pero también hay que considerar la inversa: el trauma infligido a los humanos que empatizan con robots qie son enviados a una muerte segura.

Y lo que lo hace aún más complicado es que, si un robot como Octavia termina sintiendo emociones humanas, esos sentimientos no serán sólo el resultado de la arquitectura cognitiva que se le haya dado desde el principio. Si se parecen algo a nuestras emociones, evolucionarán en el contexto de sus relaciones con sus compañeros de equipo, su lugar en el mundo en el que habitan.

Si su vida robótica se limita a penetrar en edificios en llamas o en abordar carreteras desérticas granadas de artefactos explosivos en solitario, sus emociones serán diferentes a las experimentadas por un robot más protegido, o un humano más protegido. Independientemente de las expresiones emocionales reconocibles que haga la máquina, si pasa su vida en situaciones inhumanas, sus emociones podrían no ser identificadas como humanas.