Inteligencia Artificial

Los siete grandes errores de quienes predicen el futuro de la inteligencia artificial

La creencia de que las máquinas inteligentes llegarán a dominar a la humanidad se basa en extrapolaciones equivocadas, imaginación sin límites, argumentos de fe y otros errores comunes que nos distraen de formas de pensar más productivas para el futuro del campo

Estamos inundados por una histeria acerca del futuro de la inteligencia artificial (IA) y la robótica; una histeria por el poder que alcanzarán, la velocidad con la que lo harán y sus consecuencias sobre el mercado laboral.

Recientemente vi una historia que decía que dentro de entre 10 años y 20 años los robots se habrán quedado con la mitad de los trabajos que existen hoy en día. Incluso había un gráfico para probar los cálculos. Esa afirmación es absurda (intento mantener un lenguaje profesional, pero a veces cuesta). Por ejemplo, el texto parece decir que en EEUU un millón de trabajadores de mantenimiento de edificios y terrenos parará a sólo 50.000 en ese plazo, porque los robots se harán cargo de esos puestos de trabajo. ¿Cuántos robots están actualmente operativos en esos trabajos? Cero. ¿Cuántas demostraciones realistas de robots trabajando en este ámbito ha habido? Cero. Historias similares se aplican a todas las otras categorías donde se sugiere que veremos el final de más del 90% de los trabajos que actualmente requieren presencia física en algún sitio en particular.

Las predicciones erróneas generan miedos sobre cosas que no van a suceder, ya sea la destrucción a gran escala de empleos, la Singularidad o el advenimiento de una inteligencia artificial con valores distintos a los nuestros que pudiera intentar destruirnos. Necesitamos luchar contra estos errores. ¿De dónde nacen estos fallos? Veo siete razones comunes.

1. Sobrestimar y subestimar

Roy Amara fue cofundador del Instituto para el Futuro de Palo Alto, el corazón intelectual de Silicon Valley (EEUU). Es más conocido por su máxima, que ahora se conoce como Ley de Amara:

Tendemos a sobrestimar el efecto de una tecnología a corto plazo y subestimar el efecto a largo plazo.

Hay mucha sabiduría encapsulada en estas 18 palabras. Un optimista puede entenderlas de una manera, y un pesimista, de otra.

Un gran ejemplo de ambos puntos de vista sobre la Ley de Amara es el Sistema de Posicionamiento Global (GPS). A partir de 1978, EEUU puso en órbita una constelación de 24 satélites (ahora 31 contando los de recambio). El objetivo del GPS era permitir la entrega precisa de municiones por parte del ejército estadounidense. Pero el programa estuvo a punto de ser cancelado una y otra vez en la década de 1980. El primer uso operativo para su propósito inicial fue en 1991 durante la Tormenta del Desierto [la operación del ejército de EEUU en la primera guerra de Irak]. Hicieron falta varios éxitos más para que los militares aceptaran su utilidad.

Las predicciones erróneas generan miedos sobre cosas que no van a suceder

Hoy en día el GPS se encuentra en lo que Amara llamaría el largo plazo, y sus usos actuales eran al principio inimaginables. Mi Apple Watch Serie 2 usa GPS mientras estoy corriendo, registrando mi ubicación con una precisión suficiente para ver a qué lado de la calle corro. El pequeño tamaño y el precio del receptor habrían sido incomprensibles para los primeros ingenieros de GPS. La tecnología sincroniza experimentos de física por todo el planeta y desempeña un papel fundamental en la sincronización de la red eléctrica de EEUU y mantenerla en funcionamiento. Incluso permite a los inversores de alta frecuencia que realmente controlan el mercado de valores evitar en mayor medida desastrosos errores de sincronización. Es utilizado por todos nuestros aviones, grandes y pequeños, para orientarse, y se utiliza para seguir a las personas que salen de la cárcel en libertad condicional. Determina qué variante de semillas será plantada en qué parte de muchos campos a lo largo del globo. Realiza un seguimiento de las flotas de camiones e informa sobre el rendimiento de los conductores.

El GPS comenzó con un objetivo, pero conseguir que funcionara tan bien como se esperaba fue difícil. Ahora está metido en tantos aspectos de nuestras vidas que no sólo estaríamos perdidos si desapareciera, sino que estaríamos fríos, hambrientos y muy posiblemente muertos.

Vemos un patrón similar con otras tecnologías en los últimos 30 años. Una gran promesa por adelantado, posterior decepción, y finalmente un lento crecimiento de la confianza en unos resultados que superan las expectativas originales. Esto es así para la informática, la secuenciación del genoma, la energía solar, la energía eólica, e incluso la entrega a domicilio de alimentos.

La inteligencia artificial ha sido sobrestimada una y otra vez, en la década de 1960, en la década de 1980, y creo que ahora también, pero sus perspectivas a largo plazo también están probablemente subestimadas. La pregunta es: ¿Cuándo llega el largo plazo? Los siguientes seis errores ayudan a explicar por qué la escala de tiempo está siendo subestimada para el futuro de la IA.

2. Imaginar magia

En mi época de adolescente, Arthur C. Clarke era uno de los "tres grandes" escritores de ciencia ficción, junto con Robert Heinlein e Isaac Asimov. Pero Clarke también fue inventor, escritor científico y futurista. Entre 1962 y 1973 formuló tres adagios que han llegado a ser conocidos como las Tres Leyes de Clarke:

1) Cuando un científico eminente pero anciano afirma que algo es posible, lo más seguro es que tenga razón. Cuando afirma que algo es imposible, es muy probable que esté equivocado.

2) La única manera de descubrir los límites de lo posible es aventurarse un poco más allá hacia lo imposible.

3) Cualquier tecnología lo suficientemente avanzada no puede distinguirse de la magia.

Personalmente, incluiría la segunda oración en la primera ley, ya que soy mucho más conservador que otros sobre la rapidez con la que evolucionará la inteligencia artificial. Pero por ahora quiero centrarme en la tercera ley de Clarke.

Imagínese que tuviéramos una máquina del tiempo y pudiéramos transportar a Isaac Newton desde finales del siglo XVII hasta la actualidad para colocarle en un lugar que le sería familiar: La capilla del Trinity College en la Universidad de Cambridge (Reino Unido).

Ahora muéstrenle a Newton una manzana [juego de palabras entre la hipotética manzana que le ayudó a descubrir la gravedad y el nombre en inglés de Apple]. Saque un iPhone de su bolsillo, y enciéndalo para que la pantalla brille llena de iconos, y entrégueselo. Newton, que demostró que la luz blanca se descompone en luz de diferentes colores al separar un rayo de Sol con un prisma y luego volverlo a unir, sin duda se sorprendería de que un objeto tan pequeño produjera colores tan vivos en la oscuridad de la capilla. Ahora reproduzca una película de una escena campestre inglesa, y luego una música de iglesia que él hubiera escuchado. Y luego muéstrele una página web con las más de 500 páginas de su copia con anotaciones personales de su obra maestra, los Principia, enseñándole cómo usar el gesto de pellizcar para ampliar los detalles.

Cuidado con los argumentos acerca de una futura tecnología que es mágica, porque nunca pueden ser refutados.

¿Sería capaz Newton de dar una mínima explicación sobre cómo funciona ese aparato? Aunque inventó el cálculo y explicó tanto la óptica como la gravedad, nunca pudo diferenciar la química de la alquimia. Así que creo que el científico estaría desconcertado y sería incapaz de imaginar una descripción mínimamente coherente del dispositivo. Para él no habría diferencia con una encarnación de lo oculto, algo en lo que se interesaba mucho. No podría distinguir un iPhone de la magia. Y recuerde, Newton era un tipo muy inteligente.

Si algo es mágico, es difícil conocer sus limitaciones. Supongamos que mostramos a Newton cómo el dispositivo puede iluminar la oscuridad, cómo puede hacer fotos y vídeos y grabar sonido, cómo hacer de lupa y de espejo. A continuación, le mostramos que también sirve para hacer cálculos aritméticos a una velocidad increíble y con muchos decimales. Le enseñamos que el teléfono ha ido contando sus pasos a medida que anda, y le mostramos que puede usarlo para hablar con personas de cualquier parte del mundo, inmediatamente, desde esa misma capilla.

¿Qué otras cosas se imaginaría Newton que el teléfono es capaz de hacer? Los prismas funcionan siempre. ¿Conjeturaría que el iPhone funcionaría para siempre tal como es, sin tener en cuenta que necesita ser recargado? Recuerde que lo sacamos de una época 100 años antes del nacimiento de Michael Faraday, por lo que carecía de una comprensión científica de la electricidad. Si el iPhone puede ser una fuente de luz sin fuego, ¿podría también transformar el plomo en oro?

Este es un problema que todos tenemos a la hora de imaginar las tecnologías del futuro. Si está lo suficientemente alejada de la tecnología que tenemos y entendemos hoy, entonces no conocemos sus limitaciones. Y si se vuelve indistinguible de la magia, nada de lo que se dice sobre ella se puede refutar.

Este es un problema que encuentro bastante cuando debato con la gente acerca de si debemos temer a la inteligencia general artificial, o IGA; la idea de que vamos a ser capaces de construir agentes autónomos que operan como entes en el mundo. Se me dice que no entiendo lo poderosa que será la IGA. Eso no es un argumento. Ni siquiera sabemos si va a llegar a existir. Me gustaría que existiera, esta ha sido siempre mi propia motivación para trabajar en robótica e inteligencia artificial. Pero la investigación moderna en IGA no marcha nada bien ni en ser general ni en lograr una entidad independiente con una existencia duradera. En realidad está mayoritariamente atascada en las mismas cuestiones sobre el razonamiento y el sentido común con las que la tecnología lleva lidiando desde hace más de 50 años. Todos los indicios que veo dicen que todavía no tenemos una idea real de cómo construir una. Sus propiedades son completamente desconocidas, por lo que retóricamente en seguida se convierte en mágica, poderosa sin límite.

Nada en el universo carece de límites. Así que cuidado con los argumentos acerca de una futura tecnología que es mágica, porque nunca pueden ser refutados. Son argumentos basados en la fe, sin base científica.

3. Desempeño frente a competencia

Todos usamos pistas sobre cómo la gente hace alguna tarea concreta para adivinar cuál será su desempeño en otra distinta. En una ciudad extranjera pedimos direcciones a un desconocido en la calle y responde con confianza y con direcciones que parecen tener sentido, así que deducimos que también podemos preguntarle sobre el sistema local para pagar cuando uno quiere coger un autobús.

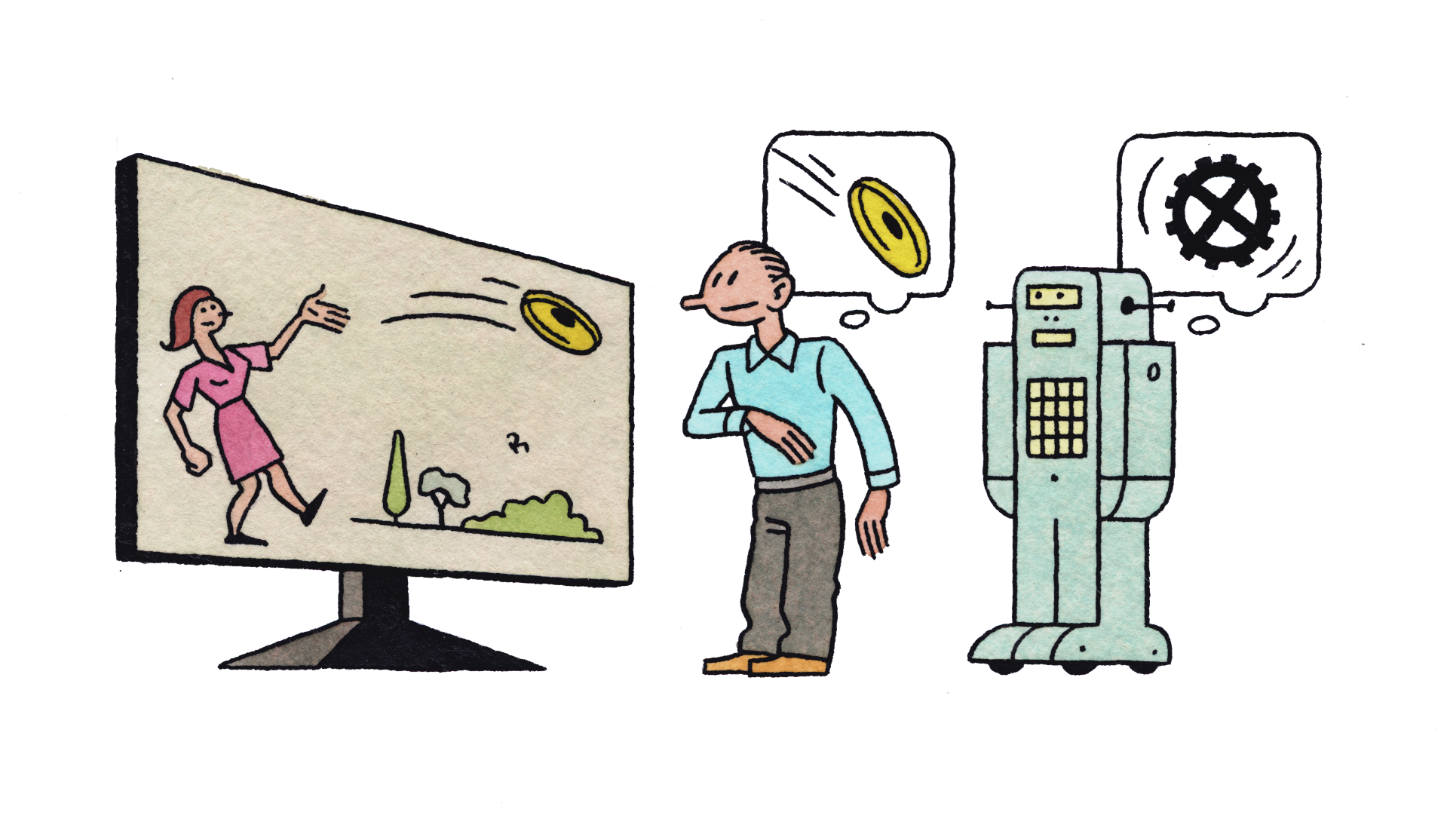

Ahora supongamos que una persona nos habla de una foto en la que aparece gente jugando a la pelota en un parque. Naturalmente asumimos que dicha persona puede responder preguntas como: ¿De qué color es la pelota? ¿Hasta dónde, aproximadamente, puede una persona lanzar una pelota? ¿Puede una persona comerse una pelota? ¿Aproximadamente cuántas personas juegan a la pelota a la vez? ¿Puede una persona de tres meses de edad jugar a la pelota? ¿Hace un tiempo adecuado para jugar a la pelota al aire libre?

Los ordenadores capaces de etiquetar imágenes como "personas que juegan a la pelota en un parque" no tienen ninguna posibilidad de responder a ninguna de esas preguntas (ver El software de Google dice que en esa foto sale "un grupo de jóvenes jugando al frisbee"). Aparte del hecho de que sólo pueden etiquetar más imágenes y no pueden responder preguntas en absoluto, no tienen ni idea de qué es una persona, que los parques suelen estar al aire libre, que la gente tiene distintas edades, que el tiempo es algo más que cómo hace que parezca una foto, etcétera.

Esto no significa que estos sistemas sean inútiles; son de gran valor para los motores de búsqueda. Pero aquí está lo que va mal. La gente oye que algún robot o algún sistema de inteligencia artificial ha conseguido hacer una tarea. A continuación, extienden esa capacidad concreta a toda una competencia asumible por una persona y generalizan esa capacidad humana al robot o sistema de inteligencia artificial.

Los robots y los sistemas de IA de hoy son increíblemente limitados en sus capacidades. Las generalizaciones de naturaleza humana no sirven.

4. Palabras maleta

Marvin Minsky (ver Adiós, Marvin Minsky, padre de la inteligencia artificial) bautizó a los términos que engloban varios significados como "palabras maleta". "Aprender" es una potente palabra maleta ya que puede referirse a muchos tipos diferentes de experiencia. Aprender a usar los palillos chinos es una experiencia muy diferente de aprender la melodía de una nueva canción. Y aprender a programar es una experiencia muy diferente de aprender a desenvolverte por una ciudad.

Cuando la gente oye que el aprendizaje automático está haciendo grandes avances en algún nuevo dominio, tienden a usar como modelo mental la forma en que una persona lo aprendería. Sin embargo, el aprendizaje automático es muy frágil y requiere mucha preparación por parte de investigadores o ingenieros humanos, programar con propósitos específicos, conjuntos de datos de entrenamiento para fines específicos y una estructura de aprendizaje personalizada para cada nuevo dominio de problemas. El aprendizaje automático actual no es en absoluto el aprendizaje esponjoso típico de los seres humanos, con el que hacen rápidos progresos en un nuevo dominio sin tener que ser alterados quirúrgicamente o construidos a propósito.

Del mismo modo, cuando la gente oye que una computadora pudo vencer al campeón mundial de ajedrez (en 1997, ver Kasparov admite que Deep Blue no hizo trampas al ajedrez 20 años después) o uno de los mejores jugadores del mundo del Go (en 2016, ver No se asuste si la IA de Google gana al campeón mundial de Go), tienden a pensar que está "jugando" el juego tal como lo haría un humano. Pero la realidad es que esos programas no tenían ni idea de lo que realmente era un juego, o incluso de que estaban jugando. También eran mucho menos adaptables. Cuando los seres humanos juegan un juego, un pequeño cambio en las reglas no los abate por completo. No pasa lo mismo con AlphaGo o Deep Blue.

Las palabras maleta confunden a la gente acerca de lo bien que rinden las máquinas en las tareas que la gente puede hacer. Esto se debe, en parte, a que los investigadores de IA y, peor aún, sus oficinas de prensa institucionales, están ansiosos por proclamar progresos a instancias de un concepto maleta. Lo importante aquí es "a instancias". Ese detalle pronto se pierde. Los titulares resaltan la palabra maleta y distorsionan la comprensión general de dónde está la inteligencia artificial y lo cerca que está de hacer más avances.

5. Crecimiento exponencial

Muchas personas están sufriendo de un caso agudo de "exponencialismo". Todo el mundo sabe algo sobre la Ley de Moore, que sugiere que los ordenadores mejoran a un ritmo preciso como el de un reloj. Lo que Gordon Moore dijo en realidad fue que el número de componentes que podrían caber en un microchip se duplicaría cada año. Durante 50 años eso fue cierto, aunque la constante temporal para duplicar gradualmente se alargó de un año a más de dos años. Y ahora el patrón está llegando a su fin (ver La ley de Moore llegará a su fin en 2021, según admiten los fabricantes de chips).

Duplicar los componentes en un chip ha hecho que los ordenadores dupliquen continuamente su velocidad. Y ha dado lugar a chips de memoria que cuadruplican en capacidad cada dos años. También ha logrado cámaras digitales con cada vez mejor resolución, y pantallas LCD que aumentan sus píxeles exponencialmente.

La razón por la que la Ley de Moore funcionó es porque se aplicaba a una abstracción digital de una pregunta de verdadero o falso. En cualquier circuito dado, ¿hay una carga o voltaje eléctrico o no? La respuesta sigue estando clara a medida que los componentes de los chips disminuyen su tamaño, hasta que interviene un límite físico y llegamos a componentes con tan pocos electrones que los efectos cuánticos empiezan a dominar. Ahí es donde nuestra tecnología de chips basados en silicio se encuentra ahora mismo.

Cuando la gente sufre de exponencialismo, pueden pensar que los exponenciales que utilizan para justificar un argumento van se van a mantener sin alteraciones. Pero la Ley de Moore y otras leyes aparentemente exponenciales pueden fallar porque, en su origen, no eran verdaderamente exponenciales.

Ya en la primera mitad de este siglo, cuando dirigía el Laboratorio de Informática e Inteligencia Artificial (CSAIL) del MIT y necesitaba ayudar a recaudar fondos para más de 90 grupos de investigación diferentes, traté de usar el aumento de memoria de los iPods para demostrar a los patrocinadores que las cosas estaban cambiando muy rápidamente. Estos son los datos sobre cuánto almacenamiento de música se obtenía en un iPod por menos de 350 euros:

|

año |

gigabytes |

|

2002 |

10 |

|

2003 |

20 |

|

2004 |

40 |

|

2006 |

80 |

|

2007 |

160 |

Entonces extrapolé algunos años y pregunté qué haríamos con toda esa memoria en nuestros bolsillos.

Si extrapoláramos hasta el día de hoy, esperaríamos que un iPod tuviera 160.000 gigabytes de memoria. Pero el iPhone actual de más alta gama (que cuesta mucho más de 350 euros) tiene solamente 256 gigabytes de memoria, menos que el doble de la capacidad del iPod de 2007. Este exponencial en particular se derrumbó de repente en cuanto la cantidad de memoria llegó ser lo suficientemente grande como para mantener la biblioteca de música de cualquier persona razonable y aplicaciones, fotos y vídeos. Los exponenciales pueden colapsar cuando se alcanza un límite físico, o cuando no hay razón económica para seguir aumentándolos.

Del mismo modo, hemos visto un aumento repentino en el rendimiento de los sistemas de inteligencia artificial gracias al éxito del aprendizaje profundo. Muchas personas parecen pensar que eso significa que seguiremos viendo aumentos exponenciales del desempeño de la IA de manera regular (ver La inteligencia artificial nos superará en todo dentro de 45 años, según los expertos). Pero el éxito del aprendizaje profundo llevaba 30 años en desarrollo y fue un evento aislado.

Eso no significa que no habrá más eventos aislados, en los que oscuros trabajos de investigación de repente alimenten un aumento rápido en el rendimiento de muchas aplicaciones de la inteligencia artificial. Pero no hay una "ley" que diga con qué frecuencia va a pasar.

6. Escenarios de Hollywood

La trama en muchas películas de ciencia ficción consiste en que el mundo es tal como es hoy, excepto por un nuevo giro. En El hombre bicentenario, Richard Martin, interpretado por Sam Neill, se sienta a desayunar y es atendido por un robot humanoide que camina y habla, interpretado por Robin Williams. Richard coge un periódico para leer durante el desayuno. ¡Un periódico! Impreso en papel. No un ordenador tablet, ni un podcast de un dispositivo tipo Amazon Echo, ni una conexión neural directa a internet.

Resulta que muchos investigadores y expertos en inteligencia artificial, especialmente aquellos pesimistas que se entregan a las predicciones sobre una máquina descontrolada que acaba matando a la humanidad, tienen una imaginación igual de pobre. Ignoran el hecho de que, si fuéramos capaces de construir tales dispositivos inteligentes, el mundo habría cambiado significativamente para entonces. No nos sorprendería de repente la existencia de tales superinteligencias. Evolucionarán tecnológicamente con el tiempo y nuestro mundo estará poblado por muchas otras inteligencias y ya tendremos mucha experiencia. Mucho antes de que haya superinteligencias malvadas que quieran deshacerse de nosotros, habrá máquinas algo menos inteligentes y menos beligerantes. Antes de eso, habrá máquinas realmente gruñonas. Antes de eso, máquinas bastante molestas. Y aún antes de ellas, máquinas arrogantes y desagradables. Cambiaremos nuestro mundo a lo largo del camino, ajustando tanto el entorno de las nuevas tecnologías como las nuevas tecnologías mismas. No estoy diciendo que no pueda haber desafíos. Estoy diciendo que no serán repentinos e inesperados, como mucha gente piensa.

7. Velocidad de implementación

Las nuevas versiones de software se implementan con mucha frecuencia en algunas industrias. Nuevas funciones para plataformas como Facebook aparecen casi cada hora. Muchas características nuevas, siempre y cuando hayan pasado las pruebas de integración, presentan muy pocos inconvenientes económicos si aparece un problema y la versión necesita ser retirada. Este es un ritmo al que Silicon Valley y los desarrolladores de software web se han acostumbrado. Funciona porque el coste marginal de implementar un nuevo código es prácticamente cero.

En cambio, la implementación de un hardware nuevo tiene unos costes importantes. Lo sabemos por nuestras propias vidas. Muchos de los coches que compramos ahora mismo no son autónomos y probablemente seguirán en las carreteras en el año 2040. Esto pone un límite inherente a la fecha en la que todos los coches serán autónomos. Si construimos una casa nueva hoy, esperamos que dure más de 100 años. El edificio en que vivo fue construido en 1904, y no es ni de lejos el más antiguo de mi barrio.

Los costes hacen que el hardware físico dure mucho tiempo, incluso cuando hay aspectos de alta tecnología, e incluso cuando tiene una misión existencial.

La fuerza aérea de los EEUU todavía vuela la variante B-52H del bombardero B-52. Esta versión fue introducida en 1961, con lo que tiene 56 años de antigüedad. El último fue construido en 1962, hace apenas 55 años. Actualmente se espera que estos aviones sigan volando hasta por lo menos 2040, y tal vez más; se habla de extender su vida a 100 años.

Frecuentemente veo equipos antiguos en fábricas de todo el mundo. Incluso veo PC ejecutando Windows 3.0, una versión lanzada en 1990. El mensaje es: si no está roto, no lo arregles. Esos PC y su software han estado ejecutando la misma aplicación, haciendo la misma tarea, de forma fiable durante más de dos décadas.

Casi todas las innovaciones en robótica e inteligencia artificial tardan muchísimo más tiempo en ser realmente implementadas de forma masiva de lo que la gente en el campo y fuera del campo imagina

El principal mecanismo de control en las fábricas, incluidas las nuevas en los EEUU, Europa, Japón, Corea y China, se basa en controladores lógicos programables, o PLC. Estos fueron introducidos en 1968 para reemplazar los relés electromecánicos. La "bobina" sigue siendo la principal unidad de abstracción utilizada hoy en día y los PLC están programados como si fueran una red de relés electromecánicos de 24 voltios. Todavía. Algunos de los cables directos han sido reemplazados por cables Ethernet. Pero no forman parte de una red abierta. En su lugar, son cables individuales, que van de punto a punto, incorporando físicamente el flujo de control (el orden en que se ejecutan los pasos) en estos controladores de automatización anticuados, nuevos a estrenar. Cuando se quiere cambiar el flujo de información o el flujo de control en la mayoría de las fábricas de todo el mundo, se necesitan semanas de consultores para averiguar qué hay, diseñar nuevas reconfiguraciones y luego equipos de especialistas para recablear y reconfigurar el hardware. Uno de los principales fabricantes de estos equipos recientemente me dijo que su objetivo es tres actualizaciones de software cada 20 años.

En principio, podría hacerse de manera diferente. En la práctica, no. Acabo de mirar en una lista de empleos, e incluso hoy mismo, Tesla Motors trata de contratar a técnicos de PLC en su fábrica de California (EEUU). Utilizarán la emulación de relés electromagnéticos en la producción del automóvil más capacitado que existe con inteligencia artificial.

Muchos investigadores y analistas de inteligencia artificial piensan que el mundo ya es digital, y que basta con introducir nuevos sistemas para generar cambios operativos inmediatos en el campo, en la cadena de suministro, en la fábrica, en el diseño de los productos. Nada más lejos de la verdad. Casi todas las innovaciones en robótica e inteligencia artificial tardan muchísimo más tiempo en ser realmente implementadas de forma masiva de lo que la gente en el campo y fuera del campo imagina.