Inteligencia Artificial

Este chip de 2.000 millones de dólares acelerará la inteligencia artificial

Nvidia ha presentado el Tesla P100, capaz de procesar datos 12 veces más rápido que la versión anterior. IBM, Dell y HP lo podrían incorporar a sus servidores a partir del próximo año

El campo de la inteligencia artificial ha experimentado una impresionante racha de progresos en los últimos años. El software reconoce imágenes y voz con gran precisión y ha logrado dominar algunos juegos extremadamente complejos. Ahora, la empresa cuyo hardware ha permitido gran parte de esos progresos ha creado un chip para seguir impulsándolo.

El pasado martes, Nvidia anunció un nuevo chip llamado Tesla P100 y diseñado para proporcionar mayor potencia al aprendizaje profundo. Esta técnica ha generado unos importantes avances recientes como el software AlphaGo de Google que venció al mejor jugador de Go del mundo el mes pasado (ver Cinco lecciones del histórico triunfo de AlphaGo sobre la inteligencia humana).

El aprendizaje profundo incluye el procesamiento de datos por grandes conjuntos de neuronas simuladas. El P100 podría ayudar a proporcionar más avances al posibilitar que los informáticos alimenten sus redes artificiales neuronales con mayores cantidades de datos o creen conjuntos más grandes de neuronas virtuales.

Las redes neuronales artificiales han existido desde hace décadas, pero el aprendizaje profundo sólo ha cobrado relevancia durante los últimos cinco años. Fue cuando los investigadores averiguaron que los chips originalmente diseñados para lidiar con los efectos gráficos de los videojuegos potenciaban la técnica. Los procesadores gráficos siguen siendo cruciales para el aprendizaje profundo, pero el CEO de Nvidia, Jen-Hsun Huang, asegura que ha llegado el momento de fabricar chips más personalizados para este uso.

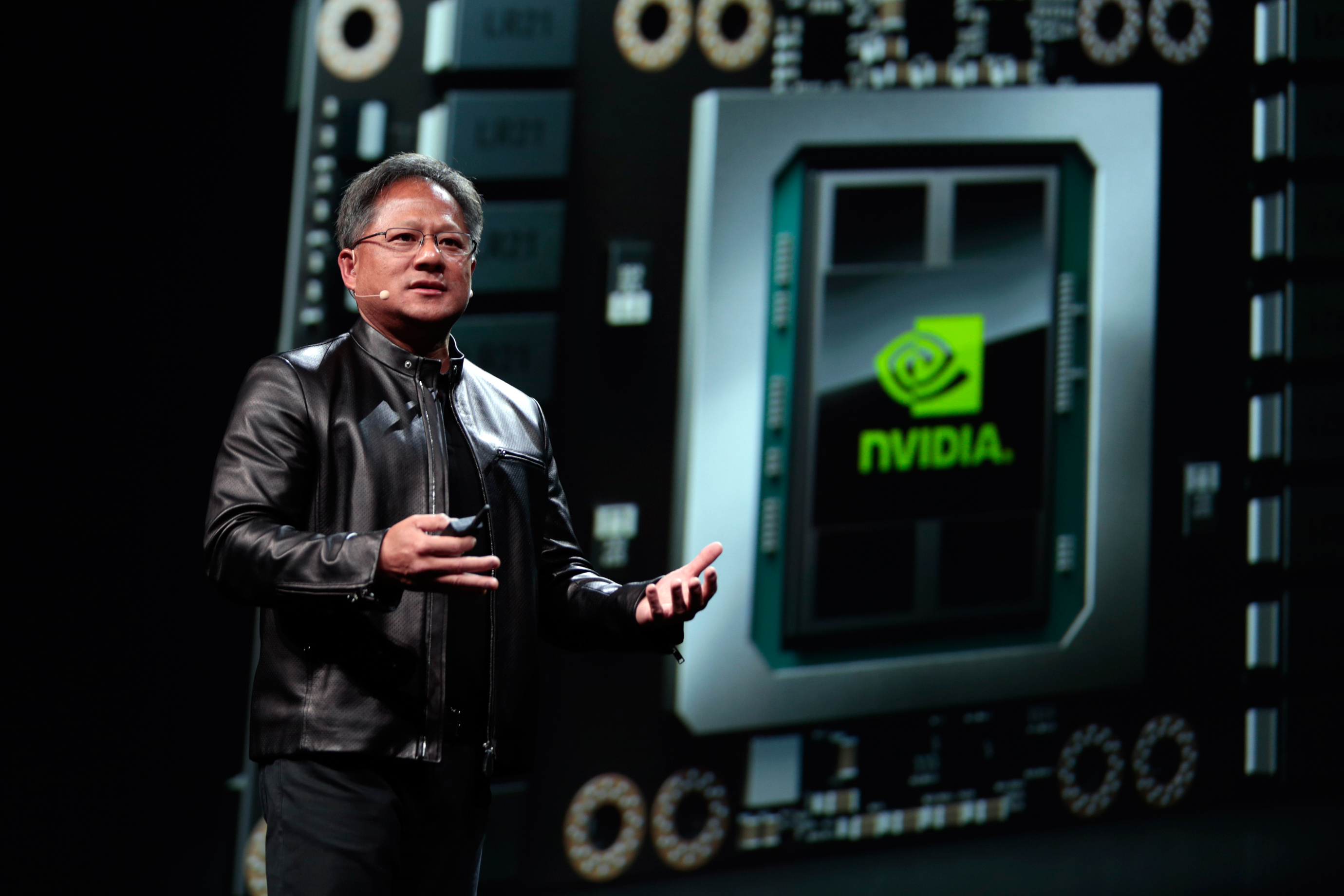

Foto: El CEO del fabricante de chips Nvidia, Jen-Hsun Huang, presenta un nuevo chip diseñado para dotar al software de aprendizaje de máquinas de mayores capacidades. Crédito: Nvidia (Flickr).

Foto: El CEO del fabricante de chips Nvidia, Jen-Hsun Huang, presenta un nuevo chip diseñado para dotar al software de aprendizaje de máquinas de mayores capacidades. Crédito: Nvidia (Flickr).

En un evento corporativo celebrado en San José (EEUU), Huang afirmó: "Por primera vez hemos diseñado una arquitectura [de procesamiento gráfico] dirigida a acelerar la inteligencia artificial y el aprendizaje profundo". Nvidia gastó más de 2.000 millones de dólares (unos 1.760 millones de euros) en labores de I+D para desarrollar el nuevo chip, según su CEO. Incluye un total de 15.000 millones de transistores, aproximadamente tres veces la cantidad que contienen los chips anteriores de Nvidia. Huang afirmó que una red neuronal artificial alimentada por el nuevo chip podría aprender de los datos entrantes a una velocidad 12 veces mayor que con el uso del mejor chip anterior de Nvidia.

Investigadores de aprendizaje profundo de Facebook, Microsoft y otras empresas a las que Nvidia concedió un acceso temprano al nuevo chip han dicho que esperan que la nueva versión acelere sus progresos al permitirles que trabajen con mayores conjuntos de neuronas.

El trabajador en aprendizaje profundo en la empresa china de búsquedas Baidu Bryan Catanzero explica: "Creo que podremos lograr una solución bastante mejor de lo que hemos podido conseguir en el pasado, como unas 30 veces mejor". Aumentar el tamaño de las redes neuronales ya ha permitido dar grandes saltos en la inteligencia del software. Por ejemplo, el año pasado Microsoft logró desarrollar un software que gana a los humanos a la hora de reconocer los objetos dentro de las imágenes al crear una red neuronal mucho más grande.

Huang detalló que el nuevo chip ya está en producción y que espera que las empresas de computación en la nube empiecen a utilizarlo este año. Se espera que IBM, Dell y HP lo comercialicen dentro de sus servidores a partir del próximo año.

También desveló un ordenador especial para investigadores de aprendizaje profundo que aloja ocho chips P100 con chips de memoria y discos duros de memoria flash. Unos destacados grupos académicos, de prestigiosos centros como la Universidad de California en Berkeley, la Univseridad de Stanford, la Universidad de Nueva York y el Instituto Tecnológico de Massachusetts (todos en EEUU), recibirán modelos de ese ordenador conocido como el DXG-1, que también se comercializará por un precio de 129.000 dólares (unos 114.000 euros).