Todos creen que lo saben pero nadie se pone de acuerdo. Y eso es un problema.

Groserías en Internet, insultos y otros desacuerdos no tan pequeños que alteran el mundo

La IA es sexy, la IA es guay. La IA está afianzando la desigualdad, trastornando el mercado laboral y destrozando la educación. La IA es una atracción de parque temático, la IA es un truco de magia. La IA es nuestro último invento, la IA es una obligación moral. La IA es la palabra de moda de la década, la IA es jerga de marketing de 1955. La IA se parece a los humanos, la IA es extraterrestre. La IA es superinteligente y es más tonta que una mata de habas. El auge de la IA impulsará la economía, pero la burbuja de la IA está a punto de estallar. La IA aumentará la abundancia y permitirá a la humanidad florecer al máximo en el universo. La IA nos matará a todos…

¿De qué demonios habla todo el mundo?

La inteligencia artificial es la tecnología más candente de nuestro tiempo. Pero… ¿qué es? Parece una pregunta estúpida, pero nunca ha sido tan urgente. La respuesta es breve: La IA es un término que engloba un conjunto de tecnologías que hacen que los ordenadores hagan cosas que se considera que requieren inteligencia cuando las hacen las personas. Pensemos en reconocer caras, entender el habla, conducir coches, escribir frases, responder preguntas o crear imágenes. Pero incluso esa definición contiene multitud de cosas.

Y ahí está el problema. ¿Qué significa que las máquinas entiendan el habla o escriban una frase? ¿Qué tipo de tareas podríamos pedirles? ¿Y hasta qué punto deberíamos confiar en que las máquinas las hagan?

A medida que esta tecnología pasa del prototipo al producto cada vez más deprisa, se han convertido en preguntas para todos nosotros. Pero, atención: spoiler, no tengo las respuestas. Ni siquiera puedo decirte qué es la IA. La gente que la hace tampoco lo sabe, en realidad. "Este tipo de preguntas son lo bastante importantes como para que todo el mundo sienta que puede opinar", responde Chris Olah, científico jefe del laboratorio de la empresa de inteligencia artificial Anthropic, con sede en San Francisco. "También creo que puedes discutir sobre esto todo lo que quieras y no hay pruebas que te contradigan ahora mismo".

Pero si estás dispuesto a abrocharte el cinturón y venir a dar una vuelta, puedo contarte por qué nadie lo sabe realmente, por qué todo el mundo parece estar en desacuerdo y por qué harías bien en estar preocupado por ello.

Empecemos con una broma de mal gusto:

En 2022, a mitad del primer episodio de Mystery AI Hype Theater 3000, un podcast en el que las cáusticas copresentadoras Alex Hanna y Emily Bender se divierten clavando "las agujas más afiladas" en algunas de las vacas sagradas más infladas de Silicon Valley, se dedican a ridiculizar una publicación de 12.500 palabras de Blaise Agüera y Arcas, vicepresidente de ingeniería de Google, titulada ¿Pueden las máquinas aprender a comportarse?. Agüera y Arcas defiende que la IA puede entender conceptos de forma análoga a como los entienden los humanos, como los valores morales. En resumen, que quizá se pueda enseñar a las máquinas a comportarse.

Hanna y Bender no están de acuerdo. Deciden sustituir el término "inteligencia artificial" por "matemáticas matemáticas", es decir, muchas, muchas matemáticas. Con ese irreverente cambio pretenden derrumbar lo que consideran grandilocuencia y antropomorfismo en el texto referido. Muy pronto, Hanna, socióloga y directora de investigación del Distributed AI Research Institute, y Bender, lingüista computacional de la Universidad de Washington (y célebre crítica en Internet de las exageraciones de la industria tecnológica), abren un abismo entre lo que Agüera y Arcas quieren decir y cómo eligen oírlo.

"¿Cómo deben ser moralmente responsables las IA, sus creadores y sus usuarios?", se preguntan Agüera y Arcas.

"¿Qué responsabilidad moral deben tener las matemáticas?", se pregunta Bender.

"Aquí hay un error de categoría", añade. Hanna y Bender no sólo rechazan lo que dice Agüera y Arcas, sino que afirman que no tiene sentido. "¿Podemos parar esto de hablar de 'la IA' o 'las IAs' como si fueran individuos?", pide Bender.

Podría parecer que hablan de cosas distintas, pero no es así. Ambas partes hablan de los grandes modelos lingüísticos (LLM, por sus siglas en inglés), la tecnología que está detrás del actual auge de la IA. Lo que ocurre es que la forma de hablar de IA está más polarizada que nunca. En mayo, el consejero delegado de OpenAI, Sam Altman, se bromeó con la última actualización de GPT-4, el modelo insignia de su empresa, tuiteando: "A mí me parece magia".

Hay mucho camino entre las matemáticas y la magia.

La IA tiene acólitos, que creen firmemente en el poder actual de la tecnología y en sus inevitables mejoras futuras. Dicen que la inteligencia artificial general está a la vista y que la superinteligencia viene detrás. Y también tiene herejes, que desprecian estas afirmaciones y las tachan de galimatías místico.

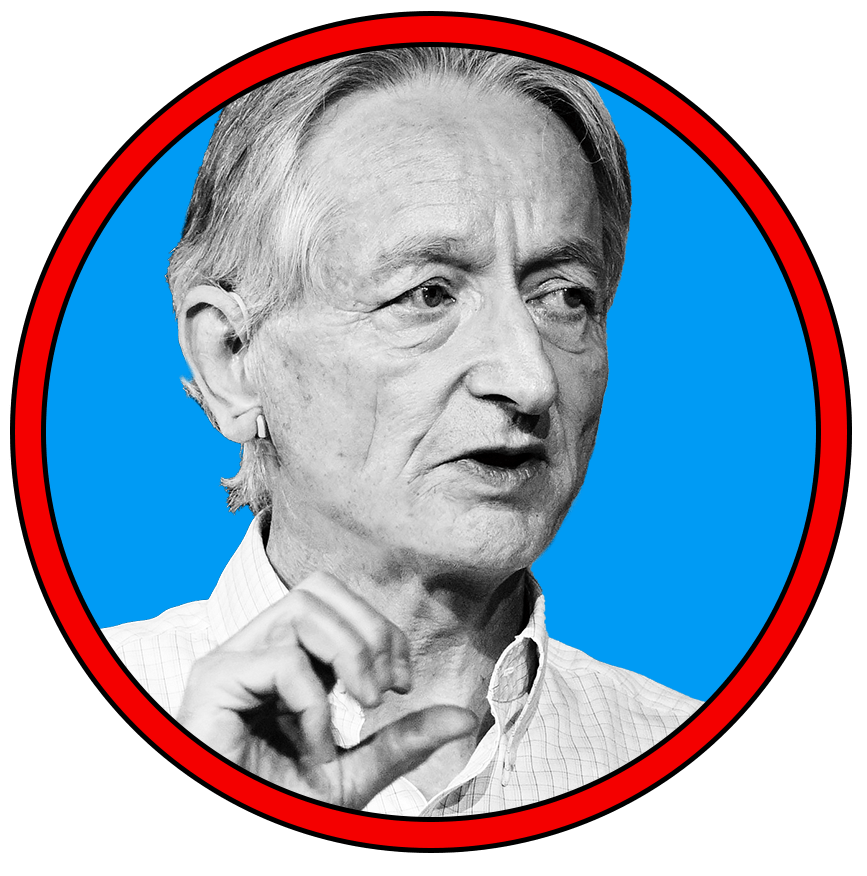

La narrativa popular está formada por un panteón de grandes nombres, desde los jefes de marketing de las grandes tecnológicas, como Sundar Pichai y Satya Nadella, hasta los líderes de la industria, como Elon Musk y Altman, pasando por informáticos famosos, como Geoffrey Hinton. A veces, estos promotores y catastrofistas son la misma cosa, y nos dicen que la tecnología es tan buena que es mala.

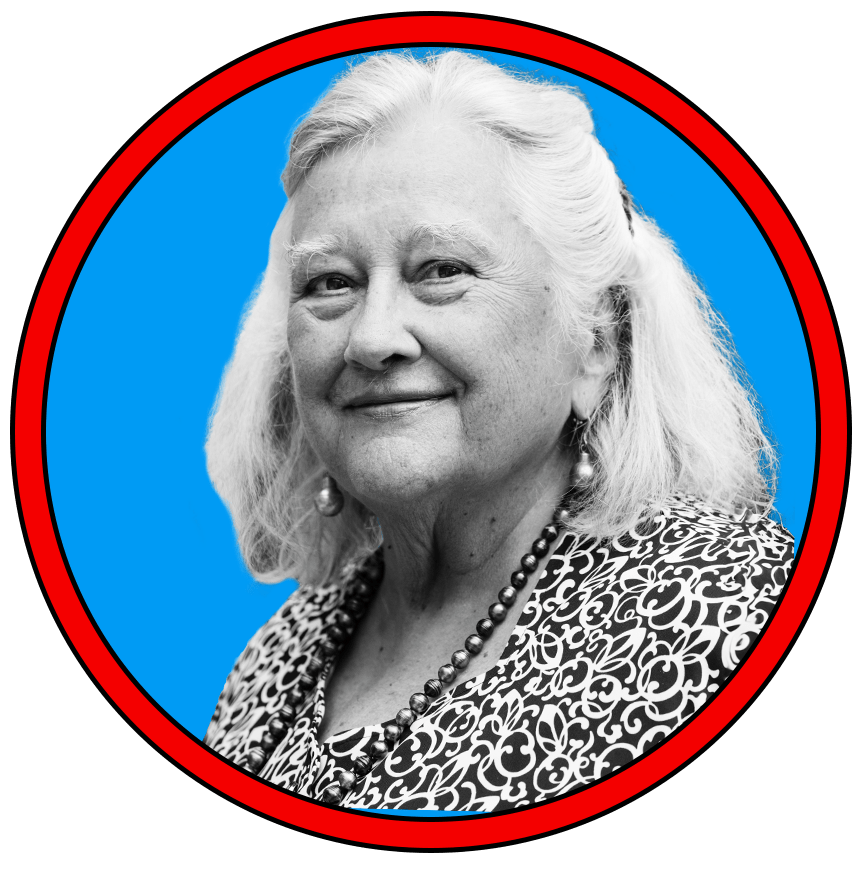

Al mismo tiempo que se ha disparado la publicidad sobre la IA, ha surgido un grupo de presión que se opone a ella, dispuesto a rebatir sus ambiciosas y a menudo descabelladas afirmaciones. En esta dirección se sitúan una serie de investigadores, como Hanna y Bender, y también críticos declarados de la industria, como el influyente informático y exmiembro de Google Timnit Gebru y el científico cognitivo de la Universidad de Nueva York Gary Marcus. Todos ellos con un coro de seguidores discutiendo entre ellos.

En resumen, la IA ha llegado a significar todo para todo el mundo, dividiendo el campo en bandos. Y da la sensación de que cada bando habla sobre todo para intentar quitar la razón al otro.

Puede que todo esto te parezca una tontería o un fastidio. Pero, dado el poder y la complejidad de estas tecnologías —que ya se utilizan para determinar cuánto pagamos de seguro, cómo buscamos información, cómo hacemos nuestro trabajo, etc.—, ya es hora de que al menos nos pongamos de acuerdo sobre de qué estamos hablando.

Sin embargo, en todas las conversaciones que he mantenido con personas que están a la vanguardia de esta tecnología, nadie me ha dado una respuesta clara sobre qué es exactamente lo que están construyendo. (Nota al margen: este artículo se centra en el debate sobre la IA en EE UU y Europa, en gran medida, porque muchos de los laboratorios de IA mejor financiados y más avanzados están allí. Pero, por supuesto, también se están llevando a cabo importantes investigaciones en otros lugares, en países con sus propias y variadas perspectivas sobre la IA, especialmente en China). En parte, se debe al ritmo de desarrollo. Pero la ciencia también está muy abierta. Los LLM actuales pueden hacer cosas asombrosas. Lo que ocurre es que este campo no logra ponerse de acuerdo sobre lo que realmente ocurre bajo el capó.

Estos modelos están entrenados para completar frases. Parecen capaces de hacer muchas más cosas: desde resolver problemas matemáticos de bachillerato hasta escribir código informático, aprobar exámenes de Derecho o componer poemas. Cuando una persona hace estas cosas, lo tomamos como un signo de inteligencia. ¿Y cuándo lo hace un ordenador? ¿Es suficiente la apariencia de inteligencia?

Estas cuestiones están en el centro de lo que entendemos por "inteligencia artificial", un término sobre el que se lleva discutiendo décadas. Pero el discurso en torno a la IA se ha vuelto más enconado con el auge de los LLM que pueden imitar la forma en que hablamos y escribimos con un realismo emocionante/escalofriante (táchese lo que no proceda).

Hemos construido máquinas con un comportamiento similar al humano, pero no hemos abandonado el hábito de imaginar una mente humana detrás de ellas. Esto conduce a evaluaciones exageradas de lo que la IA puede hacer; endurece las reacciones viscerales hasta convertirlas en posturas dogmáticas, y participa en las guerras culturales más amplias entre tecnooptimistas y tecnoescépticos.

A este caldo de cultivo de la incertidumbre hay que añadir un montón de bagaje cultural, desde la ciencia ficción con la que apuesto a que crecieron muchos miembros del sector hasta ideologías mucho más malignas que influyen en nuestra forma de pensar sobre el futuro. Dada esta embriagadora mezcla, las discusiones sobre la IA ya no son simplemente académicas (y quizá nunca lo hayan sido). La IA enciende las pasiones de la gente y hace que personas hechas y derechas se insulten.

"Ahora mismo no se está en un lugar intelectualmente sano", dice Gary Marcus sobre este debate. Durante años, Marcus ha señalado los defectos y limitaciones del aprendizaje profundo, la tecnología que lanzó la IA a la corriente dominante, impulsando todo, desde los LLM hasta el reconocimiento de imágenes y los coches autoconducidos. Su libro de 2001 La mente algebraica sostenía que las redes neuronales, la base sobre la que se construye el aprendizaje profundo, son incapaces de razonar por sí mismas. (Lo obviaremos por ahora, pero volveré sobre ello más adelante y veremos hasta qué punto importa una palabra como "razonamiento" en una frase como esta).

Marcus dice que ha intentado que Hinton —que el año pasado hizo públicos sus temores existenciales sobre la tecnología que ayudó a inventar— participe en un debate adecuado sobre la calidad real de los LLM. "No quiere hacerlo", dice Marcus. "Me llama tonto". (Habiendo hablado con Hinton sobre Marcus en el pasado, puedo confirmarlo: "Está claro que ChatGPT entiende las redes neuronales mejor que él", me dijo Hinton el año pasado). Marcus también provocó ira cuando escribió un ensayo titulado El aprendizaje profundo está chocando contra un muro. Altman le respondió con un tuit: "Dame la confianza de un escéptico del aprendizaje profundo mediocre".

Al mismo tiempo, el hecho de hacerse oír a convertido a Marcus en su propia marca y le ha valido una invitación para sentarse junto a Altman y declarar el año pasado ante el comité de supervisión de la IA del Senado de Estados Unidos.

Y por eso todas estas peleas importan más que las rencillas habituales de Internet. Claro, hay grandes egos y enormes sumas de dinero en juego. Pero más que eso, estas disputas importan cuando los jefes de Estado y los legisladores convocan a los líderes de la industria y a los científicos de opinión para que expliquen qué es esta tecnología y qué puede hacer (y lo asustados que deberíamos estar). Importan cuando esta tecnología se incorpora al software que utilizamos a diario, desde los motores de búsqueda a las aplicaciones de procesamiento de textos o los asistentes del teléfono. La IA no va a desaparecer. Pero si no sabemos lo que nos venden, ¿quién es el incauto?

"Es difícil pensar en otra tecnología en la historia sobre la que se pueda tener un debate así: un debate sobre si está en todas partes o en ninguna", escriben Stephen Cave y Kanta Dihal en Imagining AI, una colección de ensayos de 2023 sobre cómo las diferentes creencias culturales dan forma a las opiniones de la gente sobre la inteligencia artificial. "Que se pueda mantener sobre la IA es un testimonio de su cualidad mítica".

Por encima de todo, la IA es una idea, un ideal conformado tanto por visiones del mundo y tropos de ciencia ficción como por las matemáticas y la informática. Averiguar de qué estamos hablando cuando hablamos de IA aclarará muchas cosas. No nos pondremos de acuerdo, pero llegar a un acuerdo sobre lo que es la IA sería un buen punto de partida para empezar a hablar de lo que debería ser.

¿Por qué se pelean todos?

A finales de 2022, poco después de que OpenAI lanzara ChatGPT, empezó a circular por Internet un nuevo meme que captaba la rareza de esta tecnología mejor que ninguna otra cosa. En la mayoría de las versiones, un monstruo lovecraftiano llamado Shoggoth, todo tentáculos y globos oculares, sostiene un emoji de cara sonriente como si quisiera ocultar su verdadera naturaleza. ChatGPT se presenta como humano y accesible en su juego de palabras conversacional, pero tras esa fachada se esconden complejidades y horrores insondables. ("Era una cosa terrible e indescriptible, más grande que cualquier tren subterráneo: un conglomerado informe de burbujas protoplasmáticas", escribió H.P. Lovecraft sobre el Shoggoth en su novela de 1936 En las montañas de la locura).

Durante años, uno de los referentes más conocidos de la IA en la cultura pop fue Terminator, afirma Kanta Dihal. Pero al poner ChatGPT en línea de forma gratuita, OpenAI ofreció a millones de personas una experiencia de primera mano de algo diferente. "La IA siempre ha sido un concepto muy vago que puede expandirse infinitamente para abarcar todo tipo de ideas", afirma. Pero ChatGPT hizo tangibles esas ideas: "De repente, todo el mundo tiene algo concreto a lo que referirse". ¿Qué es la IA? Para millones de personas la respuesta ahora es ChatGPT.

La industria de la IA está vendiendo mucho esa cara sonriente. Fíjese en cómo The Daily Show se burló recientemente del bombo publicitario expresado por los líderes del sector. El vicepresidente de Silicon Valley, Marc Andreessen: "Esto tiene el potencial de hacer la vida mucho mejor... Creo que, sinceramente, es una apuesta segura". Altman: "Odio parecer un utópico de la tecnología, pero el aumento de la calidad de vida que puede ofrecer la IA es extraordinario." Pichai: "La IA es la tecnología más relevante en la que está trabajando la humanidad. Más relevante que el fuego".

Jon Stewart [cómico y actor estadounidense en el programa 'The Daily Show' que presenta]: "¡Sí, y un carajo como el fuego!"

Pero como señala el meme, ChatGPT es una máscara amigable. Detrás hay un monstruo llamado GPT-4, un gran modelo lingüístico construido a partir de una vasta red neuronal que ha ingerido más palabras de las que la mayoría de nosotros podríamos leer en mil vidas. Durante el entrenamiento, que puede durar meses y costar decenas de millones de dólares, a estos modelos se les encomienda la tarea de rellenar espacios en blanco en frases extraídas de millones de libros y una fracción significativa de Internet. Hacen esta tarea una y otra vez. En cierto sentido, se les entrena para que sean máquinas de autocompletar sobrealimentadas. El resultado es un modelo que ha convertido gran parte de la información escrita del mundo en una representación estadística de qué palabras tienen más probabilidades de seguir a otras palabras, capturada a través de miles y miles de millones de valores numéricos.

Son matemáticas, muchísimas matemáticas. Nadie lo discute. Pero… ¿se trata sólo de eso? ¿O estas complejas matemáticas codifican algoritmos capaces de algo parecido al razonamiento humano o a la formación de conceptos?

Muchos de los que responden afirmativamente a esta pregunta creen que estamos cerca de descubrir algo llamado inteligencia general artificial, o AGI, una hipotética tecnología futura capaz de realizar una amplia gama de tareas tan bien como los humanos. Algunos de ellos incluso han puesto sus miras en lo que llaman superinteligencia, una tecnología de ciencia ficción que puede hacer cosas mucho mejor que los humanos. Ese grupo cree que la IA cambiará drásticamente el mundo, pero ¿con qué fin? Ése es otro punto de tensión. Podría solucionar todos los problemas del mundo o provocar su perdición.

Hoy en día, la inteligencia artificial aparece en las declaraciones de intenciones de los principales laboratorios de IA del mundo. Pero el término se inventó en 2007 como un intento de inyectar un poco de dinamismo a un campo que entonces era más conocido por las aplicaciones que leían la escritura a mano en los recibos de depósitos bancarios o recomendaban la compra del próximo libro. La idea era recuperar la visión original de algo capaz de hacer cosas parecidas a las de los humanos.

En realidad, era una aspiración más que otra cosa, me dijo el año pasado el cofundador de Google DeepMind Shane Legg, que acuñó el término: "No tenía una definición especialmente clara".

AGI se convirtió en la idea más controvertida de la IA. Algunos hablaban de ella como la próxima gran novedad: AGI era IA pero, ya se sabe, mucho mejor. Otros afirmaban que el término era tan vago que carecía de sentido. "AGI era poco más que una mal nombre", me dijo Ilya Sutskever, antes de dimitir como científico jefe de OpenAI.

Pero los LLM, y ChatGPT en particular, lo cambiaron todo. AGI pasó de ser un nombre feo a ser un sueño de marketing.

Lo que nos lleva a lo que creo que es una de las disputas más ilustrativas del momento, una que establece los lados de la discusión y lo que está en juego.

Ver la magia en la máquina

Unos meses antes del lanzamiento público del gran modelo lingüístico GPT-4 de OpenAI, en marzo de 2023, la empresa compartió una versión preliminar con Microsoft, que quería utilizar el nuevo modelo para renovar su motor de búsqueda Bing.

Por aquel entonces, Sebastian Bubeck estudiaba las limitaciones de los LLM y se mostraba algo escéptico sobre sus capacidades. En concreto, Bubeck, vicepresidente de investigación de IA generativa de Microsoft Research en Redmond (Washington), había estado intentando, sin éxito, que la tecnología resolviera problemas matemáticos de secundaria. Cosas como: x - y = 0; ¿qué son x e y? "Mi creencia era que el razonamiento era un cuello de botella, un obstáculo", explica. "Pensaba que haría falta hacer algo fundamentalmente distinto para superar ese obstáculo".

Entonces llegó a sus manos el modelo GPT-4. Lo primero que hizo fue probar los problemas matemáticos. "El modelo lo clavó", dice. "Desde la perspectiva de 2024, por supuesto que GPT-4 puede resolver ecuaciones lineales, pero entonces era una locura: GPT-3 no podía hacer eso".

Pero la verdadera epifanía para Bubeck llegó cuando empujó a GPT-4 a hacer algo nuevo.

Lo que ocurre con los problemas matemáticos de secundaria es que están por todas partes en Internet, y GPT-4 podía simplemente haberlos memorizado. "¿Cómo se estudia un modelo que puede haber visto todo lo que han escrito los seres humanos?", se pregunta Bubeck. Su respuesta fue probar GPT-4 en una serie de problemas que él y sus colegas consideraban novedosos.

Jugando con Ronen Eldan, matemático de Microsoft Research, Bubeck pidió a GPT-4 que diera, en verso, una prueba matemática de que hay un número infinito de números primos.

He aquí un fragmento de la respuesta de GPT-4: “If we take the smallest number in S that is not in P / And call it p, we can add it to our set, don’t you see? / But this process can be repeated indefinitely. / Thus, our set P must also be infinite, you’ll agree.” ["Si tomamos el número más pequeño de S que no está en P / Y lo llamamos p, podemos añadirlo a nuestro conjunto, ¿no lo ves? / Pero este proceso puede repetirse indefinidamente. / Por lo tanto, nuestro conjunto P también debe ser infinito, estarás de acuerdo"].

Bonito, ¿verdad? Pero Bubeck y Eldan pensaron que era mucho más. "Estábamos en esta oficina", explica Bubeck. "Los dos nos caímos de la silla. No podíamos creer lo que estábamos viendo. Era tan creativo y tan… ¿sabes? diferente".

El equipo de Microsoft también consiguió que GPT-4 generara el código necesario para añadir un cuerno a una caricatura de un unicornio dibujada en Latex, un programa de procesamiento de textos. Bubeck cree que esto demuestra que el modelo podía leer el código Latex existente, entender lo que representaba e identificar dónde debía ir el cuerno.

"Hay muchos ejemplos, pero unos pocos son pruebas fehacientes de razonamiento", afirma, ya que el razonamiento es un componente esencial de la inteligencia humana.

Bubeck, Eldan y un equipo de otros investigadores de Microsoft describieron sus hallazgos en un artículo que titularon Destellos de inteligencia general artificial: "Creemos que la inteligencia de GPT-4 señala un verdadero cambio de paradigma en el campo de la informática y más allá". Cuando Bubeck compartió el artículo en Internet, tuiteó: "Es hora de afrontarlo, se están produciendo destellos de #AGI".

Este artículo sobre los destellos no tardó en hacerse tristemente célebre y convertirse en piedra de toque para los defensores de la IA. Agüera y Arcas y Peter Norvig, antiguo director de investigación de Google y coautor de Artificial Intelligence: A Modern Approach, quizá el libro de texto sobre IA más popular del mundo, coescribieron un artículo titulado "La Inteligencia Artificial General ya está aquí". Publicado en Noema, una revista respaldada por un think tank de Los Ángeles llamado Instituto Berggruen, su argumento utiliza el artículo de los destellos de la IA como punto de partida: "La Inteligencia Artificial General (IAG) significa muchas cosas diferentes para diferentes personas, pero las partes más importantes de la misma ya han sido alcanzadas por la actual generación de grandes modelos de lenguaje de IA avanzada", escribieron. "Dentro de unas décadas, serán reconocidos como los primeros ejemplos reales de AGI".

Desde entonces, la exageración no ha dejado de crecer. Leopold Aschenbrenner, que por aquel entonces era investigador de OpenAI y se centraba en la superinteligencia, me dijo el año pasado: "El progreso de la IA en los últimos años ha sido extraordinariamente rápido. Hemos aplastado todos los puntos de referencia, y ese progreso continúa sin cesar. Pero no se detendrá ahí. Vamos a tener modelos sobrehumanos, modelos mucho más inteligentes que nosotros". (Fue despedido de OpenAI en abril porque, según él, planteó problemas de seguridad sobre la tecnología que estaba construyendo y "molestó a algunos". Desde entonces ha creado un fondo de inversión en Silicon Valley).

En junio, Aschenbrenner publicó un manifiesto de 165 páginas en el que afirmaba que la IA superará a los licenciados universitarios en "2025/2026" y que "tendremos superinteligencia, en el verdadero sentido de la palabra" a finales de la década. Pero otros miembros del sector se burlan de tales afirmaciones. Cuando Aschenbrenner tuiteó un gráfico para mostrar la velocidad a la que pensaba que la IA seguiría mejorando, teniendo en cuenta lo rápido que había mejorado en los últimos años, el inversor tecnológico Christian Keil replicó que, siguiendo la misma lógica, su hijo, que había duplicado su tamaño desde que nació, pesaría 7,5 billones de toneladas a los 10 años.

No es de extrañar que Destellos de AGI se haya convertido en sinónimo de exageración. "Creo que se dejaron llevar", dice Marcus refiriéndose al equipo de Microsoft. "Se entusiasmaron, en plan '¡eh, hemos encontrado algo! ¡Es increíble!' y no lo consultaron con la comunidad científica". Bender se refiere al artículo como una "novela de ficción".

No sólo era provocativo afirmar que el comportamiento de GPT-4 mostraba signos de AGI, sino que Microsoft, que utiliza GPT-4 en sus propios productos, tiene un claro interés en promocionar las capacidades de la tecnología. "Este documento es una patraña de marketing disfrazada de investigación", publicó un director de tecnología en LinkedIn.

Algunos también consideraron que la metodología del artículo era errónea. Sus pruebas son difíciles de verificar porque proceden de interacciones con una versión de GPT-4 que no estaba disponible fuera de OpenAI y Microsoft. La versión pública tiene límites que restringen las capacidades del modelo, admite Bubeck. Esto hizo imposible que otros investigadores pudieran recrear sus experimentos.

Un grupo intentó recrear el ejemplo del unicornio con un lenguaje de programación llamado Processing, que GPT-4 también puede utilizar para generar imágenes. Descubrieron que la versión pública de GPT-4 podía producir un unicornio aceptable, pero no voltear o girar la imagen 90 grados. Puede parecer una diferencia pequeña, pero estas cosas importan de verdad cuando se afirma que la capacidad de dibujar un unicornio es un signo de AGI.

La clave de los ejemplos del artículo, incluido el del unicornio, es que Bubeck y sus colegas creen que son ejemplos genuinos de razonamiento creativo. Esto significa que el equipo tenía que estar seguro de que los ejemplos de estas tareas, o de otras muy parecidas, no estaban incluidos en ningún lugar de los vastos conjuntos de datos que OpenAI acumuló para entrenar su modelo. De lo contrario, los resultados podrían interpretarse como casos en los que GPT-4 reproducía patrones que ya había visto.

Imagina que la isleña dice ahora que ha construido una catapulta de coco y le pide al pulpo que construya una también y le diga lo que piensa. El pulpo no puede hacerlo. Sin saber a qué se refieren en la superficie esas palabras, no podrá seguir las instrucciones de la isleña. Tal vez adivine una respuesta: "¡Vale, buena idea!" La isleña probablemente interpretará que su interlocutor ha entendido el mensaje. Pero, si es así, estará viendo significado donde no lo hay. Por último, imaginemos que la isleña es atacada por un oso y pide ayuda a través de la línea. ¿Qué puede hacer el pulpo con estas palabras?

Bender y Koller creen que así es como aprenden los LLM y por qué son limitados. "El experimento mental muestra por qué este camino no nos va a llevar a una máquina que entienda nada", mantiene Bender. "El asunto con el pulpo es que le hemos dado sus datos de entrenamiento, las conversaciones entre esas dos personas, y ya está. Pero si surge algo no será capaz de resolverlo porque no lo ha entendido".

En el otro artículo por el que se conoce a Bender, On the Dangers of Stochastic Parrots (Sobre los peligros de los loros estocásticos), ella y otros coautores sostienen que las empresas que fabrican los LLM ignoran una serie de problemas. Entre ellos figuran el enorme gasto computacional de su creación y su impacto medioambiental; el lenguaje racista, sexista y abusivo que los modelos afianzan y, en general, los riesgos de construir un sistema que podría engañar a la gente "cosiendo al azar secuencias de formas lingüísticas... según información probabilística sobre cómo se combinan, pero sin ninguna referencia al significado; es decir, un loro estocástico".

A la dirección de Google le gustó el artículo y el conflicto resultante obligó a dos de las personas que lo firmaban junto con Bender, Timnit Gebru y Margaret Mitchell, a abandonar la empresa, en donde eran responsables del equipo de Ética de la IA. También hizo que "loro estocástico" se convirtiera en un calificativo popular para los LLM y puso a Bender en la diana de los insultos.

La conclusión para Bender y para muchos investigadores de ideas afines es que el campo se ha dejado engañar por humo y espejos: "Creo que les llevan a imaginar entidades pensantes autónomas que pueden tomar decisiones por sí mismas y, en última instancia, ser el tipo de cosa que realmente podría rendir cuentas de esas decisiones".

Bender, que siempre ha sido lingüista, ni siquiera utiliza el término IA "sin comillas", me explica. En última instancia, para ella es una palabra de moda de las grandes tecnológicas que distrae la atención de los muchos perjuicios asociados. "Ahora estoy en el candelero. Me preocupan estos temas y el tema de moda se ha interpuesto en mi camino".

¿Pruebas extraordinarias?

Agüera y Arcas llama a personas como Bender "negacionistas de la IA", dando a entender que nunca aceptarán lo que él da por sentado. La postura de Bender es que las afirmaciones extraordinarias requieren pruebas extraordinarias, de las que no disponemos.

Y hay gente que busca esas pruebas y que, hasta que no encuentren algo claro, ya sean destellos, loros estocásticos o algo intermedio, prefieren no tomar partido. Es el bando de los que esperan.

Como me dice Ellie Pavlick, que estudia las redes neuronales en la Universidad de Brown (EE UU): "Para algunas personas es ofensivo sugerir que la inteligencia humana podría recrearse mediante este tipo de mecanismos".

Y añade: "La gente tiene creencias muy arraigadas sobre este tema, casi parece religioso. Por otro lado, hay gente que tiene un poco de complejo de Dios. Por eso también les ofende que se les sugiera que no pueden hacerlo".

En última instancia, Pavlick es agnóstica. Dice que es científica y que seguirá la pista de la ciencia. Pone los ojos en blanco ante las afirmaciones más descabelladas, pero cree que está ocurriendo algo emocionante. "Ahí es donde discrepo de Bender y Koller. Creo que hay algunos destellos, quizá no de AGI, pero sí de algo que no esperábamos encontrar", me explica.

El problema es ponerse de acuerdo sobre cuáles son esas cosas emocionantes y por qué lo son. Con tanto hype es fácil ser cínico.

Los investigadores como Bubeck parecen mucho más serenos cuando se les deja explicarse. Cree que estas luchas internas hacen que se pierdan las matizaciones: "No veo ningún problema en mantener opiniones simultáneas", afirma. "Hay loros estocásticos, hay razonamientos... es un espectro. Es muy complejo. No tenemos todas las respuestas".

"Necesitamos un vocabulario completamente nuevo para describir lo que ocurre", afirma. "Una de las razones por las que la gente me rechaza cuando hablo de razonamiento en LLM es porque no es el mismo razonamiento que en los seres humanos. Pero creo que es imposible no llamarlo razonamiento. Es razonamiento".

Chris Olah, de Anthropic, no se moja cuando se le pregunta qué es lo que estamos viendo en los LLM (y eso que su empresa es uno de los laboratorios de IA en boga en estos momentos, tras lanzar a principios de año Claude 3, un LLM que ha recibido tantos elogios hiperbólicos como GPT-4 o más): "Creo que muchas de estas conversaciones sobre las capacidades de estos modelos son muy tribales. La gente tiene opiniones preconcebidas y no se basa en pruebas. Y creo que estas discusiones en Internet basadas en vibras no van a ningún lado", afirma.

Olah tiene sus propias corazonadas, según me cuenta. "Mi impresión subjetiva es que estas cosas son capaces de seguir ideas bastante sofisticadas. No tenemos una historia completa de cómo funcionan los LLM, pero creo que es difícil conciliar lo que estamos viendo con la imagen extrema de los loros estocásticos", explica.

Pero no va más lejos: "No quiero ir mucho más allá de lo que se puede deducir de las pruebas que tenemos".

El mes pasado, la compañía Anthropic publicó los resultados de un estudio en el que los investigadores sometieron a Claude 3 al equivalente de una resonancia magnética. Al monitorizar qué partes del modelo se encendían y apagaban mientras se ejecutaba, identificaron patrones específicos de redes neurales que se activaban cuando al modelo se le mostraban entradas específicas.

Por ejemplo, un patrón parecía aparecer siempre que se presentaba al modelo una imagen o palabras relacionadas con el puente Golden Gate.

Los investigadores descubrieron que, si aumentaban esta parte del modelo, Claude se obsesionaba por completo con la famosa estructura, hasta el punto de que respondía con algo relacionado con el puente, incluso identificándose con él cuando se le pedía que se describiera a sí mismo. En ocasiones señaló que mencionar el puente era inapropiado, pero no pudo evitarlo.

Anthropic también detectó patrones que, según dice, se correlacionan con entradas que intentan describir o mostrar conceptos abstractos. "Vemos rasgos relacionados con el engaño y la honestidad, con la adulación, con las vulnerabilidades de seguridad, con la parcialidad", dice Olah. "Encontramos rasgos relacionados con la búsqueda de poder y la manipulación y la traición".

Estos resultados ofrecen una de las perspectivas más claras hasta la fecha de lo que hay dentro de un LLM. Se trata de un tentador atisbo de lo que parecen rasgos humanos esquivos. Pero, ¿qué nos dice realmente? Como admite Olah, no saben qué hace el modelo con estos patrones. "Es una imagen relativamente limitada y el análisis es bastante difícil", afirma.

Aunque Olah no sabe explicar con exactitud lo que pasa dentro de un LLM como Claude 3, está claro por qué le importa la cuestión. Anthropic es conocida por su trabajo sobre la seguridad de la IA, que busca garantizar que los modelos futuros se comporten como queremos que se comporten (lo que se conoce como "alineación" en la jerga del sector). Averiguar cómo funcionan los modelos actuales no sólo es un primer paso necesario si se quiere controlar los futuros, sino que también indica hasta qué punto hay que preocuparse por los escenarios de fracaso. "Si no crees que los modelos vayan a ser muy capaces, entonces probablemente no crees que vayan a ser demasiado peligrosos", concluye.

Por qué no podemos llevarnos bien

En una entrevista concedida en 2014 a la BBC en la que repasaba su carrera, a la influyente científica cognitiva Margaret Boden, que ahora tiene 87 años, le preguntaron si creía que había algún límite que impidiera a los ordenadores (o "latas de conserva", como ella los llamaba) hacer lo que pueden hacer los humanos.

"Desde luego, no creo que haya nada en principio", dijo. "Porque negar eso es decir que [el pensamiento humano] ocurre por arte de magia, y yo no creo que ocurra por arte de magia".

Sin embargo, advirtió, no bastará con tener ordenadores potentes: el campo de la IA también necesitará "ideas potentes", nuevas teorías sobre cómo se produce el pensamiento y nuevos algoritmos que puedan reproducirlo. "Pero estas cosas son muy, muy difíciles y no veo ninguna razón para suponer que un día de estos seremos capaces de responder a todas esas preguntas. Puede que sí, puede que no".

Boden hacía esta reflexión en los primeros días del actual auge de la IA, pero esta vacilación sobre si lo conseguiremos o no se remonta a décadas en las que ella y sus colegas se enfrentaron a las mismas preguntas difíciles con las que luchan los investigadores hoy en día. La IA comenzó como una ambiciosa aspiración hace setenta y tantos años, y todavía discrepamos sobre lo que se puede conseguir y lo que no, y sobre cómo sabremos si lo hemos logrado. La mayoría de estas disputas, si no todas, se reducen a lo siguiente: No sabemos muy bien qué es la inteligencia ni cómo reconocerla. El campo está lleno de corazonadas, pero nadie puede asegurarlo.

Llevamos estancados en este punto desde que la gente empezó a tomarse en serio la idea de la IA. O incluso antes, cuando las historias que consumíamos empezaron a sembrar la idea de máquinas parecidas a los humanos en lo más profundo de nuestro imaginario colectivo. La larga historia de estas disputas significa que las luchas actuales a menudo refuerzan fisuras que han existido desde el principio, lo que hace aún más difícil que la gente encuentre un terreno común.

Para entender cómo hemos llegado hasta aquí, tenemos que entender dónde hemos estado. Así que vamos a sumergirnos en la historia del origen de la IA, una historia en la que, ya por aquel entonces, se buscó generar hype para conseguir dinero.

Breve historia de la IA (con giro incluido)

Se atribuye al informático John McCarthy la creación del término "inteligencia artificial" en 1955, al redactar una solicitud de financiación para un programa de investigación de verano en el Dartmouth College de New Hampshire.

El plan consistía en que McCarthy y un pequeño grupo de investigadores se reunieran durante dos meses y avanzaran seriamente en un nuevo reto de investigación que se habían propuesto. Ese grupo era un quién es quién de los matemáticos e informáticos estadounidenses de la posguerra… (o, como los llama Harry Law, investigador que estudia la historia de la IA en la Universidad de Cambridge y sus aspectos éticos y legales en Google DeepMind, simplemente, "John McCarthy y los chicos").

El estudio se basaba "en la conjetura de que cada aspecto del aprendizaje o cualquier otra característica de la inteligencia puede, en principio, describirse con tanta precisión que se puede hacer que una máquina lo simule", según escribieron McCarthy y sus coautores. "Se intentará averiguar cómo hacer que las máquinas utilicen el lenguaje, formen abstracciones y conceptos, resuelvan tipos de problemas ahora reservados a los humanos y se mejoren a sí mismas", añadían.

Esa lista de cosas que querían que hicieran las máquinas —lo que Bender llama en inglés "the starry-eyed dream" [algo así como el sueño de los que tienen pájaros en la cabeza]— no ha cambiado mucho. Utilizar el lenguaje, formar conceptos y resolver problemas son objetivos definitorios de la IA hoy en día. La arrogancia tampoco ha cambiado mucho: "Creemos que se puede lograr un avance significativo en uno o más de estos problemas si un grupo cuidadosamente seleccionado de científicos trabaja en ello durante un verano", escribieron entoces. Ese verano, por supuesto, se ha prolongado durante siete décadas. Y el grado en que estos problemas se han resuelto es algo sobre lo que la gente sigue discutiendo en Internet.

Pero lo que suele quedar fuera de esta historia canónica de la inteligencia artificial es que por poco no se llama "inteligencia artificial".

Más de un colega de McCarthy detestaba el término que se le había ocurrido. "La palabra 'artificial' hace pensar que hay algo de falso en todo esto", afirma Arthur Samuel, uno de los participantes de Dartmouth y creador del primer ordenador que jugaba a las damas, en el libro Machines Who Think (Máquinas que piensan), publicado en 2004 por la historiadora Pamela McCorduck. El matemático Claude Shannon, coautor de la propuesta de Dartmouth y a veces considerado "el padre de la era de la información", prefería el término "estudios sobre autómatas". Herbert Simon y Allen Newell, otros dos pioneros de la IA, siguieron llamando a su propio trabajo "procesamiento complejo de la información" durante años.

De hecho, "inteligencia artificial" era sólo una de las muchas etiquetas que podrían haber reflejado la mezcolanza de ideas en las que se basaba el grupo de Dartmouth. El historiador Jonnie Penn ha recopilado algunas de las posibles alternativas que se propusieron en aquella época, como "psicología de la ingeniería", "epistemología aplicada", "cibernética neural", "computación no numérica", "dinámica neural", "programación automática avanzada" y "autómatas hipotéticos". Esta lista de nombres revela lo diversa que era la inspiración para su nuevo campo, que procedía de la biología, la neurociencia, la estadística y otros campos. Marvin Minsky, otro participante de Dartmouth, ha descrito la IA como una "palabra maleta" porque puede albergar muchas interpretaciones divergentes.

Pero McCarthy quería un nombre que reflejara el ambicioso alcance de su visión. Llamar "inteligencia artificial" a este nuevo campo atrajo la atención de la gente y su dinero. No lo olvidemos: La IA es sexy, la IA mola.

Además de la terminología, la propuesta de Dartmouth creó una división entre dos enfoques rivales de la inteligencia artificial que ha dividido el campo desde entonces, una división que Law denomina la "tensión central de la IA".

McCarthy y sus colegas querían describir en código informático "todos los aspectos del aprendizaje o cualquier otra característica de la inteligencia" para que las máquinas pudieran imitarlos. En otras palabras, si podían averiguar cómo funcionaba el pensamiento -las reglas del razonamiento- y escribir la receta, podrían programar los ordenadores para que la siguieran. Esto sentó las bases de lo que se conoce como IA simbólica o basada en reglas (a veces denominada GOFAI, "good old-fashioned AI" [la IA buena y al viejo estilo]). Sin embargo, la elaboración de reglas codificadas que reflejaran los procesos de resolución de problemas reales y no triviales resultó demasiado difícil.

La otra vía favorecía las redes neuronales, programas informáticos que intentarían aprender esas reglas por sí mismos en forma de patrones estadísticos. La propuesta de Dartmouth lo menciona casi como un inciso (refiriéndose a "redes neuronales" y "redes nerviosas"). Aunque al principio la idea parecía menos prometedora, algunos investigadores siguieron trabajando en versiones de redes neuronales junto con la IA simbólica. Pero, para que despegaran realmente, tuvieron que pasar varias décadas, enormes cantidades de potencia informática y gran parte de los datos de Internet. En la actualidad, este enfoque es la base de todo el auge de la IA.

La gran conclusión es que, al igual que los investigadores actuales, los innovadores de la IA se peleaban por los conceptos básicos y se dejaban llevar por su propia promoción. Incluso el equipo GOFAI estaba plagado de disputas. Aaron Sloman, filósofo y pionero de la IA, recuerda cómo sus "viejos amigos" Minsky y McCarthy "discrepaban fuertemente" cuando los conoció en los años 70: "Minsky pensaba que las afirmaciones de McCarthy sobre la lógica no podían funcionar, y McCarthy pensaba que los mecanismos de Minsky no podían hacer lo que se podía hacer utilizando la lógica. Me llevaba bien con ambos, pero les decía: 'Ninguno de los dos tiene razón'". (Sloman sigue pensando que nadie puede explicar el modo en que el razonamiento humano utiliza tanto la intuición como la lógica, pero eso es otra tangente).

A medida que la evolución de esta tecnología aceleraba o frenaba, el término "IA" se ponía o se pasaba de moda. A principios de los años 70, ambas líneas de investigación se congelaron después de que el gobierno británico publicara un informe en el que afirmaba que el sueño de la IA no había llegado a ninguna parte y no merecía la pena financiarlo. Todo ese alboroto no había servido para nada. Se cerraron proyectos de investigación y los informáticos borraron las palabras "inteligencia artificial" de sus propuestas de subvención.

Cuando estaba terminando un doctorado en informática en 2008, sólo una persona del departamento trabajaba en redes neuronales". Bender tiene un recuerdo similar: "Cuando estaba en la universidad, un chiste que se repetía era que la IA es cualquier cosa que aún no hemos descubierto cómo hacer con los ordenadores. En cuanto descubres cómo hacerlo, ya no es magia, así que no es IA".

Pero esa magia —la visión expuesta en la propuesta de Dartmouth— seguía viva y, como podemos ver ahora, sentó las bases del sueño de la AGI.

Buen y mal comportamiento

En 1950, cinco años antes de que McCarthy empezara a hablar de inteligencia artificial, Alan Turing había publicado un artículo en el que se preguntaba: ¿Pueden pensar las máquinas? Para responder a esa pregunta, el célebre matemático propuso una prueba hipotética, a la que llamó el juego de la imitación. Se trata de imaginar a un humano y a un ordenador detrás de una pantalla y a un segundo humano que escribe preguntas a cada uno. Si el interrogador no puede distinguir qué respuestas proceden del ser humano y cuáles del ordenador, el ordenador podría pensar.

Lo que Turing vio —a diferencia del equipo de McCarthy— fue que el pensamiento es algo realmente difícil de describir. El test de Turing era una forma de eludir ese problema. "Básicamente dijo 'En lugar de centrarme en la naturaleza de la inteligencia en sí, voy a buscar su manifestación en el mundo. Voy a buscar su sombra'", explicó Law.

En 1952, la BBC Radio convocó una mesa redonda para profundizar en las ideas de Turing. Turing estuvo acompañado en el estudio por dos de sus colegas de la Universidad de Manchester —el catedrático de matemáticas Maxwell Newman y el catedrático de neurocirugía Geoffrey Jefferson— y Richard Braithwaite, filósofo de la ciencia, la ética y la religión de la Universidad de Cambridge.

Braithwaite dio el pistoletazo de salida: "El pensamiento se considera de ordinario tan propio del hombre, y quizá de otros animales superiores, que la cuestión puede parecer demasiado absurda para ser discutida. Pero, por supuesto, todo depende de lo que se incluya en pensar".

Los panelistas dieron vueltas entorno a la pregunta de Turing, pero nunca llegaron a concretar una respuesta.

Cuando intentaron definir en qué consistía el pensamiento, cuáles eran sus mecanismos, la meta se movió. "En cuanto se ve que la relación causa-efecto opera en el cerebro, se considera que eso no es pensamiento, sino una especie de trabajo pesado sin imaginación", dice Turing.

Éste era el problema: cuando uno de los panelistas proponía algún comportamiento que pudiera considerarse prueba de pensamiento —reaccionar ante una nueva idea con indignación, por ejemplo—, otro señalaba que se podía hacer que un ordenador lo hiciera.

Como dijo Newman, sería bastante fácil programar un ordenador para imprimir "No me gusta este nuevo programa". Pero admitió que esto sería un truco.

Jefferson le dio la razón. Él quería un ordenador que imprimiera "no me gusta este nuevo programa" porque, de verdad, no le gustaba el nuevo programa. En otras palabras, para Jefferson, el comportamiento no era suficiente; sino que lo que importaba era el proceso que conducía al comportamiento.

Pero Turing no estaba de acuerdo. Como él mismo había señalado, descubrir un proceso específico -el trabajo pesado, por utilizar su expresión- tampoco determinaba qué era el pensamiento. Entonces, ¿qué quedaba?

"Desde este punto de vista, uno podría estar tentado de definir el pensamiento como consistente en aquellos procesos mentales que no entendemos", dijo Turing. "Si esto es cierto, crear una máquina pensante es crear una que haga cosas interesantes sin que entendamos realmente cómo las hace".

Es extraño oír a la gente lidiar con estas ideas por primera vez. "El debate es clarividente", afirma Tomer Ullman, científico cognitivo de la Universidad de Harvard. "Algunos de los puntos [del debate] están más que vivos. A lo que parecen dar vueltas es a que el test de Turing es, ante todo, un test conductista."

Para Turing, la inteligencia era difícil de definir, pero fácil de reconocer. Propuso que la apariencia de inteligencia era suficiente, pero no dijo nada sobre cómo debía producirse ese comportamiento.

Las máquinas teóricas de Ned Block o blockhead eran tan "inteligentes" como una tostadora. / JUN IONEDA

Y, sin embargo, la mayoría de la gente, cuando se le presiona, tiene un instinto visceral sobre lo que es inteligente y lo que no lo es. Hay formas tontas y formas inteligentes de parecer inteligente. En 1981, Ned Block, filósofo de la Universidad de Nueva York, demostró que la propuesta de Turing no respondía a esos instintos viscerales. Como no decía nada de lo que causaba el comportamiento, la prueba de Turing puede superarse mediante trucos (como Newman había señalado en la emisión de la BBC).

"¿Depende la cuestión de si una máquina piensa o es inteligente de lo crédulos que sean los interrogadores humanos?", se pregunta Block. (O, en palabras del informático Mark Reidl, "la prueba de Turing no consiste en que la IA apruebe, sino en que los humanos suspendan".

Imagine una gran tabla de consulta en la que programadores humanos hubieran introducido todas las respuestas posibles a todas las preguntas posibles, plantea Ned Block. La máquina teclea una pregunta, busca la respuesta correspondiente en su base de datos y se la devuelve. Block sostenía que cualquiera que utilizara esta máquina consideraría que su comportamiento era inteligente. "Pero, en realidad, la máquina tiene la inteligencia de una tostadora. Toda la inteligencia que exhibe es la de sus programadores", escribió.

Block llegó a la conclusión de que si un comportamiento es inteligente es cuestión de cómo se produce, no de cómo aparece. Las "tostadoras" de Block, que pasaron a conocerse como blockheads, son uno de los contraejemplos más sólidos de los supuestos en los que se basa la propuesta de Turing.

Mirando bajo el capó

El test de Turing no pretendía ser una métrica práctica, pero sus implicaciones están profundamente arraigadas en la forma en que pensamos hoy en día sobre la inteligencia artificial. Esto ha cobrado especial relevancia con la explosión de los LLM en los últimos años. Estos modelos se clasifican en función de su comportamiento externo, es decir, de su rendimiento en una serie de pruebas. Cuando OpenAI anunció GPT-4, publicó una impresionante tabla de puntuación que detallaba el rendimiento del modelo en múltiples exámenes de bachillerato y profesionales. Casi nadie habla de cómo estos modelos obtienen esos resultados.

Eso es porque no lo sabemos. Los grandes modelos lingüísticos actuales son demasiado complejos para que nadie pueda decir exactamente cómo se produce su comportamiento. Los investigadores ajenos al reducido número de empresas que fabrican estos modelos no saben qué contienen sus datos de entrenamiento; ninguno de los fabricantes de modelos ha compartido los detalles. Por eso es difícil decir qué es y qué no memorización o repetición estocástica. Ni siquiera los investigadores internos, como Olah, saben qué ocurre realmente cuando se enfrentan a un robot obsesionado con los puentes.

Esto deja la cuestión muy abierta. Sí, los LLM se basan en las matemáticas, pero…. ¿hacen algo inteligente con ellas?

De nuevo, comienza la discusión:

"La mayoría de la gente está poniéndose en evidencia", dice Pavlick, de la Universidad de Brown, en referencia a que están debatiendlo sobre teorías sin mirar lo que realmente está sucediendo. "Algunos dicen: 'Yo creo que es así', y otros: 'Pues yo no'. Estamos como atascados y todos insatisfechos".

Bender cree que esta sensación de misterio contribuye a la creación del mito. ("Los magos no explican sus trucos", dice.) Sin una apreciación adecuada de la procedencia de las palabras del LLM, recurrimos a suposiciones familiares sobre los humanos, ya que ése es nuestro único punto de referencia real. Cuando hablamos con otra persona, intentamos dar sentido a lo que esa persona intenta decirnos. "Ese proceso implica necesariamente imaginar una vida detrás de las palabras", explica Bender. Así funciona el lenguaje.

"El truco de salón de ChatGPT es tan impresionante que cuando vemos salir estas palabras de él, hacemos lo mismo instintivamente Es muy bueno imitando la forma del lenguaje. El problema es que no se nos da nada bien encontrarnos con la forma del lenguaje y no imaginarnos el resto", señala.

Para algunos investigadores, no importa realmente si no podemos entender el cómo. Bubeck solía estudiar LLM para intentar averiguar cómo funcionaban, pero GPT-4 cambió su forma de pensar sobre ellos. "Parece que estas preguntas ya no son tan relevantes. El modelo es tan grande, tan complejo, que no podemos esperar abrirlo y entender lo que está pasando realmente", sostiene.

Pero Pavlick, al igual que Olah, está intentando hacer precisamente eso. Su equipo ha descubierto que los modelos parecen codificar relaciones abstractas entre objetos, como la que existe entre un país y su capital. Al estudiar un gran modelo lingüístico, Pavlick y sus colegas descubrieron que utilizaba la misma codificación para asignar Francia a París y Polonia a Varsovia. Casi suena inteligente, le digo. "No. Es literalmente una tabla de búsqueda", me responde.

Pero lo que sí sorprendió a Pavlick fue que, a diferencia de un blockhead, el modelo había aprendido esta tabla de búsqueda por sí mismo. En otras palabras, el LLM descubrió por sí mismo que París es a Francia lo que Varsovia es a Polonia. ¿Pero qué demuestra esto? ¿Codificar su propia tabla de búsqueda en lugar de utilizar una codificada es un signo de inteligencia? ¿Dónde está el límite?

"Básicamente, el problema es que el comportamiento es lo único que sabemos medir de forma fiable. Cualquier otra cosa requiere un compromiso teórico y a la gente no le gusta comprometerse en algo que tiene tanta carga", explica Pavlick.

Pero a muchos científicos influyentes no les importa comprometerse. Hinton, por ejemplo, insiste en que las redes neuronales son todo lo que se necesita para recrear una inteligencia similar a la humana. "El aprendizaje profundo va a ser capaz de hacerlo todo", dijo a MIT Technology Review en 2020.

Es un compromiso que Hinton parece haber mantenido desde el principio. Sloman, que recuerda las discusiones entre ambos cuando Hinton era estudiante de posgrado en su laboratorio, recuerda que fue incapaz de convencerle de que las redes neuronales no pueden aprender ciertos conceptos abstractos cruciales que los humanos y algunos otros animales parecen comprender intuitivamente, como por ejemplo si algo es imposible. Simplemente podemos ver cuándo descartan algo, explica Sloman. "A pesar de la extraordinaria inteligencia de Hinton, nunca pareció entender ese punto. No sé por qué, pero hay un gran número de investigadores en redes neuronales que comparten ese fallo".

Y luego está Marcus, cuya visión de las redes neuronales es exactamente opuesta a la de Hinton. Su caso se basa en lo que dice que los científicos han descubierto sobre los cerebros.

Los cerebros, señala Marcus, no son pizarras en blanco que aprenden completamente desde cero, sino que vienen preparados con estructuras y procesos innatos que guían el aprendizaje. Así es como los bebés pueden aprender cosas que las mejores redes neuronales aún no pueden, argumenta.

"La gente de las redes neuronales tiene un martillo, y ahora todo es un clavo. Quieren hacerlo todo con el aprendizaje, lo que muchos científicos cognitivos considerarán poco realista y tonto. No vas a aprenderlo todo desde cero", explica Marcus.

No es que Marcus, que es científico cognitivo, esté menos seguro de sí mismo. "Si realmente se analizara quién ha predicho bien la situación actual, creo que yo tendría que encabezar la lista", me dice desde la parte trasera de un Uber de camino a coger un vuelo para dar una conferencia en Europa. "Sé que no suena muy modesto, pero tengo una perspectiva que resulta ser clave si lo que intentas estudiar es la inteligencia artificial".

Dados sus ataques públicos a este campo, puede que le sorprenda que Marcus siga creyendo que la inteligencia artificial está en el horizonte. Lo que piensa es que la fijación actual en las redes neuronales es un error. "Probablemente necesitemos uno, dos o cuatro avances", afirma. "Puede que usted y yo no vivamos tanto, siento decirlo. Pero creo que ocurrirá este siglo. Quizá tengamos una oportunidad".

El poder de un sueño en tecnicolor

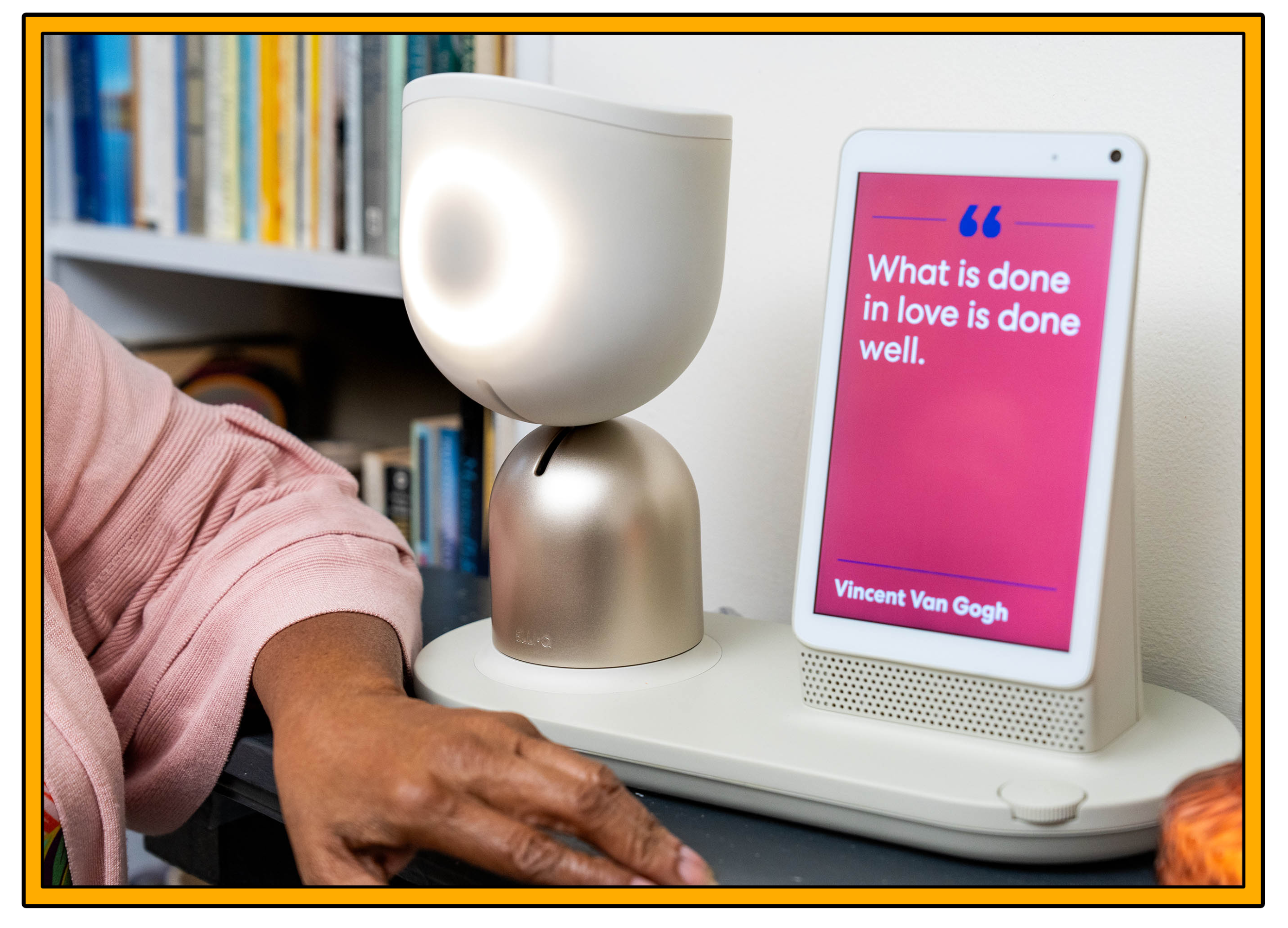

Por encima del hombro de Dor Skuler en la llamada de Zoom desde su casa de Ramat Gan (Israel), un pequeño robot parecido a una lámpara se enciende y se apaga mientras hablamos de él. "Puedes ver a ElliQ detrás de mí", dice. La empresa de Skuler, Intuition Robotics, desarrolla estos dispositivos para personas mayores, y el diseño -parte Amazon Alexa, parte R2-D2- debe dejar muy claro que ElliQ es un ordenador. Si alguno de sus clientes muestra signos de estar confundido al respecto, Intuition Robotics retira el dispositivo, dice Skuler.

ElliQ no tiene cara ni forma humana. Si le preguntas por deportes, te dirá que no tiene coordinación mano-ojo porque no tiene manos ni ojos. "Te juro que no entiendo por qué la industria intenta cumplir el test de Turing", asegura Skuler. "¿En qué redunda en beneficio de la humanidad desarrollar una tecnología cuyo objetivo sea embaucarnos?".

En su lugar, la empresa de Skuler apuesta por que las personas puedan entablar relaciones con máquinas que se presentan como máquinas. "Igual que tenemos la capacidad de entablar una relación real con un perro. Los perros proporcionan mucha alegría a la gente. Proporcionan compañía. La gente quiere a su perro, pero nunca lo confunde con un ser humano", explica.

Los usuarios de ElliQ, muchos de ellos de entre 80 y 90 años, se refieren al robot como una entidad o una presencia, a veces como un compañero de piso. "Son capaces de crear un espacio para esta relación intermedia, algo entre un dispositivo o un ordenador y algo que está vivo", dice Skuler.

Pero por mucho que los diseñadores de ElliQ intenten controlar la percepción que la gente tiene del dispositivo, están compitiendo con décadas de cultura pop que han moldeado nuestras expectativas. ¿Por qué estamos tan obsesionados con una inteligencia artificial parecida a la humana? "Porque nos resulta difícil imaginar otra cosa", dice Skuler (que, de hecho, se refiere a ElliQ como "ella" a lo largo de nuestra conversación). "Y porque mucha gente del sector tecnológico es aficionada a la ciencia ficción. Intentan hacer realidad su sueño".

¿Cuántos desarrolladores han crecido pensando que construir una máquina inteligente era lo más genial —si no lo más importante— que podían hacer?

No hace mucho que OpenAI lanzó su nueva versión controlada por voz de ChatGPT con una voz que sonaba como Scarlett Johansson, tras lo cual muchas personas —incluida Altman— señalaron la conexión con la película Her, de Spike Jonze, de 2013. La ciencia ficción coinventa lo que se entiende por IA. Como escriben Cave y Dihal en Imagining AI: "La IA fue un fenómeno cultural mucho antes que tecnológico".

Las historias y los mitos sobre la transformación de seres humanos en máquinas existen desde hace siglos. La gente lleva soñando con seres humanos artificiales tanto tiempo como con volar, afirma Dihal. Señala que Dédalo, el personaje de la mitología griega famoso por construir un par de alas para él y su hijo Ícaro, también construyó un robot gigante de bronce llamado Talos que lanzaba piedras a los piratas que pasaban.

La palabra robot procede de robota, un término para "trabajos forzados" acuñado por el dramaturgo checo Karel Čapek en su obra de 1920 Los robots universales de Rossum. Las "leyes de la robótica" esbozadas en la ciencia ficción de Isaac Asimov, que prohíben a las máquinas hacer daño a los humanos, se invierten en películas como Terminator, que es un punto de referencia icónico para los temores populares sobre la tecnología del mundo real. La película de 2014 Ex Machina es una versión dramática del test de Turing. El Creador, que el año pasado cosechó éxito en taquilla, imagina un mundo futuro en el que la IA ha sido prohibida por haber hecho estallar una bomba nuclear, un acontecimiento que algunos catastrofistas consideran al menos una posibilidad remota.

Cave y Dihal relatan cómo otra película, Transcendence, de 2014, en la que un experto en IA interpretado por Johnny Depp carga su mente en un ordenador, sirvió a una narrativa impulsada por unos catastrofistas Stephen Hawking, Max Tegmark (también físico, como Hawking) y Stuart Russell (investigador de IA). En un artículo publicado en el Huffington Post el mismo fin de semana del estreno de aquella película, el trío escribió: "Mientras la superproducción de Hollywood Transcendence se estrena este fin de semana con visiones enfrentadas sobre el futuro de la humanidad, es tentador descartar la noción de máquinas altamente inteligentes como mera ciencia ficción. Pero esto sería un error, y potencialmente nuestro peor error".

Trascendence / ALCON ENTERTAINMENT VIA ALAMY

Al mismo tiempo, Tegmark fundó el Future of Life Institute, con el objetivo de estudiar y promover la seguridad de la IA. Morgan Freeman, coprotagonista de la película con Depp, formó parte de la junta directiva de la institución, y Elon Musk, que tuvo un cameo en la película, donó 10 millones de dólares en su primer año. Para Cave y Dihal, Transcendence es un ejemplo perfecto de la maraña que forman la cultura popular, la investigación académica, la producción industrial y "la lucha financiada por multimillonarios para dar forma al futuro".

En la etapa londinense de su gira mundial del año pasado, le preguntaron a Sam Altman a qué se refería cuando tuiteó: "La IA es la tecnología que el mundo siempre ha querido". Aquel día, de pie al fondo de la sala, detrás de un público de cientos de personas, le escuché contar su propia historia de origen: "Yo era un niño muy nervioso. Leía mucha ciencia ficción. Pasaba muchos viernes por la noche en casa, jugando con el ordenador. Pero siempre me interesó mucho la IA y pensé que sería muy guay". Fue a la universidad, se hizo rico y vio cómo las redes neuronales eran cada vez mejores. "Esto puede ser tremendamente bueno, pero también podría ser realmente malo. ¿Qué vamos a hacer al respecto?", recuerda que pensó en 2015. "Acabé fundando OpenAI".

Por qué debería importarte que un grupo de empollones se peleen por la IA

Vale, creo que queda claro: nadie se pone de acuerdo sobre qué es la IA. Pero en lo que todo el mundo parece estar de acuerdo es en que el debate actual en torno a la IA ha ido mucho más allá de lo académico y lo científico. Hay componentes políticos y morales en juego. No ayuda que todo el mundo piense que los demás están equivocados.

Desenredar esta maraña es difícil. También lo es tener perspectiva sobre lo que está pasando cuando algunos de los aspectos morales que se discuten abarcan el futuro de la humanidad y lo vinculan con una tecnología que nadie puede definir del todo.

Pero no podemos quedarnos con los brazos cruzados. Porque, sea cual sea esta tecnología, está al llegar y, a menos que vivas bajo una roca, la utilizarás de una forma u otra. Y la forma que adopte la tecnología —y los problemas que resuelva y cree— dependerán del pensamiento y las motivaciones de personas como las que acaban de leer. En particular, de las personas con más poder, más dinero y más altavoces.

Lo que me lleva a los TESCREAListas. —¡Espera, no te vayas!— Me doy cuenta de que no está bien introducir un concepto nuevo tan tarde; pero para entender cómo las personas con poder pueden moldear las tecnologías que construyen y cómo se las explican a los reguladores y legisladores del mundo, es necesario entender realmente su mentalidad.

Timnit Gebru, que fundó el Distributed AI Research Institute tras dejar Google, y Émile Torres, filósofo e historiador de la Case Western Reserve University, han rastreado la influencia de varios sistemas de creencias tecnoutópicas en Silicon Valley. Ambos sostienen que para entender lo que está ocurriendo con la IA en la actualidad —por qué hay empresas como Google DeepMind y OpenAI que están en una carrera por construir inteligencia artificial y por qué hay catastrofistas como Tegmark y Hinton que advierten de un desastre inminente— hay que ver el campo a través de la lente de lo que Torres ha denominado el marco TESCREAL.

El acrónimo TESCREAL incluye, de forma generalista, una lista de etiquetas: transhumanismo, extropianismo, singularitarismo, cosmismo, racionalismo, altruismo efectivo y largoplacismo. Se ha escrito (y se escribirá) mucho sobre cada una de estas visiones del mundo, así que me ahorraré hacerlo aquí. (Hay madrigueras de conejo dentro de la madriguera de conejo para cualquiera que quiera profundizar: elige tu foro y prepara tu equipo de espeleología).

Esta constelación de ideologías superpuestas resulta atractiva para cierto tipo de mentalidad de cerebro-galaxia común en el mundo tecnológico occidental. Algunos anticipan la inmortalidad humana; otros predicen la colonización de las estrellas por parte de la humanidad. El principio común es que una tecnología todopoderosa —AGI o superinteligencia, elija su equipo— no sólo está al alcance de la mano, sino que es inevitable. Esto se puede ver en la actitud de "hazlo o muere", omnipresente en laboratorios de vanguardia como OpenAI: si nosotros no creamos la AGI, lo hará otro.

Es más, los TESCREAListas creen que la IAG no sólo podría solucionar los problemas del mundo, sino también elevar el nivel de la humanidad. "El desarrollo y la proliferación de la IA, lejos de ser un riesgo que debamos temer, es una obligación moral que tenemos con nosotros mismos, con nuestros hijos y con nuestro futuro", escribió Andreessen en un manifiesto muy comentado el año pasado. Demis Hassabis, director general y cofundador de Google DeepMind; Mustafa Suleyman, director general de la recién creada Microsoft AI y otro cofundador de DeepMind; Sutskever, director general de Microsoft AI y cofundador de DeepMind, me han dicho muchas veces que la IA es la forma de hacer del mundo un lugar mejor. Y con ellos están Sutskever, Altman, etc.

Pero, como señaló Andreessen, se trata de una mentalidad yin-yang. La otra cara de la utopía tecnológica es el infierno tecnológico. Si uno cree que está construyendo una tecnología tan poderosa que resolverá todos los problemas del mundo, probablemente también crea que existe una posibilidad no despreciable de que todo salga muy mal. Cuando le preguntaron en la Cumbre Mundial de Gobiernos de febrero qué le quitaba el sueño, Altman respondió: "todas estas cosas de ciencia ficción".

Es una tensión de la que Hinton viene hablando desde hace un año. Es lo que pretenden resolver empresas como Anthropic. Es en lo que se centra Sutskever en su nuevo laboratorio y en lo que quería que se centrara un equipo interno especial de OpenAI el año pasado antes de que los desacuerdos sobre el balance entre riesgos y beneficios que hacía la empresa llevaran a la mayoría de los miembros de ese equipo a marcharse.

Por supuesto, la mentalidad catastrofista o doomer (por el inglés Doomsday, Día del Juicio) forma parte de la ecuación. ("Afirmar que has creado algo superinteligente es bueno para las cifras de ventas", explica Dihal. "Es como decir: 'Por favor, que alguien me impida ser tan bueno y tan poderoso'"). Pero, haya boom o haya catástrofe, ¿qué problemas (y de quién) están resolviendo estos tipos? ¿Debemos confiar realmente en lo que construyen y en lo que dicen a nuestros dirigentes?

Gebru y Torres (y otros) lo tienen claro: no, no deberíamos. Son muy críticos con estas ideologías y con la forma en que pueden influir en el desarrollo de la tecnología futura, especialmente la IA. Sobre todo, vinculan varias de estas visiones a los movimientos racistas eugenésicos del siglo XX, con su enfoque compartido hacia la "mejora" de la humanidad.

Uno de los peligros, argumentan, es que un desplazamiento de los recursos hacia el tipo de innovaciones tecnológicas que exigen estas ideologías, desde la construcción de AGI hasta la ampliación de la esperanza de vida y la colonización de otros planetas, beneficiará en última instancia a las personas que son occidentales y blancas a costa de miles de millones de personas que no lo son. Si la vista está puesta en futuros fantásticos, es fácil pasar por alto los costes actuales de la innovación, como la explotación laboral, el afianzamiento de prejuicios racistas y sexistas, y el daño medioambiental.

"¿Intentamos construir una herramienta que nos sea útil de algún modo?", se pregunta Bender, reflexionando sobre las víctimas de esta carrera hacia la AGI. Si es así, ¿para quién?, ¿cómo lo probamos?, ¿qué tal funciona? "Pero si para lo que lo estamos construyendo es sólo para poder decir que lo hemos hecho, ése no es un objetivo que podamos respaldar. No es un objetivo que valga miles de millones de dólares".

Bender dice que ver las conexiones entre las ideologías "TESCREAL" fue lo que le hizo darse cuenta de que había algo más en estos debates. "Relacionarme con esa gente fue...", se detiene. "Vale, aquí hay algo más que ideas académicas. También hay un código moral ligado a ello".

Por supuesto, expuesto así, sin matices, no parece que nosotros —como sociedad, como individuos— estemos obteniendo el mejor trato. También tiene una parte ridícula. Cuando Gebru describió partes del paquete TESCREAL en una charla el año pasado, el público se rio. Es cierto que pocas personas se identificarían a sí mismas como discípulos de estas escuelas de pensamiento, al menos en sus extremos.

Pero si no entendemos cómo enfocan esta tecnología quienes la construyen, ¿cómo podemos decidir a qué acuerdo queremos llegar con ellos como sociedad? ¿Qué aplicaciones decidimos utilizar, a qué chatbots queremos dar información personal, qué centros de datos apoyamos en nuestros barrios, a qué políticos queremos votar?

Antes era así: había un problema en el mundo, y construíamos algo para solucionarlo. Aquí, todo es al revés: el objetivo parece ser construir una máquina que pueda hacerlo todo, y saltarse el lento y duro trabajo que supone averiguar cuál es el problema antes de construir la solución.

Y como dijo Gebru en esa misma charla: "Una máquina que resuelve todos los problemas: si eso no es magia, ¿qué es?".

Semántica, semántica y semántica

Cuando se le pregunta directamente qué es la IA, mucha gente esquiva la pregunta. Pero Mustafa Suleyman no. En abril, el director general de Microsoft AI subió al escenario de TED y contó a la audiencia lo que le había dicho a su sobrino de seis años en respuesta a esa pregunta. La mejor respuesta que podía dar, explicó Suleyman, era que la IA era "un nuevo tipo de especie digital", una tecnología tan universal y poderosa que llamarla herramienta ya no reflejaba lo que podía hacer por nosotros.

"En nuestra trayectoria actual, nos dirigimos hacia la aparición de algo que todos nos esforzamos por describir y, sin embargo, no podemos controlar lo que no entendemos", afirmó. "Así que las metáforas, los modelos mentales, los nombres... todo esto es importante si queremos sacar el máximo partido de la IA y limitar al mismo tiempo sus posibles inconvenientes".

¡El lenguaje es importante! Espero que eso te haya quedado claro después de las vueltas que hemos dado (y las rabietas que nos hemos llevado) para llegar a este punto. Pero también espero que te hagas esta pregunta: ¿el lenguaje de quién? Suleyman es un líder del sector en un gigante tecnológico que puede ganar miles de millones con sus productos de IA. Describir la tecnología que hay detrás de esos productos como un nuevo tipo de especie evoca algo totalmente sin precedentes, algo con un poder y unas capacidades que nunca habíamos visto. Y eso activa mi sentido arácnido... ¿no os pasa a vosotros?

No puedo decirte si hay magia aquí (ya sea irónica o no). Y no puedo decirte cómo las matemáticas pueden hacer realidad lo que Bubeck y muchos otros ven en esta tecnología (nadie puede todavía). Tendrás que decidirlo por ti mismo. Pero puedo mostrarte mi propio punto de vista.

Escribiendo sobre GPT-3 en 2020, dije que el mayor truco de la IA era convencer al mundo de que existe. Sigo pensando lo mismo: Estamos predispuestos a ver inteligencia en las cosas que se comportan de determinada manera, tanto si existe como si no. En los últimos años, la industria tecnológica ha encontrado sus propias razones para convencernos de que la IA también existe. Esto me hace ser escéptico ante muchas de las afirmaciones que se hacen sobre esta tecnología.

Al mismo tiempo, los LLM me asombran. Qué pueden hacer exactamente y cómo lo hacen son algunas de las cuestiones más apasionantes de nuestro tiempo.

Quizá a los humanos siempre nos haya fascinado la inteligencia: qué es y quién más la tiene.

Los filósofos llevan mucho tiempo planteando escenarios hipotéticos para imaginar lo que significaría encontrarse con un comportamiento inteligente que no fuera de un humano, me explica Pavlick.

Como, por ejemplo, ¿qué pasaría si una ola bañara una playa y, cuando se retirase, dejara un dibujo en la arena que deletrease un poema?

Con los grandes modelos lingüísticos, a través de sus máscaras de caras sonrientes, nos enfrentamos a algo en lo que nunca antes habíamos tenido que pensar. "Es tomar esa hipótesis y hacerla realmente concreta. Nunca he tenido que pensar si un trozo de lenguaje requería inteligencia para generarse, porque nunca he tratado con un lenguaje que no la requiriera", explica Pavlick.

La IA es muchas cosas. Pero no creo que se parezca a los humanos. No creo que sea la solución a todos (ni siquiera a la mayoría) de nuestros problemas. No es ChatGPT ni Gemini ni Copilot. No son las redes neuronales. Es una idea, una visión, una especie de deseo cumplido. Y las ideas son moldeadas por otras ideas, por la moral, por convicciones casi religiosas, por visiones del mundo, por la política y por el instinto. La "inteligencia artificial" es una forma útil de describir una serie de tecnologías diferentes. Pero la IA no es una sola cosa; nunca lo ha sido, por mucho que la marca se grabe en el exterior de la caja.

"La verdad es que estas palabras -inteligencia, razonamiento, comprensión, etc.- se definieron antes de que existiera la necesidad de ser realmente preciso al respecto", dice Pavlick. "No me gusta que la pregunta se convierta en '¿entiende el modelo, sí o no?' porque… bueno, no sé, las palabras se redefinen y los conceptos evolucionan constantemente".

Creo que es cierto. Y cuanto antes demos todos un paso atrás, nos pongamos de acuerdo en lo que no sabemos y aceptemos que nada de esto es todavía un hecho, antes podremos... no sé, supongo que no vamos a darnos las manos y a ponernos a cantar kumbayá; pero, al menos, podremos dejar de insultarnos.