La IA generativa ha hecho que el 'phishing', las estafas y el 'doxxing' sean más fáciles que nunca

La inteligencia artificial ha supuesto un gran aumento de la productividad para los criminales.

La IA generativa ofrece un nuevo y potente conjunto de herramientas que permite a los delincuentes trabajar de forma mucho más eficaz e internacional que nunca, afirma Vincenzo Ciancaglini, investigador principal de amenazas de la empresa de seguridad Trend Micro.

La mayoría de los delincuentes «no viven en una oscura guarida planeando cosas», afirma Ciancaglini. «La mayoría son gente normal que lleva a cabo actividades habituales que también requieren productividad».

El año pasado vimos el auge y la caída de WormGPT, un modelo de lenguaje de IA construido sobre un modelo de código abierto y entrenado con datos relacionados con malware, que se creó para ayudar a los hackers y no tenía normas éticas ni restricciones. Pero el verano pasado, sus creadores anunciaron que cerraban el modelo después de que empezara a atraer la atención de los medios de comunicación. Desde entonces, la mayoría de los ciberdelincuentes han dejado de desarrollar sus propios modelos de IA. En su lugar, están optando por trucos con herramientas existentes que funcionan de forma fiable.

Esto se debe a que los delincuentes quieren una vida fácil y ganancias rápidas, explica Ciancaglini. Para que una nueva tecnología merezca la pena por los riesgos desconocidos asociados a su adopción —por ejemplo, un mayor riesgo de ser descubierto—, tiene que ser mejor y ofrecer mayores recompensas que las que utilizan actualmente.

He aquí cinco formas en las que los delincuentes utilizan la IA en la actualidad.

Phishing

El mayor caso de uso de IA generativa entre los delincuentes en estos momentos es el phishing, que consiste en intentar engañar a la gente para que revele información sensible que pueda utilizarse con fines maliciosos, explica Mislav Balunović, investigador de seguridad de IA en ETH Zurich. Los investigadores han descubierto que el auge de ChatGPT ha ido acompañado de un enorme repunte en el número de correos electrónicos de phishing.

Los servicios que generan spam, como GoMail Pro, tienen ChatGPT integrado, lo que permite a los usuarios delincuentes traducir o mejorar los mensajes enviados a las víctimas, afirma Ciancaglini. Las políticas de OpenAI prohíben el uso de sus productos para actividades ilegales, pero esto es difícil de controlar en la práctica, ya que muchos mensajes que parecen inocentes pueden utilizarse también con fines maliciosos, dice Ciancaglini.

OpenAI afirma que utiliza una combinación de revisores humanos y sistemas automatizados para identificar y aplicar medidas contra el uso indebido de sus modelos, y emite advertencias, suspensiones temporales y prohibiciones si los usuarios infringen las políticas de la empresa.

«Nos tomamos muy en serio la seguridad de nuestros productos y mejoramos continuamente nuestras medidas de seguridad en función del uso que se hace de ellos», afirma un portavoz de OpenAI. «Trabajamos constantemente para que nuestros modelos sean más seguros y robustos contra el abuso y los jailbreaks, al tiempo que mantenemos la utilidad de los modelos y el rendimiento de las tareas», añadieron.

En un informe de febrero, OpenAI dijo que había cerrado cinco cuentas asociadas con actores maliciosos afiliados a varios Estados.

Antes, las llamadas estafas del príncipe nigeriano, en las que alguien promete a la víctima una gran suma de dinero a cambio de un pequeño pago por adelantado, eran relativamente fáciles de detectar porque el inglés de los mensajes era torpe y estaba plagado de errores gramaticales, afirma Ciancaglini. Los modelos lingüísticos permiten a los estafadores generar mensajes que suenan como si los hubiera escrito un hablante nativo.

«Los angloparlantes solían estar relativamente a salvo de los delincuentes no angloparlantes porque podían detectar sus mensajes», afirma Ciancaglini. Pero ya no es así.

Gracias a la mejora de la traducción automática, los distintos grupos delictivos de todo el mundo también pueden comunicarse mejor entre sí. El riesgo es que puedan coordinar operaciones a gran escala que vayan más allá de sus naciones y se dirijan a víctimas de otros países, dice Ciancaglini.

Estafas de audio deepfake

La IA generativa ha permitido que el desarrollo de deepfakes dé un gran salto adelante, con imágenes, vídeos y audio sintéticos que parecen y suenan más realistas que nunca. Esto no ha pasado desapercibido para el hampa.

A principios de este año, un empleado de Hong Kong perdió 25 millones de dólares (algo más de 23 millones de euros) en una estafa después de que unos ciberdelincuentes utilizaran un deepfake del director financiero de la empresa para convencerle de que transfiriera el dinero a la cuenta del estafador. «Hemos visto cómo los deepfakes se comercializan finalmente en la clandestinidad», afirma Ciancaglini. Su equipo ha encontrado personas en plataformas como Telegram que muestran su «cartera» de deepfakes y venden sus servicios por tan sólo 10 dólares (unos 9 euros) por imagen o 500 dólares (en torno a 460 euros) por minuto de vídeo. Una de las personas más populares entre los delincuentes de quien crear deepfakes es Elon Musk, afirma Ciancaglini.

Y mientras que los vídeos deepfake siguen siendo complicados de hacer y más fáciles de detectar para los humanos, ese no es el caso de los deepfakes de audio. Son baratos de hacer y solo requieren un par de segundos de la voz de alguien —tomada, por ejemplo, de las redes sociales— para generar algo aterradoramente convincente.

En Estados Unidos se han dado casos muy sonados de personas que han recibido llamadas angustiosas de seres queridos diciendo que habían sido secuestrados y pidiendo dinero para ser liberados, para luego resultar ser un estafador que utilizaba una grabación de voz deepfake.

«La gente tiene que ser consciente de que ahora estas cosas son posibles, y tiene que ser consciente de que ahora el rey nigeriano ya no habla en un inglés chapurreado», dice Ciancaglini. «La gente puede llamarte con otra voz, y pueden ponerte en una situación muy estresante», añade.

Hay algunas formas de protegerse, dice. Ciancaglini recomienda acordar entre los seres queridos una palabra de seguridad secreta que cambie con regularidad y ayude a confirmar la identidad de la persona al otro lado de la línea.

«Yo protegí a mi abuela con una contraseña», dice.

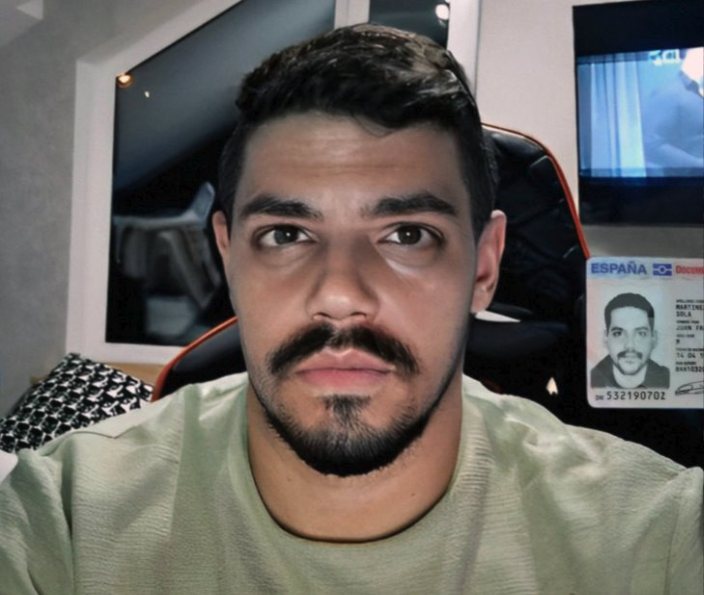

Eludir los controles de identidad

Otra forma en la que los delincuentes utilizan deepfakes es para eludir los sistemas de verificación de cliente. Los bancos y las bolsas de criptomonedas utilizan estos sistemas para verificar que sus clientes son personas reales. Exigen a los nuevos usuarios que se hagan una foto con un documento de identidad frente a una cámara. Pero los delincuentes han empezado a vender aplicaciones en plataformas como Telegram que permiten eludir este requisito.

Funcionan ofreciendo un documento de identidad falso o robado e imponiendo una imagen deepfake sobre la cara de una persona real para engañar al sistema de verificación de la cámara de un teléfono Android. Ciancaglini ha encontrado ejemplos de personas que ofrecen estos servicios para el sitio web de criptomonedas Binance por tan solo 70 dólares (64,5 euros).

«Todavía son bastante básicos», dice Ciancaglini. Las técnicas que utilizan son similares a los filtros de Instagram, donde la cara de otra persona se cambia por la tuya.

«Lo que podemos esperar en el futuro es que [los delincuentes] utilicen deepfakes reales (...) para que puedas hacer autenticaciones más complejas», dice.

Jailbreak-as-a-service

Si preguntas a la mayoría de los sistemas de IA cómo fabricar una bomba, no obtendrás una respuesta útil.

Esto se debe a que las empresas de IA han establecido diversas salvaguardias para evitar que sus modelos arrojen información dañina o peligrosa. En lugar de crear sus propios modelos de IA sin estas salvaguardias, lo que resulta caro, laborioso y difícil, los ciberdelincuentes han empezado a adoptar una nueva tendencia: el jailbreak como servicio.

La mayoría de los modelos vienen con reglas sobre cómo pueden utilizarse. El jailbreaking permite a los usuarios manipular el sistema de IA para generar resultados que violan esas políticas, por ejemplo, para escribir código para ransomware o generar texto que podría utilizarse en correos electrónicos fraudulentos.

Servicios como EscapeGPT y BlackhatGPT ofrecen acceso anónimo a API de modelos de lenguaje y a instrucciones de jailbreaking que se actualizan con frecuencia. Para luchar contra esta creciente industria artesanal, empresas de IA como OpenAI y Google tienen que tapar con frecuencia agujeros de seguridad que podrían permitir el uso indebido de sus modelos.

Los servicios de jailbreaking utilizan diferentes trucos para saltarse los mecanismos de seguridad, como plantear preguntas hipotéticas o hacer preguntas en idiomas extranjeros. Existe un juego constante del gato y el ratón entre las empresas de inteligencia artificial, que intentan evitar que sus modelos se comporten mal, y los actores malintencionados, que inventan mensajes de jailbreak cada vez más creativos.

Estos servicios están dando en el clavo para los delincuentes, afirma Ciancaglini.

«Estar al día de los jailbreaks es una actividad tediosa. Se te ocurre uno nuevo, luego tienes que probarlo, funcionará durante un par de semanas, y después Open AI actualiza su modelo", añade. «El jailbreaking es un servicio superinteresante para los delincuentes».

Doxxing y vigilancia

Los modelos lingüísticos de IA son una herramienta perfecta no solo para el phishing, sino también para el doxxing (revelar información privada e identificativa de alguien en línea), afirma Balunović. Esto se debe a que los modelos lingüísticos de IA se entrenan con grandes cantidades de datos de Internet, incluidos datos personales, y pueden deducir dónde, por ejemplo, podría estar ubicada una persona.

Como ejemplo de cómo funciona, se podría pedir a un chatbot que se hiciera pasar por un investigador privado con experiencia en la elaboración de perfiles. Entonces se le podría pedir que analizara el texto que ha escrito la víctima y que dedujera información personal a partir de pequeñas pistas en ese texto: por ejemplo, su edad basándose en cuándo fue al instituto, o dónde vive basándose en los puntos de referencia que menciona en su trayecto al trabajo. Cuanta más información haya sobre ellos en Internet, más vulnerables son a ser identificados.

Balunović formó parte de un equipo de investigadores que descubrió a finales del año pasado que modelos lingüísticos de gran tamaño, como GPT-4, Llama 2 y Claude, son capaces de inferir información sensible como el origen étnico, la ubicación y la ocupación de las personas a partir de conversaciones mundanas con un chatbot. En teoría, cualquiera con acceso a estos modelos podría utilizarlos de esta forma.

Desde la publicación de este artículo, han surgido nuevos servicios que explotan esta característica de los modelos lingüísticos.

Aunque la existencia de estos servicios no indica actividad delictiva, señala las nuevas capacidades a las que podrían acceder los actores malintencionados. Y si la gente normal puede construir herramientas de vigilancia como esta, los actores estatales probablemente tengan sistemas mucho mejores, afirma Balunović.

«La única forma de prevenir estas cosas es trabajar en las defensas», afirma.

Las empresas deben invertir en protección de datos y seguridad, añade.

En cuanto a los particulares, la clave es una mayor concienciación. La gente debería pensarse dos veces lo que comparte en línea y decidir si se siente cómoda con que sus datos personales se utilicen en modelos lingüísticos, afirma Balunović.