Así es cómo las grandes empresas tecnológicas, las 'start-ups', los dispositivos de IA y las guerras comerciales transformarán el modo en que se fabrican los chips y las tecnologías que impulsan

La serie 'What's Next' de 'MIT Technology Review' analiza distintos sectores, tendencias y tecnologías para ofrecerte una visión anticipada del futuro. Puedes leer el resto aquí.

Gracias al auge de la inteligencia artificial, el mundo de los chips está a punto de experimentar un enorme cambio. Hay una gran demanda de chips que puedan entrenar modelos de IA más rápidamente y comunicarse con ellos desde dispositivos como teléfonos inteligentes y satélites, permitiéndonos utilizar estos modelos sin revelar datos privados. Gobiernos, gigantes tecnológicos y start-ups por igual están compitiendo por hacerse con su parte del creciente pastel de los semiconductores.

He aquí cuatro tendencias que tener en cuenta en el próximo año, que definirán cómo serán los chips del futuro, quién los fabricará y qué nuevas tecnologías desbloquearán.

Leyes de chips por todo el mundo

En las afueras de Phoenix (Arizona, EE UU), dos de los mayores fabricantes de chips del mundo, TSMC e Intel, se apresuran a construir campus en el desierto que esperan que se conviertan en las sedes de la pericia estadounidense en la fabricación de chips. Una cosa que tienen en común es su financiación: en marzo, el presidente Joe Biden anunció 8.500 millones de dólares (unos 7.832 millones de euros) en fondos federales directos y 11.000 millones (en torno a 10.136 millones de euros) en préstamos para las ampliaciones de Intel en todo el país. Semanas después, se anunciaron otros 6.600 millones (6.081 millones de euros) para TSMC.

Estas ayudas son solo una parte de los subsidios que EE UU destina a la industria de los chips a través de la Ley de CHIPS y Ciencia, dotada con 280.000 millones de dólares (unos 258.000 millones de euros) y firmada en 2022. El dinero significa que cualquier empresa con un pie en el ecosistema de los semiconductores está analizando cómo reestructurar sus cadenas de suministro para beneficiarse de este capital. Aunque gran parte del dinero se destina a impulsar la fabricación estadounidense de chips, hay margen para que otros actores presenten su candidatura, desde fabricantes de equipos hasta start-ups de materiales especializados.

Pero Estados Unidos no es el único país que intenta desarrollar localmente parte de la cadena de suministro de la fabricación de chips. Japón gastará 13.000 millones de dólares (unos 11.979 millones de euros) en su propio equivalente a la Ley CHIPS, Europa gastará más de 47.000 millones de dólares (en torno a 43.313 millones de euros) y, a principios de este año, India anunció un esfuerzo de 15.000 millones de dólares (alrededor de 13.823 millones de euros) para construir plantas locales de chips. Las raíces de esta tendencia se remontan a 2014, dice Chris Miller, profesor de la Universidad de Tufts (Massachusetts, EE UU) y autor de Chip War: The Fight for the World's Most Critical Technology (traducido al español como La guerra de los chips: La gran lucha por el dominio mundial). Fue entonces cuando China empezó a ofrecer subvenciones masivas a sus fabricantes de chips.

«Esto creó una dinámica en la que otros Gobiernos llegaron a la conclusión de que no tenían más remedio que ofrecer incentivos o ver cómo las empresas trasladaban la fabricación a China», afirma. Esa amenaza, unida al auge de la IA, ha llevado a los Gobiernos occidentales a financiar alternativas. En el próximo año, esto podría tener un efecto bola de nieve, con aún más países iniciando sus propios programas por miedo a quedarse atrás.

Según Miller, es poco probable que el dinero genere nuevos competidores en el sector de los chips o que reestructure fundamentalmente quiénes son los principales actores de este sector. Por el contrario, incentivará sobre todo a las empresas dominantes, como TSMC, a establecerse en varios países. Pero la financiación por sí sola no bastará para hacerlo rápidamente: los esfuerzos de TSMC por construir plantas en Arizona se han visto envueltos en incumplimientos de plazos y conflictos laborales, e Intel tampoco ha cumplido los plazos prometidos. Y no está claro si, cuando las plantas entren en funcionamiento, sus equipos y mano de obra serán capaces del mismo nivel de fabricación avanzada de chips que las empresas mantienen en el extranjero.

«La cadena de suministro cambiará lentamente, a lo largo de años y décadas», afirma Miller. «Pero está cambiando».

Más IA de frontera

Actualmente, la mayoría de nuestras interacciones con modelos de IA como ChatGPT se realizan a través de la nube. Eso significa que cuando le pides a GPT que te elija un conjunto (o que sea tu novio), tu petición se envía a los servidores de OpenAI, lo que hace que el modelo alojado allí la procese y saque conclusiones (lo que se conoce como «inferencia») antes de enviarte una respuesta. Depender de la nube tiene algunos inconvenientes: por un lado, requiere acceso a Internet y, por otro, significa que algunos de tus datos se comparten con el creador del modelo.

Por eso ha habido mucho interés e inversión en la computación frontera (edge computing) para la IA, donde el proceso de hacer "ping" al modelo de IA tiene lugar directamente en tu dispositivo, como un portátil o un smartphone. Con el sector trabajando cada vez más hacia un futuro en el que los modelos de IA sepan mucho sobre nosotros (Sam Altman me describió su aplicación estrella de IA como una que sabe «absolutamente todo sobre toda mi vida, cada correo electrónico, cada conversación que he tenido»), existe una demanda de chips «frontera» más rápidos que puedan ejecutar modelos sin compartir datos privados. Estos chips se enfrentan a limitaciones diferentes de las de los centros de datos: normalmente tienen que ser más pequeños, más baratos y más eficientes energéticamente.

El Departamento de Defensa de EE UU está financiando numerosas investigaciones sobre computación frontera rápida y privada. En marzo, su rama de investigación, la Agencia de Proyectos de Investigación Avanzados de Defensa (DARPA, por sus siglas en inglés), anunció una asociación con el fabricante de chips EnCharge AI para crear un chip de computación frontera ultrapotente utilizado para la inferencia de la IA. EnCharge AI está trabajando en la creación de un chip que permita mejorar la privacidad pero que también pueda funcionar con muy poca energía. Esto lo hará adecuado para aplicaciones militares como satélites y equipos de vigilancia sin conexión a la red. La empresa espera comercializar los chips en 2025.

Los modelos de IA siempre dependerán de la nube para algunas aplicaciones, pero las nuevas inversiones y el interés por mejorar la computación frontera podrían llevar chips más rápidos, y por tanto más IA, a nuestros dispositivos cotidianos. Si los chips frontera son lo suficientemente pequeños y baratos, es probable que veamos aún más «dispositivos inteligentes» basados en IA en nuestros hogares y lugares de trabajo. En la actualidad, los modelos de IA se limitan sobre todo a los centros de datos.

«Muchos de los retos que vemos en los centros de datos se superarán», afirma Naveen Verma, cofundador de EnCharge AI. «Espero ver un gran enfoque en la frontera. Creo que va a ser fundamental para conseguir IA a escala».

Las grandes tecnológicas entran en la batalla de fabricación de chips

En sectores que van desde la moda rápida al cuidado del césped, las empresas están pagando cantidades exorbitantes en costes de computación para crear y entrenar modelos de IA para sus negocios. Los ejemplos incluyen modelos que los empleados pueden utilizar para escanear y resumir documentos, así como tecnologías de cara al exterior como agentes virtuales que puedan guiar al usuario sobre cómo reparar su nevera rota. Esto significa que la demanda de computación en la nube para entrenar esos modelos está por las nubes.

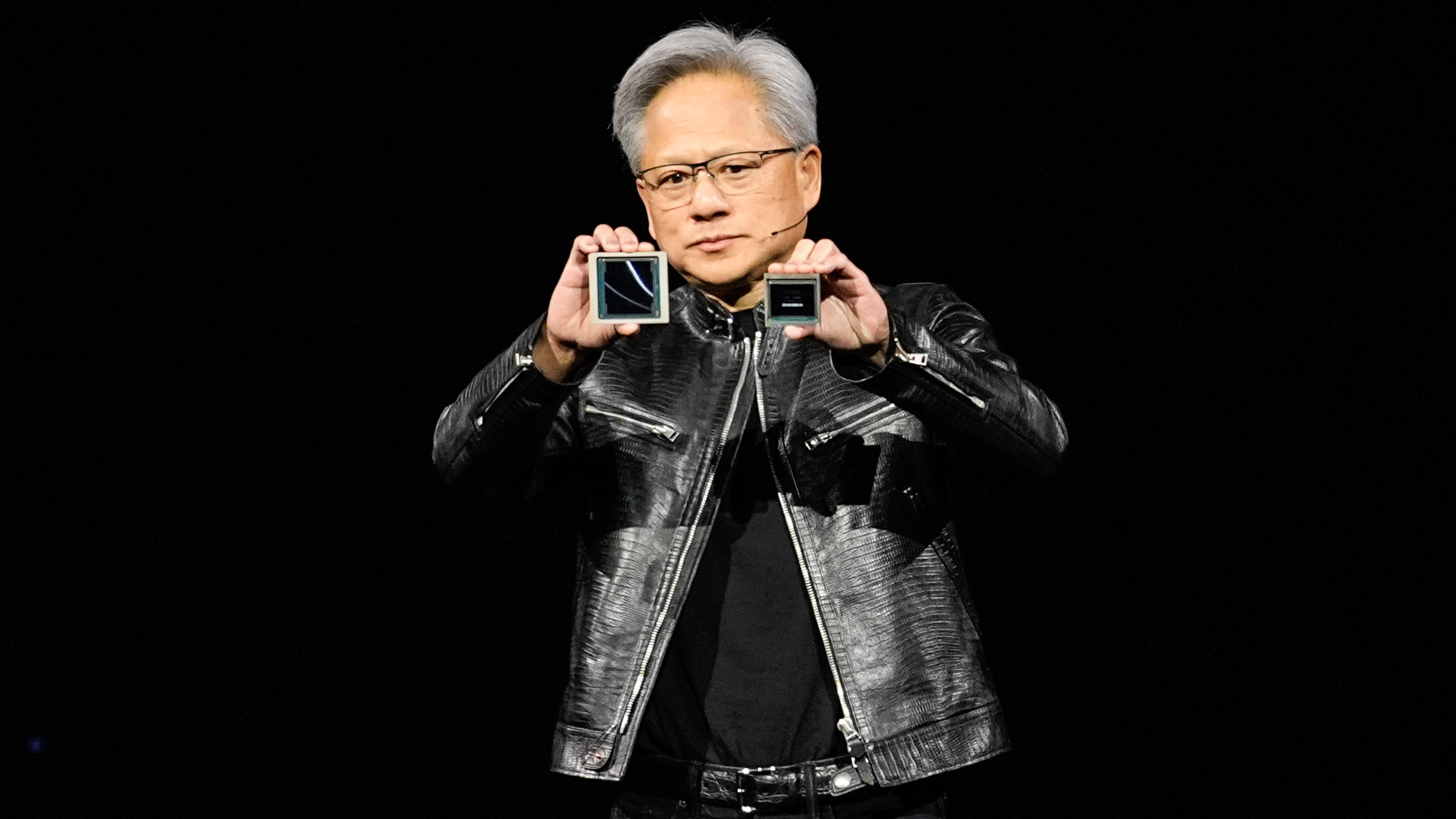

Las empresas que proporcionan la mayor parte de esa potencia informática son Amazon, Microsoft y Google. Durante años, estos gigantes tecnológicos han soñado con aumentar sus márgenes de beneficio fabricando internamente los chips para sus centros de datos en lugar de comprarlos a empresas como Nvidia, un gigante con casi el monopolio de los chips de entrenamiento de la IA más avanzados y un valor superior al PIB de 183 países.

Amazon comenzó su esfuerzo en 2015, adquiriendo la start-up Annapurna Labs. Google movió ficha a continuación en 2018 con sus propios chips, llamados TPU. Microsoft lanzó sus primeros chips de IA en noviembre, y Meta presentó una nueva versión de sus propios chips de entrenamiento de la IA en abril.

Esa tendencia podría inclinar la balanza en detrimento de Nvidia. Pero Nvidia no solo desempeña el papel de rival a los ojos de las grandes tecnológicas: independientemente de sus propios esfuerzos internos, los gigantes de la nube siguen necesitando sus chips para sus centros de datos. Esto se debe en parte a que sus propios esfuerzos de fabricación de chips no pueden satisfacer todas sus necesidades, pero también a que sus clientes esperan poder utilizar chips Nvidia de gama alta.

«Se trata de dar a los clientes la posibilidad de elegir», afirma Rani Borkar, responsable de Hardware de Microsoft Azure. Afirma que no se imagina un futuro en el que Microsoft suministre todos los chips para sus servicios en la nube: «Continuaremos con nuestras sólidas alianzas y desplegaremos chips de todos los socios con los que trabajamos».

Mientras los gigantes de la computación en nube intentan arrebatar un poco de cuota de mercado a los fabricantes de chips, Nvidia está intentando lo contrario. El año pasado, la compañía puso en marcha su propio servicio en la nube para que los clientes puedan prescindir de Amazon, Google o Microsoft y obtener directamente tiempo de computación en los chips de Nvidia. A medida que se desarrolle esta dramática lucha por la cuota de mercado, el próximo año se decidirá si los clientes ven los chips de las grandes tecnológicas como parejos a los chips más avanzados de Nvidia, o más bien como sus primos pequeños.

Nvidia se enfrenta a las start-ups

A pesar del dominio de Nvidia, hay una ola de inversión que fluye hacia las start-ups que aspiran a competir con ella en ciertos segmentos del mercado de chips del futuro. Todas estas empresas prometen un entrenamiento más rápido de la IA, pero tienen ideas diferentes sobre qué tecnología de computación los llevará hasta allí, desde la cuántica a la fotónica, pasando por la computación reversible.

Pero Murat Onen, el fundador de 28 años de una de esas empresas de chips, Eva, que surgió de su trabajo de doctorado en el MIT (Instituto Tecnológico de Massachussets, EE UU), es franco sobre lo que supone crear una empresa de chips en estos momentos.

«El rey de la colina es Nvidia, y ese es el mundo en el que vivimos», afirma.

Muchas de estas empresas, como SambaNova, Cerebras y Graphcore, están intentando cambiar la arquitectura subyacente de los chips. Imaginemos que un chip acelerador de la IA tiene que mover constantemente datos de un área a otra: un dato se almacena en la zona de memoria, pero debe pasar a la zona de procesamiento, donde se realiza un cálculo, y luego volver a almacenarse en la zona de memoria para su custodia. Todo eso requiere tiempo y energía.

Si el proceso fuera más eficiente, el entrenamiento de la IA sería más rápido y barato para los clientes, pero solo si el fabricante de chips dispone de un software lo suficientemente bueno como para que la empresa de entrenamiento de la IA pueda realizar la transición al nuevo chip sin problemas. Si la transición de software es demasiado complicada, es probable que los creadores de modelos como OpenAI, Anthropic y Mistral se queden con los grandes fabricantes de chips, lo que significa que las empresas que adoptan este enfoque, como SambaNova, dedican mucho tiempo no solo al diseño de chips, sino también al de software.

Onen propone cambios más profundos. En lugar de los transistores tradicionales, que han proporcionado una mayor eficiencia durante décadas haciéndose cada vez más pequeños, está utilizando un nuevo componente llamado transistor controlado por protones que, según dice, Eva diseñó específicamente para las necesidades matemáticas del entrenamiento de la IA. Permite a los dispositivos almacenar y procesar datos en el mismo lugar, lo que ahorra tiempo y energía informática. La idea de utilizar un componente de este tipo para la inferencia de la IA se remonta a la década de 1960, pero los investigadores nunca pudieron averiguar cómo utilizarlo para el entrenamiento de la IA, en parte debido a un obstáculo relativo a los materiales: requiere un material que pueda, entre otras cualidades, controlar con precisión la conductividad a temperatura ambiente.

Un día en el laboratorio, «optimizando estos números y teniendo mucha suerte, conseguimos el material que queríamos», dice Onen. «De repente, el dispositivo no es un proyecto de feria de ciencias». Eso planteó la posibilidad de utilizar ese componente a escala. Tras meses de trabajo para confirmar que los datos eran correctos, fundó Eva, y el trabajo se publicó en Science.

Pero en un sector en el que tantos fundadores han prometido derrocar el dominio de los principales fabricantes de chips —y fracasado en el empeño—, Onen admite con franqueza que pasarán años antes de que sepa si el diseño funciona según lo previsto y si los fabricantes aceptarán producirlo. Dirigir una empresa en medio de esa incertidumbre, afirma, exige flexibilidad y apetito por el escepticismo de los demás.

«Creo que a veces la gente se aferra demasiado a sus ideas, y se siente insegura de que si esto desaparece no habrá nada más», afirma. «No creo que yo me sienta así. Sigo buscando gente que nos desafíe y diga que esto está mal».