Inteligencia Artificial

Hacia una definición única y consensuada de la IA de código abierto más allá de las 'big tech'

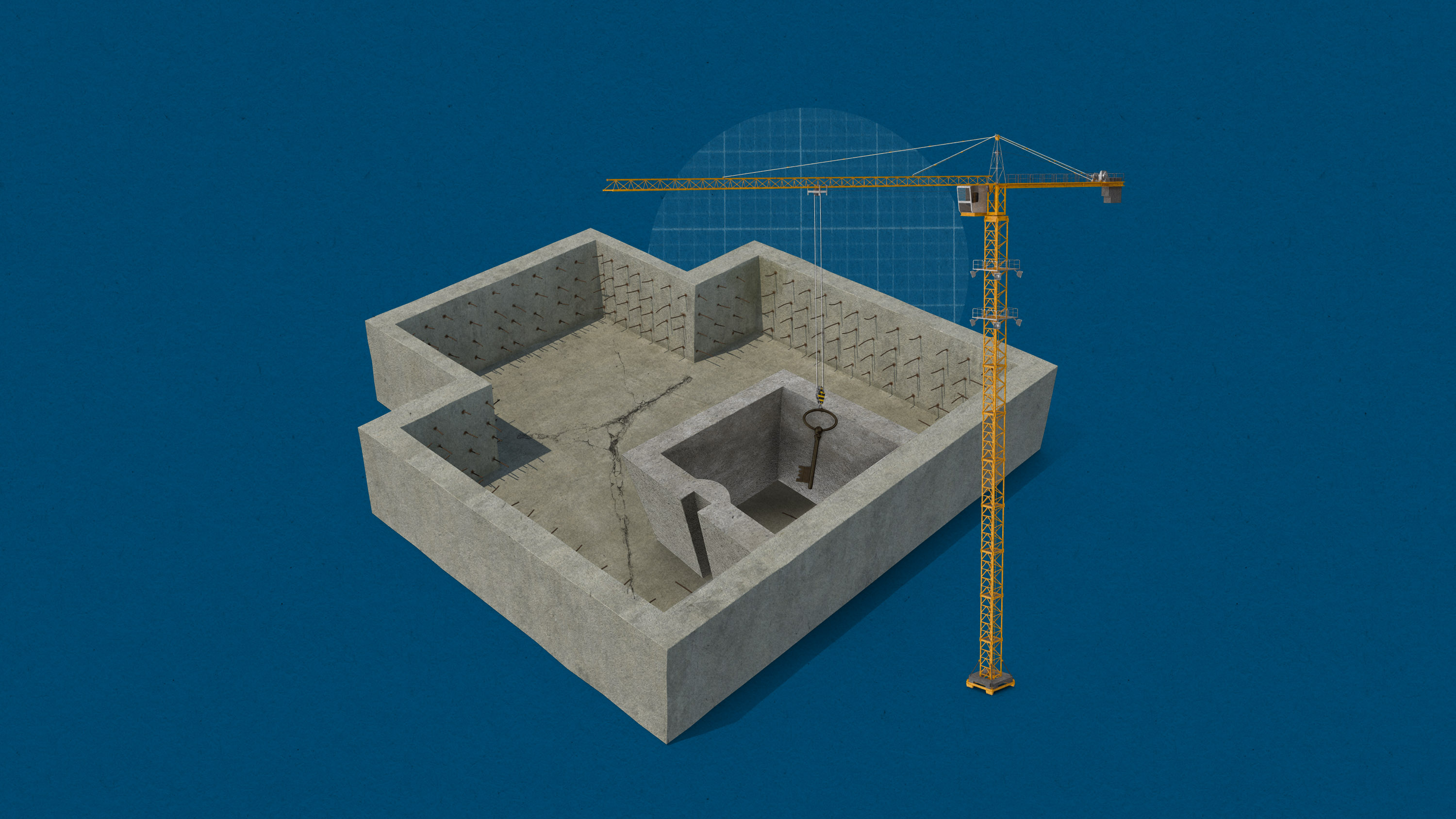

La definición de qué es la IA de código abierto podría determinar quién dará forma al futuro de la tecnología

De repente, "código abierto" es la última palabra de moda en los círculos de la IA. Meta se ha comprometido a crear una inteligencia artificial general de código abierto. Y Elon Musk ha demandado a OpenAI por su falta de modelos de IA de código abierto.

Mientras tanto, un número cada vez mayor de líderes y empresas tecnológicas se erigen en adalides del código abierto.

Pero hay un problema fundamental: nadie se pone de acuerdo sobre qué significa "IA de código abierto".

A primera vista, la IA de código abierto promete un futuro en el que cualquiera pueda participar en el desarrollo de la tecnología. Eso podría acelerar la innovación, aumentar la transparencia y dar a los usuarios un mayor control sobre sistemas que pronto podrían remodelar muchos aspectos de nuestras vidas. Pero ¿qué es? ¿Qué hace que un modelo de IA sea de código abierto y qué lo descalifica?

Las respuestas podrían tener importantes ramificaciones para el futuro de la tecnología. Hasta que la industria tecnológica no haya establecido una definición, las empresas potentes pueden adaptar fácilmente el concepto a sus propias necesidades, y podría convertirse en una herramienta para afianzar el dominio de los principales actores actuales.

La Iniciativa de Código Abierto (OSI, por sus siglas en inglés), que se ha autoproclamado árbitro de lo que significa el código abierto, ha entrado en la refriega. Fundada en 1998, esta organización sin ánimo de lucro es la guardiana de la Definición de Código Abierto, un conjunto de normas ampliamente aceptadas que determinan si un programa informático puede considerarse de código abierto.

Ahora, la organización ha reunido a un grupo de 70 investigadores, abogados, responsables políticos, activistas y representantes de grandes empresas tecnológicas como Meta, Google y Amazon para elaborar una definición práctica de la IA de código abierto.

Sin embargo, la comunidad del código abierto es un gran paraguas, que abarca desde hacktivistas hasta empresas de la lista Fortune 500. Aunque existe un amplio acuerdo sobre los principios generales, dice Stefano Maffulli, director ejecutivo de la OSI, cada vez es más evidente que la clave está en los detalles. Con tantos intereses contrapuestos, no es fácil encontrar una solución que satisfaga a todos y garantice que las grandes empresas sigan el juego.

Criterios difusos

La falta de una definición clara no ha impedido a las empresas tecnológicas adoptar el término.

El pasado mes de julio, Meta puso a disposición del público su modelo Llama 2, que calificó de código abierto y libre acceso; y cuenta con un historial de divulgación pública de tecnologías de IA. "Apoyamos el esfuerzo de la OSI por definir la IA de código abierto y esperamos seguir participando en su proceso en beneficio de la comunidad de código abierto de todo el mundo", nos dijo Jonathan Torres, asesor general asociado de Meta para IA, código abierto y licencias.

Esto contrasta notablemente con su rival OpenAI, que a lo largo de los años ha compartido cada vez menos detalles sobre sus principales modelos, alegando motivos de seguridad. "Solo abrimos modelos de IA potentes una vez que hemos sopesado cuidadosamente los beneficios y los riesgos, incluidos el uso indebido y la aceleración", dijo un portavoz.

Otras empresas líderes en IA, como Stability AI y Aleph Alpha, también han publicado modelos descritos como de código abierto, y Hugging Face alberga una gran biblioteca de modelos de IA de libre acceso.

Mientras que Google ha adoptado un enfoque más cerrado con sus modelos más potentes, como Gemini y PaLM 2, los modelos Gemma publicados el mes pasado son de libre acceso y están diseñados para competir con Llama 2, aunque la empresa los describió como "abiertos" en lugar de "de código abierto".

Sin embargo, existe un desacuerdo considerable sobre si alguno de estos modelos puede calificarse realmente de código abierto. Para empezar, tanto Llama 2 como Gemma vienen con licencias que restringen lo que los usuarios pueden hacer con los modelos. Esto va en contra de los principios del código abierto: una de las cláusulas clave de la Definición de Código Abierto prohíbe la imposición de cualquier restricción basada en casos de uso.

Los criterios son difusos incluso para los modelos que no vienen con este tipo de condiciones. El concepto de código abierto se ideó para garantizar que los desarrolladores pudieran utilizar, estudiar, modificar y compartir software sin restricciones. Pero la IA funciona de forma fundamentalmente distinta y los conceptos clave no se trasladan con claridad del software a la IA, dice Maffulli.

Uno de los mayores obstáculos es la enorme cantidad de ingredientes que intervienen en los modelos actuales de IA. Todo lo que se necesita para manipular un programa de software es el código fuente subyacente, dice Maffulli. Pero dependiendo del objetivo, trastear con un modelo de IA puede requerir el acceso al modelo entrenado, sus datos de entrenamiento, el código utilizado para preprocesar estos datos, el código que rige el proceso de entrenamiento, la arquitectura subyacente del modelo, o una serie de otros detalles más sutiles.

Qué ingredientes se necesitan para estudiar y modificar los modelos de forma significativa queda abierto a la interpretación. "Hemos identificado qué libertades o derechos básicos queremos poder ejercer", dice Maffulli. "La mecánica de cómo ejercer esos derechos no está clara".

Resolver este debate será esencial si la comunidad de la IA quiere cosechar los mismos beneficios que los desarrolladores de software obtuvieron del código abierto, dice Maffulli, que se construyó sobre un amplio consenso sobre el significado del término. "Tener [una definición] respetada y adoptada por una gran parte del sector aporta claridad", afirma. "Y la claridad conlleva menores costes de cumplimiento, menos fricciones y un entendimiento común".

El mayor escollo, con diferencia, son los datos. Todas las grandes empresas de IA se han limitado a publicar modelos preentrenados, sin los conjuntos de datos con los que se han entrenado. Según Maffulli, para quienes abogan por una definición más estricta de la IA de código abierto, esto limita seriamente los esfuerzos por modificar y estudiar los modelos, descalificándolos automáticamente como código abierto.

Otros han argumentado que una simple descripción de los datos suele bastar para sondear un modelo, dice Maffulli, y no necesariamente hay que volver a entrenarlo desde cero para hacer modificaciones. Los modelos preentrenados se adaptan habitualmente mediante un proceso conocido como fine-tuning o perfeccionamiento, por el que se vuelven a entrenar parcialmente con un conjunto de datos más pequeño, a menudo específico para una aplicación.

La Llama 2 de Meta es un ejemplo de ello, dice Roman Shaposhnik, CEO de la empresa de IA de código abierto Ainekko y vicepresidente de asuntos legales de la Apache Software Foundation, que participa en el proceso de la OSI. Aunque Meta solo publicó un modelo preentrenado, una floreciente comunidad de desarrolladores lo ha estado descargando y adaptando, y compartiendo sus modificaciones.

"La gente lo utiliza en todo tipo de proyectos. Hay todo un ecosistema a su alrededor", afirma. "Por tanto, debemos llamarlo de alguna manera. ¿Está entreabierto? ¿Está entornado?".

Aunque sea técnicamente posible modificar un modelo sin sus datos de entrenamiento originales, restringir el acceso a un ingrediente clave contradice el espíritu del código abierto, dice Zuzanna Warso, directora de investigación de la organización sin ánimo de lucro Open Future, que participa en los debates de la OSI. También es discutible si es posible ejercer realmente la libertad de estudiar un modelo sin saber con qué información se ha formado.

"Es un componente crucial de todo este proceso", afirma. "Si nos importa la apertura, también debería importarnos la apertura de los datos".

Tenerlo todo

Es importante entender por qué las empresas que se presentan como campeonas del código abierto son reacias a ceder los datos de entrenamiento. El acceso a datos de entrenamiento de alta calidad es un importante cuello de botella para la investigación en IA y una ventaja competitiva para las grandes empresas que están ansiosas por mantener, afirma Warso.

Al mismo tiempo, el código abierto conlleva una serie de ventajas que a estas empresas les gustaría ver trasladadas a la IA. A nivel superficial, el término "código abierto" tiene connotaciones positivas para mucha gente, por lo que participar en el llamado open washing o “lavado de cara abierto” puede ser una victoria fácil de relaciones públicas, dice Warso.

También puede tener un impacto significativo en su cuenta de resultados. Economistas de la Harvard Business School descubrieron recientemente que el software de código abierto ha ahorrado a las empresas casi 9 billones de dólares (unos 8,3 billones de euros) en costes de desarrollo al permitirles crear sus productos sobre software libre de alta calidad en lugar de escribirlo ellas mismas.

En el caso de las grandes empresas, abrir su software para que pueda ser reutilizado y modificado por otros desarrolladores puede ayudar a crear un potente ecosistema en torno a sus productos, afirma Warso. El ejemplo clásico es el de Google, que abrió el código de su sistema operativo móvil Android y consolidó su posición dominante en el centro de la revolución de los smartphones. Mark Zuckerberg, de Meta, ha sido explícito sobre esta motivación en las discusiones sobre resultados financieros, diciendo que "el software de código abierto a menudo se convierte en un estándar de la industria, y cuando las empresas estandarizan la construcción sobre nuestro producto, luego se hace más fácil integrar nuevas innovaciones en nuestros productos".

También parece que la IA de código abierto puede recibir un trato normativo favorable en algunos lugares, afirma Warso, señalando la recién aprobada Ley de IA de la UE, que exime a ciertos proyectos de código abierto de algunos de sus requisitos más estrictos.

En conjunto, está claro por qué compartir modelos preentrenados pero restringir el acceso a los datos necesarios para crearlos tiene sentido desde el punto de vista empresarial, afirma Warso. Sin embargo, añade, parece que las empresas intentan tenerlo todo. Y si la estrategia ayuda a afianzar las posiciones ya dominantes de las grandes empresas tecnológicas, es difícil ver cómo encaja con la ética subyacente del código abierto.

"Consideramos que la apertura es una de las herramientas para hacer frente a la concentración de poder", afirma Warso. "Si se supone que la definición ayuda a desafiar estas concentraciones de poder, entonces la cuestión de los datos cobra aún más importancia".

Shaposhnik cree que es posible llegar a un compromiso. Una cantidad significativa de los datos utilizados para entrenar los modelos más grandes ya procede de repositorios abiertos como Wikipedia o Common Crawl, que extraen datos de la web y los comparten libremente. Las empresas podrían simplemente compartir los recursos abiertos utilizados para entrenar sus modelos, dice, haciendo posible recrear una aproximación razonable que debería permitir a la gente estudiar y entender los modelos.

La falta de claridad sobre si entrenar a la IA con obras de arte o textos extraído de internet infringe los derechos de propiedad del creador puede causar complicaciones legales, afirma Aviya Skowron, responsable de política y ética del grupo de investigación en IA sin ánimo de lucro EleutherAI, que también participa en el proceso de la OSI. Esto hace que los desarrolladores se muestren reticentes a la hora de divulgar sus datos.

Stefano Zacchiroli, catedrático de Informática del Instituto Politécnico de París, que también contribuye a la definición de la OSI, destaca la necesidad de ser pragmáticos. Su opinión personal es que una descripción completa de los datos de entrenamiento de un modelo es lo mínimo para calificarlo de código abierto, pero reconoce que las definiciones más estrictas de la IA de código abierto podrían no gozar de un gran atractivo.

En última instancia, la comunidad tiene que decidir lo que quiere conseguir, dice Zacchiroli: "¿Estamos sencillamente siguiendo la evolución del mercado para que no se apropie del término 'IA de código abierto', o estamos intentando que el mercado sea más abierto y ofrezca más libertades a los usuarios?".

¿Qué sentido tiene el código abierto?

En cualquier caso, es discutible hasta qué punto cualquier definición de IA de código abierto igualará las reglas del juego, afirma Sarah Myers West, codirectora ejecutiva del AI Now Institute. Es coautora de un artículo publicado en agosto de 2023 en el que se exponía la falta de apertura de muchos proyectos de IA de código abierto. Pero también ponía de relieve que las enormes cantidades de datos y potencia de cálculo necesarias para entrenar la IA de vanguardia crean barreras estructurales más profundas para los agentes más pequeños, por muy abiertos que sean los modelos.

Myers West cree que tampoco está claro qué se espera conseguir con la IA de código abierto. "¿Es la seguridad, es la capacidad de realizar investigación académica, es intentar fomentar una mayor competencia?", se pregunta. "Tenemos que ser mucho más precisos sobre cuál es el objetivo, y luego cómo la apertura de un sistema cambia la búsqueda de ese objetivo".

El OSI parece dispuesto a evitar esas conversaciones. El borrador de la definición menciona la autonomía y la transparencia como ventajas clave, pero Maffulli se mostró reticente cuando se le pidió que explicara por qué el OSI valora esos conceptos. El documento también contiene una sección titulada "cuestiones fuera del ámbito de aplicación" que deja claro que la definición no se adentrará en cuestiones relacionadas con la IA "ética, fiable o responsable".

Maffulli afirma que, históricamente, la comunidad del código abierto se ha centrado en facilitar el intercambio de software sin fricciones y ha evitado enredarse en debates sobre para qué debe utilizarse ese software. "No es nuestro trabajo", afirma.

Pero esas cuestiones no pueden descartarse, dice Warso, por mucho que la gente lo haya intentado durante décadas. La idea de que la tecnología es neutral y que temas como la ética están "fuera del alcance" es un mito, añade. Un mito, sospecha, que es necesario mantener para evitar que la coalición de la comunidad del código abierto se fracture. "Creo que la gente se da cuenta de que [el mito] no es real, pero lo necesitamos para avanzar", afirma Warso.

Más allá de la OSI, otros han adoptado un enfoque diferente. En 2022, un grupo de investigadores presentó las Licencias Responsables de Inteligencia Artificial (RAIL, por sus siglas en inglés), que son similares a las licencias de código abierto pero incluyen cláusulas que pueden restringir casos de uso específicos. El objetivo, dice Danish Contractor, un investigador de IA que cocreó la licencia, es permitir a los desarrolladores evitar que su trabajo se utilice para cosas que consideren inapropiadas o poco éticas.

"Como investigador, no me gustaría que mi trabajo se utilizara de forma perjudicial", afirma. Y no es el único: un análisis reciente que él y sus colegas realizaron sobre la popular plataforma de alojamiento de modelos de la start-up de IA Hugging Face descubrió que el 28% de los modelos utiliza RAIL.

La licencia que Google adjuntó a su Gemma sigue un planteamiento similar. Sus condiciones de uso enumeran varios casos de uso prohibidos considerados "perjudiciales", lo que refleja su "compromiso con el desarrollo responsable de la IA", afirma la empresa en una reciente entrada de su blog. Sus licencias ImpACT restringen la redistribución de modelos y datos en función de sus riesgos potenciales.

Dado lo diferente que es la IA del software convencional, es inevitable que se experimente con distintos grados de apertura, lo que probablemente sea bueno para el sector, afirma Luis Villa, cofundador y responsable jurídico de la empresa de gestión de software de código abierto Tidelift. Pero le preocupa que la proliferación de licencias "más o menos abiertas" incompatibles entre sí pueda anular la colaboración sin fricciones que ha dado tanto éxito al código abierto, ralentizando la innovación en IA, reduciendo la transparencia y dificultando que los actores más pequeños se basen en el trabajo de los demás.

En última instancia, Villa cree que la comunidad debe unirse en torno a una norma única, de lo contrario la industria simplemente la ignorará y decidirá por sí misma lo que significa "abierto". Sin embargo, no envidia el trabajo de la OSI. Cuando elaboró la definición de software de código abierto tuvo el lujo de disponer de tiempo y de poco escrutinio externo. Hoy, la IA está en el punto de mira tanto de las grandes empresas como de los reguladores.

Pero si la comunidad del software libre no logra establecer una definición, y hacerlo rápidamente, alguien inventará una que se adapte a sus propias necesidades. "Van a llenar ese vacío", dice Villa. "Mark Zuckerberg va a decirnos a todos lo que él cree que significa 'abierto', y tiene un megáfono muy grande".