Durante un tiempo, los investigadores pensaron que tendrían que conformarse con sistemas ruidosos y propensos a errores, al menos a corto plazo. Esto está empezando a cambiar.

En los últimos 20 años, cientos de empresas, entre ellas gigantes como Google, Microsoft e IBM, se han lanzado a la conquista de la computación cuántica. Hasta la fecha, los inversores han invertido más de 5.000 millones de dólares. Todo este esfuerzo tiene un único objetivo: conseguir el próximo gran avance del mundo.

Los ordenadores cuánticos utilizan las reglas contraintuitivas que rigen la materia a nivel atómico y subatómico para procesar la información de formas imposibles con los ordenadores convencionales o "clásicos". Los expertos sospechan que esta tecnología podrá influir en campos tan dispares como el descubrimiento de fármacos, la criptografía, las finanzas y la logística de la cadena de suministro.

La promesa está ahí, pero también el bombo. En 2022, por ejemplo, Haim Israel, director general de investigación del Bank of America, declaró que la computación cuántica será "más grande que el fuego y más grande que todas las revoluciones que ha visto la humanidad". Incluso entre los científicos, un sinfín de afirmaciones y despiadadas réplicas lo han convertido en un campo difícil de evaluar.

En última instancia, sin embargo, evaluar nuestro progreso en la construcción de ordenadores cuánticos útiles se reduce a un factor clave: si podemos manejar el ruido. La delicada naturaleza de los sistemas cuánticos los hace extremadamente vulnerables a la más mínima perturbación, ya sea un fotón perdido creado por el calor, una señal aleatoria de la electrónica circundante o una vibración física. Este ruido causa estragos, generando errores o incluso deteniendo un cálculo cuántico en seco. No importa lo grande que sea su procesador ni cuáles puedan llegar a ser sus aplicaciones más revolucionarias: a menos que se pueda domar el ruido, un ordenador cuántico nunca superará lo que puede hacer un ordenador clásico.

Durante muchos años, los investigadores pensaron que tendrían que conformarse con circuitos ruidosos, al menos a corto plazo, y muchos buscaron aplicaciones que pudieran hacer algo útil con esa capacidad limitada. La caza no ha ido especialmente bien, pero puede que eso no importe ahora. En los últimos dos años, los avances teóricos y experimentales han permitido a los investigadores declarar que el problema del ruido podría estar por fin contra las cuerdas. Una combinación de estrategias de hardware y software resulta prometedora para suprimir, mitigar y limpiar los errores cuánticos. No es un método especialmente elegante, pero parece que podría funcionar, y antes de lo esperado.

"Cada vez veo más pruebas en defensa del optimismo", afirma Earl Campbell, vicepresidente de ciencia cuántica de Riverlane, una empresa de informática cuántica con sede en Cambridge (Reino Unido).

Incluso los más escépticos se están convenciendo. La profesora de la Universidad de Helsinki Sabrina Maniscalco, por ejemplo, investiga el impacto del ruido en los cálculos. Hace una década, dice, no tenía mucha fe en la computación cuántica. "Pensaba que existían problemas realmente fundamentales. No estaba segura de que hubiera una salida", afirma. Ahora, sin embargo, trabaja en el uso de sistemas cuánticos para diseñar versiones mejoradas de fármacos contra el cáncer activados por luz que sean eficaces a concentraciones más bajas y puedan activarse con una forma de luz menos dañina. Cree que sólo faltan dos años y medio para que el proyecto tenga éxito. Para Maniscalco, la era de la "utilidad cuántica" (el punto en el que, para determinadas tareas, tiene sentido utilizar un procesador cuántico en lugar de uno clásico) está a punto de llegar. "Estoy bastante segura de que muy pronto entraremos en la era de la utilidad cuántica", afirma.

Llevar los cúbits a la nube

Este gran avance llega tras más de una década de decepción. A finales de la década de los 2000 y principios de la de 2010, los investigadores que construían y utilizaban ordenadores cuánticos en el mundo real descubrieron que eran mucho más problemáticos de lo que habían esperado los teóricos.

Para algunos, estos problemas parecían insuperables. Pero otros, como Jay Gambetta, no se inmutaron.

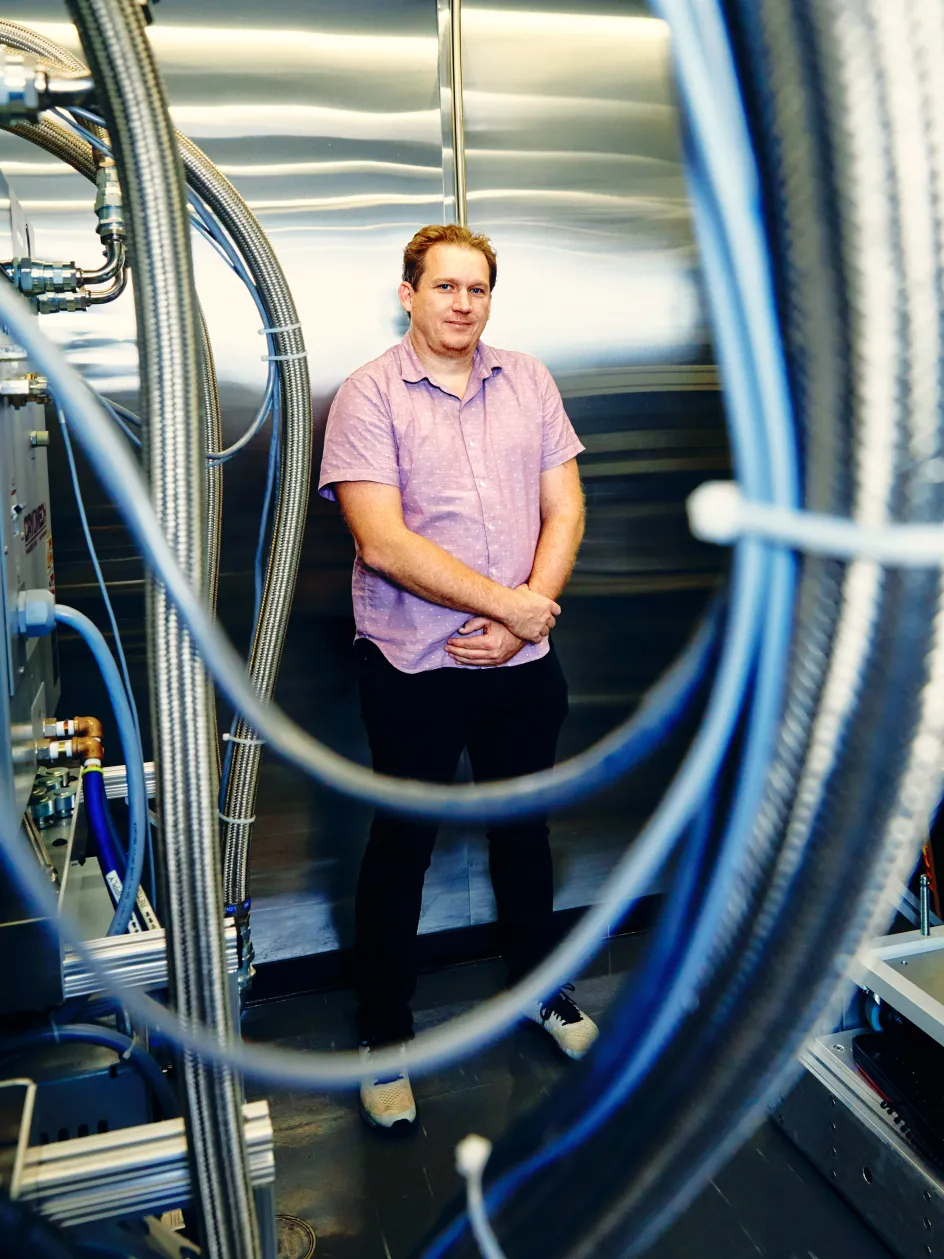

Gambetta, un australiano de voz tranquila, es doctor en Física por la Universidad de Griffith, en la Costa Dorada de Australia. Decidió ir allí en parte porque le permitía alimentar su adicción al surf. Pero en julio de 2004 se marchó al hemisferio norte para investigar en la Universidad de Yale las propiedades cuánticas de la luz. Tres años más tarde (para entonces convertido ya un exsurfista gracias a las frías aguas de New Haven), Gambetta se trasladó aún más al norte, a la Universidad de Waterloo, en Ontario (Canadá). Entonces se enteró de que IBM quería dedicar más esfuerzos a la computación cuántica. En 2011, Gambetta se convirtió en uno de los nuevos fichajes de la empresa.

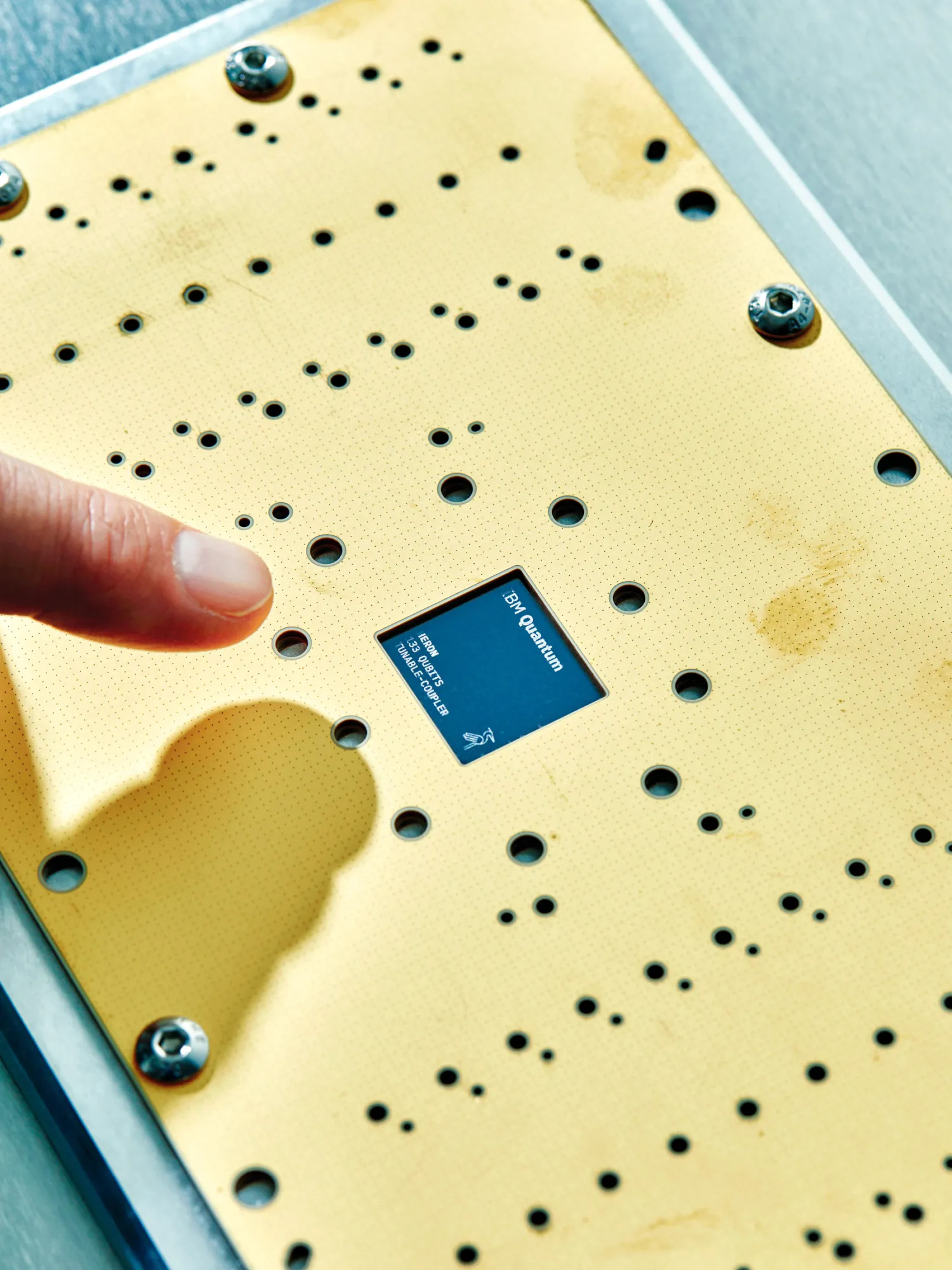

Los ingenieros cuánticos de IBM se han dedicado a construir versiones cuánticas del dígito binario, o bit, del ordenador clásico. En los ordenadores clásicos, el bit es un interruptor electrónico con dos estados que representan el 0 y el 1. En los ordenadores cuánticos, las cosas son menos blancas o negras. Si se aísla del ruido, un bit cuántico, o "cúbit", puede existir en una combinación probabilística de esos dos estados posibles, algo así como una moneda lanzada al aire suspendida a medio camino. Esta propiedad de los cúbits, junto con su potencial para estar "entrelazados" con otros, es la clave de las revolucionarias posibilidades de la computación cuántica.

Un año después de incorporarse a la empresa, Gambetta detectó un problema con los cúbits de IBM: todo el mundo podía ver que se estaban volviendo bastante buenos. Cada vez que se reunía con sus colegas físicos en conferencias, le pedían que probara sus últimas ideas en los cúbits de IBM. Al cabo de un par de años, Gambetta empezó a preocuparse por el volumen de peticiones. "Empecé a pensar que era una locura: ¿por qué teníamos que hacer experimentos solo para físicos?".

"Vimos llegar los primeros trabajos. Podíamos verlos haciendo ping en el ordenador cuántico. Cuando no se rompió, empezamos a relajarnos".

Jay Gambetta

Se le ocurrió que su vida podría ser más fácil si encontraba una manera de que los físicos pudieran operar los cúbits de IBM por sí mismos, tal vez a través de la computación en nube. Se lo comentó a su jefe, y entonces contó con un cinco minutos para presentar la idea a los ejecutivos de IBM en una reunión a finales de 2014. La única pregunta que le hicieron fue si Gambetta estaba seguro de poder llevarla a cabo. "Dije que sí", cuenta. "Pensé: ¿cómo de difícil puede ser?".

Muy difícil, resultó, porque los ejecutivos de IBM le dijeron a Gambetta que tenía que hacerlo rápido. "Quería dedicarle dos años", dice. Le dieron uno.

Era un reto de enormes proporciones: por entonces apenas sabía lo que era la nube. Afortunadamente, algunos de sus colegas sí lo sabían, y pudieron actualizar los protocolos de acceso remoto del equipo —útiles para ajustar la máquina por la noche o durante el fin de semana— para crear un conjunto de interfaces a las que se pudiera acceder desde cualquier parte del mundo. El primer ordenador cuántico del mundo con acceso a la nube, construido con cinco cúbits, entró en funcionamiento a medianoche del 4 de mayo de 2016. La fecha, el Día de Star Wars, fue elegida por frikis, para frikis. "No creo que nadie de la alta dirección lo supiera", dice Gambetta riendo.

No es que la reacción de la alta dirección ante la fecha de lanzamiento fuera lo más importante para él. Lo que más le preocupaba, dice, era si un sistema que reflejaba años de trabajo de desarrollo entre bastidores sobreviviría conectado al mundo real. "Vimos llegar los primeros trabajos. Podíamos ver cómo hacían ping en el ordenador cuántico", explica. "Cuando no se rompió, empezamos a relajarnos".

La computación cuántica basada en la nube fue un éxito instantáneo. 7.000 personas se apuntaron en la primera semana, y a finales de mes había 22.000 usuarios registrados. Sus aventuras dejaron claro, sin embargo, que la computación cuántica tenía un gran problema.

El objetivo final de este campo es tener cientos de miles, si no millones, de cúbits trabajando juntos. Pero cuando los investigadores pudieron probar ordenadores cuánticos con unos pocos cúbits trabajando juntos, muchas de las suposiciones teóricas sobre la cantidad de ruido que generarían resultaron ser muy erróneas.

Siempre hubo algo de ruido. Como funcionan a temperaturas superiores al cero absoluto, donde la radiación térmica está siempre presente, todo el mundo esperaba que los cúbits sufrieran algunos golpes aleatorios. Pero también había golpes no aleatorios. Los cambios de temperatura en la electrónica de control creaban ruido. La aplicación de pulsos de energía para poner los cúbits en los estados correctos creaba ruido. Y lo peor de todo es que enviar una señal de control a un cúbit generaba ruido en otros cúbits cercanos. "Estás manipulando un cúbit y otro de allí lo nota", explica Michael Biercuk, director del Laboratorio de Control Cuántico de la Universidad de Sídney (Australia).

Para cuando los algoritmos cuánticos se ejecutaban en una docena de cúbits, el rendimiento era chocante. En una evaluación de 2022, Biercuk y otros calcularon la probabilidad de que un algoritmo funcionara correctamente antes de que el ruido destruyera la información contenida en los cúbits y desviara el cálculo. Si un algoritmo con una respuesta correcta conocida se ejecutaba 30.000 veces, por ejemplo, la respuesta correcta sólo aparecería tres veces.

Aunque decepcionante, también fue educativo. "La gente aprendió mucho sobre estas máquinas usándolas", dice Biercuk. "Descubrimos muchas cosas que más o menos nadie sabía, o que sabían pero no tenían ni idea de qué hacer al respecto".

Corrigiendo los errores

Una vez recuperados de esta sonora bofetada, los investigadores empezaron a reponerse. Y ahora han ideado un conjunto de soluciones que pueden funcionar de forma coordinada para controlar el ruido.

A grandes rasgos, las soluciones pueden clasificarse en tres categorías. La capa base es la supresión de errores. Funciona mediante software clásico y algoritmos de aprendizaje automático, que analizan continuamente el comportamiento de los circuitos y los cúbits y reconfiguran el diseño del circuito y la forma en que se dan las instrucciones para proteger mejor la información contenida en los cúbits. Esta es una de las cosas en las que trabaja la empresa de Biercuk, Q-CTRL. La supresión, dice la empresa, puede hacer que los algoritmos cuánticos tengan mil veces más probabilidades de producir una respuesta correcta.

La siguiente capa, la mitigación de errores, aprovecha el hecho de que no todos los errores provocan el fallo de un cálculo; muchos de ellos sólo lo desvían del camino correcto. Observando los errores que el ruido genera en un sistema concreto que ejecuta un algoritmo determinado, los investigadores pueden aplicar una especie de "antirruido" al circuito cuántico para reducir las posibilidades de error durante el cálculo y en el resultado. Esta técnica, similar al funcionamiento de los auriculares con cancelación de ruido, no es una solución perfecta. Depende, por ejemplo, de ejecutar el algoritmo varias veces, lo que aumenta el coste de la operación, y el algoritmo sólo estima el ruido. No obstante, reduce bastante los errores en el resultado final, afirma Gambetta.

Algorithmiq, con sede en Helsinki y de la que Maniscalco es directora general, tiene su propio método para limpiar el ruido una vez realizado el cálculo. "Básicamente elimina el ruido en el posprocesamiento, como si limpiara el desorden del ordenador cuántico", explica Maniscalco. De momento, parece funcionar a escalas razonablemente grandes.

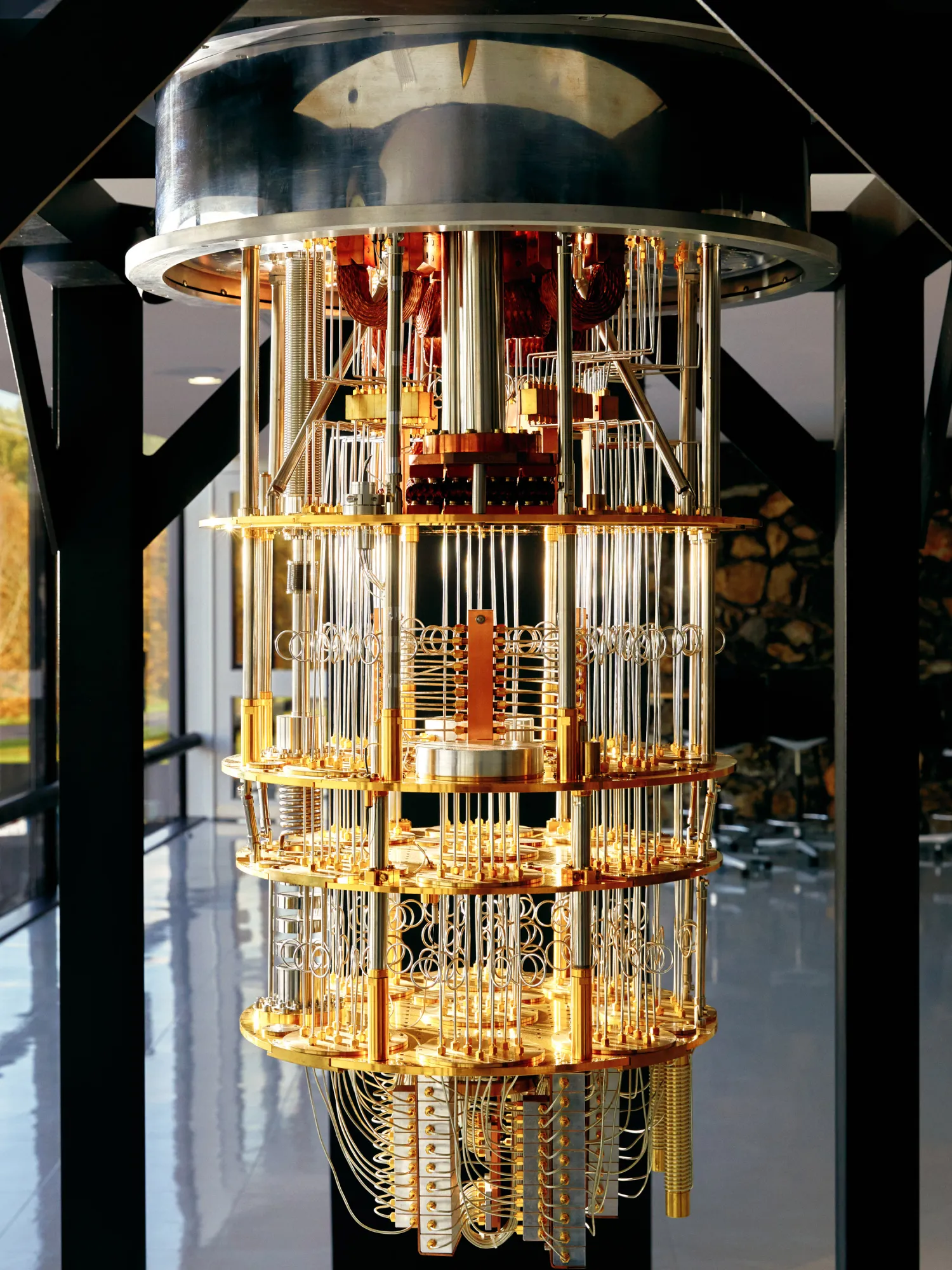

Además de todo esto, cada vez hay más logros en la "corrección cuántica de errores" o QEC, por sus siglas en inglés. En lugar de almacenar la información de un cúbit en un cúbit, la QEC la codifica en los estados cuánticos de un conjunto de cúbits. Un error inducido por ruido en cualquiera de ellos no es tan catastrófico como lo sería si la información estuviera contenida en un solo cúbit: controlando cada uno de los cúbits adicionales, es posible detectar cualquier cambio y corregirlo antes de que la información quede inutilizable.

La implementación de la QEC se considera desde hace tiempo uno de los pasos esenciales en el camino hacia la computación cuántica a gran escala y resistente al ruido, es decir, hacia máquinas que puedan cumplir todas las promesas de la tecnología, como la capacidad de descifrar los esquemas de cifrado más populares. El problema es que la QEC supone un gran sobrecoste. La arquitectura de corrección de errores estándar, conocida como código de superficie, requiere al menos trece cúbits físicos para proteger un solo cúbit "lógico" útil. A medida que se conectan cúbits lógicos entre sí, esa cifra se dispara: un procesador útil podría requerir mil cúbits físicos por cada cúbit lógico.

Sin embargo, hay muchas razones para ser optimistas. En julio de 2022, por ejemplo, los investigadores de Google publicaron una demostración de un código de superficie en acción en la que el rendimiento mejoraba (en lugar de empeorar) cuando se conectaban más cúbits entre sí.

Que tantas técnicas de gestión del ruido estén floreciendo es algo muy importante, especialmente en un momento en el que la idea de que podríamos obtener algo útil de los procesadores ruidosos a pequeña escala ha resultado ser un fracaso.

También han aparecido prometedoras demostraciones de alternativas teóricas a los códigos de superficie. En agosto de 2023, un equipo de IBM que incluía a Gambetta mostró una técnica de corrección de errores que podía controlar los errores en un circuito de memoria de 12 cúbits utilizando 276 cúbits extra, una gran mejora respecto a los miles de cúbits adicionales que requieren los códigos de superficie.

En septiembre, otros dos equipos demostraron mejoras similares con un circuito tolerante a fallos llamado puerta CCZ, que utiliza circuitos superconductores y procesadores de trampa de iones.

Que estén floreciendo tantas técnicas de gestión del ruido es un gran logro, sobre todo en un momento en que la idea de que podríamos obtener algo útil de los procesadores ruidosos a pequeña escala ha resultado ser un fracaso.

Los procesadores cuánticos disponibles en el mercado aún no corrigen los errores reales (y, por lo general, no pueden implementarse como un proceso en tiempo real durante los cálculos). Pero Biercuk considera que la computación cuántica está alcanzando por fin su punto álgido. "Creo que estamos en el buen camino", afirma. "No veo ningún problema fundamental en absoluto".

Y estas innovaciones se están produciendo junto con mejoras generales en el rendimiento del hardware —lo que significa que cada vez hay menos errores de base en los cúbits en funcionamiento— y un aumento del número de cúbits en cada procesador, lo que hace posibles cálculos más grandes y útiles. Biercuk dice que está empezando a ver situaciones en las que pronto podría elegir un ordenador cuántico frente a las máquinas clásicas de mejor rendimiento. Ni los ordenadores clásicos ni los cuánticos pueden resolver tareas a gran escala, como encontrar las rutas óptimas para una flota nacional de camiones de reparto. Pero, señala Biercuk, acceder y hacer funcionar los mejores superordenadores clásicos cuesta mucho dinero, posiblemente más que acceder y hacer funcionar un ordenador cuántico que incluso podría dar una solución ligeramente mejor.

"Fíjate en lo que hacen a diario los centros de computación de alto rendimiento", afirma Kuan Tan, director técnico y cofundador del proveedor de ordenadores cuánticos IQM, con sede en Finlandia. "Realizan cálculos científicos que consumen mucha energía y que son alcanzables por ordenadores cuánticos que consumirán mucha menos energía". Un ordenador cuántico no tiene por qué ser mejor que cualquier otro tipo de máquina para atraer clientes de pago, afirma Tan. Sólo tiene que ser comparable en rendimiento y más barato de utilizar. Espera que consigamos esa ventaja energética cuántica en los próximos tres a cinco años.

Encontrar la utilidad

Hace tiempo que se debate qué objetivo deben perseguir los investigadores de la computación cuántica en su intento de competir con los ordenadores clásicos. ¿Supremacía cuántica, el objetivo que persigue Google (demostrar que un ordenador cuántico puede resolver un problema que ningún ordenador clásico puede resolver en un tiempo razonable)? ¿O la ventaja cuántica, un rendimiento superior cuando se trata de un problema útil, como ha preferido IBM? ¿O utilidad cuántica, la nueva palabra de moda de IBM? La semántica refleja diferentes puntos de vista sobre qué objetivos a corto plazo son importantes.

En junio, IBM anunció que empezaría a retirar de la nube sus procesadores de gama básica, de modo que su procesador Eagle de 127 cúbits sería el más pequeño que la empresa pondría a disposición de los investigadores. La medida pretende empujar a los investigadores a dar prioridad a las tareas verdaderamente útiles. Eagle es un procesador "a escala de utilidad", afirma IBM; cuando se maneja correctamente, puede "proporcionar resultados útiles a problemas que desafían a los mejores métodos clásicos escalables."

Es una afirmación controvertida: muchos dudan de que Eagle sea realmente capaz de superar a las máquinas clásicas convenientemente preparadas. Pero los ordenadores clásicos ya tienen dificultades para seguirle el ritmo, e IBM tiene sistemas aún mayores: el procesador Osprey de 433 cúbits, que también es accesible desde la nube, y el procesador Condor de 1.121 cúbits, que debutó en diciembre. (Gambetta obedece a una sencilla razón para poner nombre los procesadores cuánticos de IBM: "Me gustan los pájaros"). La empresa tiene un nuevo diseño modular, llamado Heron, y está previsto que Flamingo aparezca en 2025, con conexiones totalmente cuánticas entre los chips que permitan que la información cuántica fluya sin obstáculos entre los distintos procesadores, posibilitando una computación cuántica realmente a gran escala. Eso hará de 2025 el primer año en que la computación cuántica será demostrablemente escalable, afirma Gambetta: "Mi objetivo es que 2025 sea un año importante para demostrar tecnologías clave que nos permitan escalar a cientos de miles de cúbits".

Tan, de IQM, está asombrado por el ritmo de desarrollo. "Es alucinante lo rápido que avanza este campo", afirma. "Cuando trabajaba en este campo hace 10 años, nunca habría esperado tener un chip de 10 cúbits a estas alturas. Ahora ya hablamos de cientos, y potencialmente de miles en los próximos años".

No se trata sólo de IBM. A Campbell le ha impresionado, por ejemplo, el progreso silencioso pero rotundo de Google. "Funcionan de forma diferente, pero han alcanzado los hitos de su hoja de ruta pública", afirma. "Parece que hacen lo que dicen que van a hacer". Otras empresas de renombre también están adoptando la computación cuántica. "Estamos viendo cómo Intel utiliza sus máquinas de gama alta, las que utiliza para fabricar chips, para fabricar dispositivos cuánticos", afirma Tan. Intel sigue un camino tecnológico muy distinto al de IBM: crear cúbits en dispositivos de silicio que la empresa sabe fabricar a gran escala, con un mínimo de defectos que inducen ruido.

A medida que la computación cuántica avance y los ordenadores cuánticos empiecen a procesar datos del mundo real, la diversidad tecnológica y geográfica será importante para evitar problemas geopolíticos y de normativa sobre el intercambio de datos.

Existen restricciones, por ejemplo, destinadas a mantener la seguridad nacional, lo que quizá limite las oportunidades de mercado de gigantes multinacionales como IBM y Google. A principios de 2022, el ministro de Defensa francés declaró que las tecnologías cuánticas son de "interés estratégico" al tiempo que anunciaba un nuevo programa nacional de investigación. En julio de 2023, Deutsche Telekom anunció una nueva asociación con IQM para el acceso basado en la nube a la computación cuántica, calificándola como una forma de que los clientes de DT accedan a un "entorno cuántico verdaderamente soberano, construido y gestionado desde dentro de Europa".

No se trata sólo de bravatas nacionalistas: la soberanía importa. A medida que se acerque la era en que los ordenadores cuánticos a gran escala supongan una seria amenaza para los protocolos de cifrado estándar, los gobiernos y las organizaciones comerciales querrán poder probar algoritmos de cifrado "poscuánticos" —capaces de resistir los ataques de cualquier ordenador cuántico, independientemente de su tamaño— dentro de sus propias fronteras.

No es que esto sea un problema todavía. Pocos creen que un procesador cuántico a gran escala que destruya la seguridad esté a la vuelta de la esquina. Pero lo cierto es que cada vez se cree más en el potencial de este campo para ser transformador (y útil) de otras formas en unos pocos años. Y hoy en día, esa creencia se basa en logros del mundo real. "En Algorithmiq creemos en un futuro en el que la utilidad cuántica llegará pronto, pero puedo rastrear este optimismo hasta las patentes y las publicaciones", afirma Maniscalco.

El único inconveniente para ella es que no todo el mundo se ha dado cuenta. La computación cuántica ya está aquí, insiste, pero las viejas objeciones son difíciles de superar y mucha gente se niega a verlo.

"Todavía hay muchos malentendidos: Me enfado mucho cuando veo u oigo ciertas conversaciones", dice. "A veces me gustaría tener una varita mágica que pudiera abrir los ojos a la gente".

Michael Brooks es un periodista científico independiente afincado en el Reino Unido.