La inteligencia artificial generativa irrumpió en el mundo en 2023. Su futuro —y el nuestro— dependerá de lo que hagamos ahora.

Fue una desconocida la primera que me hizo darme cuenta de lo grande que iba a ser el cambio de paradigma en 2023. En marzo, mientras esperábamos juntos en un ascensor atascado, me contó que acababa de utilizar ChatGPT para ayudarle a escribir un informe para su trabajo de marketing. Odiaba escribir informes porque no se le daba muy bien. Pero esta vez su manager la había elogiado. ¿Le pareció hacer trampa? Claro que no. Haces lo que puede para estar a la altura.

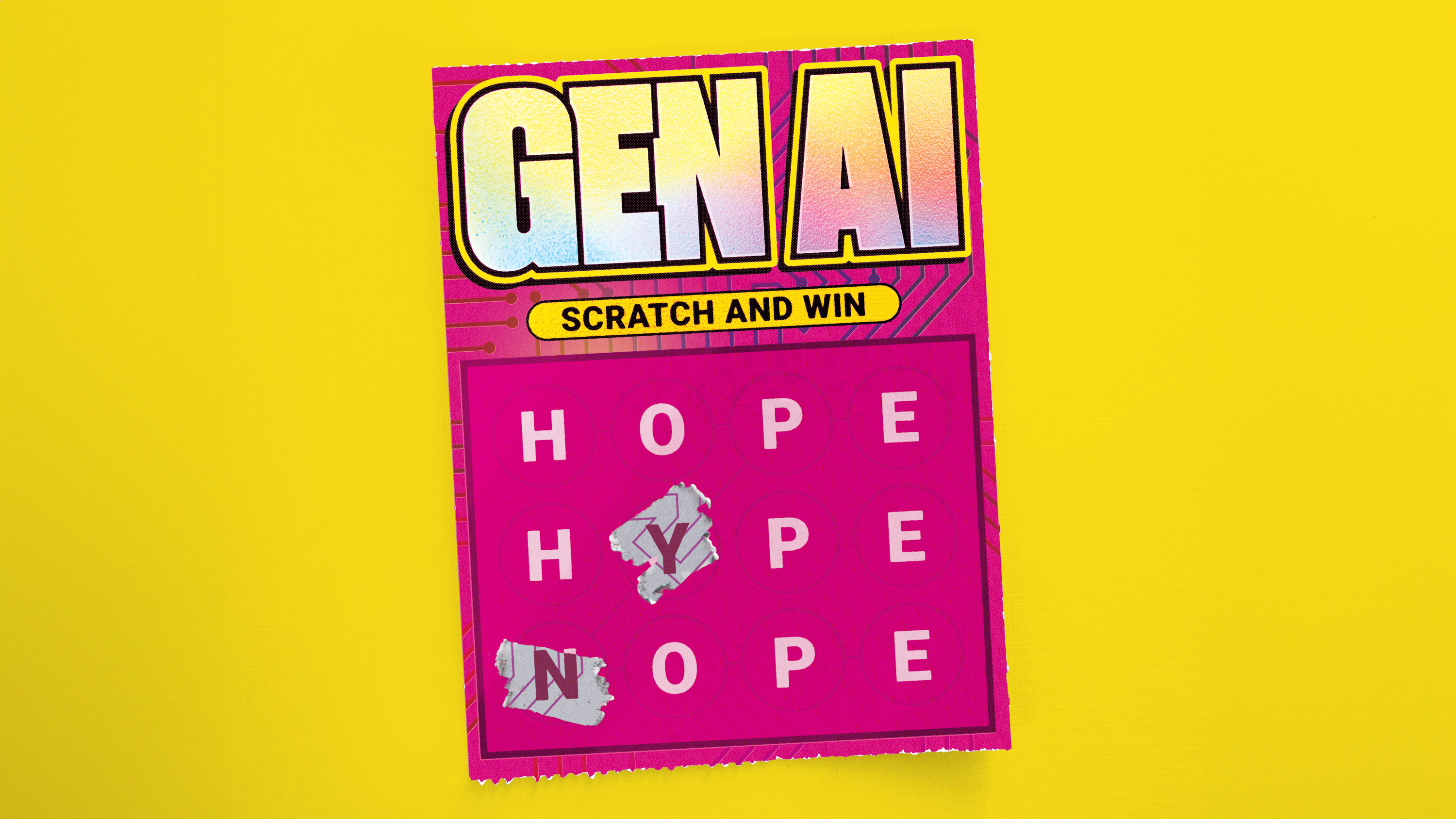

La experiencia de esa desconocida con la IA generativa es una entre millones. La gente de la calle (y de los ascensores) está descubriendo para qué sirve esta nueva tecnología radical y preguntándose qué puede hacer por ellos. En muchos sentidos, el revuelo en torno a la IA generativa recuerda a los primeros días de Internet: hay un sentimiento de entusiasmo y expectación, y la sensación de que nos lo estamos inventando sobre la marcha.

Es decir, estamos en el bum de las puntocom, hacia el año 2000. Muchas empresas quebrarán. Puede que pasen años antes de que veamos surgir el Facebook (ahora Meta), el Twitter (ahora X) o el TikTok de esta era. "La gente es reacia a imaginar lo que podría ser el futuro dentro de 10 años, porque nadie quiere parecer tonto", afirma Alison Smith, responsable de IA generativa de Booz Allen Hamilton, una consultora tecnológica. "Pero creo que va a superar nuestras expectativas".

“ Aquí está el problema: es imposible saber todas las formas en que se utilizará indebidamente una tecnología hasta que se utiliza".

Internet lo ha cambiado todo: cómo trabajamos y jugamos, cómo pasamos tiempo con amigos y familiares, cómo aprendemos, cómo consumimos, cómo nos enamoramos y mucho más. Pero también nos trajo el ciberacoso, el revenge porn (o porno de venganza) y las fábricas de trolls. Facilitó el genocidio, alimentó las crisis de salud mental y convirtió el capitalismo de la vigilancia —con sus algoritmos adictivos y su publicidad depredadora— en la fuerza de mercado dominante de nuestro tiempo. Estas desventajas solo se hicieron evidentes cuando la gente empezó a usarlo en masa y llegaron killer apps (aplicaciones estrella) como las redes sociales.

Es probable que a la IA generativa le ocurra lo mismo. Una vez asentada la infraestructura —los modelos generativos básicos de OpenAI, Google, Meta y unos cuantos más—, otras personas, aparte de quienes la construyeron, empezarán a utilizarla y a abusar de ella de formas que sus creadores nunca imaginaron. "No vamos a comprender plenamente el potencial y los riesgos sin que los usuarios individuales jueguen realmente con ello", afirma Smith.

La IA generativa se formó en Internet y, por tanto, ha heredado muchos de sus problemas sin resolver, como los relacionados con la parcialidad, la desinformación, la violación de los derechos de autor, los abusos de los derechos humanos y la agitación económica general. Pero no vamos a ciegas.

He aquí seis cuestiones sin resolver que debemos tener en cuenta mientras vemos cómo se desarrolla la revolución de la IA generativa. Esta vez tenemos la oportunidad de hacerlo mejor.

1. ¿Mitigaremos algún día el problema de los sesgos?

Los sesgos se han convertido en sinónimo de daños relacionados con la IA, y con razón. Los datos del mundo real, especialmente textos e imágenes extraídos de Internet, están plagados de ellos, desde estereotipos de género hasta discriminación racial. Los modelos entrenados con esos datos codifican esos prejuicios y los refuerzan dondequiera que se utilicen.

Los chatbots y los generadores de imágenes tienden a presentar a los ingenieros como blancos y hombres y a las enfermeras como blancas y mujeres. Las personas negras corren el riesgo de ser identificadas erróneamente por los programas de reconocimiento facial de los departamentos de policía, lo que conduce a detenciones indebidas. Los algoritmos de contratación favorecen a los hombres en detrimento de las mujeres, afianzando un sesgo que a veces fueron creados para abordar.

Sin nuevos conjuntos de datos ni una nueva forma de entrenar los modelos (ambas cosas podrían llevar años de trabajo), la raíz del problema del sesgo está aquí para quedarse. Pero eso no ha impedido que sea un tema candente de investigación. OpenAI ha trabajado para que sus modelos de lenguaje de gran tamaño (LLM, por sus siglas en inglés) sean menos sesgados utilizando técnicas como el aprendizaje por refuerzo a partir de la retroalimentación humana (RLHF), que orienta los resultados que arroja un modelo hacia el tipo de texto que los evaluadores humanos dicen preferir.

Otras técnicas utilizan conjuntos de datos sintéticos. Por ejemplo, Runway, una start-up que fabrica modelos generativos para la producción de vídeo, ha entrenado una versión del popular modelo de creación de imágenes Stable Diffusion con datos sintéticos como imágenes generadas por IA de personas que varían en etnia, sexo, profesión y edad. La empresa informa de que los modelos entrenados con este conjunto de datos generan más imágenes de personas de piel más oscura y más imágenes de mujeres. Si se solicita una imagen de un hombre de negocios, los resultados incluyen a mujeres con pañuelo en la cabeza; las imágenes de médicos muestran a personas con distinto color de piel y sexo, y así sucesivamente.

Los críticos tachan estas soluciones de tiritas en modelos de base rotos, que ocultan el problema en lugar de solucionarlo. Pero Geoff Schaefer, colega de Smith en Booz Allen Hamilton y director de IA responsable en la empresa, sostiene que estos sesgos algorítmicos pueden poner de manifiesto los sesgos sociales de una forma útil a largo plazo.

Como ejemplo, señala que incluso cuando se elimina la información explícita sobre la raza de un conjunto de datos, el sesgo racial puede sesgar la toma de decisiones basada en datos porque la raza puede deducirse de las direcciones de las personas, lo que revela patrones de segregación y discriminación en la vivienda. "Reunimos un montón de datos en un solo lugar y esa correlación se hizo realmente evidente", afirma.

Schaefer cree que algo similar podría ocurrir con esta generación de IA: "Estos prejuicios en toda la sociedad van a salir a la luz". Y eso conducirá a una formulación de políticas más específicas, afirma.

Pero muchos se resistirían a tal optimismo. El hecho de que un problema salga a la luz no garantiza que vaya a solucionarse. Los responsables políticos siguen tratando de resolver los prejuicios sociales que salieron a la luz hace años en la vivienda, la contratación, los préstamos, la policía y otros ámbitos. Mientras tanto, los individuos viven con las consecuencias.

Predicción: El sesgo seguirá siendo una característica inherente a la mayoría de los modelos generativos de IA. Pero las soluciones alternativas y una mayor concienciación podrían ayudar a los responsables políticos a abordar los ejemplos más obvios.

2. ¿Cómo cambiará la IA los derechos de autor?

Indignados por el hecho de que las empresas tecnológicas se beneficien de su trabajo sin su consentimiento, artistas y escritores (y programadores) han iniciado demandas colectivas contra OpenAI, Microsoft y otras empresas, alegando infracción de derechos de autor. Getty ha demandado a Stability AI, la empresa responsable del creador de imágenes Stable Diffusion.

Estos casos dan mucho que hablar. Demandantes famosos como Sarah Silverman y George R.R. Martin han atraído la atención de los medios de comunicación. Y los casos están llamados a reescribir las normas sobre lo que cuenta y lo que no cuenta como uso legítimo de la obra de otro, al menos en Estados Unidos.

Pero no contengamos la respiración. Pasarán años antes de que los tribunales tomen una decisión definitiva, dice Katie Gardner, socia especializada en licencias de propiedad intelectual del bufete de abogados Gunderson Dettmer, que representa a más de 280 empresas de IA. Para entonces, dice, "la tecnología estará tan arraigada en la economía que no se podrá deshacer".

Mientras tanto, la industria tecnológica está aprovechando estas supuestas infracciones a un ritmo vertiginoso. "No creo que las empresas esperen a ver qué pasa", dice Gardner. "Puede haber algunos riesgos legales, pero hay muchos otros riesgos por no seguir el ritmo".

Algunas empresas han tomado medidas para limitar la posibilidad de infracción. OpenAI y Meta afirman haber introducido vías para que los creadores retiren su trabajo de futuros conjuntos de datos. OpenAI impide ahora que los usuarios de DALL-E soliciten imágenes al estilo de artistas vivos. Pero, dice Gardner, "todo esto son acciones para reforzar sus argumentos en el litigio".

Google, Microsoft y OpenAI ofrecen ahora proteger a los usuarios de sus modelos frente a posibles acciones legales. La política de indemnización de Microsoft para su asistente de programación generativa GitHub Copilot, que es objeto de una demanda colectiva en nombre de los desarrolladores de software con cuyo código fue entrenado, protegería en principio a quienes lo utilicen mientras los tribunales dilucidan las cosas. "Asumiremos esa carga para que los usuarios de nuestros productos no tengan que preocuparse", declaró Satya Nadella, consejero delegado de Microsoft, a MIT Technology Review.

Al mismo tiempo, surgen nuevos tipos de acuerdos de licencia. Shutterstock ha firmado un acuerdo de seis años con OpenAI para el uso de sus imágenes. Y Adobe afirma que su propio modelo de creación de imágenes, llamado Firefly, sólo se ha entrenado con imágenes con licencia, imágenes de su conjunto de datos Adobe Stock o imágenes que ya no están protegidas por derechos de autor. Sin embargo, algunos colaboradores de Adobe Stock afirman que no se les consultó y no están contentos con ello.

El resentimiento es feroz. Ahora los artistas contraatacan con su propia tecnología. Una herramienta llamada Nightshade permite a los usuarios alterar las imágenes de forma imperceptible para los humanos, pero devastadora para los modelos de aprendizaje automático, ya que les hace categorizar erróneamente las imágenes durante el entrenamiento. Es de esperar que se produzca un gran reajuste de las normas que rigen el intercambio y la reutilización de medios en línea.

Predicción: Los pleitos de gran repercusión seguirán llamando la atención, pero es poco probable que eso impida a las empresas crear modelos generativos. Surgirán nuevos mercados en torno a conjuntos de datos éticos y se desarrollará un juego del gato y el ratón entre empresas y creadores.

3. ¿Cómo cambiará nuestros trabajos?

Llevamos mucho tiempo oyendo que la IA viene a por nuestros puestos de trabajo. La diferencia esta vez es que los trabajadores de cuello blanco —analistas de datos, médicos, abogados y periodistas— también parecen estar en peligro. Los chatbots pueden aprobar exámenes de bachillerato, de medicina y de abogacía. Pueden resumir reuniones e incluso redactar artículos de noticias básicos. ¿Qué nos queda a los demás? La verdad dista mucho de ser sencilla.

Muchos investigadores niegan que el rendimiento de los grandes modelos lingüísticos sea prueba de verdadera inteligencia. E incluso aunque así fuera, la mayoría de los roles profesionales abarcan mucho más que las tareas que pueden realizar esos modelos.

El verano pasado, Ethan Mollick, que estudia innovación en la Wharton School de la Universidad de Pensilvania, ayudó a realizar un experimento con Boston Consulting Group para analizar el impacto de ChatGPT en los consultores. El equipo encomendó a cientos de consultores 18 tareas relacionadas con una empresa de calzado ficticia, como "Proponer al menos 10 ideas para un nuevo zapato dirigido a un mercado o deporte desatendido" y "Segmentar el mercado de la industria del calzado en función de los usuarios". Algunos del grupo utilizaron ChatGPT para ayudarles, otros no.

Los resultados fueron sorprendentes: "Los consultores que utilizaron ChatGPT-4 superaron con creces a los que no lo hicieron. En todas las dimensiones. En todas las formas en que medimos el rendimiento", escribe Mollick en una entrada de blog sobre el estudio.

Muchas empresas ya utilizan grandes modelos lingüísticos para buscar y obtener información, afirma Nathan Benaich, fundador de la empresa de capital riesgo Air Street Capital y jefe del equipo responsable del Informe sobre el Estado de la IA, un exhaustivo resumen anual de investigaciones y tendencias del sector. Lo considera positivo: "Con suerte, los analistas se convertirán en un modelo de IA", afirma. "Estas cosas son sobre todo un aburrimiento".

Su argumento es que dejar el trabajo pesado en manos de las máquinas permite a las personas centrarse en aspectos más gratificantes de su trabajo. La tecnología también parece nivelar las capacidades de los trabajadores: los primeros estudios, como el de Mollick con consultores y otros con programadores, sugieren que las personas con menos experiencia obtienen un mayor impulso del uso de la IA. (Sin embargo, hay excepciones. Mollick descubrió que las personas que confiaban demasiado en la GPT-4 se volvían descuidadas y tenían menos probabilidades de detectar errores cuando el modelo los cometía).

La IA generativa no sólo cambiará los trabajos de oficina. Los modelos de creación de imágenes y vídeos podrían hacer posible la producción de flujos interminables de imágenes y películas sin ilustradores, operadores de cámara o actores humanos. Las huelgas de guionistas y actores en Estados Unidos en 2023 dejaron claro que este será un punto álgido en los próximos años.

Aun así, muchos investigadores consideran que, en general, esta tecnología potencia a los trabajadores, no los sustituye. Al fin y al cabo, la tecnología ha venido a ocupar puestos de trabajo desde la revolución industrial. Se crean nuevos puestos de trabajo a medida que desaparecen los antiguos. "Creo firmemente que es un beneficio neto", afirma Smith.

Pero el cambio siempre es doloroso, y las ganancias netas pueden ocultar pérdidas individuales. La agitación tecnológica también tiende a concentrar la riqueza y el poder, alimentando la desigualdad.

"En mi opinión, la cuestión ya no es si la IA va a remodelar el trabajo, sino qué queremos que signifique", escribe Mollick.

Predicción: Los temores a una pérdida masiva de puestos de trabajo resultarán exagerados. Pero las herramientas generativas seguirán proliferando en el lugar de trabajo. Es posible que cambien las funciones y que haya que aprender nuevas habilidades.

4. ¿Qué desinformación hará posible?

Tres de las imágenes más virales de 2023 fueron las fotos del Papa con un abrigo de plumas de Balenciaga, Donald Trump siendo empujado al suelo por policías y una explosión en el Pentágono. Todas falsas, todas vistas y compartidas por millones de personas.

Utilizar modelos generativos para crear textos o imágenes falsos es más fácil que nunca. Muchos advierten de un exceso de desinformación. OpenAI ha colaborado en una investigación que pone de relieve muchos posibles usos indebidos de su propia tecnología para campañas de noticias falsas. En un informe de 2023 advertía de que los LLM podrían utilizarse para producir propaganda más persuasiva (difícil de detectar como tal) a gran escala. Expertos de EE UU y la UE ya afirman que las elecciones están en peligro.

No fue ninguna sorpresa que la administración Biden hiciera del etiquetado y la detección de contenidos generados por IA uno de los puntos centrales de su orden ejecutiva sobre inteligencia artificial del pasado mes de octubre. Pero la orden se quedó corta a la hora de exigir legalmente a los fabricantes de herramientas que etiquetaran el texto o las imágenes como creaciones de una IA. Y las mejores herramientas de detección aún no funcionan lo suficientemente bien como para ser fiables.

La Ley de Inteligencia Artificial de la Unión Europea, aprobada este en diciembre, va más allá. Parte de esta amplia legislación obliga a las empresas a marcar con una marca de agua el texto, las imágenes o los vídeos generados por IA, y a dejar claro a los usuarios cuándo están interactuando con un chatbot. Y la Ley de Inteligencia Artificial es contundente: las normas serán vinculantes e irán acompañadas de fuertes multas en caso de incumplimiento.

Estados Unidos también ha dicho que auditará cualquier IA que pueda suponer una amenaza para la seguridad nacional, incluida la interferencia electoral. Es un gran paso, dice Benaich. Pero ni siquiera los desarrolladores de estos modelos conocen todas sus capacidades: "La idea de que los gobiernos u otros organismos independientes puedan obligar a las empresas a probar completamente sus modelos antes de lanzarlos al mercado parece poco realista".

Aquí está el truco: es imposible conocer todas las formas en que se utilizará indebidamente una tecnología hasta que se utiliza. "En 2023 se habló mucho de frenar el desarrollo de la IA", dice Schaefer. "Pero nosotros opinamos lo contrario".

A menos que estas herramientas sean utilizadas por el mayor número de personas y de las formas más diversas posibles, no conseguiremos mejorarlas, afirma: "No vamos a entender las formas específicas en que se manifestarán estos riesgos ni qué acontecimientos los desencadenarán".

Predicción: A medida que aumente su uso, seguirán apareciendo nuevas formas de uso indebido. Habrá algunos ejemplos destacados, posiblemente relacionados con la manipulación electoral.

5. ¿Podremos afrontar su coste?

También hay que tener en cuenta los costes de desarrollo de la IA generativa, tanto humanos como medioambientales. El problema de los trabajadores invisibles es un secreto a voces: nos ahorramos lo peor de lo que pueden producir los modelos generativos gracias en parte a multitudes de trabajadores ocultos (a menudo mal pagados) que etiquetan los datos de entrenamiento y eliminan los resultados tóxicos, a veces traumáticos, durante las pruebas. Son los talleres clandestinos de la era de los datos.

En 2023, el uso de trabajadores de OpenAI en Kenia fue objeto de escrutinio por parte de medios de comunicación populares como Time y el Wall Street Journal. OpenAI quería mejorar sus modelos generativos creando un filtro que ocultara a los usuarios los contenidos odiosos, obscenos y ofensivos. Pero para ello necesitaba que la gente encontrara y etiquetara un gran número de ejemplos de esos contenidos tóxicos para que su filtro automático pudiera aprender a detectarlos. OpenAI había contratado a la empresa de subcontratación Sama, que a su vez habría recurrido a trabajadores mal pagados en Kenia que recibían escaso apoyo.

Ahora que la IA generativa se ha convertido en una preocupación generalizada, los costes humanos se harán más patentes, presionando a las empresas que construyen estos modelos para que tengan en cuenta las condiciones laborales de los trabajadores de todo el mundo contratados para ayudar a mejorar su tecnología.

El otro gran coste, la cantidad de energía necesaria para entrenar grandes modelos generativos, aumentará antes de que la situación mejore. En agosto, Nvidia anunció unos ingresos en el segundo trimestre de 2024 de más de 13.500 millones de dólares (unos 12.000 millones de euros), el doble que en el mismo periodo del año anterior. La mayor parte de esos ingresos (10.300 millones de dólares, unos 9.400 millones de euros) procede de los centros de datos, es decir, de otras empresas que utilizan el hardware de Nvidia para entrenar modelos de IA.

"La demanda es bastante extraordinaria", afirma Jensen Huang, CEO de Nvidia. "Estamos en el despegue de la IA generativa". También reconoce el problema energético y predice que el auge podría incluso impulsar un cambio en el tipo de hardware informático desplegado. "La gran mayoría de la infraestructura informática mundial tendrá que ser eficiente desde el punto de vista energético", afirma.

Predicción: Una mayor concienciación pública sobre los costes laborales y medioambientales de la IA presionará a las empresas tecnológicas. Pero no esperes mejoras significativas en ninguno de los dos frentes en breve.

6. ¿El doomerismo seguirá dominando la formulación de políticas?

El doomerismo (el temor a que la creación de máquinas inteligentes pueda tener consecuencias desastrosas, incluso apocalípticas) ha sido durante mucho tiempo un trasfondo de la IA. Pero la exageración y el anuncio de Geoffrey Hinton, pionero de la IA, de que temía a la tecnología que había ayudado a construir en mayo del año pasado, lo han sacado a la superficie.

Pocos temas en 2023 fueron tan controvertidos. Eminencias de la IA como Hinton y su colega Yann LeCun, ganador del Premio Turing, fundador del laboratorio de IA de Meta y que considera absurdo el "doomerismo", se enzarzan en disputas públicas, lanzándose pullas mutuamente en las redes sociales.

Hinton, Sam Altman, consejero delegado de OpenAI, y otros han sugerido que los (futuros) sistemas de IA deberían contar con salvaguardas similares a las utilizadas para las armas nucleares. Este tipo de comentarios atraen la atención de la gente. Pero en un artículo que coescribió en Vox en julio del año pasado, Matt Korda, director del Proyecto de Información Nuclear de la Federación de Científicos Estadounidenses, denunció estas "analogías confusas" y el "pánico mediático sin calorías" que provocan.

Es difícil entender qué es real y qué no, porque no conocemos los incentivos de las personas que hacen saltar las alarmas, dice Benaich: "Parece extraño que mucha gente se esté enriqueciendo a costa de estas cosas y que muchos de ellos sean los mismos que exigen un mayor control. Es como decir: '¡Eh, he inventado algo muy potente! Tiene muchos riesgos, pero yo tengo el antídoto'".

A algunos les preocupa el impacto de todo este alarmismo. En X, Andrew Ng, pionero del aprendizaje profundo, escribió: "Mi mayor temor para el futuro de la IA es que los riesgos sobredimensionados (como la extinción humana) permitan a los grupos de presión tecnológicos promulgar normativas asfixiantes que supriman el código abierto y aplasten la innovación". El debate también desvía recursos e investigadores de riesgos más inmediatos, como la parcialidad, los trastornos laborales y la desinformación (véase más arriba).

"Algunas personas impulsan el riesgo existencial porque creen que beneficiará a su propia empresa", afirma François Chollet, un influyente investigador de IA en Google. "Hablar de riesgo existencial pone de relieve lo éticamente consciente y responsable que eres y, al mismo tiempo, distrae de cuestiones más realistas y apremiantes".

Benaich señala que algunas de las personas que hacen sonar la alarma con una mano están recaudando 100 millones de dólares para sus empresas con la otra. "Se podría decir que el doomerismo es una estrategia de captación de fondos", afirma.

Predicción: El alarmismo amainará, pero la influencia en las agendas de los responsables políticos se dejará sentir durante algún tiempo. Seguirán los llamamientos a centrarse en los daños más inmediatos.

Aún falta: la aplicación asesina de la IA

Resulta extraño pensar que ChatGPT estuvo a punto de no existir. Antes de su lanzamiento en noviembre de 2022, Ilya Sutskever, cofundador y científico jefe de OpenAI, no estaba impresionado por su precisión. A otros en la empresa les preocupaba que no fuera un gran avance. Bajo el capó, ChatGPT era más una remezcla que una revolución. Se basaba en GPT-3.5, un LLM que OpenAI había desarrollado varios meses antes. Pero el chatbot incorporaba un puñado de atractivos retoques (en particular, respuestas más conversacionales y precisas) en un paquete accesible. "Era capaz y práctico", dice Sutskever. "Fue la primera vez que el progreso de la IA se hizo visible para personas ajenas a ella".

El revuelo desatado por ChatGPT aún no ha llegado a su fin. "La IA es el único juego al que jugar", dice Sutskever. "Es lo más grande en tecnología, y la tecnología es lo más grande en economía. Y creo que nos seguirá sorprendiendo lo que la IA puede hacer".

Pero ahora que hemos visto lo que puede hacer la IA, quizá la pregunta inmediata sea para qué sirve. OpenAI construyó esta tecnología sin un uso real en mente. "Ahí va algo", es lo que los investigadores parecían decir cuando lanzaron ChatGPT. "Haz lo que quieras con ello". Todo el mundo ha estado luchando para averiguar qué es eso desde entonces.

"ChatGPT me parece útil", dice Sutskever. "Lo uso con bastante regularidad para todo tipo de cosas aleatorias". Dice que lo utiliza para buscar ciertas palabras o para expresarse con más claridad. A veces lo utiliza para buscar datos (aunque no siempre son reales). Otras personas de OpenAI lo utilizan para planificar sus vacaciones ("¿Cuáles son los tres mejores lugares para bucear en el mundo?") o para consejos de programación o soporte informático.

Útil, pero no revolucionario. La mayoría de estos ejemplos pueden realizarse con herramientas ya existentes, como la búsqueda. Mientras tanto, se dice que el personal de Google tiene dudas sobre la utilidad del propio chatbot de la empresa, Bard (ahora impulsado por el rival de Google GPT-4, Gemini, lanzado el mes pasado). "El mayor reto en el que sigo pensando es: ¿para qué son realmente útiles los LLM, en términos de ayuda?", Cathy Pearl, responsable de experiencia de usuario de Bard, escribió en Discord en agosto, según Bloomberg. "Me refiero a marcar realmente la diferencia. ¡Está por ver!"

Sin una killer app, el efecto sorpresa desaparece. Las estadísticas de la empresa de inversión Sequoia Capital muestran que, a pesar de los lanzamientos virales, aplicaciones de IA como ChatGPT, Character.ai y Lensa, que permite a los usuarios crear avatares estilizados (y sexistas) de sí mismos, pierden usuarios más rápido que servicios populares ya existentes como YouTube e Instagram y TikTok.

"Las leyes de la tecnología de consumo siguen siendo válidas", afirma Benaich. "Habrá mucha experimentación, muchas cosas muertas en el agua tras un par de meses de bombo".

Por supuesto, los primeros días de Internet también estuvieron plagados de falsos comienzos. Antes de cambiar el mundo, el bum de las puntocom acabó en quiebra. Siempre existe la posibilidad de que la IA generativa actual se desvanezca y sea eclipsada por la próxima gran cosa que aparezca.

Pase lo que pase, ahora que la IA se ha generalizado, los problemas de nicho se han convertido en un problema de todos. Como dice Schaefer: "Vamos a vernos obligados a lidiar con estas cuestiones como nunca antes".