Inteligencia Artificial

Gemini de Google DeepMind es asombroso, pero podría indicar el pico de la IA

Supera a GPT-4 en casi todos los aspectos, pero por poco. ¿Mereció la pena tanta expectación?

Gemini, la respuesta tan rumoreada de Google DeepMind a GPT-4 de OpenAI, lleva meses generando conversación. El 6 de diciembre, la empresa por fin reveló en qué ha estado trabajando en secreto todo este tiempo. ¿Estaba justificada la expectación? Sí, y no.

Gemini es el mayor lanzamiento de IA de Google hasta la fecha, y su apuesta por enfrentarse a sus competidores OpenAI y Microsoft en la carrera por la supremacía de la IA. Sin duda, el modelo se presenta como el mejor de su clase en una amplia gama de habilidades. Una “máquina para todo”, según dice un experto.

"El modelo demuestra aún más capaz de manera innata", afirmó Sundar Pichai, CEO de Google y Alphabet, su empresa matriz, a MIT Technology Review. “Es una plataforma. La IA trae un cambio profundo, más grande que la web o el móvil. Por ello, es un gran paso para nosotros”.

Es un gran paso para Google, pero no implica un gran salto para el sector en su conjunto. Google DeepMind afirma que Gemini supera a GPT-4 en 30 de las 32 medidas estándar de rendimiento. Sin embargo, los márgenes entre ambos son escasos. Google DeepMind ha reunido las mejores capacidades actuales de la IA en un potente paquete. A juzgar por las demostraciones, realiza muy bien diferentes tareas, pero pocas que no hayamos visto antes. A pesar de todos los rumores sobre el próximo gran hito, Gemini podría ser una señal de que hemos llegado al paradigma de la exageración sobre la IA. Al menos, por ahora.

Chirag Shah, profesor de la Universidad de Washington (EE UU) especializado en Búsquedas en Internet, compara el lanzamiento con la presentación anual de Apple sobre un nuevo iPhone. “Tal vez hemos llegado a un umbral diferente, donde esto no nos impresiona tanto porque ya hemos visto mucho”, afirma Shah.

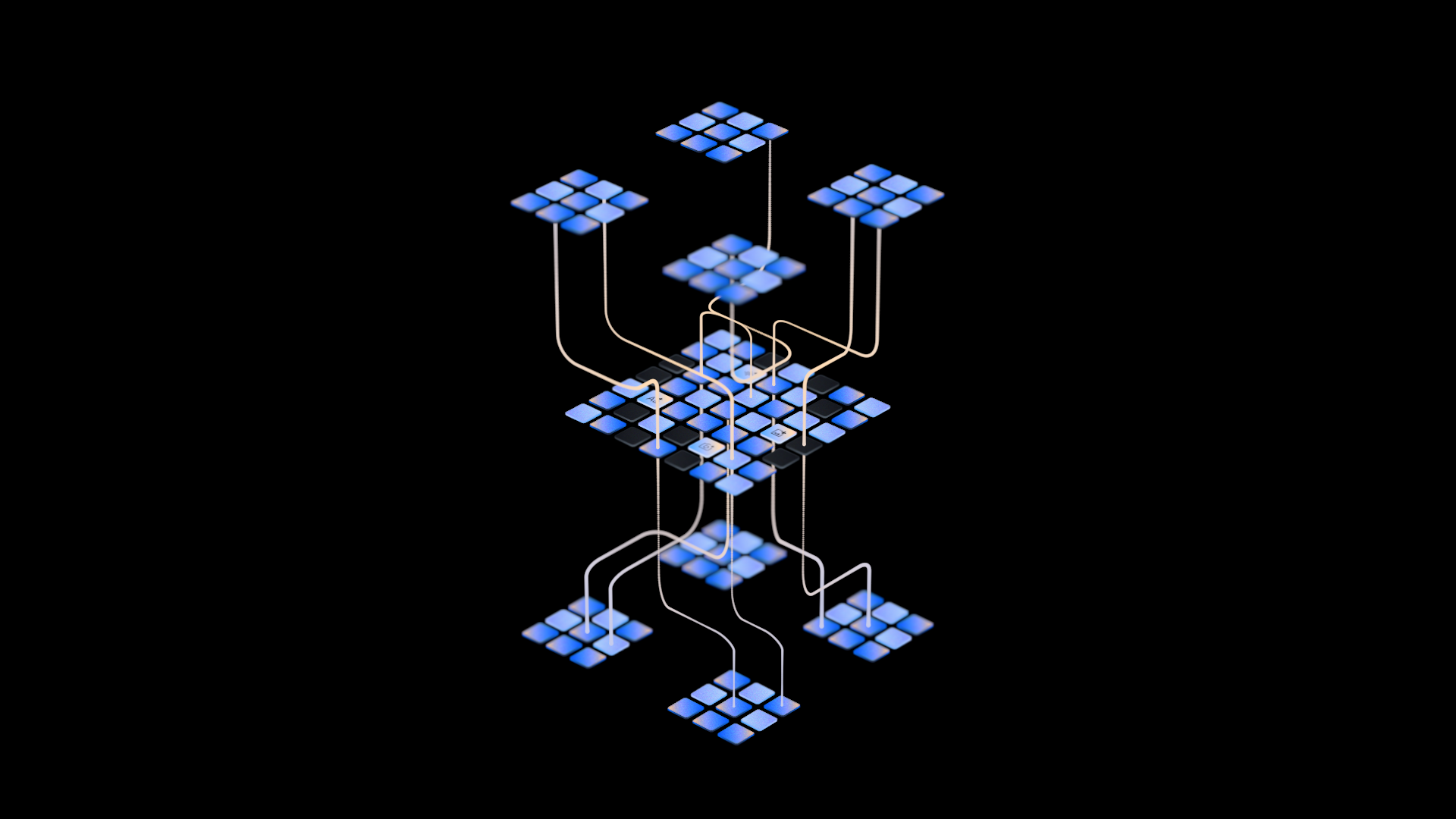

Al igual que GPT-4, Gemini es multimodal, es decir, está entrenado para manejar muchos tipos de contenidos: texto, imágenes, o audio. Puede combinar diferentes formatos para responder a preguntas sobre cualquier tema, desde tareas domésticas hasta matemáticas universitarias o economía.

En una demostración para periodistas realizada el 5 de diciembre, Google mostró la capacidad de Gemini para tomar una captura de pantalla de un gráfico, analizar cientos de páginas de investigación con nuevos datos y, después, actualizar dicho gráfico con esa nueva información. En otro ejemplo, se enseñó a Gemini imágenes de una tortilla cocinándose en una sartén y se preguntó (mediante voz, no texto) si ya estaba cocinada. “No está lista porque los huevos aún están crudos”, respondió.

Sin embargo, la mayoría de usuarios tendrán que esperar para disfrutar de la experiencia completa. La versión lanzada el 6 de diciembre es un back-end de Bard, el chatbot de búsqueda basado en texto de Google, que, según la empresa, le proporcionará capacidades más avanzadas de razonamiento, planificación y comprensión. El lanzamiento completo de Gemini se escalonará a lo largo de los próximos meses. Mientras el nuevo Bard, potenciado por Gemini, estará disponible inicialmente en inglés en más de 170 países, sin incluir la UE y el Reino Unido. Según Sissie Hsiao, vicepresidenta de Google y responsable de Bard, el objetivo es que la empresa pueda “interactuar” con los organismos reguladores locales.

Gemini también está disponible en tres formatos: Ultra, Pro y Nano. Ultra es la versión de mayor potencia; Pro y Nano están adaptadas a apps que se ejecutan con recursos informáticos más limitados. Nano está diseñado para ejecutarse en dispositivos, como los nuevos teléfonos Pixel de Google. Los desarrolladores y las empresas podrán acceder a Gemini Pro a partir del miércoles 13 de diciembre. Gemini Ultra, el modelo más potente, estará disponible “a principios de 2024” tras “exhaustivas comprobaciones de confianza y seguridad”, según afirmaron varios ejecutivos de Google a los periodistas en una convocatoria de prensa.

“Lo veo como la era Gemini de los modelos”, aseguró Pichai. “Así es como Google DeepMind va a construir y progresar en IA. Siempre representará la frontera donde avanzamos en tecnología de IA”.

¿Más grande, mejor, más rápido, más fuerte?

GPT-4, el modelo más potente de OpenAI, se considera el patrón oro del sector. Aunque Google presumió de que Gemini supera a GPT 3.5, el modelo anterior de OpenAI, los ejecutivos de la empresa eludieron las preguntas sobre hasta qué punto el modelo supera a GPT-4.

Sin embargo, la empresa destaca una prueba en particular: massive multitask language understanding (MMLU, por sus siglas). Un conjunto de pruebas diseñadas para medir el rendimiento de los modelos en tareas que implican texto e imágenes, como comprensión lectora, matemáticas universitarias y preguntas de opción múltiple sobre física, economía y ciencias sociales. En las preguntas solo de texto, Gemini obtiene una puntuación del 90% y los expertos humanos sobre 89%, explica Pichai. GPT-4 obtiene un 86% en este tipo de preguntas. En las preguntas multimodales, Gemini obtiene un 59% y GPT-4 un 57%. “Es el primer modelo que supera ese umbral”, admite Pichai.

“El rendimiento de Gemini frente a conjuntos de datos de referencia es impresionante”, afirma Melanie Mitchell, investigadora de IA del Santa Fe Institute de Nuevo México (EE UU).

“Está claro que Gemini es un sistema de IA muy sofisticado”, afirma Mitchell. Pero “no me parece obvio que Gemini tenga mayor capacidad que GPT-4”.

“Aunque el modelo tiene buenas puntuaciones de referencia, es difícil saber cómo interpretar estas cifras, dado que no sabemos qué hay en los datos de entrenamiento”, según Percy Liang, director del Centro de Investigación de Modelos de Fundamentos de Stanford (California, EE UU).

Mitchell también señala que Gemini rinde mejor en pruebas de lenguaje y código que en imágenes y vídeo: “los modelos de fundamentos multimodales aún tienen mucho camino por recorrer para ser útiles de forma generalizada y sólida en muchas tareas”.

Gracias a los comentarios de los usuarios, Google DeepMind ha entrenado a Gemini para que sea más preciso en los hechos, atribuya las fuentes cuando se le pida y de cobertura en lugar de soltar tonterías cuando se enfrente a una pregunta que no pueda responder. La empresa afirma que esto mitiga el problema de las alucinaciones. Pero sin una revisión radical de la tecnología de base, los grandes modelos lingüísticos seguirán inventándose datos.

Los expertos afirman que no está claro si los parámetros que utiliza Google para medir el rendimiento de Gemini ofrecen tanta información y, sin transparencia, es difícil comprobar las afirmaciones de la empresa.

"Google anuncia Gemini como una máquina para todo, un modelo de uso general que puede emplearse de muchas formas distintas", afirma Emily Bender, profesora de Lingüística Computacional de la Universidad de Washington. Pero la empresa utiliza criterios de referencia muy limitados para evaluar los modelos que espera que se utilicen para fines tan diversos: “Esto significa que, efectivamente, no se puede evaluar a fondo”.

En última instancia, para el usuario medio, la mejora con respecto a los modelos de la competencia podría no suponer una gran diferencia, asegura Shah. "Se trata más de comodidad, reconocimiento de marca, integración, y no que la gente piense «Oh, esto es mejor»", admite.

Una larga y lenta construcción

Gemini se ha hecho esperar. En abril de 2023, Google anunció la fusión de Google Brain, su unidad de investigación de IA, con DeepMind, el laboratorio de investigación de IA de Alphabet (Londres, Reino Unido). Google ha tenido todo 2023 para desarrollar su respuesta a GPT-4, el modelo de lenguaje más avanzado de OpenAI, que debutó en marzo de este año y es la columna vertebral de la versión de pago de ChatGPT.

Google ha estado sometida a una intensa presión para demostrar a los inversores que puede igualar y superar a sus competidores en IA. Aunque la empresa lleva años desarrollando y utilizando potentes modelos de IA, se ha mostrado reticente a lanzar herramientas con las que el público pueda jugar por miedo a dañar su reputación y por cuestiones de seguridad.

"Google ha sido muy cauto a la hora de hacer públicas estos temas", declaró Geoffrey Hinton a MIT Technology Review en abril, cuando dejó la empresa. "Podrían ocurrir demasiadas cosas malas, y Google no quería arruinar su reputación". Ante una tecnología que parecía poco fiable o poco comercializable, Google jugó sobre seguro, hasta que el mayor riesgo fue quedarse fuera.

Google ha aprendido por las malas que lanzar productos defectuosos puede ser contraproducente. Cuando presentó Bard, su competencia a ChatGPT, en febrero, los ingenieros no tardaron en darse cuenta de un error factual en el propio anuncio de la empresa para el chatbot. Un incidente que hizo caer 100.000 millones de dólares (93.000 millones de euros) el precio de sus acciones.

En mayo, Google anunció que estaba introduciendo la IA generativa en la mayoría de sus productos, desde el correo electrónico hasta el software de productividad, pero los resultados no impresionaron a los críticos. Por ejemplo, el chatbot hacía referencias a correos electrónicos que no existían.

Se trata de un problema habitual en los grandes modelos lingüísticos. Aunque son excelentes generando textos que parecen escritos por un ser humano, los sistemas de IA generativa suelen inventarse cosas. Y no es el único problema. También son fáciles de piratear y están plagados de sesgos. Además, su uso es muy contaminante.

Google no ha resuelto ni estos problemas ni el de las alucinaciones. Su solución a este último problema es una herramienta que permite a los usuarios utilizar la búsqueda de Google para comprobar las respuestas del chatbot, pero que depende de la precisión de los propios resultados de búsqueda online.

Gemini puede ser lo más alto de la ola de la IA generativa, pero no está claro hacia dónde se dirige la IA basada en grandes modelos lingüísticos. Algunos investigadores creen que podría ser una meseta y no la falda de la siguiente montaña.

Sin embargo, Pichai no se deja intimidar. "Mirando al futuro, vemos mucho margen", afirma. "Creo que la multimodalidad será importante. A medida que enseñemos a estos modelos a razonar más, habrá avances cada vez mayores. Aún quedan avances más profundos por llegar ".

"Cuando lo contemplo en su totalidad, de verdad siento que estamos solo al principio".

Mat Honan ha contribuido a esta información.