La automatización puede ayudarnos a tomar decisiones difíciles, pero no puede hacerlo sola. Los expertos aseguran que mejorar un software que gobierne a las personas es un paradigma para también progresar en la manera de hacer las leyes

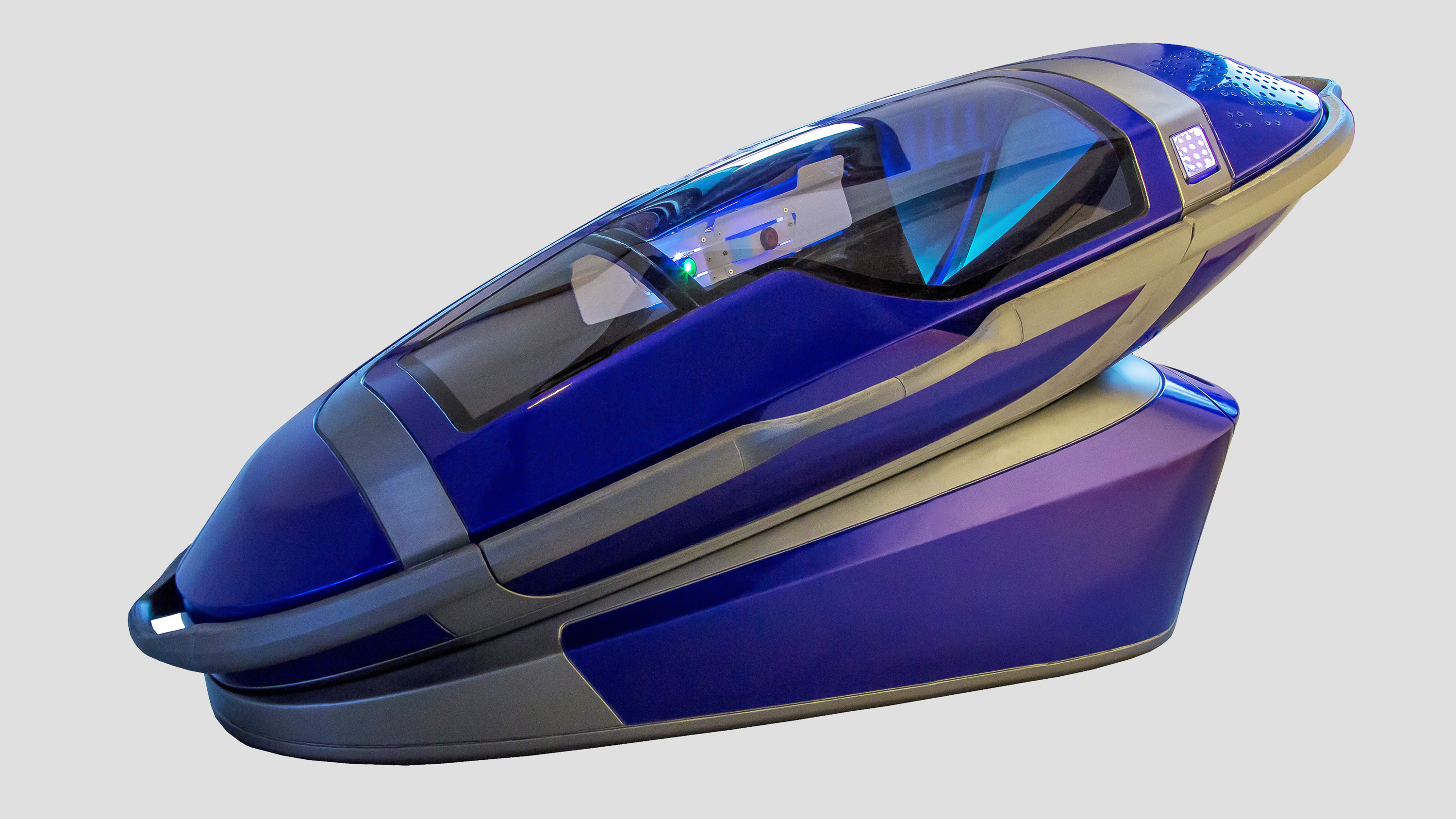

En un taller en Rotterdam en los Países Bajos, Philip Nitschke—“Dr. Muerte” o “el Elon Musk del suicidio asistido” para algunos, está supervisando las últimas rondas de pruebas de su nueva máquina Sarco antes de enviarla a Suiza, donde afirma que lo está esperando su primer usuario.

Este es el tercer prototipo que Exit International, la organización sin ánimo de lucro de Nitschke, que ha impreso en 3D todo el cableado. El primero se ha exhibido en Alemania y Polonia. “El segundo fue un desastre”, admite Nitschke, quien acaba de corregir los errores de fabricación y está preparado para lanzarlo: “Este es el que se va a utilizar”.

Sarco es una cápsula del tamaño de un ataúd que recuerda a Star Trek y representa la culminación de la empresa de Nitschke, que lleva 25 años intentando "desmedicalizar la muerte" a través de la tecnología. La persona que ha elegido morir encerrada dentro de esta máquina debe responder a tres preguntas: ¿Quién eres? ¿Dónde estás? ¿Y sabes lo que sucederá cuando presiones ese botón?

Entonces, ocurrirá lo siguiente: Sarco se llenará de gas nitrógeno. Su ocupante se desmayará en menos de un minuto y morirá por asfixia en cinco minutos, aproximadamente.

A continuación, se entregará una grabación de ese breve cuestionario final a las autoridades suizas. Nitschke no ha hablado con el Gobierno suizo para su aprobación, pero Suiza es uno de los pocos países que ha legalizado el suicidio asistido. Esto está permitido siempre que las personas que desean morir realicen el acto final por sí mismas.

Nitschke quiere que el suicidio asistido sea lo menos asistido posible, dando autonomía a las personas que han elegido suicidarse y, por lo tanto, un final digno. “En realidad, no hace falta un médico para morir”, explica Nitschke.

Sarco utiliza nitrógeno, un gas ampliamente disponible, y no los barbitúricos que suelen utilizar las clínicas de eutanasia. Por ello, no requiere que un médico administre una inyección o apruebe medicamentos letales.

Al menos, esa es la idea. Aunque Nitschke todavía no ha podido evitar a las instituciones médicas. Suiza requiere que los candidatos para la eutanasia demuestren su capacidad mental, que generalmente es evaluada por un psiquiatra, señala Nitschke. “Todavía existe la creencia de que, si una persona pide morir, tiene algún tipo de enfermedad mental no diagnosticada”, asegura el experto. “Aún no es racional que una persona quiera morir”.

No obstante, Nitschke cree que tiene una solución. Exit International está trabajando en un algoritmo para permitir a las personas realizar una especie de autoevaluación psiquiátrica vía ordenador. En teoría, si una persona pasa esta prueba online, el programa proporcionaría un código de cuatro dígitos para activar la máquina Sarco. “Ese es el objetivo”, asegura Nitschke. “Con todo eso, el proyecto está resultando muy difícil”.

Su misión puede parecer extrema, incluso escandalosa, para algunos. Y su confianza en el poder de los algoritmos puede resultar exagerada. Pero él no es el único que busca involucrar la tecnología, y la inteligencia artificial (IA) en particular, en las decisiones de vida o muerte.

Mientras Nitschke ve a la IA como una forma de empoderar a las personas para que tomen la última decisión por sí mismas, otros se preguntan si esta tecnología puede ayudar a aliviar a los humanos de la carga de tales elecciones. La IA ya se utiliza para clasificar y tratar a los pacientes en un creciente número de especialidades de atención médica. A medida que los algoritmos se vuelven una parte más importante de la asistencia sanitaria, debemos asegurar que su función se limite a las decisiones médicas, y no a las morales.

La atención médica es un recurso limitado. Los pacientes deben esperar a las citas para hacerse pruebas o algún tratamiento. Quienes necesitan trasplantes de órganos deben esperar esos corazones o riñones adecuados. Las vacunas deben distribuirse primero entre los más vulnerables (los países que disponen de ellas). Y durante lo peor de la pandemia, cuando los hospitales no tenían suficientes camas ni respiradores, los médicos tomaron decisiones rápidas sobre quién recibiría atención inmediata y quién no, con trágicas consecuencias.

La crisis de la COVID-19 puso de relieve la necesidad de tomar ese tipo de decisiones y llevó a preguntarse si los algoritmos podrían ayudar. Los hospitales de todo el mundo compraron nuevas herramientas de IA o usaron las existentes para ayudar con el cribado. Algunos hospitales en Reino Unido que habían estado explorando el uso de esta tecnología para las radiografías de tórax aportaron por esas herramientas como una forma rápida y económica de identificar los casos más graves de la COVID-19. Los proveedores de esta tecnología, como Qure.ai (con sede en Mumbai, India), y Lunit (con sede en Seúl, Corea) firmaron nuevos contratos en Europa, EE UU y África. Diagnostic Robotics, la empresa israelí que suministra herramientas de triaje basadas en IA a hospitales en Israel, India y EE UU, ha afirmado que aumentó siete veces la demanda de su tecnología en el primer año de la pandemia. Desde entonces, el negocio de la IA en la atención médica ha estado en auge.

Esta prisa por automatizar plantea grandes preguntas que no tienen respuestas fáciles. ¿Para qué tipo de decisiones es apropiado usar un algoritmo? ¿Cómo se deben construir esos algoritmos? ¿Y quién decide cómo funcionan?

Rhema Vaithianathan -directora del Centro de Análisis de Datos Sociales, profesora de la Universidad Tecnológica de Auckland en Nueva Zelanda y especializada en la tecnología para la salud y bienestar-, cree que es correcto que las personas pidan a la IA que les ayude a tomar decisiones importantes. “Deberíamos abordar los problemas que los médicos encuentran difíciles”, opina la profesora.

Uno de los proyectos en los que está trabajando Vaithianathan cuenta con un servicio de salud mental para adolescentes, en el que los jóvenes son diagnosticados y tratados por conductas de autolesión. Hay una gran demanda de la clínica, por lo que debe mantenerse una gran rotación, dando de alta a los pacientes lo antes posible para que otros puedan ingresar.

Sin embargo, los médicos se enfrentan a la complicada decisión de mantener a los pacientes ingresados o tratar a los nuevos. “Los médicos no dan de alta a los pacientes porque tienen mucho miedo de que se autolesionen”, señala Vaithianathan, “ese es su escenario de pesadilla”.

Aunque la IA parezca precisa, tanto los expertos como los reguladores piden precaución

Vaithianathan y sus colegas han intentado desarrollar un modelo de aprendizaje automático capaz de predecir qué pacientes corren mayor riesgo de autolesión en el futuro y cuáles no, utilizando una amplia variedad de datos, incluidos los registros de salud e información demográfica, para dar a los médicos un recurso adicional en su toma de decisiones. “Siempre busco aquellos casos en los que un médico tiene dificultades y agradecería [la ayuda de] un algoritmo”, indica la profesora.

El proyecto se encuentra en sus primeras etapas, pero, hasta ahora, los investigadores han detectado que puede haber pocos datos para entrenar un modelo y realizar predicciones precisas. Seguirán intentándolo. Según Vaithianathan, el modelo no tiene que ser perfecto para ayudar a los médicos.

No es el único equipo que intenta predecir el riesgo de dar de alta a los pacientes. Un informe publicado en 2021 destacó 43 estudios realizados por investigadores que afirmaban usar modelos de aprendizaje automático para predecir si los pacientes serían readmitidos o morirían después de salir de los hospitales en EE UU. Ninguno fue lo suficientemente preciso para el uso clínico, pero los autores esperan con mucho entusiasmo ese momento en el que tales modelos "mejoren la calidad de la atención y reduzcan los costes de la asistencia médica".

Aunque la IA parezca precisa, tanto los expertos como los reguladores piden precaución. Por un lado, los datos que los algoritmos siguen y cómo lo hacen son creaciones humanas, plagadas de prejuicios. Los datos sobre salud cuentan con demasiadas personas que, por ejemplo, son hombres blancos, lo que sesga su poder predictivo. Además, los modelos ofrecen una apariencia de objetividad que puede llevar a los profesionales a delegar la responsabilidad respecto a las decisiones éticas, confiando en la máquina en vez de cuestionar su resultado.

Este problema es el tema de Voices in the Code, el nuevo libro sobre la democratización de la IA descrito por David Robinson, investigador visitante de Social Science Matrix de la Universidad de California en Berkeley (EE UU) y miembro del cuerpo docente de la Universidad de Apple. Robinson cuenta la historia de Belding Scribner, nefrólogo de Seattle (EE UU). En 1960, Scribner insertó un tubo corto de teflón (conocido como derivación) en los brazos de algunos de sus pacientes para evitar que la sangre coagulara durante un tratamiento de diálisis. Esa innovación permitió que las personas con enfermedades renales permanecieran en diálisis indefinidamente, transformando la gravedad de una insuficiencia renal, de una condición fatal a una enfermedad crónica.

Cuando se corrió la voz, Scribner tuvo muchas solicitudes de tratamiento, pero no podía realizarlos todos. ¿A quién ayudar y a quién rechazar? Pronto se dio cuenta de que no se trataba de una decisión médica sino ética y creó un comité laico para decidir. Por supuesto, sus decisiones no fueron perfectas. Los prejuicios de la época llevaron al comité a favorecer a los hombres casadoscon trabajo y familia, por ejemplo.

Tal y como cuenta Robinson, la lección que debemos aprender del trabajo de Scribner es que ciertos procesos (burocráticos, técnicos y algorítmicos) pueden hacer que las preguntas difíciles parezcan neutrales y objetivas. Pueden tapar los aspectos morales de una decisión y, a veces, también sus terribles consecuencias.

“La burocracia en sí misma puede servir como vía para convertir los complicados problemas morales en problemas técnicos aburridos”, escribe Robinson. Este fenómeno es anterior a la digitalización, resalta el escritor, “pero los sistemas basados en software pueden acelerar y amplificar esta tendencia. La cuantificación puede ser un anestésico moral, y los ordenadores hacen que ese anestésico sea más fácil de administrar que nunca”.

En el proceso, debemos dejar que la anestesia moral desaparezca y examinar las dolorosas implicaciones de la decisión que tenemos entre manos. Para Scribner, eso significaba delegar la decisión vital en un grupo de laicos (en vez de un grupo de médicos aparentemente objetivos y reunidos a puerta cerrada). Hoy en día, eso significaría pedir que los algoritmos de alto riesgo se auditen. Por ahora, la auditoría de algoritmos por algunas partes independientes es más un elemento de la lista de deseos que una práctica estándar. Mediante el ejemplo de la enfermedad renal, Robinson muestra cómo eso también se podría llevar a cabo.

En la década de los 2000, se desarrolló un algoritmo en EE UU para identificar a los receptores de los riñones donados, pero algunas personas no estaban contentas con cómo se había diseñado el algoritmo. En 2007, Clive Grawe, un candidato a trasplante de riñón de Los Ángeles (EE UU), indicó en una sala llena de médicos que su algoritmo estaba sesgado en contra de las personas mayores, como él. El algoritmo había sido diseñado para asignar los riñones de una manera que maximizara los años de vida salvados. Esto favoreció a los pacientes más jóvenes, ricos y blancos, argumentaron Grawe y otros pacientes.

Ese tipo de sesgo en los algoritmos es común. Sin embargo, es menos común que los diseñadores de esos algoritmos estén de acuerdo en que existe un problema. Tras años de consultas con los laicos, como hizo Grawe, los diseñadores encontraron una manera menos sesgada de maximizar la cantidad de años salvados. Entre otras cosas, tomando en consideración la salud general, además de la edad. Un cambio clave fue que la mayoría de donantes, a menudo personas que fallecieron jóvenes, ya no se asignarían solo a los receptores del mismo grupo de edad. Algunos de esos riñones podrían ir a personas mayores, si estuvieran sanas. Como el comité de Scribner, el algoritmo aún no tomaba decisiones con las que todos estuvieran de acuerdo. Pero el proceso mediante el que se desarrolló es más difícil de criticar.

“No quería sentarme allí y administrar la inyección. Si alguien lo quiere hacer, solo tiene que presionar el botón”.

Felipe Nitschke

Nitschke también plantea algunas preguntas difíciles.

Este antiguo médico quemó su licencia tras una disputa legal de varios años con el Consejo Médico de Australia, fue la primera persona en administrar una inyección letal voluntaria a otro ser humano de manera legal. Durante los nueve meses entre julio de 1996 (cuando el Territorio del Norte de Australia legalizó la eutanasia) y marzo de 1997 (cuando el Gobierno federal de Australia la derogó), Nitschke ayudó a cuatro de sus pacientes a morir.

El primero, Bob Dent, era un carpintero de 66 años que padecía cáncer de próstata desde hacía cinco años, y explicó su decisión en una carta: “Si yo tuviera un animal de compañía en las mismas condiciones en las que estoy, me demandarían”.

Nitschke quería apoyar las decisiones de sus pacientes. Aun así, se sentía incómodo con el papel que le pedían que tuviera. Así que creó una máquina para ocupar su lugar. “No quería sentarme allí y administrar la inyección”, señala. “Si alguien lo quiere hacer, solo tiene que presionar el botón”.

La máquina no tenía gran cosa: era un ordenador portátil conectado a una jeringa. Pero logró su propósito. Sarco es una iteración de ese dispositivo original, que luego fue adquirido por el Museo de Ciencias de Londres (Reino Unido). Nitschke espera que el próximo paso sea un algoritmo capaz de llevar a cabo una evaluación psiquiátrica.

No obstante, es posible que esas esperanzas se desvanezcan. Crear un programa que evalúe la salud mental de una persona es un problema sin solución, también controvertido. Como señala el propio Nitschke, los médicos no se ponen de acuerdo sobre lo que significa que una persona en sus cabales decida morir. “Se puede obtener una docena de respuestas distintas de una docena de psiquiatras diferentes”, resalta Nitschke. En otras palabras, no hay un terreno común sobre el cual se pueda construir ese algoritmo.

Aunque eso no es lo más importante. Al igual que Scribner, Nitschke se pregunta qué es una decisión médica y qué una decisión ética, quién puede elegir. Scribner pensó que los laicos representan a la sociedad en su conjunto, y deberían elegir quién recibe su diálisis. Ya que, cuando los pacientes tienen las mismas posibilidades de supervivencia, quién vive y quién muere no es una cuestión técnica. Como lo describe Robinson, la sociedad debe ser responsable de tales decisiones, aunque el proceso se puede codificar en un algoritmo si se realiza de manera inclusiva y transparente. Para Nitschke, el suicidio asistido también es una decisión ética que los individuos deben tomar por sí mismos. Sarco, y el algoritmo teórico que imagina Nitschke, solo protegerían su capacidad para llevarlo a cabo.

La IA se volverá cada vez más útil, quizás esencial, a medida que aumenten las poblaciones y se extiendan los recursos. Sin embargo, el verdadero trabajo consistirá en reconocer lo horrible y arbitrario de muchas de las decisiones que la IA deberá tomar. Y eso depende de nosotros.

Para Robinson, idear los algoritmos es parecido a legislar: “Desde cierto punto de vista, mejorar un software que gobierne a las personas es un paradigma de mejorar la manera de hacer las leyes. La población no está de acuerdo sobre los beneficios de las diferentes formas de crear software de alto riesgo, igual que discrepan sobre las ventajas de las distintas maneras de promulgar las leyes”. Son las personas, en el sentido más amplio, las responsables de las leyes que tenemos.