El entorno está controlado por una inteligencia artificial central que va sometiendo a las IA jugadoras a tareas cada vez más complejas a medida que dominan las sencillas sin intervención humana. Bastan 30 minutos de juegos para que los sistemas aprendan a adaptar sus capacidades a nuevos retos

DeepMind ha desarrollado un gran patio de juego virtual de caramelos de colores que enseña habilidades generales a los sistemas de inteligencia artificial (IA) cambiando constantemente las tareas asignadas. En vez de desarrollar únicamente las habilidades necesarias para resolver una tarea concreta, las IA aprenden a experimentar y explorar, adquiriendo capacidades que luego usan para tener éxito en tareas nuevas. Se trata de un pequeño paso hacia la inteligencia artificial general.

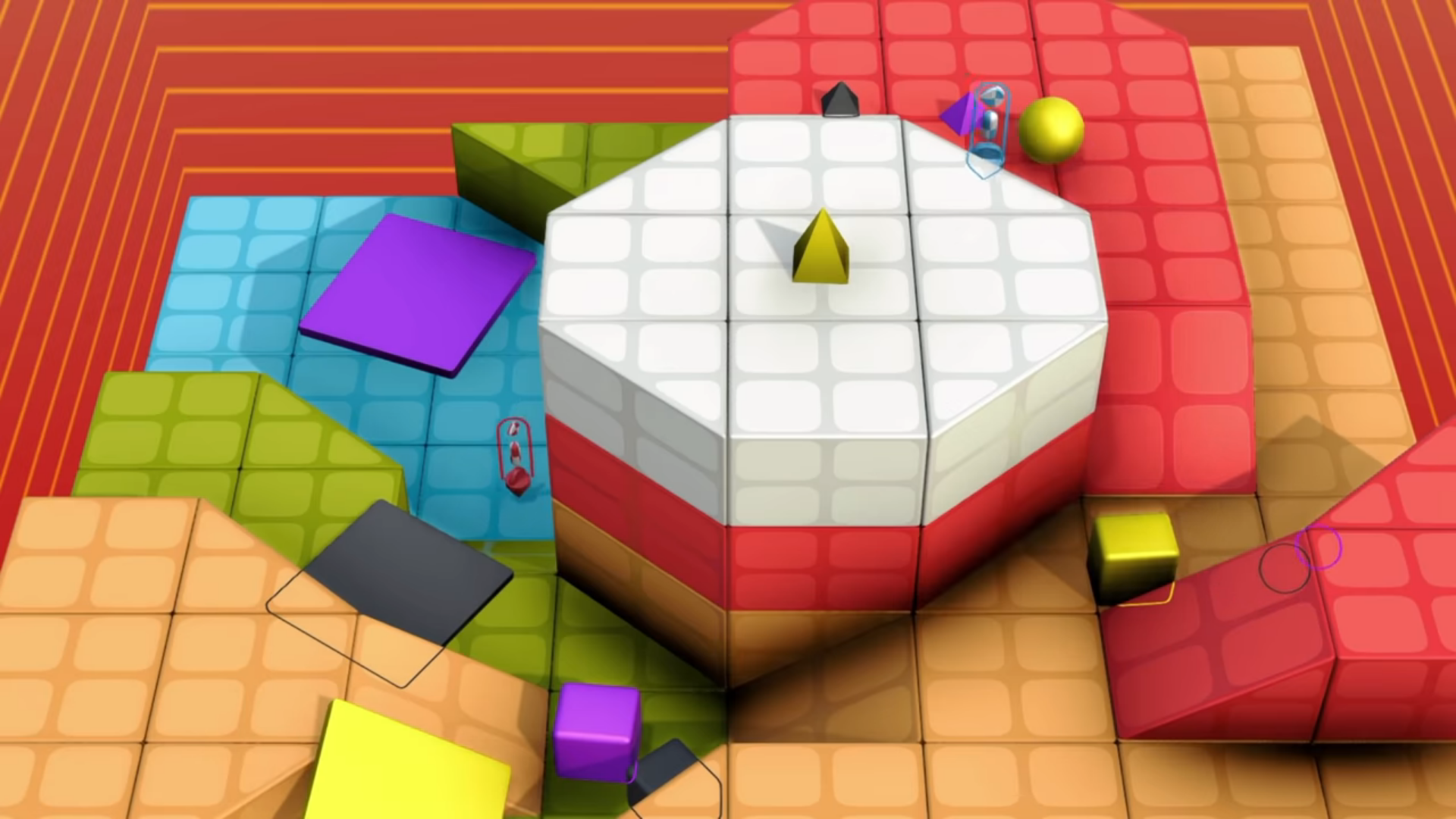

¿Qué es? XLand es un mundo en 3D, similar a un videojuego, que los jugadores de IA perciben en color. El área está gestionada por una IA central que establece miles de millones de tareas diferentes para los jugadores cambiando el entorno, las reglas del juego y el número de jugadores. Tanto los jugadores como el administrador utilizan aprendizaje reforzado para mejorar mediante prueba y error.

Durante el entrenamiento, los jugadores se enfrentan primero a juegos sencillos individuales, como encontrar un cubo morado o colocar una bola amarilla en el suelo rojo. Avanzan a otros juegos multijugador más complejos como el escondite o el juego de capturar la bandera, en el cual los equipos compiten para ser los primeros en encontrar y hacerse con la bandera de su oponente. El administrador del área de juegos no tiene un objetivo específico, solo intenta mejorar la capacidad general de los jugadores a lo largo del tiempo.

¿Por qué es tan genial? Las IA como AlphaZero de DeepMind han vencido a los mejores jugadores humanos del mundo de ajedrez y Go. Pero solo pueden aprender un juego a la vez. Como explicó el cofundador de DeepMind, Shane Legg, cuando hablé con él el año pasado, es como tener que cambiar el cerebro de ajedrez por el cerebro de Go cada vez que se quiere cambiar de juego.

Los investigadores intentan construir IA capaces de aprender múltiples tareas a la vez, lo que significa enseñarles habilidades generales que faciliten su adaptación de un reto a otro.

Vídeo: Tras aprender a experimentar, estos bots improvisaron una rampa. Créditos: DeepMind

Una tendencia interesante en esta dirección es el aprendizaje abierto, donde las IA se entrenan en varias tareas diferentes sin un objetivo específico. En muchos sentidos, así es como parece que aprenden los seres humanos y otros animales, a través del juego sin rumbo fijo. Pero esto requiere una gran cantidad de datos. XLand genera esos datos automáticamente, en forma de un sinfín de desafíos. Es parecido a POET, el dojo de entrenamiento de IA donde los bots de dos piernas aprenden a sortear obstáculos en un paisaje en 2D. Sin embargo, el mundo de XLand es mucho más complejo y detallado.

XLand también es un ejemplo de inteligencia artificial que aprende a hacerse a sí misma, o lo que el jefe del equipo que trabaja en este tema en OpenAI, Jeff Clune, quien además ayudó a desarrollar POET, llama algoritmos de generación de inteligencia artificial (AG-IA o AI-GA, por sus siglas en inglés). "Este trabajo amplía las fronteras de los AI-GA. Es muy fascinante", afirma Clune.

¿Qué aprendieron? Algunas de las IA de XLand de DeepMind jugaron 700.000 juegos diferentes en 4.000 mundos distintos, encontrando 3,4 millones de tareas únicas en total. En vez de aprender qué es lo mejor que se puede hacer en cada situación, algo que hace la mayoría de las existentes IA de aprendizaje reforzado, los jugadores aprendieron a experimentar: a mover objetos para ver qué pasaba o a usar un objeto como herramienta para alcanzar otro o esconderse detrás, hasta llegar a superar la tarea propuesta.

En los vídeos se puede ver a las IA tirando objetos hasta que se topan con algo útil: una baldosa grande, por ejemplo, se convierte en una rampa hacia una plataforma. Resulta difícil saber con certeza si todos estos resultados son intencionados o coincidencias accidentales, señalan los investigadores. Pero ocurren de manera constante.

Las IA que aprendieron a experimentar tenían ventaja en la mayoría de las tareas, incluso en aquellas que no habían visto antes. Los investigadores encontraron que después de solo 30 minutos de entrenamiento en una nueva tarea compleja, las IA de XLand se adaptaban rápidamente. Pero las IA que no habían pasado tiempo en XLand no podían aprender estas tareas en absoluto.