La mayoría del sector se centra en imitar los procesos humanos de aprendizaje, pero, cuando se deja que un sistema diseñe sus propios retos, acaba resolviéndolos de maneras que no se le habrían ocurrido a ningún desarrollador, un nuevo enfoque que podría acercarnos a la inteligencia artificial general

Una pequeña figura de palo con cabeza en forma de cuña se mueve medio agachada por la pantalla, arrastrando una rodilla por el suelo. ¡Está caminando! O algo así. El investigador de inteligencia artificial (IA) en Uber Rui Wang está encantado con ella, y afirma: "Cada día entro en mi oficina y miro mi ordenador sin saber qué esperar".

A Wang le gusta dejar el software Paired Open-Ended Trailblazer (POET), que él mismo ayudó a desarrollar, ejecutándose en su ordenador portátil durante la noche. POET es una especie de dojo de entrenamiento para bots virtuales. De momento no han aprendido a hacer gran cosa. Estos agentes de inteligencia artificial no están jugando a Go, detectando signos de cáncer ni proteínas plegables; solo intentan moverse por un simple paisaje de dibujos animados de vallas y barrancos sin caerse.

Lo fascinante no es lo que están aprendiendo, sino cómo lo hacen. POET genera una serie de obstáculos, evalúa las habilidades de los bots y asigna su próximo desafío, todo sin ninguna participación humana. Paso a paso vacilante, los bots mejoran mediante prueba y error. "En algún momento es capaz de saltar por un acantilado como un maestro de kung fu", explica Wang.

Puede que parezca algo muy básico en estos momentos, pero para Wang y un puñado de investigadores, POET apunta a una nueva y revolucionaria forma de crear máquinas superinteligentes: dejar que la IA se construya a sí misma.

El antiguo colega de Wang Jeff Clune figura entre los mayores impulsores de esta idea. Lleva años trabajando en ella, primero en la Universidad de Wyoming (EE. UU.) y luego en Uber AI Labs, donde colaboró con Wang. Actualmente, divide su tiempo entre la Universidad de Columbia Británica (Canadá) y OpenAI, y cuenta con el respaldo de uno de los mejores laboratorios de inteligencia artificial del mundo.

Cree que construir una IA verdaderamente inteligente es la búsqueda científica más ambiciosa de la historia de la humanidad. Hoy en día, siete décadas después del inicio de los esfuerzos serios para generar la IA, todavía estamos muy lejos de crear máquinas tan inteligentes como los seres humanos, y mucho menos más inteligentes que nosotros. Clune opina que POET podría ser un atajo para lograrlo. Y afirma: "Tenemos que quitarnos las trabas del pasado y salir de nuestro propio camino".

Si Clune tiene razón, usar IA para hacer IA podría ser un paso importante que algún día conduciría a la inteligencia artificial general (IAG, o AGI por sus siglas en inglés), máquinas capaces de adelantar a las personas. A un plazo más corto, esa técnica también podría ayudarnos a descubrir diferentes tipos de inteligencia: la no humana que puede encontrar soluciones inesperadas y quizás complementar nuestra propia inteligencia en vez de reemplazarla.

Imitar la evolución

Hablé por primera vez con Clune sobre esa idea a principios del año pasado, solo unas semanas después de que se incorporara a OpenAI. Le gustó comentar sus trabajos anteriores, pero se mantuvo callado sobre lo que estaba haciendo con su nuevo equipo. En vez de atender la llamada en algún sitio cerrado, prefirió caminar por las calles fuera de las oficinas mientras hablábamos.

Todo lo que dijo sobre su trabajo actual es que OpenAI era una buena opción: "Mis ideas coinciden con muchas de las cosas en las que creen ahí. Fue una especie de matrimonio hecho en el cielo. Les gustó mi visión y querían que me fuera con ellos y la persiguiera". Unos meses después de su incorporación, OpenAI también contrató a la mayor parte de su antiguo equipo de Uber.

La ambiciosa visión de Clune se basa en mucho más que en la inversión de OpenAI. La historia de la IA está llena de ejemplos en los que las soluciones diseñadas por personas dieron paso a las aprendidas por las máquinas. Como por ejemplo la visión artificial: hace una década, el gran avance en el reconocimiento de imágenes se produjo cuando los sistemas hechos a mano existentes fueron reemplazados por otros que se enseñaron solos a sí mismos desde cero. Lo mismo ocurre con muchos otros éxitos de la IA.

Una de las cosas fascinantes de la IA, y del aprendizaje automático en particular, es su capacidad de encontrar soluciones que los seres humanos no han encontrado, de sorprendernos. Un ejemplo frecuentemente citado es AlphaGo (y su sucesor AlphaZero), que venció a lo mejor que la humanidad tiene para ofrecer en el antiguo y cautivador juego de Go con estrategias inauditas. Después de cientos de años de estudio por los maestros humanos, la IA encontró soluciones en las que nadie había pensado.

Clune está trabajando con el equipo de OpenAI que en 2018 desarrolló los bots que aprendieron a jugar al escondite en un entorno virtual. Estas IA comenzaron con unos objetivos simples y herramientas sencillas para lograrlos: una pareja tenía que encontrar a la otra pareja, que podía esconderse detrás de unos obstáculos móviles. Pero, cuando se les permitió que aprendieran libremente, encontraron formas de aprovechar su entorno imprevistas por los investigadores. Usaron los errores en la física simulada de su mundo virtual para saltar e incluso atravesar algunas paredes.

Ese tipo de comportamientos emergentes inesperados ofrecen indicios tentadores de que la IA podría llegar a soluciones técnicas que a las personas no se les ocurrirían, lo que podría dar lugar a nuevos tipos de algoritmos o redes neuronales que también serían más eficientes, o incluso abandonando por completo las redes neuronales, la piedra angular de la IA moderna.

A Clune le gusta recordar a la gente que la inteligencia nació de unos comienzos simples. Y afirma: "Lo interesante de este enfoque es que sabemos que puede funcionar. El sencillo algoritmo de la evolución darwiniana produjo nuestro cerebro, y nuestro cerebro es el algoritmo de aprendizaje más inteligente del universo que conocemos hasta ahora". Su punto de vista consiste en que si la inteligencia tal y como la conocemos es el resultado de la mutación inconsciente de genes durante incontables generaciones, ¿por qué no intentar replicar el proceso de creación de la inteligencia, que posiblemente es más simple, en lugar de la propia inteligencia?

Pero ahí aparece otra observación crucial. La inteligencia nunca fue el punto final de la evolución, algo a lo que aspirar. En cambio, surgió en muchas formas diferentes, desde las numerosas soluciones pequeñas hasta los desafíos que permitieron que los seres vivos sobrevivieran y asumieran futuros retos. La inteligencia actual fue la culminación de un proceso continuo y abierto. En este sentido, la evolución es bastante diferente de los algoritmos tal y como la gente suele considerarlos, como un medio para un fin.

Lo que Clune y otros creen que podría conducir a nuevos tipos de IA es ese carácter abierto que se vislumbra en la secuencia aparentemente sin objetivo de los desafíos generados por POET. Durante décadas, los investigadores de inteligencia artificial han intentado construir algoritmos para imitar la inteligencia humana, pero el verdadero avance puede provenir de la construcción de algoritmos que intentan imitar la resolución de problemas de la evolución abierta y sentarnos a observar lo que surge.

Los investigadores ya están entrenando al aprendizaje automático para que encuentre soluciones por sí solo a algunos de los problemas más difíciles del campo: cómo hacer máquinas capaces de aprender más de una tarea a la vez o manejar situaciones que no han visto antes. Algunos piensan que adoptar este enfoque y ejecutarlo podría ser el mejor camino hacia la inteligencia artificial general. "Podríamos empezar con un algoritmo que al principio no tiene mucha inteligencia y ver cómo se completa a sí mismo hasta llegar potencialmente a una IAG", explica Clune.

La verdad es que, por ahora, la IAG sigue siendo una fantasía. Pero eso se debe en gran parte a que nadie sabe cómo crearla. Los avances en la IA son parciales y los llevan a cabo personas del campo, y el progreso generalmente implica ajustes en las técnicas o algoritmos existentes, lo que produce saltos incrementales en el rendimiento o en la precisión. Clune describe estos esfuerzos como intentos de descubrir los componentes básicos de la inteligencia artificial sin saber qué se está buscando o cuántos de ellos harán falta. Y eso es solo el comienzo. "En algún momento, tenemos que asumir la titánica tarea de juntarlos todos", asegura.

Pedirle a la IA que encuentre y junte esos componentes básicos por nosotros supone un cambio de paradigma. Significa que queremos crear una máquina inteligente, pero no nos importa cómo será, solo queremos que funcione.

Incluso si nunca se llega a conseguir una inteligencia artificial general, el enfoque de autoaprendizaje aún puede cambiar los tipos de IA que se crean. El mundo necesita algo más que un buen jugador de Go, según Clune. Para él, crear una máquina súper inteligente significa construir un sistema que invente sus propios desafíos, los resuelva y luego invente otros nuevos. POET es un pequeño vistazo de esto en acción. Clune imagina una máquina que enseña a un robot a caminar, luego a jugar a la rayuela, y después tal vez a jugar a Go. "Entonces quizás aprenda a resolver problemas matemáticos y comience a inventar sus propios desafíos. El sistema innova continuamente y el cielo es el límite en cuanto a adónde podría llegar", explica.

A lo mejor se trata de una idea descabellada, pero se espera que máquinas como esta puedan esquivar nuestros callejones sin salida conceptuales, ayudándonos a solucionar situaciones críticas muy complejas como el cambio climático o la salud global. Pero primero tenemos que construir una.

Cómo crear un cerebro

Hay muchas formas diferentes de conectar un cerebro artificial. Las redes neuronales están formadas por múltiples capas de neuronas artificiales codificadas en el software. Cada neurona se puede conectar a otras de las capas superiores. La forma de la conexión de una red neuronal marca una gran diferencia, y las nuevas arquitecturas a menudo conducen a nuevos avances.

Las redes neuronales codificadas por los científicos suelen ser el resultado de un proyecto de prueba y error. Hay poca teoría sobre lo que funciona y lo que no, y no hay garantías de que ya hayamos encontrado los mejores diseños. Es por eso que la automatización de la búsqueda de mejores diseños de redes neuronales ha sido uno de los temas más candentes en IA desde la década de 1980. La forma más común de automatizar el proceso es dejar que una IA genere muchos posibles diseños de red, que pruebe automáticamente cada uno de ellos y elija los mejores. Esto se conoce comúnmente como la neuroevolución o búsqueda de arquitectura neuronal (NAS, por sus siglas en inglés).

En los últimos años, estos diseños de máquinas han empezado a superar a los creados por las personas. En 2018, el investigador de Google Esteban Real y sus colegas utilizaron NAS para generar una red neuronal para el reconocimiento de imágenes que venció a las mejores redes diseñadas por personas en ese momento. Fue una revelación.

El sistema de 2018 es parte del proyecto en curso de Google AutoML, que también ha utilizado NAS para producir EfficientNets, una familia de modelos de aprendizaje profundo más eficientes que los diseñados por los ingenieros humanos, que logran altos niveles de precisión en tareas de reconocimiento de imágenes con modelos más pequeños y más rápidos.

Tres años después, Real está traspasando los límites de lo que se puede generar desde cero. Los sistemas anteriores simplemente reorganizaban las piezas de las redes neuronales probadas y verificadas, como los tipos de capas o componentes existentes. "Podríamos esperar una buena respuesta", opina Real.

El año pasado Real y su equipo se quitaron los ruedines de seguridad. El nuevo sistema AutoML Zero, intenta construir una IA desde cero mediante nada más que los conceptos matemáticos más básicos que gobiernan el aprendizaje automático.

Sorprendentemente, AutoML Zero no solo construyó espontáneamente una red neuronal, sino que también ideó el descenso de gradientes, la técnica matemática más común que usan los diseñadores para entrenar una red. Real admite: "Me sorprendió bastante. Es un algoritmo muy simple, de unas seis líneas de código, pero escribió las seis líneas exactas".

AutoML Zero aún no está generando arquitecturas capaces de competir con el rendimiento de los sistemas diseñados por humanos, ni está haciendo gran cosa que no hiciera un diseñador humano. Pero Real cree que algún día podrá.

Es hora de formar a un nuevo tipo de profesor

Primero se crea un cerebro; luego hay que enseñarle. Pero los cerebros de las máquinas no aprenden como los nuestros. Nuestros cerebros son fantásticos para adaptarse a nuevos entornos y nuevas tareas. Las IA de hoy en día pueden resolver algunos desafíos bajo ciertas condiciones, pero fallan cuando esas condiciones cambian mínimamente. Esta inflexibilidad obstaculiza la búsqueda de una IA generalizable que pueda ser útil en una amplia variedad de escenarios, lo que sería un gran paso para que fuera verdaderamente inteligente.

Para la investigadora de DeepMind en Londres (Reino Unido) Jane Wang, la mejor manera de hacer que la IA sea más flexible consiste en conseguir que aprenda por sí misma. En otras palabras, Wang quiere crear una IA que no solo aprenda tareas específicas, sino que también cómo adaptarse a nuevas situaciones.

Los investigadores llevan años intentando que la IA sea más adaptable. Wang cree que lograr que la IA resuelva un problema por sí misma evita una parte del ensayo y error del enfoque diseñado a mano: "No podemos esperar encontrar la respuesta correcta de inmediato". Espera que en el proceso también aprendamos más sobre cómo funcionan los cerebros, y añade: "Todavía hay muchas cosas que no entendemos sobre cómo aprenden los seres humanos y los animales".

Hay dos métodos principales para generar algoritmos de aprendizaje automático, y ambos empiezan con una red neuronal existente y una IA para enseñarla.

El primer enfoque, inventado por separado por Wang y sus colegas de DeepMind y por un equipo de OpenAI aproximadamente al mismo tiempo, utiliza las redes neuronales recurrentes. Este tipo de red se puede entrenar de tal manera que la activación de sus neuronas (más o menos similar a la activación de neuronas en los cerebros biológicos), codifiquen cualquier tipo de algoritmo. DeepMind y OpenAI aprovecharon esto para entrenar una red neuronal recurrente a generar algoritmos de aprendizaje reforzado, que indican a una IA cómo comportarse para lograr unos objetivos dados.

El resultado es que los sistemas de DeepMind y de OpenAI no aprenden un algoritmo que resuelve un desafío específico, como reconocer imágenes, sino un algoritmo de aprendizaje que se puede aplicar a múltiples tareas y adaptarse a medida que avanza. Es como la vieja máxima sobre enseñar a alguien a pescar: mientras que un algoritmo diseñado a mano puede aprender una tarea concreta, estas IA están diseñadas para aprender a aprender por sí mismas. Y algunas funcionan mejor que las diseñadas por personas.

El segundo método proviene de la investigadora de la Universidad de California, Berkeley (EE. UU.) Chelsea Finn y sus colegas. Su modelo de meta-aprendizaje agnóstico, o MAML, entrena un modelo mediante dos procesos de aprendizaje automático, uno dentro del otro.

Funciona más o menos de siguiente manera: el proceso interno en MAML se entrena con los datos y luego se prueba, como siempre. Pero luego, el modelo externo se apropia del rendimiento del modelo interno (por ejemplo, su técnica para identificar las imágenes) y lo usa para aprender a ajustar el algoritmo de aprendizaje de ese modelo para mejorar el desempeño. Es como si un inspector escolar supervisara a un grupo de profesores, cada uno de los cuales ofrece diferentes técnicas de aprendizaje. El inspector comprueba qué técnicas ayudan a los alumnos a obtener las mejores notas y las aplica en consecuencia.

A través de estos métodos, los investigadores construyen una IA más sólida, más generalizada y capaz de aprender más rápido con menos datos. Por ejemplo, Finn quiere lograr que un robot haya aprendido a caminar sobre un terreno plano pueda aprender a caminar en pendiente o sobre hierba o llevando una carga con un entrenamiento adicional mínimo.

El año pasado, Clune y sus colegas ampliaron la técnica de Finn para diseñar un algoritmo que aprendió con menos neuronas para no perder todo lo que había aprendido anteriormente (es un gran problema sin resolver en el aprendizaje automático conocido como el olvido catastrófico). Un modelo entrenado que usa menos neuronas, denominado modelo "disperso", tendrá más neuronas sin usar para dedicarlas a las nuevas tareas cuando se reentrena, lo que significa que se sobrescribirán menos de las neuronas "usadas". Clune descubrió que al someter a su IA al desafío de aprender más de una tarea acabó creando su propia versión de un modelo disperso que superó a los diseñados por personas.

Si vamos a dejar que la IA cree y se enseñe a sí misma, entonces las IA también deberían generar sus propios entornos de formación: escuelas, libros de texto y planes de estudio.

El año pasado apareció una serie de proyectos en los que la inteligencia artificial se entrenó con datos generados automáticamente. Los sistemas de reconocimiento facial se entrenan con los rostros generados por IA, por ejemplo. Las IA también están aprendiendo a entrenarse entre sí. En un ejemplo reciente, dos brazos robóticos trabajaron juntos, uno aprendió a desafiar al otro a apilar bloques, de forma cada vez más difícil, y así entrenó al otro a agarrar y girar objetos.

De hecho, Clune se pregunta si la intuición humana sobre qué tipo de datos necesita una IA para aprender podría estar equivocada. Por ejemplo, sus colegas y él han desarrollado las denominadas redes de enseñanza generativa, que aprenden qué datos deben generar para obtener los mejores resultados al entrenar un modelo. En un experimento, usó una de estas redes para adaptar un conjunto de datos de números escritos a mano que a menudo se usa para entrenar algoritmos de reconocimiento de imágenes. El resultado era muy diferente del conjunto de datos original creado por humanos: cientos de dígitos que no eran del todo números, como la mitad superior de un siete o lo que parecían dos dígitos fusionados. Algunos ejemplos generados por IA fueron difíciles de descifrar. A pesar de esto, los datos generados por IA aún hicieron un gran trabajo en entrenar el sistema de reconocimiento de escritura a mano para identificar los dígitos reales.

No perseguir el éxito

Los datos generados por IA solo son una parte del rompecabezas. La idea a largo plazo consiste en tomar todas estas técnicas, y otras que aún no se han inventado, y entregarlas a un entrenador de inteligencia artificial que controle cómo se conectan los cerebros artificiales, cómo se entrenan y con qué datos. Ni siquiera Clune tiene claro cómo sería un sistema de este tipo en el futuro. A veces habla de una especie de arenero simulado hiperrealista, donde las IA empiezan a gatear y hacen sus primeros pasos virtuales. Todavía faltan años para algo tan complejo. Lo más parecido hasta ahora es POET, el sistema que Clune creó con Rui Wang de Uber y otros colegas.

POET se creó gracias a una paradoja, recuerda Wang. Si intentamos resolver un problema, fracasaremos; si no intentamos solucionarlo, es más probable que tengamos éxito. Es una de las ideas que Clune extrae de su analogía con la evolución: los asombrosos resultados que surgen de un proceso aparentemente aleatorio a menudo no se pueden recrear con pasos deliberados hacia el mismo fin. No hay duda de que las mariposas existen, pero si retrocedemos a sus precursores unicelulares e intentamos crearlas desde cero eligiendo cada paso desde la bacteria hasta el insecto, probablemente no lo logremos.

POET empieza con su agente de dos piernas en un entorno simple, como un camino plano sin obstáculos. Al principio, el agente no sabe qué hacer con las piernas y no puede caminar. Pero a través de prueba y error, el algoritmo de aprendizaje reforzado que lo controla aprende a moverse por el terreno plano. POET luego genera un nuevo entorno aleatorio diferente, pero no necesariamente más difícil para moverse. El agente intenta caminar por allí. Si hay obstáculos en este nuevo entorno, el agente aprende a superarlos. Cada vez que tiene éxito o se atasca, se traslada a un nuevo entorno. Con el tiempo, los agentes aprenden una serie de acciones para caminar y saltar que les permiten moverse por caminos de obstáculos cada vez más difíciles.

El equipo descubrió que el cambio aleatorio de entornos resulta esencial.

Por ejemplo, los agentes a veces aprendían a caminar sobre un terreno llano con un movimiento extraño, medio arrodillados, porque con eso bastaba. "Nunca aprenden a ponerse de pie porque no necesitan hacerlo", explica Wang. Pero después de verse obligados a aprender estrategias alternativas en un terreno lleno de obstáculos, regresaron a la etapa inicial con una mejor forma de caminar, usando ambas piernas en vez de arrastrar una, por ejemplo, y luego llevaban esa versión mejorada de sí mismos hacia adelante a los desafíos más difíciles.

POET entrena a sus bots de una manera que ningún experto humano utilizaría: toma caminos erráticos y poco intuitivos hacia el éxito. En cada etapa, los bots intentan encontrar una solución a cualquier desafío que se les presente. Al abordar una selección aleatoria de obstáculos que aparecen, mejoran en general. Pero este proceso no tiene un punto final, ni una prueba definitiva que aprobar ni una puntuación alta que superar.

Clune, Wang y varios de sus colegas creen que se trata de un conocimiento profundo. Actualmente están explorando lo que podría significar para el desarrollo de máquinas superinteligentes. ¿Tratar de no trazar una senda específica podría ser un avance clave en el camino hacia la inteligencia artificial general?

POET ya está inspirando a otros investigadores, como Natasha Jaques y Michael Dennis de la Universidad de California en Berkeley, que han desarrollado un sistema denominado PAIRED que utiliza la IA para generar una serie de laberintos para entrenar a otra IA a atravesarlos.

Wang cree que los desafíos diseñados por personas serán un impedimento y que el progreso real requerirá que la IA desarrolle sus propios desafíos. Y añade: "Independientemente de lo buenos que sean los algoritmos hoy en día, siempre se prueban en algún punto de referencia diseñado a mano. Es muy difícil imaginar que la inteligencia artificial general provenga de esto, porque está limitada por unos objetivos fijos".

Un nuevo tipo de inteligencia

El rápido desarrollo de la IA capaz de entrenarse a sí misma también plantea preguntas sobre lo bien que podemos controlar su crecimiento. La idea de una IA que construye una IA mejor es una parte crucial de la creación de los mitos de la "singularidad", el punto imaginario en el que las IA comienzan a mejorar a un ritmo exponencial y avanzan más allá de nuestro control. Algunos fatalistas advierten que, con el tiempo, la IA podría decidir que no necesita a los seres humanos en absoluto.

Eso no es lo que ninguno de estos investigadores tiene en mente: su trabajo está muy centrado en mejorar la IA actual. Las máquinas que se vuelven locas siguen siendo una remota anti-fantasía.

Aun así, Wang tiene sus reservas. Una gran parte del atractivo de usar IA para hacer IA es que puede crear diseños y técnicas en las que la gente no había pensado. No obstante, señala que no todas las sorpresas son buenas: "El final abierto es, por definición, inesperado". Si la idea es lograr que la IA haga algo que no anticipamos, se vuelve más difícil de controlar. "Es emocionante y aterrador a la vez", asegura.

Clune también destaca la importancia de pensar en la ética de esta nueva tecnología desde el principio. Existe una buena posibilidad de que las redes neuronales y los algoritmos diseñados por IA sean aún más difíciles de entender que los sistemas actuales de caja negra ya opacos. ¿Las IA generadas por algoritmos serán más difíciles de auditar en busca de sesgos? ¿Será más complicado garantizar que no se comportarán de manera indeseable?

Clune espera que estas preguntas se hagan y respondan a medida que más personas se den cuenta del potencial de las IA autogeneradas. Y añade: "La mayoría de las personas en la comunidad de aprendizaje automático nunca habla sobre nuestro camino hacia una inteligencia artificial extremadamente poderosa". En cambio, tienden a centrarse en pequeñas mejoras incrementales. Clune quiere volver a iniciar una conversación sobre las grandes ambiciones del campo.

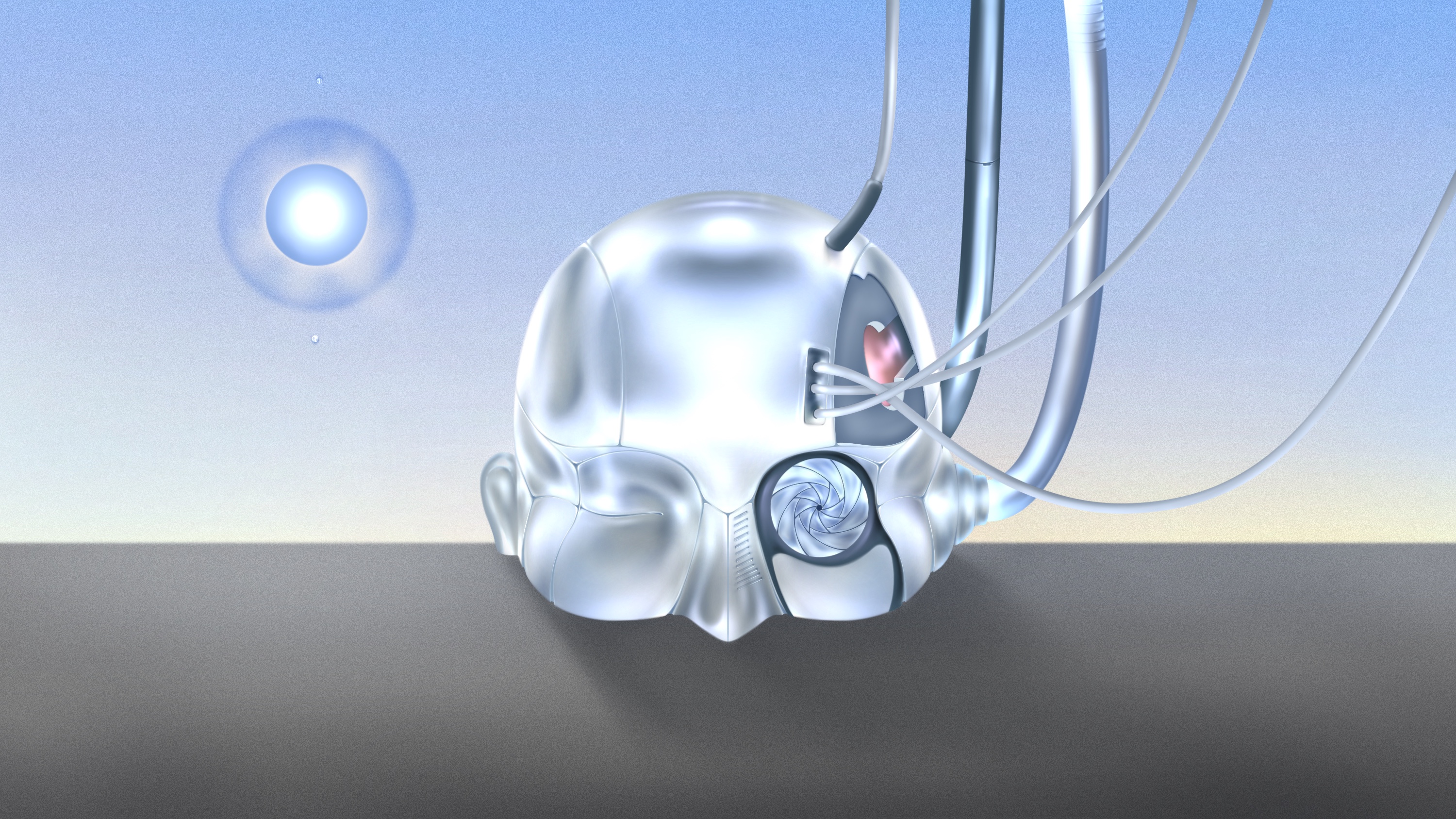

Sus propias ambiciones están relacionadas con sus primeros intereses en la inteligencia humana y su evolución. Su gran visión es que, algún día, las máquinas podrán ver su propia inteligencia, o inteligencias, emerger y mejorar a través de incontables generaciones de prueba y error, guiadas por algoritmos sin un plan en mente.

Si la IA empieza a generar inteligencia por sí misma, no hay garantías de que sea similar a la humana. En vez de que las personas enseñen a las máquinas a pensar como los seres humanos, las máquinas podrían enseñar a la gente nuevas formas de pensar.

Clune concluye: "Probablemente haya una gran cantidad de formas de ser muy inteligente. Una de las cosas que me entusiasman de la IA es que podríamos llegar a comprender la inteligencia de una manera más general, al ver las posibles variaciones. Creo que es fascinante. Quiero decir, es casi como inventar viajes interestelares y poder visitar culturas alienígenas. No habría mejor momento en la historia de la humanidad que encontrarse con una raza alienígena y aprender sobre su cultura, su ciencia, y todo lo demás. Los viajes interestelares son extremadamente difíciles, pero quizás tenemos la capacidad de crear esas inteligencias alienígenas digitalmente ".