En su libro 'Atlas of AI', Kate Crawford analiza toda la cadena de desarrollo de la inteligencia artificial, desde las actividades mineras para extraer los componentes de los ordenadores. En su opinión, toda la conversación sobre la tecnología deja el efecto de la tecnología sobre el planeta y las personas

A principios del siglo XX, un caballo alemán tomó Europa por asalto. Hans el Inteligente (Hans Clever), como se le conocía, parecía poder realizar todo tipo de trucos antes limitados a los humanos. Sabía sumar y restar, leer la hora y un calendario, incluso deletrear palabras y frases. Daba todas las respuestas chocando su pezuña contra el suelo. "A" era un golpe; "B" dos; 2 + 3 = 5. Fue un éxito internacional, y muchos creían que era una prueba de que a los animales se les podía enseñar a razonar tan bien como a los humanos.

El problema era que Hans realmente no hacía nada de eso. Como los investigadores descubrieron más tarde, el caballo había aprendido a dar la respuesta correcta al observar los cambios en la postura, la respiración y las expresiones faciales de sus interrogadores. Si el interrogador se quedaba demasiado lejos, Hans perdía sus habilidades. Su inteligencia era pura apariencia.

Esta historia se utiliza como advertencia cuando los investigadores de inteligencia artificial (IA) deben evaluar las capacidades de sus algoritmos. Un sistema no siempre es tan inteligente como parece. Hay que tener cuidado y medirlo correctamente.

La destacada experta en inteligencia artificial Kate Crawford le da la vuelta a esta lección en su nuevo libro, Atlas of AI. Crawford escribe que el problema residía en la forma en la que la gente definía los logros de Hans: "Hans ya estaba realizando extraordinarias hazañas de comunicación entre especies, de actuación pública y de considerable paciencia, pero eso no se reconoció como inteligencia".

Así comienza la exploración de Crawford sobre la historia de la inteligencia artificial y su impacto en nuestro mundo físico. Cada capítulo busca ampliar nuestra comprensión sobre la tecnología al revelar cuán estrechamente la hemos visto y definido.

Crawford lo hace llevándonos en un viaje por el mundo, desde las minas donde se extraen los elementos raros utilizados en la fabricación de ordenadores hasta los centros logísticos de Amazon donde los humanos han sido mecanizados en la búsqueda incesante de crecimiento y beneficios de la compañía.

En el primer capítulo, la autora relata cómo condujo una camioneta desde el corazón de Silicon Valley hasta una pequeña comunidad minera en Clayton Valley (ambos en EE. UU.). Allí investigó las prácticas destructivas con el medio ambiente necesarias para obtener el litio para los ordenadores de todo el mundo. Es una ilustración contundente de lo cerca que estos dos lugares están geográficamente y lo enormemente lejos que se encuentran en cuanto a riqueza.

Al basar su análisis en tales investigaciones físicas, Crawford descarta la formulación eufemística de que la inteligencia artificial es simplemente un software eficiente que se ejecuta en "la nube". Sus descripciones vívidas y directas de la tierra y las labores sobre las cuales se construye la IA, y de las historias profundamente problemáticas que hay detrás de eso, hacen que sea imposible seguir hablando de la tecnología solo como algo abstracto.

En el cuarto capítulo, por ejemplo, Crawford nos lleva a otro viaje través del tiempo en vez del espacio. Para explicar la historia de la obsesión de este campo con la clasificación, visitó el Museo Penn en Filadelfia (EE. UU.) donde observó filas de cráneos humanos.

Los cráneos habían sido recogidos por el craneólogo estadounidense del siglo XIX Samuel Morton, quien creía que era posible dividirlos "objetivamente" por sus medidas físicas en las cinco "razas" del mundo: africana, nativa americana, caucásica, malaya y mongoloide. Crawford establece paralelismos entre el trabajo de Morton y los modernos sistemas de inteligencia artificial que siguen clasificando el mundo en categorías fijas.

Estas clasificaciones están lejos de ser objetivas, argumenta Crawford. Imponen un orden social, naturalizan las jerarquías y magnifican las desigualdades. Cuando se mira a través de esta lente, la IA ya no puede considerarse una tecnología objetiva o neutra.

En sus 20 años de carrera, Crawford ha luchado contra las consecuencias del mundo real de los sistemas de datos a gran escala, el aprendizaje automático y la inteligencia artificial. En 2017, junto a Meredith Whittaker, cofundó el instituto de investigación AI Now como una de las primeras organizaciones dedicadas a estudiar los efectos sociales de estas tecnologías. Actualmente también es profesora en la Universidad del Sur de California en Annenberg (EE. UU.), y presidenta visitante inaugural de IA y justicia en la École Normale Supérieure en París (Francia), así como investigadora principal sénior en Microsoft Research.

Crawford recuerda que hace cinco años todavía estaba trabajando para presentar la mera idea de que los datos y la IA no eran neutrales. En la actualidad, esa conversación ha evolucionado y la ética de la IA ha florecido como un campo propio. Crawford espera que su libro ayude a que este campo madure aún más.

Hemos hablado con Crawford sobre su libro.

¿Por qué decidió escribir este libro como proyecto y qué significa para usted?

Muchos de los libros que se han escrito sobre la inteligencia artificial en realidad solo hablan de unos logros técnicos muy limitados. Y a veces describen a los grandes hombres de la IA, pero eso es realmente todo lo que hemos tenido para hacer frente a lo que es la inteligencia artificial.

Creo que eso ha producido esta comprensión muy sesgada de la inteligencia artificial como sistemas puramente técnicos que de alguna manera son objetivos y neutrales y, según describen Stuart Russell y Peter Norvig en su libro, representan unos agentes inteligentes que toman la mejor decisión sobre cualquier acción posible.

Yo quería hacer algo muy diferente: he querido entender cómo se crea la inteligencia artificial en el sentido más amplio. Esto significa analizar los recursos naturales que la impulsan, la energía que consume, el trabajo oculto de la cadena de suministro y la gran cantidad de datos que se extraen de cada plataforma y dispositivo que usamos todos los días.

De esa forma, quería abrir las puertas a la idea de que la IA que no es ni artificial ni inteligente. Es lo opuesto a lo artificial. Proviene de las partes más materiales de la corteza terrestre y del trabajo humano, y de todos los artefactos que producimos, decimos y fotografiamos todos los días. Tampoco es inteligente. Creo que existe este gran pecado original en este campo, donde la gente asumió que los ordenadores eran de alguna manera como los cerebros humanos y si los entrenábamos como si fueran niños, poco a poco se convertirían en estos seres sobrenaturales.

Eso es algo que creo que resulta muy problemático: nos hemos creído esta idea de la inteligencia cuando, en realidad, solo estamos viendo formas de análisis estadístico a escala que tienen tantos problemas como los datos que reciben.

¿Le resultó inmediatamente obvio que así era como la gente debería pensar sobre la IA? ¿O ha sido un proceso?

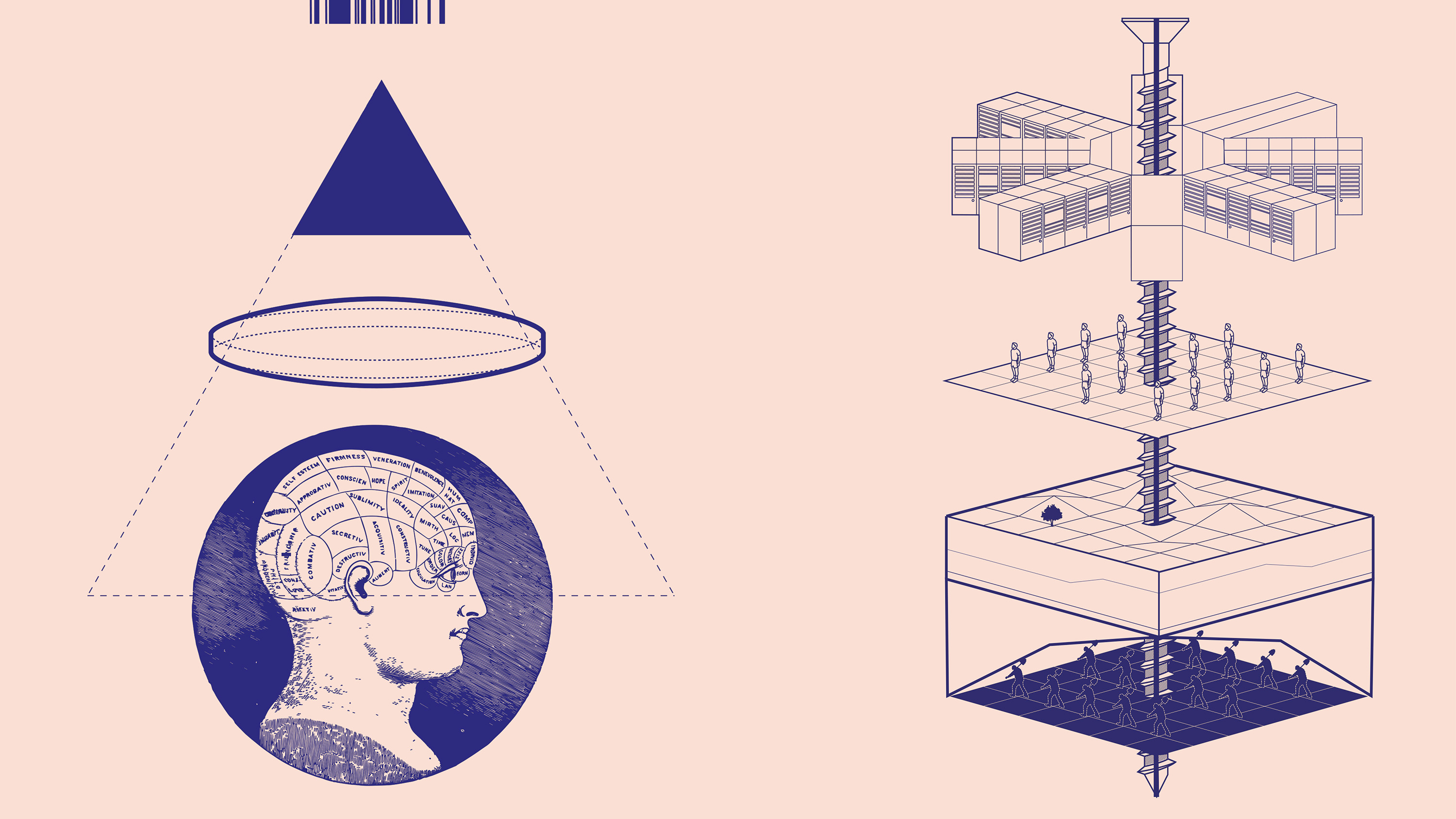

Desde luego que ha sido un proceso. Yo diría que uno de los puntos de inflexión para mí fue en 2016, cuando comencé el proyecto "Anatomía de un sistema de inteligencia artificial" (Anatomy of an AI system) con el investigador Vladan Joler. Nos conocimos en una conferencia sobre inteligencia artificial habilitada por voz, e intentamos trazar lo que se necesitaba para que Amazon Echo funcionara. ¿Cuáles eran los componentes? ¿Cómo extraía los datos? ¿Cuáles eran las capas en la distribución de datos?

Nos dimos cuenta de que, en realidad, para entender eso, hacía falta saber de dónde venían los componentes. ¿Dónde se produjeron los chips? ¿Dónde están las minas? ¿Dónde se funden? ¿Cuáles eran las vías logísticas y las cadenas de suministro?

Por último, ¿cómo rastrear el final de la vida útil de estos dispositivos? ¿Cómo saber dónde se encuentran los desechos electrónicos en lugares como Malasia, Ghana y Pakistán? Era un proyecto de investigación de dos años que nos consumió mucho tiempo para poder rastrear esas cadenas de suministro de los materiales desde la cuna a la tumba.

Cuando se empiezan a analizar los sistemas de IA en esa gran escala, y en ese horizonte de tiempo más largo, uno se aleja de las estrechas ideas de "la IA justa" y de la "ética" para concluir que estos sistemas producen cambios geomórficos profundos y duraderos en nuestro planeta, además de aumentar las formas de desigualdad laboral que ya tenemos.

Así me di cuenta de que tenía que pasar del análisis de un solo dispositivo, Amazon Echo, a aplicar este tipo de estudio a todo el sector. Para mí, esa fue la gran tarea, y es por eso que tardé cinco años en escribir Atlas of AI. Existe una gran necesidad de ver cuánto nos cuestan estos sistemas realmente, porque rara vez hacemos el esfuerzo de comprender del todo sus verdaderos efectos en el planeta.

Otra cosa que diría que ha sido una verdadera inspiración es el creciente campo de investigadores que se hacen estas preguntas importantes sobre las condiciones laborales, los datos y la desigualdad. Me refiero a Ruha Benjamin, Safiya Noble, Mar Hicks, Julie Cohen, Meredith Broussard, Simone Brown; y la lista continúa. Incorporar los puntos de vista que conectan el medio ambiente, los derechos laborales y la protección de datos me parece una contribución a ese cuerpo de conocimiento.

Usted viaja mucho a lo largo del libro. Casi todos los capítulos comienzan con usted mirando a su alrededor. ¿Por qué fue esto tan importante?

Fue una decisión muy consciente fundamentar este análisis de la IA en los lugares específicos, alejarnos de estos abstractos "nichos" del espacio algorítmico, donde ocurren muchos de los debates sobre el aprendizaje automático. Y espero que eso resalte el hecho de que cuando no lo hacemos, cuando solo hablamos de estos "espacios abstractos" de la objetividad algorítmica, también es una elección política y tiene ramificaciones.

Esta es realmente la razón por la que comencé a pensar en la metáfora de un atlas, en términos de unir las ubicaciones, porque los atlas son libros inusuales que se pueden abrir y ver la escala de todo un continente, o se pueden acercar para observar una cordillera o una ciudad. Así ofrecen estos cambios de perspectiva y de escala.

Hay una bonita cita de la física Ursula Franklin, que menciono en el libro, que cuenta cómo los mapas unen lo conocido y lo desconocido en estos métodos de percepción colectiva. Entonces, para mí, esto realmente supuso basarme en el conocimiento que ya tenía, pero también en las ubicaciones reales donde se está construyendo la IA de una manera literal, a partir de las rocas, arena y petróleo.

¿Qué tipo de reacciones ha provocado el libro?

Una de las cosas que me han sorprendido en las primeras reacciones es que la gente realmente cree que este tipo de perspectiva llega tarde. Hay un momento de reconocimiento de que necesitamos tener un tipo de conversación diferente a las que hemos tenido en los últimos años.

Hemos pasado demasiado tiempo dedicándonos a las soluciones tecnológicas limitadas para los sistemas de inteligencia artificial y siempre centrándolo todo en las respuestas técnicas. Ahora tenemos que lidiar con la huella medioambiental de los sistemas y con las formas muy reales de la explotación laboral que ocurren en la creación de estos sistemas.

Y también estamos empezando a ver el legado tóxico de lo que sucede cuando simplemente se extraen tantos datos de internet como se pueda, y a eso se le llama verdad fundamental. Ese tipo de formulación problemática del mundo ha producido muchos daños y, como siempre, los han sentido sobre todo las comunidades que ya estaban marginadas y que no experimentaban los beneficios de esos sistemas.

¿Qué espera que la gente comience a hacer de manera diferente?

Espero que sea mucho más difícil tener estas conversaciones sin salida donde los términos como la "ética" e "IA para el bien" han sido tan completamente desnaturalizados de cualquier significado real. Espero que se corra la cortina y que realmente veamos quién maneja las palancas de estos sistemas. Eso significa dejar de centrarse solo en cosas como los principios éticos para hablar sobre poder.

¿Cómo nos podemos alejar de esta formulación ética?

Una verdadera trampa en el sector tecnológico durante la última década fue que la teoría del cambio siempre se había centrado en la ingeniería. Siempre ha sido: "Si hay un problema, hay una solución técnica para él". Y solo recientemente hemos empezado a ver que se amplía a: "Oh, bueno, si hay un problema, entonces la regulación puede solucionarlo. Los formuladores de políticas tienen un papel ahí".

Pero creo que debemos ampliarlo aún más. También debemos decir: ¿Dónde están los grupos de la sociedad civil? ¿Dónde están los activistas? ¿Dónde están los que abordan los temas de la justicia medioambiental, derechos laborales, protección de datos? ¿Cómo los incluimos en estos debates? ¿Cómo incluimos a las comunidades afectadas?

En otras palabras, ¿cómo podemos convertir esto en una conversación democrática mucho más profunda sobre cómo estos sistemas están influyendo en las vidas de miles de millones de personas de formas principalmente irresponsables, fuera de la regulación y la supervisión democrática?

En ese sentido, este libro trata de descentrar la tecnología y empezar a formular las preguntas más importantes sobre: ¿En qué tipo de mundo queremos vivir?

¿En qué tipo de mundo quiere vivir? ¿Cómo es el futuro con el que sueña?

Quiero ver unirse a los grupos que han estado realizando el trabajo realmente duro de abordar las cuestiones como la justicia climática y los derechos laborales, y que se den cuenta de que estos frentes anteriormente bastante separados para el cambio social y la justicia racial realmente han tenido las mismas preocupaciones y tienen un terreno compartido sobre el cual se pueden coordinar y organizar.

Porque queda muy poco tiempo. Nuestro planeta ya está sometido a una gran presión. Estamos ante una profunda concentración de poder en muy pocas manos. Realmente habría que volver a los primeros días del sector ferrocarril para ver otra industria tan concentrada, y ahora incluso se podría decir que la tecnología lo ha superado.

Por tanto, tenemos que lidiar con distintas maneras en las que podamos pluralizar nuestras sociedades y tener mayores formas de pedir responsabilidad democrática. Y ese es un problema de acción colectiva. No es un problema de elección individual. No es como elegir la marca de tecnología más ética. Se trata de encontrar formas de trabajar juntos en estos desafíos a escala planetaria.