La mayoría de las tecnologías que gobiernan la economía actual se basa en chips cada vez más pequeños y potentes. Pero, a pesar de algunas ingeniosas estrategias, cada vez es más difícil que sigan aumentando su velocidad. O empezamos a invertir en I+D ahora o las industrias no podrán seguir avanzando

La predicción tecnológica más importante del último medio siglo fue la que hizo Gordon Moore en 1965, cuando pronosticó que el número de componentes en un circuito integrado se duplicaría cada año hasta alcanzar los asombrosos 65.000 en 1975. Cuando aquel año se comprobó que era cierta, su creador la revisó para afirmar que los transistores en un chip se duplican cada dos años, convirtiéndose en la ley de Moore que conocemos. Desde entonces, su predicción ha sido utilizada para medir la evolución de la tecnología y, en muchos sentidos, del también progreso.

El argumento de Moore se basaba en una cuestión económica. Unos años antes, el cofundador de Fairchild Semiconductor, Robert Noyce, había inventado los circuitos integrados, con múltiples transistores y otros dispositivos electrónicos interconectados con líneas de metal de aluminio en un pequeño cuadrado de oblea de silicio. Según escribió en 1965, Moore, que entonces era el director de I+D de la empresa, se dio cuenta de que, con estos nuevos circuitos integrados, "el coste por cada componente es casi inversamente proporcional al número de componentes". Era un cálculo interesante: en teoría, cuantos más transistores se añadían, más barato sería cada uno. Moore también descubrió que había mucho espacio para avances en ingeniería capaces de aumentar el número de transistores que se podían integrar en un chip de manera asequible y fiable.

Pronto, estos chips más baratos y potentes se convertirían en lo que a los economistas les gusta denominar como tecnología de propósito general (TPG), es decir, una tecnología tan fundamental que genera todo tipo de innovaciones y avances en muchas industrias. Hace unos años, los principales economistas reconocieron que la tecnología de la información de circuitos integrados había estado involucrada en un tercio del crecimiento de la productividad de EE. UU. desde 1974. Casi todas las tecnologías que nos interesan, desde teléfonos inteligentes hasta ordenadores portátiles baratos y GPS, son un reflejo directo de la predicción de Moore. También ha impulsado los avances actuales en inteligencia artificial (IA) y medicina genética, al dar a las técnicas de aprendizaje automático la capacidad de analizar grandes cantidades de datos para encontrar las respuestas.

Pero, ¿cómo una predicción tan simple, basada en la extrapolación de un gráfico del número de transistores al año, que en ese momento tenía solo unos pocos puntos de datos, definió medio siglo de progreso? En parte, al menos, porque la industria de semiconductores lo decidió así.

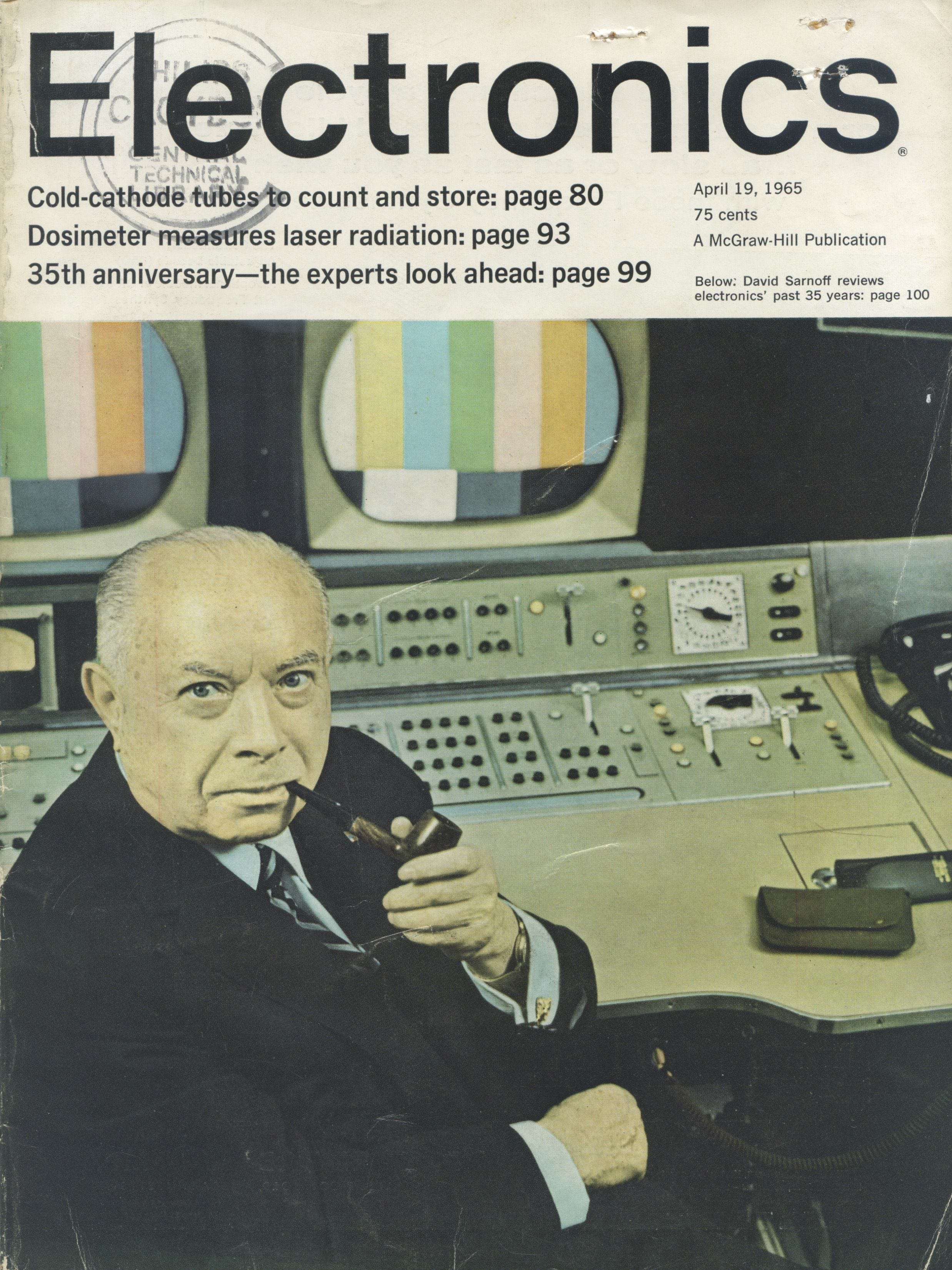

Foto: La revista electrónica de abril de 1965 en la que apareció el artículo de Moore. Créditos: Wikimedia

Moore escribió que "introducir más componentes en circuitos integrados", que era el título de su artículo de 1965, "haría maravillas en forma de ordenadores domésticos (o al menos terminales con conexión a un ordenador central), controles automáticos para coches y equipos personales portátiles de comunicaciones". En otras palabras, su hoja de ruta que consistía en colocar cuantos más transistores en chips nos llevaría a la tierra prometida.

Durante las siguientes décadas, esa industria en auge, el Gobierno de EE. UU. y ejércitos de investigadores públicos y privados se dedicaron a invertir tiempo y dinero para defender la ley de Moore, creando una profecía autocumplida que mantenía el progreso por buen camino con una precisión asombrosa. Aunque el ritmo del progreso ha disminuido en los últimos años, los chips más avanzados de la actualidad tienen casi 50.000 millones de transistores.

Desde 2001, MIT Technology Review elige las 10 tecnologías más importantes de cada año. Se trata de una lista de tecnologías que, casi sin excepción, solo han sido posibles gracias a los avances computacionales descritos por la ley de Moore. Su conexión con algunos de los avances en la lista de este año resulta obvia: dispositivos de consumo, incluidos relojes y teléfonos, con IA incorporada; la atribución del cambio climático gracias a la mejora del modelado informático y los datos recopilados de los sistemas mundiales del monitoreo atmosférico; y satélites baratos y de pequeño tamaño. Otros avances en la lista, incluida la supremacía cuántica, las moléculas descubiertas mediante IA e incluso los tratamientos antienvejecimiento y los medicamentos hiperpersonalizados, se deben en gran medida al poder computacional disponible para los investigadores.

Pero, ¿qué pasará cuando la ley de Moore inevitablemente llegue a su final? ¿Y si, como sospechan algunos, ya ha muerto y ahora operamos con los humos del mayor motor tecnológico de nuestros tiempos? (ver La ley de Moore llegará a su fin en 2021, según admiten los fabricantes de chips).

D. E. P.

"Se acabó. Este año ha quedado muy claro", afirma el científico informático del MIT (EE. UU.) y pionero de la computación paralela, Charles Leiserson, en cuya disciplina se realizan múltiples cálculos simultáneamente. La nueva planta de fabricación de Intel, diseñada para construir chips con un tamaño mínimo de 10 nanómetros, sufrió grandes retrasos y no empezó a entregar sus chips hasta 2019, cinco años después de lanzar la generación anterior, chips de 14 nanómetros. Según Leiserson, la ley de Moore siempre estaba involucrada en la tasa del progreso, y "ya no estamos en esa tasa". En los últimos años, numerosos y prominentes informáticos también han declarado muerta la ley de Moore. A principios de 2019, el CEO del gran fabricante de chips Nvidia también coincidió con ellos.

La verdad es que ha sido más un declive gradual que una muerte súbita. A lo largo de las décadas, algunos, a veces hasta el propio Moore, expresaron su temor por la posibilidad de notar que el final estaba cerca, ya que fabricar transistores cada vez más pequeños era cada vez más difícil. En 1999, un investigador de Intel mostró su preocupación por el objetivo de la industria de crear transistores de menos de 100 nanómetros para 2005 teniendo en cuenta los problemas físicos fundamentales con "soluciones no conocidas", como los efectos cuánticos de los electrones en sitios en los que no deberían estar.

Durante años, la industria de los chips logró evitar estos obstáculos físicos. Se introdujeron nuevos diseños de transistores para agrupar mejor los electrones. Se inventaron nuevos métodos de litografía que utilizan radiación ultravioleta extrema cuando las longitudes de onda de la luz visible eran demasiado gruesas para tallar con precisión las características de silicio de solo unas pocas decenas de nanómetros. Pero el progreso se volvió cada vez más caro. Los economistas de la Universidad de Stanford (EE. UU.) y del MIT estiman que el esfuerzo de investigación para mantener el ritmo de la ley de Moore ha aumentado en un factor de 18 desde 1971.

Del mismo modo, las fábricas de los chips más avanzados se están volviendo demasiado caras. El coste de una fábrica de este tipo aumenta en alrededor del 13 % anual, y se espera que roce los 15.000 millones de euros para 2022. No es casualidad que el número de compañías con planes de fabricar la próxima generación de chips se haya reducido a solo tres, desde las ocho que había en 2010 y las 25 de 2002.

Encontrar los sucesores de los actuales chips de silicio requerirá años de investigación. Si le preocupa qué reemplazará la ley de Moore, el momento de entrar en pánico es ahora

No obstante, Intel, uno de esos tres fabricantes de chips, no espera que la ley de Moore se acabe a un corto plazo. El director de Ingeniería de Silicio de Intel desde 2018, Jim Keller, intenta mantenerla con vida. Dirige un equipo de unos 8.000 ingenieros de hardware y diseñadores de chips en Intel. Cuando se unió a la compañía muchos anticipaban el final de la ley de Moore. Si tenían razón, recuerda haber pensado, "sería un desastre" y tal vez había hecho "una elección profesional muy equivocada".

Pero Keller encontró varias oportunidades técnicas para seguir generando avances. Señala que probablemente hay más de 100 variables que influyen en el mantenimiento de la ley de Moore, cada una con sus propios límites y beneficios. Eso significa que hay muchas maneras de seguir duplicando la cantidad de componentes en un chip: mediante las innovaciones como la arquitectura 3D y nuevos diseños de transistores.

Keller parece optimista. Afirma que lleva oyendo hablar del final de la ley de Moore desde que empezó su carrera. Al cabo de un tiempo, "decidió dejar de preocuparse por eso". Asegura que Intel tiene un buen camino para los próximos 10 años, y que hará los cálculos encantado: 65.000 millones (número de transistores) por 32 (si la densidad del chip se duplica cada dos años) equivale a dos billones de transistores. "Se trata de una mejora del rendimiento de 30 veces", explica, y añade que, si los desarrolladores de software son buenos, en 10 años podríamos tener chips 100 veces más rápidos que los actuales.

Aún así, incluso si Intel y otros fabricantes de chips logran lanzar algunas generaciones más de microchips aún más avanzados, está claro que los días en los que se podía contar con los chips más rápidos y baratos cada dos años han terminado. Pero también es cierto que eso no significa el final del progreso computacional.

El momento del pánico es ahora

Neil Thompson es economista, pero su oficina está en el extenso centro de inteligencia artificial e informática del MIT. Así que vive rodeado de robots y de científicos informáticos, incluido su colaborador Leiserson. En un nuevo artículo, muestra un amplio margen para mejorar el rendimiento computacional a través de un mejor software, algoritmos y una arquitectura de chip especializada.

Una de las estrategias consiste en reducir el llamado software inflado para extraer el máximo provecho de los chips existentes. Cuando los chips cada vez más rápidos y potentes eran una realidad, los programadores no tenían que preocuparse demasiado por escribir códigos más eficientes. Tampoco solían aprovecharon al máximo los cambios en la arquitectura del hardware, como los múltiples núcleos o procesadores, que existen en los chips que se usan hoy en día.

Thompson y sus colegas demostraron que podían alcanzar un cálculo computacionalmente intensivo que se ejecutaba unas 47 veces más rápido con solo cambiar de Python, un popular lenguaje de programación de propósito general, a C que resulta más eficiente. Esto se debe a que, aunque el lenguaje C requiere más trabajo por parte del programador, también reduce en gran medida el número requerido de operaciones, lo que permite que un programa se ejecute mucho más rápido. Adaptar aún más el código para aprovechar al máximo un chip con 18 núcleos de procesamiento aceleró aún más las cosas. En solo 0,41 segundos, los investigadores lograron el mismo resultado con conseguían en siete horas con el código Python.

Eso parece buena noticia para el progreso continuo, pero a Thompson le preocupa que eso también señale el declive de los ordenadores como tecnología de propósito general. En lugar de "levantar todos los barcos", como ha hecho la ley de Moore al ofrecer chips cada vez más rápidos, baratos y disponibles universalmente, los avances en software y arquitectura especializada ahora empezarán a centrarse selectivamente en problemas específicos y en oportunidades comerciales, lo que supondrá una ventaja para aquellos con suficiente dinero y recursos.

De hecho, el cambio a chips diseñados para aplicaciones específicas, especialmente para IA, está muy avanzado (ver IA y nuevos materiales para revivir los chips y la ley de Moore). El aprendizaje profundo y otras técnicas de IA dependen cada vez más de las unidades de procesamiento de gráficos (GPU) adaptadas de los videojuegos, capaces de manejar operaciones paralelas, mientras que las compañías como Google, Microsoft y Baidu están diseñando sus propios chips de IA para sus propias necesidades particulares. La inteligencia artificial, en concreto el aprendizaje profundo, necesita mucha potencia informática, y los chips especializados pueden acelerar enormemente su rendimiento, explica Thompson.

Pero, por otro lado, los chips especializados son menos versátiles que las unidades de procesamiento central (CPU) tradicionales. A Thompson le preocupa que los chips para la computación general se estén estancando y desacelerando "el ritmo general de la mejora informática", como escribe en su último estudio, El declive de los ordenadores como tecnología de propósito general.

La profesora de ingeniería y políticas públicas en la Universidad Carnegie Mellon (CMU, EE. UU.) Erica Fuchs, cree que en algún momento los desarrolladores de IA y otras aplicaciones tendrán que dejar de confiar en las reducciones de coste y los aumentos de rendimiento que ofrece la ley de Moore. "Tal vez en 10 o 30 años, nadie sabe realmente cuándo, se necesitará un dispositivo con esa potencia de cálculo adicional", opina.

El problema, según Fuchs, consiste en que todavía no sabemos quiénes serán los sucesores de los chips de propósito general y harán falta años de investigación básica y desarrollo para crearlos. Si le preocupa qué reemplazará la ley de Moore, sugiere, "el momento de entrar en pánico es ahora". Hay "personas realmente inteligentes en IA que no son conscientes de las limitaciones de hardware a las que se enfrentan los avances a largo plazo en la informática". Además, explica que como los chips de aplicación específica están demostrando ser muy rentables, hay pocos incentivos para invertir en nuevos dispositivos lógicos y formas de llevar a cabo la computación.

Se busca: un plan Marshall para los chips

En 2018, Fuchs y sus colegas de CMU Hassan Khan y David Hounshell escribieron un artículo sobre la historia de la ley de Moore en que identificaban los cambios responsables de la actual falta de colaboración entre la industria y el gobierno que tanto fomentó progreso en las décadas anteriores. Afirman que "la fragmentación de las trayectorias tecnológicas y la rentabilidad privada a corto plazo de muchas de estas nuevas fragmentadoras" significa que debemos impulsar y mucho la inversión pública para encontrar las próximas grandes tecnologías informáticas.

Si los economistas tienen razón, y gran parte del crecimiento en la década de 1990 y principios de la década de 2000 fue el resultado de los microchips, y si, como algunos sugieren, el lento crecimiento de la productividad que comenzó a mediados de la década de 2000 refleja la desaceleración en el progreso computacional, entonces, Thompson advierte: "Se deduce que hay que invertir enormes cantidades de dinero para encontrar la tecnología sucesora. No lo estamos haciendo. Y es un fracaso de política pública".

Tampoco hay garantías de que tales inversiones valgan la pena. La computación cuántica, los transistores de nanotubos de carbono, incluso la espintrónica, son posibilidades atractivas, pero ninguna se alza como clara sustituta de lo que Gordon Moore vio por primera vez en un simple circuito integrado. Por eso, ahora necesitamos inversiones en investigación para encontrarla. Porque lo que sí es casi seguro es que siempre vamos a querer más potencia informática.