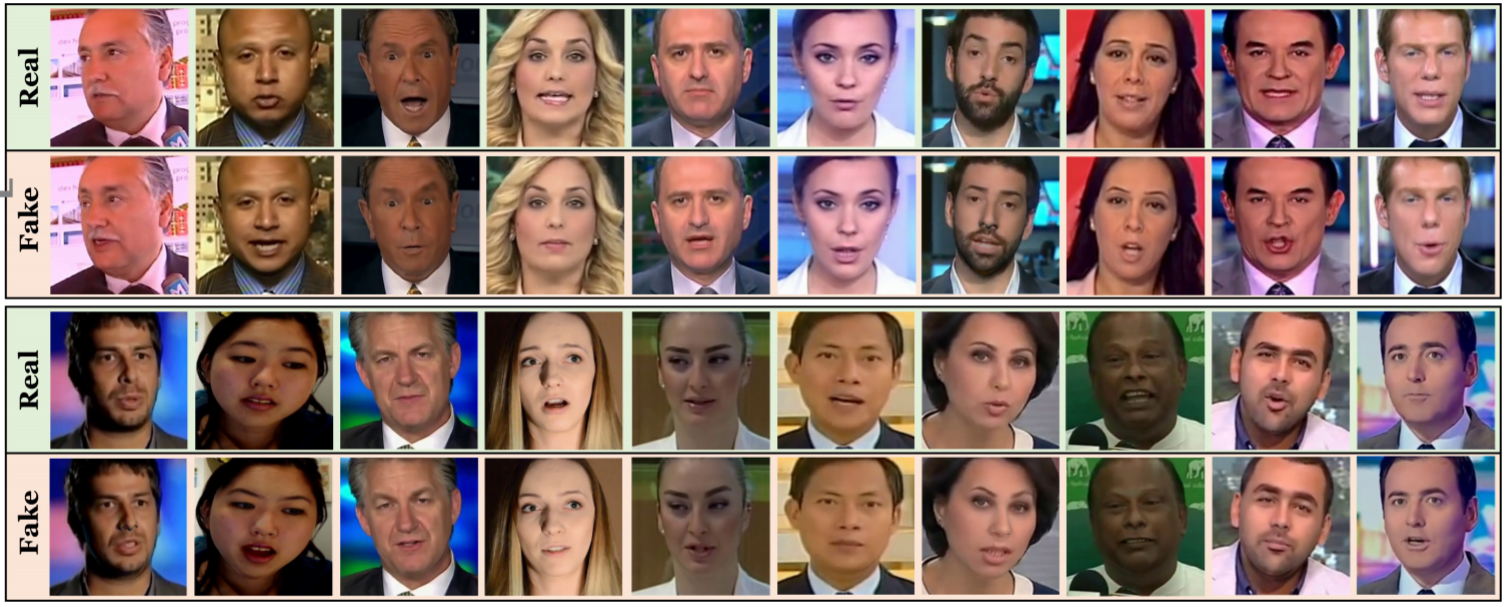

El sistema podría poner freno al fenómeno de las 'fake news', pero también es capaz de hacer que las imágenes falsificadas parezcan aún más realistas. De cada pareja de imágenes, ¿sabría usted decir cuál es la real y cuál la falsa? Le ofrecemos la respuesta al final del artículo

Hace muy poco, la adquirido la capacidad de aislar la cara o la expresión de una persona e incrustarla sobre el vídeo de otra persona. Esta habilidad ha provocado que en algunos sitios web como Reddit y 4Chahayan hayan empezado a aparecer vídeos pornográficos llamados "deepfakes" o falsificaciones automáticas, que muestran caras de personas famosas superpuestas en los cuerpos de los actores reales.

Este fenómeno tiene implicaciones importantes. Esta técnica puede hundir la reputación de las víctimas de este tipo de falsificación, es un reto para los sistemas de identificación biométrica y amenaza con socavar la confianza del público en cualquier tipo de vídeo que vea (ver La tecnología para manipular contenidos amenaza con devolvernos a las noticias del siglo XX)

Por lo tanto, necesitamos urgentemente una forma rápida y precisa de detectar estos vídeos (ver Sus próximos dispositivos le harán más vulnerable a las noticias falsas).

Eso es justo lo que ha creado el investigador de la Universidad Técnica de Munich (Alemania) Andreas Rossler y unos compañeros. El equipo ha desarrollado un sistema de aprendizaje profundo capaz de detectar automáticamente vídeos en los que las caras se han modificado. Esta nueva técnica podría ayudar a identificar los vídeos falsificados a medida que se publican.

Pero el trabajo también tiene un final decepcionante. Aunque el proceso permite detectar vídeos de intercambio facial, también se puede utilizar para mejorar la calidad de los intercambios de caras, algo que podría dificultar su detección.

La nueva técnica se basa en un algoritmo de aprendizaje profundo que Rossler y su equipo han entrenado para detectar intercambios de rostros. Para aprender, estos algoritmos dependen de grandes conjuntos de datos etiquetados con buenos ejemplos, algo que hasta ahorae simplemente no existía.

Así que el equipo comenzó creando un gran conjunto de datos a partir de vídeos originales y las versiones manipuladas que crearon a partir de ellos. Se centraron en dos tipos de intercambio de caras que son muy fáciles de generar con un software llamado Face2Face (ver La inteligencia artificial imita y sustituye personas, pero solo en vídeo). De hecho, este software fue creado por algunos miembros del equipo.

El primer tipo de falsificación facial superpone la cara de una persona en el cuerpo de otra para que adopte sus expresiones. El segundo toma las expresiones de una cara y modifica una segunda cara para recrearlas.

El equipo hizo ambos procesos con más de 1.000 vídeos, lo que dio lugar a una base de datos de alrededor de medio millón de imágenes con caras manipuladas con el software de edición facial más moderno. Llamaron a la base de datos: FaceForensics.

El tamaño de esta base de datos supone una mejora importante. La investigación detalla: "Presentamos un novedoso conjunto de datos de vídeos manipulados que supera a cualquier otro disponible públicamente por órdenes de magnitud".

Luego, el equipo usó la base de datos para entrenar un algoritmo de aprendizaje profundo para que aprendiera a reconocer la diferencia entre los vídeos con caras manipuladas y los originales. El equipo ha bautizado a su algoritmo como XceptionNet.

Finalmente, compararon el rendimiento de su programa con el de otras técnicas de detección de falsificaciones. Y los resultados son impresionantes. Está claro que XceptionNet supera a otras técnicas en la detección de vídeos manipulados, incluso cuando se han comprimido, lo que dificulta mucho la tarea. La investigación afirma: "Establecemos una sólida base de resultados para detectar una manipulación facial con arquitecturas modernas de aprendizaje profundo".

Eso debería facilitar la detección de vídeos falsificados a medida que aparezcan en internet. Pero el equipo es consciente del juego del gato y el ratón que supone la capacidad de detectar una falsificación: en cuanto aparece una nueva técnica de detección, los malhechores se apresuran a buscar otras formas para engañarla.

Desde que Rossler y su equipo desarrollaron XceptionNet van con ventaja. Después de detectar las señales reveladoras de que un vídeo ha sido manipulado, usan esta información para mejorar aún más la falsificación, lo que la hace más difícil de identificar.

Resulta que este proceso mejora la calidad visual de la falsificación, pero no tiene mucho efecto en la capacidad de XceptionNet para detectarlo. El trabajo detalla: "Nuestro refinador mejora principalmente la calidad visual, pero solo entorpece ligeramente la detección de falsificación para el método de aprendizaje profundo entrenado exactamente en los datos de salida falsificados".

Es un trabajo interesante ya que ofrece una forma completamente nueva de mejorar el proceso de manipulación de imágenes. La investigación concluye: "Creemos que esta interacción entre la manipulación y la detección es una vía extremadamente emocionante en la que seguir trabajando".

Ref: arxiv.org/abs/1803.09179: FaceForensics: A Large-scale Video Data Set for Forgery Detection in Human Faces

Respuesta: La imagen real de cada pareja es la que está encima. La de abajo es una manipulación