Esta semana hemos publicado Power Hungry, una serie de artículos sobre la IA y la energía. En el centro de esta serie se encuentra el análisis más completo hasta la fecha sobre la creciente demanda energética de la IA, si me permiten decirlo.

Este artículo, repleto de datos, es el resultado de más de seis meses de trabajo de investigación por parte de mi colega James O’Donnell y yo (y de muchos otros miembros de nuestro equipo). Durante ese tiempo, con la ayuda de investigadores de primer nivel, cuantificamos el impacto energético y las emisiones de consultas individuales a modelos de IA y calculamos el resultado total, tanto en la actualidad como para los próximos años.

Hay muchos datos que analizar, y espero que se tomen el tiempo necesario para explorar todo el artículo. Pero, mientras tanto, aquí tienen tres de las conclusiones más importantes que he extraído de mi trabajo en este proyecto.

- La demanda energética de la IA no es en absoluto constante.

Si han oído estimaciones sobre el impacto de la IA, probablemente se trate de una cifra única asociada a una consulta, seguramente a ChatGPT de OpenAI. Una estimación popular es que escribir un correo electrónico con ChatGPT consume 500 mililitros (aproximadamente una botella) de agua. Pero cuando empezamos a recopilar datos, me sorprendió descubrir hasta qué punto los detalles de una consulta pueden afectar a su demanda energética. No hay dos consultas iguales, por varias razones, entre ellas su complejidad y las particularidades del modelo al que se consulta.

Una advertencia importante es que no sabemos mucho sobre los modelos de «código cerrado», ya que las empresas no revelan los detalles de su funcionamiento. (ChatGPT de OpenAI y Gemini de Google son ejemplos de ello). En su lugar, hemos trabajado con investigadores que han medido la energía que se necesita para ejecutar modelos de IA de código abierto, cuyo código fuente es público.

Pero utilizando modelos de código abierto, es posible medir directamente la energía utilizada para responder a una consulta, en lugar de limitarse a hacer conjeturas. Hemos trabajado con investigadores que han generado texto, imágenes y vídeo y han medido la energía necesaria para que los chips en los que se basan los modelos realicen la tarea.

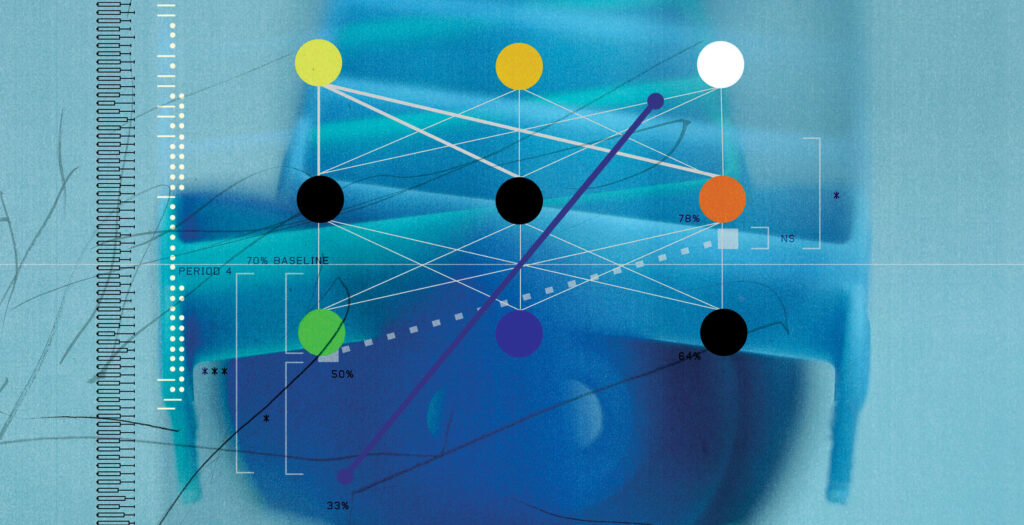

Incluso solo dentro de las respuestas de texto, había una gama bastante amplia de necesidades energéticas. Por ejemplo, un itinerario de viaje complicado consumía casi 10 veces más energía que una simple solicitud de unos cuantos chistes. Una diferencia aún mayor proviene del tamaño del modelo utilizado. Los modelos más grandes con más parámetros consumían hasta 70 veces más energía que los más pequeños para las mismas indicaciones.

Como es de imaginar, también hay una gran diferencia entre el texto, las imágenes y los vídeos. Los vídeos, en general, consumieron cientos de veces más energía que las respuestas de texto.

- La fuente de energía de la red eléctrica influirá en gran medida en el impacto climático del consumo energético de la IA.

Como reportero climático residente en este proyecto, me entusiasmó tomar el impacto energético previsto y traducirlo en una carga de emisiones prevista.

Alimentar un centro de datos con un reactor nuclear o con un montón de paneles solares y baterías no afectará a nuestro planeta de la misma manera que quemar montañas de carbón. Para cuantificar esta idea, utilizamos una cifra llamada intensidad de carbono, que mide la contaminación de una unidad de electricidad en una red determinada.

Descubrimos que una consulta idéntica, con la misma demanda energética, tendrá un impacto climático muy diferente dependiendo de la fuente de energía del centro de datos, y eso depende de la ubicación y la hora del día. Por ejemplo, según cálculos basados en datos medios de 2024, una consulta a un centro de datos en Virginia Occidental podría generar casi el doble de emisiones que una consulta a uno en California (EE UU).

Este punto muestra por qué es importante dónde construyen los gigantes tecnológicos sus centros de datos, cómo es la red eléctrica en las ubicaciones elegidas y cómo podría cambiar con el aumento de la demanda de la nueva infraestructura.

- Aún hay mucho que desconocemos sobre la IA y la energía.

Nuestro informe ha dado lugar a algunas de las estimaciones más específicas y completas que existen. Pero, en última instancia, seguimos sin tener ni idea de lo que suponen muchos de los modelos más grandes e influyentes en términos de energía y emisiones. Ninguna de las empresas a las que nos hemos dirigido ha estado dispuesta a facilitar cifras durante nuestro informe. Ni una sola.

Sumar nuestras estimaciones solo nos permite llegar hasta cierto punto, en parte porque la IA está cada vez más presente en todas partes. Si bien hoy en día, por lo general, hay que acudir a un sitio web específico y escribir las preguntas, en el futuro la IA podría integrarse en el tejido de nuestras interacciones con la tecnología. (Véase el nuevo artículo de mi colega Will Douglas Heaven sobre la presentación de Google I/O: «Al incorporar la IA en todo, Google quiere hacerla invisible»).

La IA podría ser una de las principales fuerzas que den forma a nuestra sociedad, nuestro trabajo y nuestra red eléctrica. Saber más sobre sus consecuencias podría ser crucial para planificar nuestro futuro.

Para profundizar en nuestro reportaje, lee el artículo principal. Y si desea obtener más detalles sobre cómo hemos obtenido nuestras cifras, puede consultar este artículo sobre los entresijos.

Este paquete también incluye otros artículos interesantes relacionados con el tema, como uno de James Temple sobre el auge de los centros de datos en el desierto de Nevada (EE UU) , otro de David Rotman sobre cómo el auge de la IA podría afianzar el gas natural, y otro de Will Douglas Heaven sobre algunas innovaciones técnicas que podrían ayudar a que la IA sea más eficiente. Ah, y también tengo un artículo sobre por qué la energía nuclear no es la respuesta fácil que algunos creen.

Encuéntralos, junto con el resto de artículos del paquete, aquí.