A veces, la IA parece un tema de nicho sobre el que escribir, pero luego llegan las fiestas y escucho a familiares de todas las edades hablar de casos de psicosis inducida por chatbots, culpar a los centros de datos del aumento de los precios de la electricidad y preguntar si los niños deberían tener acceso irrestricto a la IA. En otras palabras, está en todas partes. Y la gente está alarmada.

Inevitablemente, estas conversaciones toman un giro: la IA ya está teniendo todos estos efectos en cadena, pero si la tecnología mejora, ¿qué sucede después? Normalmente, es en ese momento cuando me miran, esperando un pronóstico de fatalidad o esperanza.

Probablemente los decepciono, aunque solo sea porque las predicciones sobre IA se están volviendo cada vez más difíciles de hacer.

A pesar de ello, debo decir que MIT Technology Review tiene un historial bastante excelente a la hora de entender hacia dónde se dirige la IA. En enero publicamos una lista aguda de predicciones sobre lo que viene en 2026 (donde se pueden leer mis reflexiones sobre las batallas legales en torno a la IA), y todas las predicciones de la lista del año pasado se hicieron realidad. Pero cada temporada navideña se hace más difícil anticipar el impacto que tendrá la IA. En gran parte, esto se debe a tres grandes preguntas sin respuesta.

Para empezar, no sabemos si los modelos de lenguaje de gran tamaño seguirán volviéndose incrementalmente más inteligentes en el futuro cercano. Dado que esta tecnología en particular es la que sostiene prácticamente todo el entusiasmo y la ansiedad actuales en torno a la IA, impulsando todo, desde los compañeros de IA hasta los agentes de atención al cliente, su ralentización sería un asunto importante. Tan importante que, de hecho, dedicamos toda una serie de artículos en diciembre a cómo podría ser una nueva era poshype de la IA.

En segundo lugar, la IA es enormemente impopular entre el público general. He aquí solo un ejemplo: hace casi un año, Sam Altman, de OpenAI, apareció junto al presidente Trump para anunciar con entusiasmo un proyecto de 500.000 millones de dólares (unos 465.570 millones de euros) para construir centros de datos por todo Estados Unidos con el fin de entrenar modelos de IA cada vez más grandes. Ninguno de los dos pareció prever, o importarles, que muchos estadounidenses se opondrían firmemente a que se construyeran esos centros cerca de sus comunidades. Un año después, las grandes tecnológicas libran una dura batalla para ganarse la opinión pública y seguir construyendo. ¿Lo lograrán?

La respuesta de los legisladores ante esta frustración es terriblemente confusa. Trump ha complacido a los directores ejecutivos de Silicon Valley al intentar convertir la regulación de la IA en una cuestión federal en lugar de estatal, y ahora las empresas tecnológicas esperan plasmar esto en la ley. Pero el grupo de personas que quiere proteger a los niños de los chatbots abarca desde legisladores progresistas en California hasta la Comisión Federal de Comercio, cada vez más alineada con Trump, cada uno con motivos y enfoques distintos. ¿Podrán dejar a un lado sus diferencias y contener a las empresas de IA?

Si la conversación sombría de la cena navideña llega tan lejos, alguien dirá: Oye, ¿no se está usando la IA para cosas objetivamente buenas? ¿Para mejorar la salud, acelerar descubrimientos científicos o comprender mejor el cambio climático?

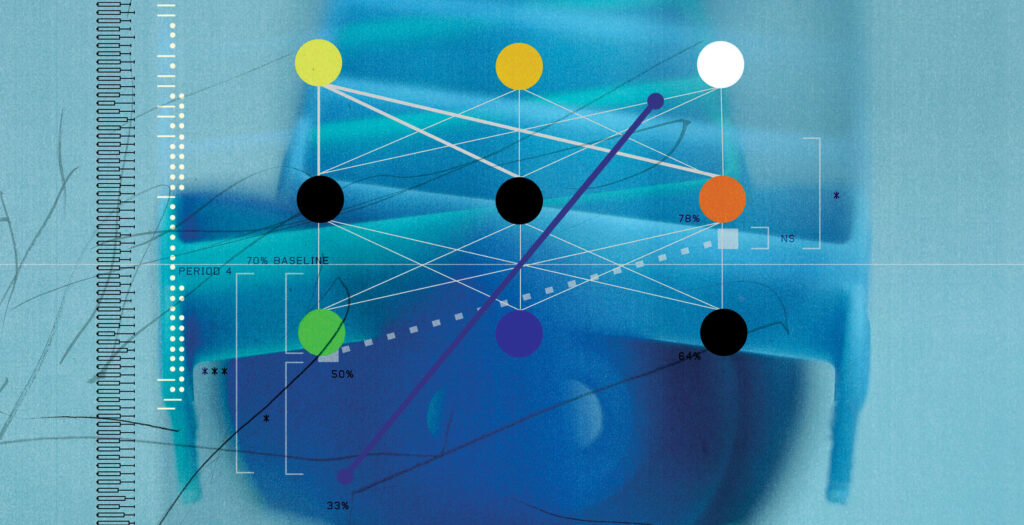

Bueno… más o menos. El machine learning, una forma más antigua de IA, se ha utilizado durante mucho tiempo en todo tipo de investigación científica. Una de sus ramas, llamada deep learning, forma parte de AlphaFold, una herramienta de predicción de proteínas galardonada con el Nobel que ha transformado la biología. Los modelos de reconocimiento de imágenes están mejorando en la identificación de células cancerosas.

Pero el desempeño de los chatbots basados en modelos de lenguaje más recientes es más modesto. Tecnologías como ChatGPT son bastante buenas para analizar grandes cantidades de investigación y resumir lo que ya se ha descubierto. Pero algunos informes muy llamativos sobre supuestos “hallazgos” de estos modelos, como resolver un problema matemático previamente sin solución, eran falsos. Estos sistemas pueden ayudar a los médicos con diagnósticos, pero también pueden alentar a las personas a autodiagnosticarse sin consultar a un profesional, a veces con resultados desastrosos.

A estas alturas, el año que viene probablemente tengamos mejores respuestas para las preguntas de mi familia, y también muchas preguntas completamente nuevas. Mientras tanto, asegúrate de leer nuestro artículo completo que pronostica lo que ocurrirá este año, con predicciones de todo el equipo de IA.