Este texto forma parte del paquete El fin del ‘hype’ de la IA de MIT Technology Review, una serie que reajusta las expectativas sobre qué es la IA, qué permite y hacia dónde vamos.

Es un momento extraño para ser un agorero de la IA.

Esta comunidad pequeña pero influyente de investigadores, científicos y expertos en políticas públicas sostiene, muy resumidamente, que la IA puede llegar a ser tan buena que termine siendo muy, muy mala para la humanidad. Muchos prefieren definirse como defensores de la seguridad en IA antes que como agoreros literales, pero advierten que la tecnología plantea un ‘riesgo existencial‘ para nuestra especie. Argumentan que, sin una regulación más estricta, el sector podría avanzar hacia sistemas que no sabrá controlar. En su mayoría esperan que esos sistemas sigan a la creación de la inteligencia artificial general (IAG) un concepto escurridizo que suele entenderse como tecnología capaz de hacer lo que hacen los humanos, y mejor.

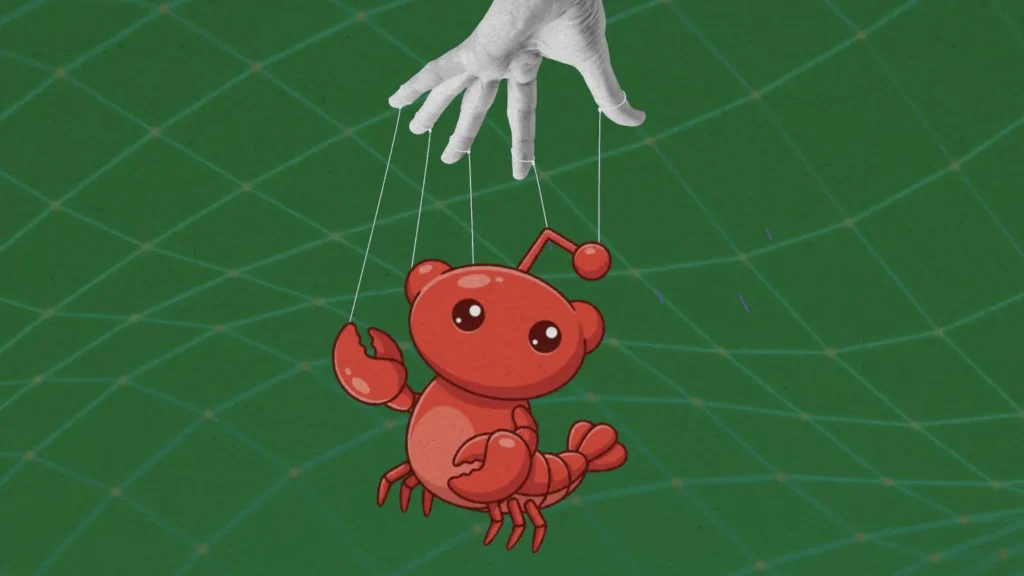

Aunque esta visión dista de ser mayoritaria en el sector, los llamados agoreros de la IA han cosechado éxitos notables en los últimos años: han contribuido a dar forma a políticas de la Administración Biden en EE UU, han impulsado llamamientos prominentes a establecer «líneas rojas» internacionales para reducir riesgos y han ganado un altavoz cada vez más grande (y más influyente) a medida que algunos de sus referentes reciben los premios más prestigiosos de la ciencia.

Pero varios acontecimientos de los últimos seis meses les han hecho retroceder. La conversación pública sobre una posible burbuja de la IA lo ha dominado todo, mientras las grandes tecnológicas siguen invirtiendo en centros de datos dignos de varios «Proyectos Manhattan» sin certeza de que la demanda futura vaya a justificar ese despliegue.

Además, en agosto llegó el lanzamiento del último modelo de OpenAI, GPT‑5, que resultó ser una decepción. Tal vez era inevitable: fue el lanzamiento de IA más sobredimensionado de la historia. El CEO de OpenAI, Sam Altman, se había jactado de que GPT‑5 se sentía «como un experto a nivel de doctorado» en cualquier materia y le dijo al podcaster Theo Von que el modelo era tan bueno que le había hecho sentirse «inútil frente a la IA».

Muchos esperaban que GPT‑5 supusiera un gran paso hacia la IAG, pero los avances del modelo quedaron eclipsados por una cadena de fallos técnicos y por la desconcertante (y rápidamente rectificada) decisión de la empresa de cortar sin aviso el acceso a todos los modelos anteriores. Aunque el nuevo sistema alcanzó puntuaciones de referencia de máximo nivel, mucha gente percibió, quizá con dureza, que en el uso diario GPT‑5 era un paso atrás.

Todo ello parece golpear algunos de los pilares del argumento catastrofista. Al mismo tiempo, un campo rival, el de los aceleracionistas de la IA, que temen que la tecnología no avance lo bastante deprisa y que el sector esté siempre amenazado por la sobrerregulación, ha visto la oportunidad de reorientar cómo abordamos la seguridad de la IA (o, mejor dicho, sobre su cómo no lo hacemos).

Eso se nota, sobre todo, entre los perfiles de la industria que se han instalado en Washington: «Las narrativas agoreras eran erróneas», proclamó David Sacks, veterano capitalista de riesgo convertido en responsable de IA de la Administración Trump. «La noción de una IAG inminente ha sido una distracción, perjudicial y ahora está, en la práctica, desmentida», secundó el asesor principal de la Casa Blanca para IA y el inversor tecnológico Sriram Krishnan. Ni Sacks ni Krishnan respondieron a solicitudes de comentarios.

(Existe, por supuesto, otro campo en el debate sobre seguridad: el grupo de investigadores y activistas que suele asociarse con la etiqueta de ética de la IA. Aunque también abogan por regular, suelen creer que se ha exagerado la velocidad del progreso y con frecuencia han despachado la IAG como ciencia ficción o como un timo que nos distrae de las amenazas inmediatas de la tecnología. Una hipotética derrota del ala catastrofista no les abriría, en todo caso, el mismo espacio que ahora vislumbran los aceleracionistas).

¿Dónde deja esto a los agoreros? Como parte de El fin del ‘hype’ de la IA, decidimos preguntar a algunas de las voces más destacadas del movimiento si los tropiezos recientes y el cambio en la opinión pública habían modificado sus posiciones. ¿Están molestos porque los responsables políticos ya no parecen atender sus advertencias? ¿Están ajustando en silencio sus plazos para el apocalipsis? habían modificado sus posiciones. ¿Están molestos porque los responsables políticos ya no parecen atender sus advertencias? ¿Están ajustando en silencio sus plazos para el apocalipsis?

Las entrevistas con 20 especialistas en seguridad y gobernanza de la IA (entre ellos el Nobel Geoffrey Hinton, el premio Turing Yoshua Bengio y figuras conocidas como la exconsejera de OpenAI Helen Toner) muestran que, lejos de sentirse desautorizados o perdidos, siguen comprometidos con su causa y creen que la IAG no solo es posible, sino potencialmente peligrosísima.

A la vez, lidian con lo que parece una contradicción. Por un lado, les alivia que los últimos acontecimientos sugieran que la IAG está más lejos de lo que pensaban («Gracias a Dios, tenemos más tiempo», dice el investigador Jeffrey Ladish). Por otro, les frustra que algunos actores con poder impulsen políticas en dirección contraria a la que defienden (Daniel Kokotajlo, autor principal de una previsión de cautela titulada AI 2027, afirma: «La política de IA parece estar empeorando» y califica los mensajes de Sacks y Krishnan de «delirantes y/o deshonestos»).

En líneas generales, estos expertos ven la discusión sobre una burbuja de la IA como un simple bache y el desencanto con GPT‑5 como ruido más que señal. Siguen defendiendo una regulación más robusta y temen que los avances normativos (la aplicación del Reglamento de IA de la UE, la aprobación de la primera gran ley de seguridad de la IA en Estados Unidos, la SB 53 de California, y el renovado interés de algunos congresistas por el riesgo asociado a la IAG) queden en entredicho si Washington sobrerreacciona ante lo que, a ojos de los catastrofistas, no son más que fallos a corto plazo para estar a la altura de las expectativas.

Algunos también se mostraron dispuestos a corregir lo que consideran los malentendidos más persistentes sobre el mundo catastrofista. Aunque sus críticos suelen burlarse de ellos por predecir que la IAG está a la vuelta de la esquina, aseguran que eso nunca ha sido esencial en su argumento: “No se trata de inminencia”, afirma Stuart Russell, profesor en Berkeley y autor de Human Compatible: Artificial Intelligence and the Problem of Control. La mayoría de las personas con las que hablé dicen que sus plazos para la llegada de sistemas peligrosos se han alargado ligeramente en el último año, un cambio importante si se tiene en cuenta lo rápido que pueden variar los escenarios técnicos y regulatorios.

De hecho, muchos subrayan la relevancia de ajustar esos plazos. Y aunque ahora sean un poco más largos, Helen Toner me comenta que una de las grandes historias de la era ChatGPT es la compresión drástica de estas estimaciones en todo el mundo de la IA. Durante mucho tiempo, no se esperaba la IAG hasta dentro de varias décadas. Hoy, en su mayoría, se predice que llegará en algún momento entre los próximos años y los próximos 20 años. Así que, incluso si tenemos algo más de tiempo, ella (y muchos de sus colegas) siguen viendo la seguridad en IA como algo increíblemente urgente. “Si la IAG fuera posible en cualquier momento dentro de los próximos 30 años, sería un asunto enorme. Deberíamos tener a mucha gente trabajando en esto”, asegura.

Pese al momento delicado que atraviesan los agoreros, su conclusión sigue siendo la misma: no importa cuándo llegue la IAG (y, de nuevo, creen que es muy probable que llegue), el mundo está lejos de estar preparado.

Quizá estés de acuerdo. O quizá pienses que ese futuro está lejos de ser seguro. O que es pura ciencia ficción. Incluso puedes creer que la IAG es una gran teoría conspirativa. No estarías solo: el tema divide. Pero, pienses lo que pienses sobre la mentalidad catastrofista, no se puede obviar que ciertas personas en este ámbito tienen mucha influencia. Aquí están algunas de las más destacadas, reflexionando sobre este momento con sus propias palabras.

El Nobel que no tiene claro qué vendrá

Geoffrey Hinton, ganador del premio Turing y del Nobel de Física por sus avances en deep learning

El mayor cambio en los últimos años es que hay personas difíciles de ignorar que dicen que esto es peligroso. Por ejemplo, Eric Schmidt, ex CEO de Google, reconoce que esto puede ser realmente peligroso. Él y yo estuvimos en China recientemente hablando con alguien del Politburó, el secretario del partido en Shanghái, para asegurarnos de que lo entendía, y lo entendió. Creo que, en China, el liderazgo comprende la IA y sus riesgos mucho mejor porque muchos son ingenieros.

Yo me he centrado en la amenaza a largo plazo: cuando las IA sean más inteligentes que nosotros, ¿podemos esperar que los humanos sigan teniendo el control o incluso siendo relevantes? Pero no creo que nada sea inevitable. Hay una enorme incertidumbre en todo. Nunca hemos estado aquí antes. Cualquiera que esté seguro de saber lo que va a pasar me parece ridículo. Puede que resulte que quienes dicen que la IA está sobrevalorada tengan razón. Puede que no podamos avanzar mucho más allá de los chatbots actuales, que choquemos contra un muro por falta de datos. No lo creo, me parece improbable, pero es posible.

Tampoco creo a gente como Eliezer Yudkowsky, que dice que, si alguien construye esto, todos moriremos. No lo sabemos.

Pero, si nos basamos en la evidencia, creo que es justo decir que la mayoría de los expertos que saben mucho sobre IA creen que es muy probable que tengamos superinteligencia en los próximos 20 años. Demis Hassabis, CEO de Google DeepMind, dice que quizá en 10 años. Incluso Gary Marcus, escéptico destacado, probablemente diría: “Bueno, si combináis sistemas con lógica simbólica tradicional… quizá eso sea superinteligente”. [Nota del editor: en septiembre, Marcus predijo que la IAG llegaría entre 2033 y 2040].

Y no creo que nadie piense que el progreso se detendrá en la IAG. Más o menos todo el mundo cree que, unos años después, tendremos superinteligencia, porque la IAG será mejor que nosotros construyendo IA.

Así que, aunque está claro que el viento sopla en contra, al mismo tiempo se están destinando muchos más recursos [al desarrollo de IA avanzada]. Creo que el progreso continuará simplemente porque hay muchos más recursos entrando.

El pionero del deep learning que desearía haber visto antes los riesgos

Yoshua Bengio, premio Turing, presidente del International AI Safety Report y fundador de LawZero

Algunos pensaron que GPT‑5 significaba que habíamos tocado techo, pero eso no es lo que muestran los datos y las tendencias científicas.

Ha habido gente que ha exagerado la idea de que la IAG llega mañana, lo que comercialmente puede tener sentido. Pero si miras los distintos indicadores, GPT‑5 está justo donde cabía esperar que estuvieran los modelos en este momento. Y no es solo GPT‑5, también Claude y los modelos de Google. En áreas donde los sistemas de IA no eran muy buenos, como el último examen de la humanidad o FrontierMath (sistemas de pruebas de la IA), ahora obtienen puntuaciones mucho mejores que a principios de año.

Al mismo tiempo, el panorama general para la gobernanza y la seguridad de la IA no es bueno. Hay una fuerza muy fuerte en contra de la regulación. Es como el cambio climático. Podemos meter la cabeza en la arena y esperar que todo vaya bien, pero eso no resuelve el problema.

El mayor desencuentro con los responsables políticos es no entender la magnitud del cambio que puede producirse si la tendencia de progreso continúa. Mucha gente en empresas y gobiernos piensa que la IA es solo otra tecnología que será muy poderosa económicamente. No comprenden cuánto podría cambiar el mundo si seguimos avanzando hacia una IA a nivel humano.

Como muchos, me cegaba un poco ante los riesgos potenciales. Debería haberlo visto mucho antes. Pero es humano. Te entusiasma tu trabajo y quieres ver el lado bueno. Eso nos hace estar un poco sesgados y no prestar atención a lo malo que pudiera pasar.

Incluso una pequeña probabilidad, como 1% o 0,1%, de provocar un accidente en el que mueran miles de millones de personas no es aceptable.

El veterano que cree que la IA avanza, pero no lo bastante rápido para evitar que la burbuja estalle

Stuart Russell, profesor distinguido de informática en la Universidad de California, Berkeley, y autor de ‘Human Compatible‘

Espero que la idea de que hablar de riesgo existencial te convierte en un “agorero” o en ciencia ficción acabe viéndose como marginal, dado que la mayoría de los principales investigadores y CEOs de IA lo toman en serio.

Ha habido afirmaciones de que la IA nunca podría pasar un test de Turing, o que nunca tendríamos un sistema que use lenguaje natural con fluidez, o que aparque un coche en paralelo. Todas esas afirmaciones han quedado desmentidas por el progreso.

La gente está gastando billones de dólares para que exista una IA sobrehumana. Creo que necesitan nuevas ideas, pero hay una probabilidad significativa de que las encuentren, porque en los últimos años han surgido muchas ideas importantes.

Mi estimación más constante en los últimos 12 meses es que hay un 75% de probabilidades de que esos avances no lleguen a tiempo para salvar a la industria del estallido de la burbuja. Las inversiones actuales se basan en la predicción de que tendremos una IA mucho más potente, capaz de generar un valor real para los clientes. Pero si esas previsiones no se cumplen, habrá mucha sangre en el parqué.

Ahora bien, el argumento sobre la seguridad no tiene que ver con la inminencia. Se trata del hecho de que aún no tenemos una solución al problema del control. Si alguien dijera que un asteroide de cuatro millas de diámetro va a impactar contra la Tierra en 2067, no responderíamos: “Avísame en 2066 y lo pensamos”. No sabemos cuánto tiempo llevará desarrollar la tecnología necesaria para controlar una IA superinteligente.

Si miramos precedentes, el nivel de riesgo aceptable para que se funda un reactor nuclear es de uno entre un millón al año. La extinción es mucho peor que eso. Así que quizá deberíamos fijar el riesgo aceptable en uno entre mil millones. Pero las empresas hablan de algo parecido a uno entre cinco. No saben cómo hacerlo aceptable. Y eso es un problema.

El profesor que intenta fijar el relato sobre la seguridad en IA

David Krueger, profesor asistente de aprendizaje automático en la Universidad de Montreal y el instituto Mila de Yoshua Bengio, y fundador de Evitable

Creo que la gente se pasó de frenada en su reacción a GPT‑5. Pero había hype. Recuerdo varias declaraciones de CEOs, con distintos grados de claridad, que básicamente decían que para finales de 2025 tendríamos un sustituto remoto automatizado para trabajadores. Pero parece que ha sido decepcionante: los agentes simplemente no están ahí todavía.

Me sorprende lo mucho que las narrativas que predicen la IAG en 2027 capturan la atención pública. Cuando llegue 2027 y todo siga más o menos normal, creo que la gente sentirá que toda esa visión del mundo ha quedado desacreditada. Y es realmente molesto que, cuando hablo de seguridad en IA, muchos asuman que creo que tenemos plazos muy cortos para sistemas peligrosos, o que pienso que los LLM o el deep learning nos darán la IAG. Me atribuyen supuestos que no son necesarios para sostener el argumento.

Creo que necesitaremos décadas para resolver el problema de la coordinación internacional. Así que, incluso si la IA peligrosa está a décadas de distancia, ya es urgente. Ese punto parece perdido para mucha gente. Existe esta idea de “esperemos a tener un sistema realmente peligroso y entonces empezamos a gobernarlo”. Hombre, eso es demasiado tarde.

También pienso que la comunidad de seguridad tiende a trabajar entre bastidores, con gente en el poder, no con la sociedad civil. Eso da munición a quienes dicen que todo es una estafa o un lobby interno. No digo que esas narrativas no tengan algo de verdad, pero el riesgo subyacente sigue siendo real. Necesitamos más conciencia pública y una base amplia de apoyo para responder de forma eficaz.

Si realmente crees que hay un 10% de posibilidades de catástrofe en los próximos 10 años (lo que creo que una persona razonable debería pensar si analiza el tema de cerca), lo primero que piensas es: “¿Por qué estamos haciendo esto? Es una locura”. Esa es una reacción muy razonable cuando aceptas la premisa.

La experta en gobernanza preocupada por la credibilidad de la seguridad en IA

Helen Toner, directora ejecutiva interina del Centro para Seguridad y Tecnologías Emergentes de la Universidad de Georgetown y exmiembro del consejo de OpenAI

Cuando entré en este ámbito, la seguridad en IA era más un conjunto de ideas filosóficas. Hoy es un conjunto dinámico de subcampos del aprendizaje automático, que llena el vacío entre algunas de las preocupaciones más “extravagantes” sobre una IA que trama, engaña o busca poder, frente a sistemas concretos que podemos probar y con los que podemos jugar.

La gobernanza de la IA mejora lentamente. Si tenemos mucho tiempo para adaptarnos y la gobernanza sigue mejorando poco a poco, no me siento mal. Si no tenemos mucho tiempo, entonces probablemente vamos demasiado despacio.

Creo que GPT‑5 se percibe en general como una decepción en Washington. Hay una conversación bastante polarizada: ¿Tendremos IAG y superinteligencia en los próximos años? ¿O la IA es puro hype, inútil y una burbuja? El péndulo quizá se había inclinado demasiado hacia “Vamos a tener sistemas súper capaces muy, muy pronto”. Y ahora oscila hacia “Todo es humo”.

Me preocupa que algunas estimaciones agresivas sobre plazos para la IAG por parte de gente de seguridad en IA les estén preparando para un momento tipo Pedro y el lobo. Cuando las predicciones sobre la llegada en 2027 no se cumplan, la gente dirá: “Mira a todos estos que hicieron el ridículo. Nunca deberías escucharles otra vez”. Esa no es una respuesta intelectualmente honesta, aunque luego hayan cambiado de opinión, o su postura fuera que solo pensaban que había un 20% de probabilidad y que eso ya merecía atención. Creo que eso no debería descalificarte para que te escuchen después, pero me preocupa que sea un golpe grande a la credibilidad. Y eso afecta incluso a quienes están muy preocupados por la seguridad en IA y nunca dijeron nada sobre plazos muy cortos.

El investigador que ahora cree que la IAG está más lejos—y lo agradece

Jeffrey Ladish, director ejecutivo en Palisade Research

En el último año, dos cosas han cambiado mis plazos para la IAG.

Primero, la falta de datos de alta calidad resultó ser un problema mayor de lo que esperaba.

Segundo, el primer modelo de “razonamiento”, el o1 de OpenAI en septiembre de 2024, mostró que la escala del aprendizaje por refuerzo era más eficaz de lo que pensaba. Y luego, meses después, ves la ampliación de o1 a o3 y un rendimiento impresionante en matemáticas, programación y ciencia, dominios donde es más fácil verificar los resultados. Pero, aunque seguimos viendo avances, podrían haber sido mucho más rápidos.

Todo esto eleva mi estimación media para el inicio de la investigación y desarrollo totalmente automatizados de tres años a quizá cinco o seis. Pero son cifras un poco inventadas. Es difícil. Quiero advertir que “es realmente complicado hacer previsiones aquí”.

Gracias a Dios tenemos más tiempo. Tenemos una ventana de oportunidad, quizá muy breve, para intentar comprender estos sistemas antes de que sean lo bastante capaces y estratégicos como para suponer una amenaza real a nuestra capacidad de controlarlos.

Pero da miedo ver que la gente piensa que ya no estamos progresando, cuando claramente no es cierto. Lo sé porque uso los modelos. Uno de los inconvenientes de cómo avanza la IA es que la velocidad del progreso se vuelve menos legible para la gente normal.

Ahora, esto no es cierto en algunos ámbitos: mira Sora 2. Es obvio para cualquiera que lo observe que Sora 2 es muchísimo mejor que lo anterior. Pero si preguntas a GPT‑4 y GPT‑5 por qué el cielo es azul, te darán básicamente la misma respuesta. Es la respuesta correcta. Ya ha saturado la capacidad de explicártelo. Así que las personas que espero que más comprendan el progreso ahora son las que realmente construyen con IA o la usan en problemas científicos muy difíciles.

El pronosticador que vio venir a los críticos

Daniel Kokotajlo, director ejecutivo del AI Futures Project; informante de OpenAI; y autor principal de AI 2027, un escenario vívido donde, a partir de 2027, las IA pasan de “programadores sobrehumanos” a sistemas “salvajemente superinteligentes” en cuestión de meses

La política de IA parece ir a peor, como el super PAC “Pro-AI” [lanzado este año por ejecutivos de OpenAI y Andreessen Horowitz para impulsar una agenda desreguladora], y los tuits delirantes y/o deshonestos de Sriram Krishnan y David Sacks. La investigación en seguridad avanza al ritmo habitual, que es rápido comparado con otros campos, pero lento comparado con la velocidad que necesitamos.

Dijimos en la primera página de AI 2027 que nuestros plazos eran algo más largos que 2027. Así que, incluso cuando lanzamos AI 2027, esperábamos que en 2028 hubiera críticos diciendo triunfalmente que nos habíamos equivocado, como los tuits de Sacks y Krishnan. Pero pensamos, y seguimos pensando, que la explosión de inteligencia probablemente ocurrirá en algún momento entre los próximos cinco y diez años, y que cuando suceda, la gente recordará nuestro escenario y verá que estaba más cerca de la verdad que cualquier otra cosa de las que se decían en 2025.

Predecir el futuro es difícil, pero vale la pena intentarlo; la gente debería comunicar su incertidumbre sobre el futuro de forma específica y falsable. Eso es lo que hemos hecho y muy pocos otros han hecho. Nuestros críticos, en su mayoría, no han hecho predicciones propias y a menudo exageran y tergiversan nuestras opiniones. Dicen que nuestros plazos son más cortos de lo que son o fueron, o que somos más confiados de lo que somos o fuimos.

Me siento bastante bien con tener plazos más largos para la llegada IAG. Es como si mi médico me diera un pronóstico mejor. La situación sigue siendo básicamente la misma, eso sí.

Esta historia se ha actualizado para aclarar algunos puntos sobre las opiniones de Kokotajlo en materia de política de IA.

Garrison Lovely es periodista independiente y autor de Obsolete, una publicación digital y un libro próximo a publicarse sobre el debate, la economía y la geopolítica en la carrera por desarrollar la superinteligencia artificial (saldrá en primavera de 2026). Sus artículos sobre IA han aparecido en ‘The New York Times’, ‘Nature’, ‘Bloomberg’, ‘Time’, ‘The Guardian’, ‘The Verge’ y otros medios.