OpenAI se ha fijado un doble objetivo. Por un lado, es un gigante tecnológico arraigado en productos, entre los que se incluye, por supuesto, ChatGPT, al que, según se informa, personas de todo el mundo envían 2500 millones de solicitudes al día. Pero su misión original es servir como laboratorio de investigación que no solo cree «inteligencia artificial general», sino que garantice que esta beneficie a toda la humanidad.

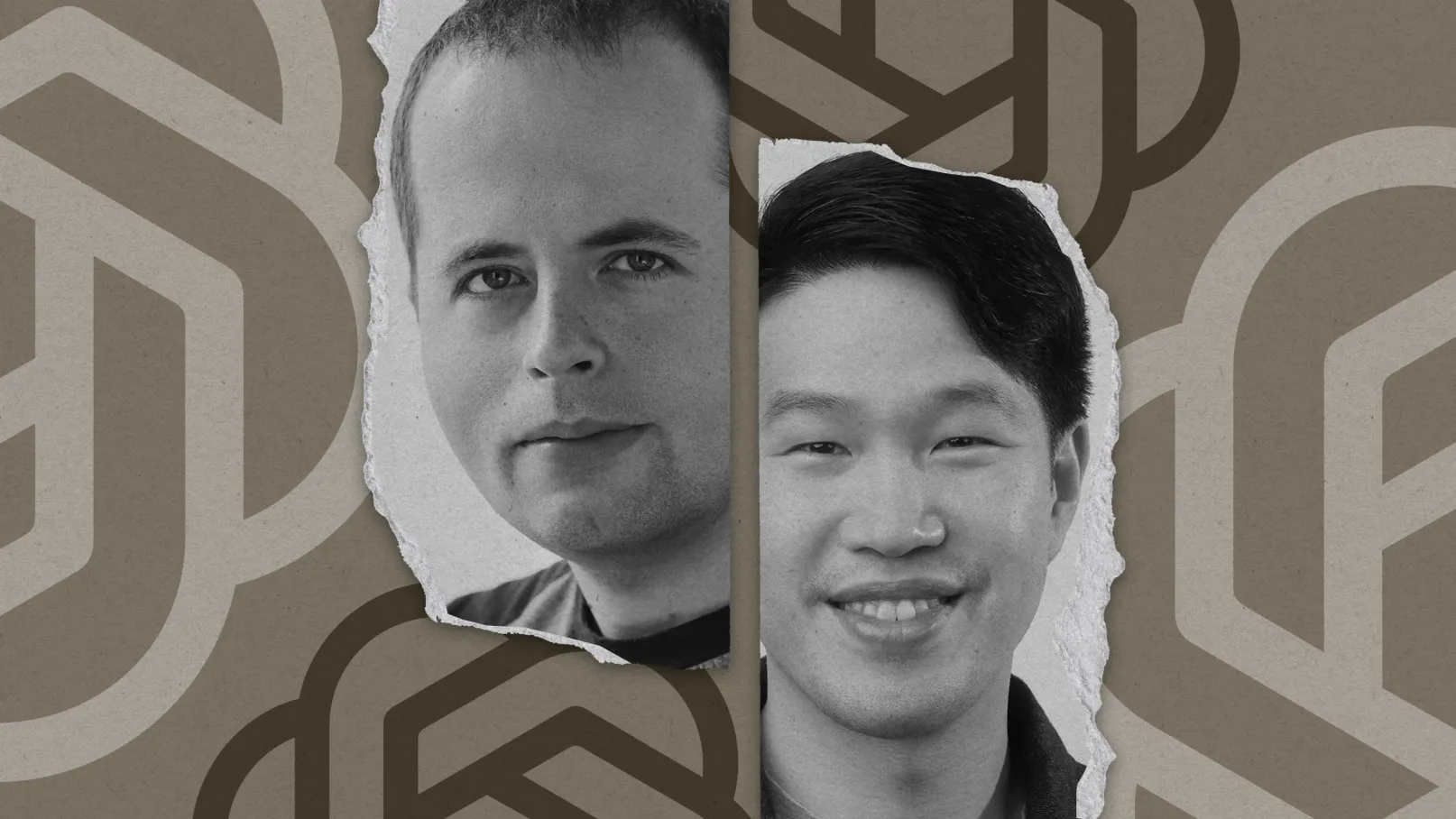

Mi colega Will Douglas Heaven se sentó recientemente para mantener una conversación exclusiva con las dos figuras de OpenAI más responsables de perseguir esta última ambición: el director de investigación Mark Chen y el científico jefe Jakub Pachocki. Si aún no lo ha hecho, no se pierda su artículo.

Ofrece una visión poco habitual de cómo la empresa va más allá de las mejoras marginales en los chatbots y contempla las mayores incógnitas de la IA: si algún día podrá razonar como un humano, si debería hacerlo y cómo conceptualizan las empresas tecnológicas las implicaciones sociales.

Vale la pena leer todo el artículo por todo lo que revela, cómo piensa OpenAI sobre la seguridad de sus productos, qué significa realmente la IGA y mucho más, pero hay una cosa que me llamó especialmente la atención.

Como señala Will, OpenAI ha conseguido recientemente dos victorias en sus esfuerzos por crear una IA que supere a los humanos. Sus modelos quedaron en segundo lugar en una competición de programación de alto nivel y, junto con los de Google DeepMind, obtuvieron resultados de medalla de oro en la Olimpiada Internacional de Matemáticas de 2025.

Las personas que creen que la IA no supone una competencia real para la inteligencia humana podrían sentirse reconfortadas por ello. La IA es buena en matemáticas y análisis, lo que queda patente en las olimpiadas y en las competiciones de programación. Eso no significa que sea buena lidiando con el caos de las emociones humanas, tomando decisiones difíciles o creando arte que resuene en alguien.

Pero esa distinción, entre el razonamiento similar al de una máquina y la capacidad de pensar de forma creativa, no es algo que los responsables de investigación de OpenAI estén dispuestos a hacer.

«Estamos hablando de programación y matemáticas«, dijo Pachocki. «Pero en realidad se trata de creatividad, de generar ideas novedosas, de conectar ideas de diferentes lugares».

Por eso, según los investigadores, estos campos de pruebas para la IA producirán modelos con una capacidad cada vez mayor para razonar como una persona, uno de los objetivos más importantes por los que trabaja OpenAI. Los modelos de razonamiento descomponen los problemas en pasos más discretos, pero incluso los mejores tienen una capacidad limitada para encadenar piezas de información y abordar los problemas de forma lógica.

OpenAI está invirtiendo una enorme cantidad de dinero y talento en ese problema, no porque sus investigadores piensen que dará lugar a mejores resultados en concursos de matemáticas, sino porque creen que permitirá que sus modelos de IA se acerquen más a la inteligencia humana.

Como recuerda Will en el artículo, dijo que pensaba que quizá estaba bien que la IA destacara en matemáticas y programación, pero que quizá no lo estaba que una IA adquiriera habilidades sociales y sustituyera a los políticos. Chen puso cara de extrañeza y miró al techo: «¿Por qué no?».