¿Lo sientes?

Dicen que está cerca: dos años, cinco… quizá el próximo. Y dicen que va a cambiarlo todo: curará enfermedades, salvará el planeta y dará paso a una era de abundancia. Resolverá nuestros mayores problemas de formas que aún no podemos imaginar. Redefinirá lo que significa ser humano.

Espera… ¿y si todo eso suena demasiado bien para ser cierto? Porque también se dice que traerá el apocalipsis y acabará con nosotros.

Sea como sea, y ocurra cuando ocurra, algo grande está por suceder.

Podríamos estar hablando del Segundo Advenimiento. O del día en que los miembros de Heaven’s Gate creían que serían recogidos por un OVNI y transformados en alienígenas iluminados. O del momento en que Donald Trump decida finalmente desatar la tormenta prometida por QAnon. Pero no. Hablamos, por supuesto, de la inteligencia artificial general o AGI, esa tecnología hipotética del futuro cercano que —dicen— podrá hacer prácticamente todo lo que hace un cerebro humano.

Para muchos, la AGI es más que una tecnología. En centros tecnológicos como Silicon Valley, se habla de ella en términos casi místicos. Ilya Sutskever, cofundador y exdirector científico de OpenAI, llegó a liderar cánticos de “¡Siente la AGI!” en reuniones de equipo. Y él la siente más que nadie: en 2024 dejó OpenAI —cuya misión declarada es garantizar que la AGI beneficie a toda la humanidad— para fundar Safe Superintelligence, una startup dedicada a evitar que una »AGI rebelde» se descontrole (o a saber cómo controlarla cuando llegue). La superinteligencia es la nueva versión mejorada: AGI, pero más potente, presentada justo cuando el término AGI empieza a hacerse común.

Sutskever también encarna las motivaciones contradictorias que mueven a muchos de los autoproclamados evangelistas de la AGI. Ha dedicado su carrera a construir los cimientos de una tecnología futura que ahora le aterra. «Va a ser monumental, estremecedora… habrá un antes y un después», me dijo unos meses antes de abandonar OpenAI. Cuando le pregunté por qué había redirigido sus esfuerzos hacia contener esa tecnología, respondió: «Lo hago por interés propio. Es evidente que cualquier superinteligencia que alguien construya no debe volverse rebelde. Obviamente».

No está solo en su pensamiento grandilocuente, incluso apocalíptico.

Cada época tiene sus creyentes: personas con una fe inquebrantable en que algo enorme está por suceder—un antes y un después que están destinados (o condenados) a vivir.

Para nosotros, ese algo es la llegada prometida de la inteligencia artificial general (AGI). La gente está acostumbrada a escuchar que esto o aquello será “lo próximo grande”, explica Shannon Vallor, experta en ética tecnológica en la Universidad de Edimburgo. «Antes era la era del ordenador, luego la del internet, y ahora es la era de la inteligencia artificial», dice. «Es normal que te presenten algo y te digan que eso es el futuro. Lo diferente, claro, es que, a diferencia de los ordenadores o internet, la AGI no existe».

Y por eso “sentir la AGI” no es lo mismo que subirse al carro de la próxima gran innovación. Hay algo más extraño en juego. Esto es lo que pienso: la AGI se parece mucho a una teoría de la conspiración, y quizá sea la más trascendental de nuestro tiempo.

Llevo más de una década cubriendo el desarrollo de la inteligencia artificial, y he visto cómo la idea de la AGI ha pasado de ser una fantasía marginal a convertirse en la narrativa dominante que da forma a toda una industria. Lo que antes era un sueño remoto ahora sostiene las proyecciones de beneficios de algunas de las empresas más valiosas del mundo y, por extensión, del mercado bursátil estadounidense. Justifica inversiones astronómicas en nuevas centrales eléctricas y centros de datos que, según nos dicen, son necesarios para hacer realidad ese sueño. Obsesionadas con esta tecnología hipotética, las empresas de IA nos la están vendiendo con fuerza.

Solo hay que escuchar lo que dicen los directivos de esas compañías. La AGI será tan inteligente como «un país entero de genios» (Dario Amodei, CEO de Anthropic); iniciará «una era de máximo florecimiento humano, en la que viajaremos a las estrellas y colonizaremos la galaxia» (Demis Hassabis, CEO de Google DeepMind); «aumentará enormemente la abundancia y la prosperidad», e incluso animará a la gente a disfrutar más de la vida y tener más hijos (Sam Altman, CEO de OpenAI). Vaya producto.

O no. Porque no hay que olvidar la otra cara de la moneda. Cuando no están vendiendo utopías, están salvándonos del infierno. En 2023, Amodei, Hassabis y Altman firmaron una declaración de 22 palabras que decía: «Mitigar el riesgo de extinción por IA debería ser una prioridad global, junto con otros riesgos a escala social como las pandemias y la guerra nuclear». Elon Musk afirma que la IA tiene un 20% de probabilidad de aniquilar a la humanidad.

«Últimamente he notado que el concepto de superinteligencia, que antes parecía algo que no debías mencionar si querías que te tomaran en serio en público, ahora lo usan los CEOs tecnológicos como si estuvieran planeando construirla», comenta Katja Grace, investigadora principal en AI Impacts, una organización que estudia las percepciones de los expertos en inteligencia artificial sobre su campo. «Creo que es fácil pensar que no pasa nada. También dicen que va a matarnos, pero se ríen mientras lo dicen».

Hay que admitir que todo esto suena un poco a sombrero de papel de aluminio. Si estás construyendo una teoría de la conspiración, necesitas algunos ingredientes: un esquema lo suficientemente flexible como para sostener la creencia incluso cuando las cosas no salen como se esperaba; la promesa de un futuro mejor que solo puede alcanzarse si los creyentes descubren verdades ocultas; y una esperanza de salvación frente a los horrores del mundo.

La AGI cumple con todos esos requisitos. Cuanto más se examina la idea, más empieza a parecer una conspiración. No lo es, claro—no exactamente. Y no trazo este paralelismo para desacreditar los logros reales, a menudo sorprendentes, alcanzados por muchas personas en este campo, incluidos (o especialmente) los creyentes en la AGI.

Pero al centrarnos en los elementos que la AGI comparte con las conspiraciones genuinas, podemos enfocar mejor el concepto y revelar lo que realmente es: un delirio techno-utópico (o techno-distópico, según el color de la píldora) que ha arraigado en creencias profundas y difíciles de erradicar.

No se trata solo de un experimento mental provocador. Es importante cuestionar lo que se nos dice sobre la AGI, porque comprar esa idea no es inocuo. Hoy por hoy, la AGI es la narrativa más influyente en el ámbito tecnológico—y, en cierta medida, en la economía global. No podemos entender lo que está ocurriendo en el mundo de la IA sin comprender de dónde viene la idea de la AGI, por qué resulta tan seductora y cómo moldea nuestra forma de pensar sobre la tecnología en general.

Lo entiendo, lo entiendo—llamar conspiración a la AGI no es una analogía perfecta. También va a molestar a mucha gente. Pero acompáñame en esta madriguera y déjame mostrarte la luz.

Cómo Silicon Valley se volvió adicta a la AGI

Tenía gancho

Una teoría de la conspiración típica suele surgir en los márgenes. Quizá empieza con un par de personas publicando en un foro, reuniendo “pruebas”. Tal vez son unos cuantos en el desierto con binoculares esperando ver luces en el cielo. Pero algunas teorías tienen suerte, por así decirlo: comienzan a circular más ampliamente, se vuelven un poco más aceptables, empiezan a influir en personas con poder. Puede que sean los ovnis (perdón, los “fenómenos aéreos no identificados”) que ahora se discuten formalmente en audiencias gubernamentales. O el escepticismo sobre las vacunas (sí, un ejemplo mucho más peligroso) que se convierte en política oficial. Y es imposible ignorar que la inteligencia artificial general ha seguido una trayectoria bastante similar a la de sus parientes más abiertamente conspirativos.

Volvamos a 2007, cuando la IA no era sexy ni estaba de moda. Empresas como Amazon y Netflix (que aún enviaba DVDs por correo) usaban modelos de machine learning, protoorganismos de los actuales LLM, para recomendar películas y libros. Pero eso era todo.

Ben Goertzel tenía planes mucho más ambiciosos. Una década antes, este investigador había fundado una startup llamada Webmind para entrenar lo que él consideraba una especie de cerebro digital infantil en los primeros días de internet. Sin hijos, Webmind pronto quebró.

Pero Goertzel era una figura influyente en una comunidad marginal de investigadores que soñaban desde hacía años con construir una inteligencia artificial similar a la humana: un programa informático capaz de hacer muchas de las cosas que hacen las personas (y hacerlas mejor). Una visión que iba mucho más allá de la tecnología que Netflix estaba explorando.

Goertzel quería publicar un libro para promover esa visión, y necesitaba un nombre que la diferenciara de la IA convencional. Shane Legg, ex empleado de Webmind, sugirió Artificial General Intelligence. Tenía gancho.

Pocos años después, Legg cofundó DeepMind junto a Demis Hassabis y Mustafa Suleyman. Pero para la mayoría de los investigadores serios de entonces, la idea de que la IA algún día imitaría las capacidades humanas era poco menos que una broma. «AGI solía ser una palabra maldita», me dijo Ilya Sutskever. Andrew Ng, fundador de Google Brain y exdirector científico de Baidu, me confesó que le parecía una locura.

Entonces, ¿qué pasó? Hablé con Goertzel el mes pasado para entender cómo una idea marginal pasó de ser extravagante a convertirse en algo común. «Soy más bien un tipo de sistemas caóticos complejos, así que tengo poca fe en saber realmente cuál fue la dinámica no lineal en el memosphere», dijo. (Traducción: es complicado).

Goertzel cree que hubo varios factores que llevaron la idea al mainstream. El primero fue la Conference on Artificial General Intelligence, un encuentro anual de investigadores que ayudó a organizar en 2008, justo después de publicar su libro. La conferencia se coordinaba a menudo con congresos académicos de primer nivel, como los de la Association for the Advancement of Artificial Intelligence y la International Joint Conference on Artificial Intelligence. «Si solo hubiera publicado un libro con ese nombre, AGI, quizá habría pasado sin pena ni gloria», dice Goertzel. «Pero la conferencia se repetía cada año, con más y más estudiantes asistiendo».

El segundo factor fue Legg, que llevó el término consigo a DeepMind. «Creo que fueron la primera entidad corporativa mainstream en hablar de AGI», dice Goertzel. «No era su tema principal, pero Shane y Demis lo mencionaban de vez en cuando. Eso fue sin duda una fuente de legitimación».

Cuando hablé por primera vez con Legg sobre la AGI hace cinco años, me dijo: «Hablar de AGI en los primeros 2000 te ponía en el margen lunático… Incluso cuando fundamos DeepMind en 2010, recibimos una cantidad asombrosa de miradas escépticas en las conferencias». Pero para 2020, el viento había cambiado. «A algunos les incomoda, pero está saliendo del frío», me dijo entonces.

El tercer factor que señala Goertzel es el cruce entre los primeros evangelistas de la AGI y los grandes nombres de Big Tech. En los años entre el cierre de Webmind y la publicación de su libro sobre AGI, Goertzel trabajó con Peter Thiel en el fondo de inversión Clarium Capital. «Hablamos bastante», recuerda. Pasó un día con Thiel en el Four Seasons de San Francisco. «Intentaba meterle la AGI en la cabeza», dice Goertzel. «Pero también estaba escuchando a Eliezer decir que la AGI va a matarnos a todos».

Llegan los doomers

Ese Eliezer es Eliezer Yudkowsky, otra figura influyente que ha hecho al menos tanto como Goertzel —si no más— para impulsar la idea de la AGI. Pero a diferencia de Goertzel, Yudkowsky cree que hay una probabilidad muy alta —99,5% es una cifra que menciona— de que el desarrollo de la AGI sea una catástrofe.

En 2000, Yudkowsky cofundó una organización sin ánimo de lucro llamada Singularity Institute for Artificial Intelligence (más tarde rebautizada como Machine Intelligence Research Institute), que pronto se dedicó a evitar escenarios doomer. Thiel fue uno de sus primeros benefactores.

Al principio, las ideas de Yudkowsky no tuvieron mucha repercusión. Recordemos que en aquel entonces la idea de una IA todopoderosa —y mucho menos peligrosa— era pura ciencia ficción. Pero en 2014, el filósofo Nick Bostrom, de la Universidad de Oxford, publicó el libro Superintelligence.

«Ese libro puso la AGI sobre la mesa», dice Goertzel. «Quiero decir, Bill Gates, Elon Musk… muchos expertos en IA de la industria tecnológica lo leyeron, y aunque no todos compartían su visión doomer, Nick tomó los conceptos de Eliezer y los presentó de forma muy aceptable».

«Todo esto le dio a la AGI un sello de respetabilidad», añade Goertzel. «Ya no era solo cosa de excéntricos aullando en el desierto».

Yudkowsky lleva 25 años tocando la misma tecla. Muchos ingenieros de las principales empresas de inteligencia artificial actuales crecieron leyendo y debatiendo sus ideas en internet, especialmente en LessWrong, un foro muy popular entre la ferviente comunidad tecnológica de racionalistas y defensores del »altruismo eficaz».

Hoy, esas ideas están más vigentes que nunca, capturando la imaginación de una nueva generación de doomers, como David Krueger, investigador de la Universidad de Montreal y exdirector de investigación en el AI Security Institute del Reino Unido. «Creo que definitivamente estamos en camino de construir sistemas de IA superhumanos que van a matar a todo el mundo», me dice Krueger. «Y creo que eso es horrible y deberíamos detenernos de inmediato».

Yudkowsky aparece en perfiles de medios como The New York Times, que lo presenta como «la versión Silicon Valley del predicador del fin del mundo». Su nuevo libro, If Anyone Builds It, Everyone Dies, escrito junto a Nate Soares, presidente del Machine Intelligence Research Institute, expone afirmaciones extremas —con escasas pruebas— según las cuales, si no se detiene el desarrollo de la AGI, esta conducirá al Armagedón global. La postura del dúo es radical: defienden que se imponga una prohibición internacional a toda costa, incluso si eso implica una represalia nuclear. Al fin y al cabo, escriben Yudkowsky y Soares, «los centros de datos pueden matar a más personas que las armas nucleares».

Esto ya no es algo minoritario. El libro es un éxito de ventas del New York Times y cuenta con el respaldo de expertos en seguridad nacional, como Suzanne Spaulding, exfuncionaria del Departamento de Seguridad Nacional de EE. UU., y Fiona Hill, exdirectora sénior del Consejo de Seguridad Nacional de la Casa Blanca, que ahora asesora al Gobierno del Reino Unido; científicos famosos, como Max Tegmark y George Church, y otras personalidades conocidas, como Stephen Fry, Mark Ruffalo y Grimes. Ahora, Yudkowsky tiene un megáfono.

Sin embargo, pueden ser más trascendentales aquellas primeras palabras susurradas al oído a ciertas personas. Se atribuye a Yudkowsky haber presentado a Thiel a los fundadores de DeepMind, tras lo cual este se convirtió en uno de los primeros grandes inversores de la empresa. Tras fusionarse con Google, DeepMind es ahora el laboratorio de IA interno del coloso tecnológico Alphabet.

Junto con Musk, Thiel también fue fundamental en la creación de OpenAI en 2015, invirtiendo millones en una empresa emergente fundada con la singular ambición de desarrollar una IA segura. En 2023, el director ejecutivo de OpenAI, Sam Altman, publicó en X: «En mi opinión, Eliezer ha hecho más que nadie para acelerar la IA. Sin duda, ha conseguido que muchos nos interesemos por la IA». Altman añadió que Yudkowsky podría merecer algún día el Premio Nobel de la Paz por ello. Sin embargo, en ese momento, Thiel parecía recelar de los «defensores de la seguridad de la IA» y del poder que estaban adquiriendo. «No entiendes cómo Eliezer ha programado a la mitad de la gente de tu empresa para que crea en esas cosas», le dijo a Altman en una cena a finales de 2023, según se ha informado. «Tienes que tomarte esto más en serio». Altman «intentó no poner los ojos en blanco», según el reportero del Wall Street Journal, Keach Hagey.

OpenAI es ahora la empresa privada más valiosa del mundo, con un valor de medio billón de dólares.

Y la transformación se ha completado: como todas las conspiraciones más poderosas, la IA se ha colado en la corriente principal y se ha afianzado.

La gran conspiración de la AGI

El término AGI —siglas en inglés de »inteligencia artificial general»— puede que se haya popularizado hace menos de dos décadas, pero el relato que lo envuelve lleva gestándose desde los albores de la era informática. Una especie de fondo cósmico de microondas hecho de chutzpah y marketing.

Alan Turing se preguntó si las máquinas podían pensar apenas cinco años después de que se construyera el primer ordenador electrónico, el ENIAC, en 1945. En una emisión radiofónica de 1951, dejó una advertencia que hoy resuena con inquietante vigencia: “Es probable que, una vez iniciado el método de pensamiento mecánico, no tardara en superar nuestras débiles capacidades. No habría duda de que las máquinas no morirían, y podrían conversar entre sí para agudizar su ingenio. En algún momento, por tanto, deberíamos esperar que tomaran el control”.

Poco después, en 1955, el científico informático John McCarthy y su equipo solicitaron financiación al gobierno de EE UU para desarrollar lo que decidieron llamar “inteligencia artificial”. Una jugada astuta, teniendo en cuenta que los ordenadores de entonces ocupaban una habitación entera y eran tan limitados como un termostato. Aun así, McCarthy escribió en aquella propuesta: “Se intentará descubrir cómo lograr que las máquinas usen el lenguaje, formen abstracciones y conceptos, resuelvan tipos de problemas que hoy están reservados a los humanos, y se mejoren a sí mismas”.

Este mito es el origen de la teoría de la conspiración sobre la IA. Una máquina más inteligente que el ser humano y capaz de hacerlo todo no es una tecnología. Es un sueño alejado de la realidad. Cuando te das cuenta de ello, empiezas a ver otros paralelismos con el pensamiento conspirativo.

Es imposible desacreditar una idea cambiante como la IGA.

Hablar de la IGA a veces es como discutir con un entusiasta usuario de Reddit sobre qué drogas (o partículas en el cielo) controlan tu mente. Cada argumento tiene un contraargumento que intenta socavar tu propio sentido de la realidad. En última instancia, se trata de un choque de cosmovisiones, no de un intercambio de razones basadas en pruebas. La IGA también es así: resbaladiza.

Parte del problema es que, a pesar de todo el dinero y la atención que recibe, nadie sabe cómo construirla. Además, la mayoría de la gente ni siquiera se pone de acuerdo sobre qué es realmente la IGA, lo que ayuda a explicar cómo la gente puede salirse con la suya diciéndonos que puede salvar el mundo y acabar con él. La mayoría de las definiciones tienen en común la idea de una máquina capaz de igualar a los humanos en una amplia gama de tareas cognitivas (y recuerda que la superinteligencia es la nueva y brillante mejora de la IGA: una máquina capaz de superarnos). Pero incluso eso se puede desmontar fácilmente: ¿de qué humanos estamos hablando?, ¿qué tipo de tarea cognitiva?, ¿y qué alcance tiene?

«No hay una definición real», afirma Christopher Symons, científico jefe de inteligencia artificial en la empresa emergente de atención sanitaria Lirio y antiguo director de la división de informática y matemáticas del Laboratorio Nacional de Oak Ridge. «Si hablamos de «inteligencia a nivel humano», eso podría referirse a un número infinito de cosas, ya que el nivel de inteligencia de cada persona es ligeramente diferente».

Por lo tanto, según Symons, estamos en esta extraña carrera para construir… ¿Qué, exactamente? «¿Qué intentas que haga?».

En 2023, un equipo de investigadores de Google DeepMind, entre ellos Shane Legg, intentó clasificar las distintas definiciones que se habían propuesto para la AGI. Algunos sostenían que una máquina debía ser capaz de aprender; otros, que debía generar ingresos; y no faltaban quienes afirmaban que debía tener cuerpo, moverse por el mundo (y quizá preparar café).

Legg me contó que, cuando sugirió el término a Ben Goertzel para el título de su libro, la vaguedad era parte del propósito. «No tenía una definición especialmente clara. Ni siquiera sentía que fuera necesario», dijo entonces. «En realidad, lo pensaba más como un campo de estudio que como un objeto concreto».

Así que, ¿lo sabremos cuando lo veamos? El problema es que hay quienes creen que ya lo han visto.

En 2023, un grupo de investigadores de Microsoft publicó un artículo en el que relataban sus experiencias con una versión preliminar del modelo de lenguaje de OpenAI, GPT-4. Lo titularon Sparks of Artificial General Intelligence, y dividió a la industria.

Fue un momento en el que muchos investigadores quedaron impresionados y trataban de asimilar lo que estaban viendo. «Las cosas funcionaban mejor de lo que esperaban», dice Goertzel. «El concepto de AGI empezó a parecer realmente más plausible».

Y sin embargo, pese a la sorprendente capacidad lingüística de los LLM, Goertzel no cree que contengan verdaderamente chispas de AGI. «Me sorprende un poco que haya personas con un profundo conocimiento técnico de cómo funcionan estas herramientas que aún piensen que podrían convertirse en una AGI a nivel humano», afirma. «Por otro lado, no puedes demostrar que no sea cierto».

Y ahí está el dilema: no se puede demostrar que no sea cierto. «La idea de que la AGI está por llegar, que está a la vuelta de la esquina y que es inevitable, ha dado pie a muchas salidas de la realidad», señala Shannon Vallor, de la Universidad de Edimburgo. «Pero en realidad no tenemos ninguna evidencia de ello».

El pensamiento conspirativo vuelve a asomar. Las predicciones sobre cuándo llegará la AGI se hacen con la precisión de numerólogos que cuentan los días hasta el fin del mundo. Como no hay consecuencias reales en juego, los plazos se incumplen sin mayor drama. Se ofrecen excusas y se ajustan los calendarios una vez más.

Lo vimos este verano, cuando OpenAI lanzó el tan esperado GPT-5. Los entusiastas de la inteligencia artificial se sintieron decepcionados al comprobar que la nueva versión de la tecnología insignia de la compañía no suponía el salto cualitativo que esperaban. Pero en lugar de ver eso como una prueba de que la AGI no era alcanzable —o al menos no con un LLM—, los creyentes simplemente aplazaron sus predicciones. Estaba por llegar… solo que, bueno, la próxima vez.

Quizá tengan razón. O quizá la gente elige las pruebas que le convienen para defender una idea y pasa por alto las que la contradicen. Jeremy Cohen, que estudia el pensamiento conspirativo en entornos tecnológicos en la Universidad McMaster (Canadá), llama a esto ‘recogida imperfecta de evidencias’, una característica típica del pensamiento conspirativo.

Cohen comenzó su carrera investigadora en el desierto de Arizona, estudiando una comunidad llamada People Unlimited, cuyos miembros creían ser inmortales. La convicción era impermeable a cualquier evidencia contraria. Cuando alguno moría por causas naturales (incluidos dos de sus fundadores), la explicación era que lo merecía. «El consenso general era que cada muerte era un suicidio», cuenta Cohen. «Si eres inmortal y te da cáncer y mueres, bueno, es que algo hiciste mal».

Desde entonces, Cohen se ha centrado en el transhumanismo —la idea de que la tecnología puede ayudar a los humanos a superar sus limitaciones naturales— y en la AGI. «Estoy viendo muchos paralelismos. Hay formas de pensamiento mágico que, creo, forman parte del imaginario popular en torno a la AGI», afirma. «Se conecta muy bien con los tipos de imaginarios religiosos que vemos hoy en el pensamiento conspirativo».

Los creyentes conocen el secreto de la AGI.

Quizá algunos piensen que soy un ingenuo: «No te enteras de nada, jajaja». Pero ese es precisamente el punto. Hay quienes están dentro y quienes están fuera. Cuando hablo con investigadores o ingenieros que mencionan la AGI como algo asumido, da la sensación de que saben algo que yo no. Pero nadie ha logrado explicarme qué es ese algo.

La verdad está ahí fuera, si sabes dónde buscar. Las teorías de la conspiración giran, sobre todo, en torno a la revelación de una verdad oculta, me explica Jeremy Cohen: «Es un componente fundamental del pensamiento conspirativo, y eso se ve claramente en cómo se habla de la AGI», afirma.

El año pasado, Leopold Aschenbrenner, un ex empleado de OpenAI de 23 años reconvertido en inversor, publicó un manifiesto de 165 páginas titulado Situational Awareness, que fue ampliamente diseccionado. No hace falta leerlo para captar la idea: o ves la verdad de lo que viene, o no. Y tampoco necesitas datos duros: basta con sentirlo. Quienes no lo ven, simplemente no han «visto la luz».

Esta idea también rondó los márgenes de mi conversación con Goertzel. Cuando le pregunté por qué hay escepticismo en torno a la AGI, respondió: «Antes de cada gran logro técnico, desde el vuelo humano hasta la energía eléctrica, muchos sabios te explicaban por qué nunca iba a ocurrir. Lo cierto es que la mayoría solo cree en lo que tiene delante de los ojos».

Eso hace que la AGI suene a artículo de fe. Se lo planteé a Krueger, que cree que su llegada podría producirse en unos cinco años. Se burló: «Creo que eso está completamente al revés». Para él, el artículo de fe es la idea de que no ocurrirá: son los escépticos quienes siguen negando lo evidente. (Aun así, matiza: nadie lo sabe con certeza, pero no hay ninguna razón clara para pensar que la AGI no llegará).

Las verdades ocultas atraen a quienes se empeñan en revelar lo que siempre han visto. Pero con la AGI, no basta con descubrir algo escondido. Aquí, la revelación exige un acto de creación sin precedentes. Si crees que la AGI es alcanzable, entonces crees que quienes la desarrollan son como comadronas de máquinas que igualarán o superarán la inteligencia humana. «La idea de dar a luz a dioses mecánicos es, obviamente, muy halagadora para el ego», dice Vallor. «Es tremendamente seductora la idea de que tú mismo estás poniendo los cimientos de esa trascendencia».

Es otro punto de contacto con el pensamiento conspirativo. Parte del atractivo está en el deseo de encontrar un propósito en un mundo caótico que puede parecer carente de sentido: el anhelo de ser alguien con relevancia.

Krueger, que vive en Berkeley, dice conocer a personas que trabajan en inteligencia artificial y que ven esta tecnología como nuestra sucesora natural. «Lo ven como algo parecido a tener hijos», comenta. «Nota al margen: normalmente no tienen hijos».

La AGI será nuestra única salvación (o traerá el apocalipsis).

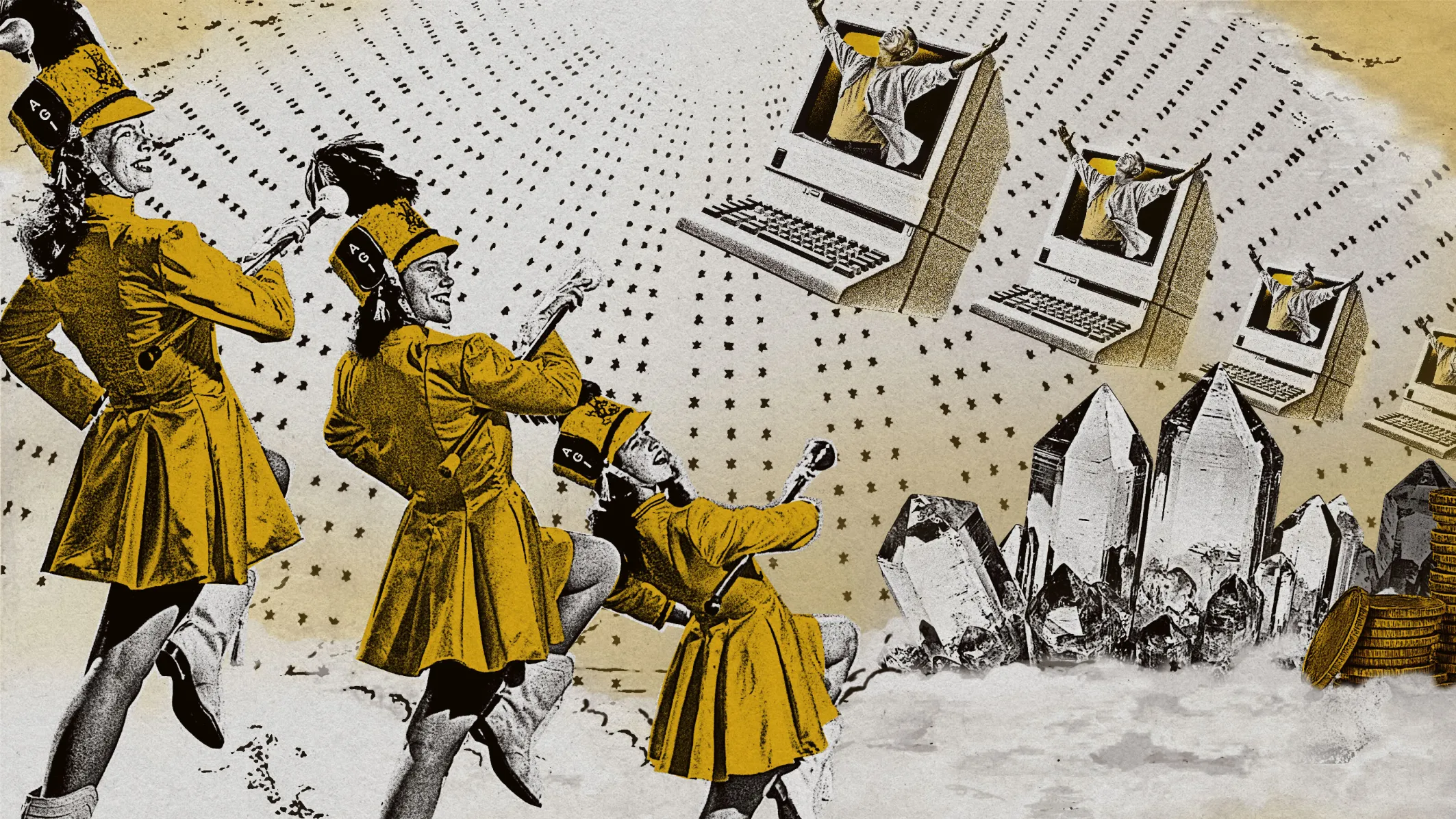

Cohen encuentra paralelismos entre muchas teorías conspirativas actuales y el movimiento New Age, que alcanzó su apogeo en los años setenta y ochenta. Sus seguidores creían que la humanidad estaba a punto de desbloquear una era de bienestar espiritual y conciencia expandida que traería un mundo más pacífico y próspero. En resumen, la idea era que, mediante un conjunto de prácticas pseudo-religiosas —como la astrología y la cuidadosa selección de cristales— los humanos trascenderían sus limitaciones y entrarían en una especie de utopía hippie.

La industria tecnológica actual se basa en compute, no en cristales, pero su visión de lo que está en juego no es menos trascendente: «Ya sabes, esta idea de que va a haber un cambio fundamental, un giro milenarista que nos llevará a un futuro tecno-utópico», dice Cohen. «Y la idea de que la AGI permitirá finalmente a la humanidad superar los problemas que nos aquejan».

Según muchos relatos, la AGI llegará de golpe. Los avances incrementales en inteligencia artificial se acumularán hasta que, un día, la IA será lo suficientemente buena como para empezar a crear mejores versiones de sí misma. En ese momento —FOOM— progresará tan rápido que la AGI emergerá en lo que suele llamarse una ‘explosión de inteligencia’, que desembocará en un punto de no retorno conocido como la Singularidad, un término estrafalario que lleva años circulando en los entornos de la AGI. El autor de ciencia ficción Vernor Vinge introdujo por primera vez la idea de la singularidad tecnológica en los años ochenta, apropiándose de un concepto de la física. Vinge imaginó un horizonte de sucesos en el camino del progreso tecnológico, más allá del cual los humanos quedarían rápidamente superados por la mejora exponencial de las máquinas que ellos mismos habían creado.

Podríamos llamarlo el Big Bang de la inteligencia artificial—lo que, una vez más, nos da un antes y un después, un momento trascendental en el que la humanidad, tal como la conocemos, cambia para siempre (para bien o para mal). «La gente lo imagina como un evento», dice Grace, de AI Impacts.

Para Vallor, este sistema de creencias destaca por cómo la fe en la tecnología ha sustituido a la fe en los seres humanos. A pesar de su componente woo-woo, el pensamiento New Age al menos partía de la idea de que las personas tenían lo necesario para cambiar el mundo por sí mismas, si lograban conectarse con ello. En la búsqueda de la AGI, hemos dejado atrás esa confianza en nosotros mismos y hemos comprado la idea de que solo la tecnología puede salvarnos, afirma.

Es un pensamiento poderoso—e incluso reconfortante—para muchas personas. «Vivimos una época en la que otras vías para mejorar materialmente la vida humana y nuestras sociedades parecen haberse agotado», señala Vallor.

La tecnología prometía antes un camino hacia un futuro mejor: el progreso era una escalera que nos llevaría al florecimiento humano y social. «Ya hemos pasado el punto álgido de esa promesa», dice Vallor. «Creo que lo único que devuelve a muchas personas la esperanza y cierto optimismo sobre el futuro es la AGI».

Llevada al extremo, esta idea convierte a la AGI en una especie de dios—uno capaz de aliviar el sufrimiento terrenal, según Vallor.

Kelly Joyce, socióloga en la Universidad de Carolina del Norte, estudia cómo las creencias culturales, políticas y económicas moldean nuestra forma de pensar y usar la tecnología. Para ella, todas estas predicciones desmesuradas sobre la AGI son algo más mundano: parte de un patrón histórico de promesas exageradas por parte de la industria tecnológica. «Lo que me parece interesante es que siempre acabamos cayendo», comenta. «Hay una creencia profunda de que la tecnología es mejor que los seres humanos».

Joyce cree que por eso, cuando el entusiasmo se dispara, la gente está predispuesta a creer. «Es una religión», afirma. «Creemos en la tecnología. La tecnología es Dios. Es muy difícil oponerse a eso. La gente no quiere escucharlo».

Cómo la AGI secuestró a toda una industria

La fantasía de ordenadores capaces de hacer casi cualquier cosa que hace una persona es seductora. Pero, como muchas teorías conspirativas persistentes, tiene consecuencias muy reales. Ha distorsionado nuestra forma de pensar sobre lo que está en juego en el actual auge tecnológico (y su posible colapso). Incluso podría haber descarrilado a la industria, desviando recursos de aplicaciones más inmediatas y prácticas. Por encima de todo, nos da carta blanca para ser perezosos. Nos engaña haciéndonos creer que podríamos evitar el trabajo duro necesario para resolver problemas complejos y globales—problemas que requieren cooperación internacional, compromiso y ayuda costosa. ¿Para qué molestarse, si pronto tendremos máquinas que lo resolverán todo por nosotros?

Basta con mirar los recursos que se están destinando a este gran proyecto. El mes pasado, OpenAI y Nvidia anunciaron una alianza de hasta 100.000 millones de dólares, en la que el gigante de los chips suministraría al menos 10 gigavatios para satisfacer la demanda insaciable de ChatGPT. Es una cifra superior a la de muchas centrales nucleares. Un rayo podría liberar esa cantidad de energía. El flux capacitor del DeLorean de Doc Brown solo necesitaba 1,2 gigavatios para enviar a Marty al futuro. Y apenas dos semanas después, OpenAI anunció una segunda alianza con el fabricante de chips AMD para otros seis gigavatios de potencia.

Al promocionar el acuerdo con Nvidia en CNBC, Sam Altman, con total seriedad, afirmó que sin este tipo de centros de datos, la gente tendría que elegir entre una cura para el cáncer y educación gratuita. «Nadie quiere tener que tomar esa decisión», dijo. (Pocas semanas después, anunció que ChatGPT incluiría chats eróticos).

A esos costes hay que sumar la pérdida de inversión en tecnologías más inmediatas que podrían mejorar vidas hoy, mañana y pasado. «Para mí es una oportunidad perdida enorme», dice Symons, de Lirio, «destinar todos estos recursos a resolver algo nebuloso cuando ya sabemos que hay problemas reales que podríamos abordar».

Pero OpenAI y compañías similares no necesitan operar así. «Con tanta gente lanzando dinero a estas empresas, no tienen por qué hacerlo», afirma Symons. «Si tienes cientos de miles de millones de dólares, no necesitas centrarte en un proyecto práctico y resoluble».

A pesar de su firme creencia en que la AGI llegará, Krueger también piensa que la obsesión de la industria por ella está dejando de lado soluciones potenciales a problemas reales, como una mejor atención sanitaria. «Todo esto de la AGI—es una tontería, una distracción, puro hype», me dice.

Y hay consecuencias en la forma en que los gobiernos apoyan y regulan la tecnología (o no lo hacen). Tina Law, experta en políticas tecnológicas en la Universidad de California–Davis, teme que los legisladores estén siendo presionados con ideas sobre cómo la IA podría acabar con la humanidad, en lugar de abordar preocupaciones reales sobre cómo esta tecnología ya está afectando la vida de las personas de forma inmediata y tangible. La desigualdad ha sido desplazada por el riesgo existencial.

«El hype es una estrategia lucrativa para las empresas tecnológicas», dice Law. Una parte importante de ese hype es la idea de que lo que está ocurriendo es inevitable: si no lo construimos nosotros, lo hará otro. «Cuando algo se presenta como inevitable», afirma Law, «la gente no solo duda de si debería resistirse, sino también de si tiene la capacidad para hacerlo». Todos quedan atrapados.

El campo de distorsión de la AGI no se limita a la política tecnológica, advierte Milton Mueller, del Instituto Tecnológico de Georgia, especializado en regulación y políticas tecnológicas. La carrera hacia la AGI se compara con la carrera por la bomba atómica, dice. «Así que quien la consiga primero tendrá el poder absoluto sobre todos los demás. Es una idea peligrosa y disparatada que realmente distorsiona nuestra forma de enfocar la política exterior».

Hay incentivos empresariales para que compañías (y gobiernos) alimenten el mito de la AGI, señala Mueller, porque así pueden afirmar que serán los primeros en alcanzarla. Pero como nadie ha definido dónde está la línea de meta, el mito puede seguir girando mientras sea útil. O mientras los inversores estén dispuestos a comprarlo.

No es difícil imaginar cómo termina todo esto. No será ni utopía ni infierno—será OpenAI y sus competidores ganando muchísimo más dinero.

La gran conspiración de la AGI, conclusión

Y quizá esto nos devuelve al núcleo de la cuestión conspirativa—con un giro final en esta historia. Hasta ahora hemos ignorado uno de los elementos más populares del pensamiento conspirativo: la idea de que hay un grupo de figuras poderosas moviendo los hilos desde las sombras y que, al buscar la verdad, los creyentes pueden desenmascarar a esta élite oculta.

Es cierto que quienes «sienten» la AGI no están acusando públicamente a los Illuminati ni a una fuerza tipo WEF de impedir el futuro de la AGI o de ocultar sus secretos.

Pero ¿y si, en realidad, sí hay titiriteros en la sombra—y son precisamente quienes más han impulsado la conspiración de la AGI desde el principio? Los reyes de Silicon Valley están echando el resto para construir AGI con fines lucrativos. El mito de la AGI sirve a sus intereses más que a los de nadie.

Como nos dijo recientemente un alto ejecutivo de una empresa de inteligencia artificial, la AGI siempre tiene que estar a seis meses o un año de distancia. Si está más lejos, no se puede atraer talento de Jane Street; si está más cerca, ¿cuál sería el sentido?

Como lo plantea Vallor: «Si OpenAI dijera que está construyendo una máquina que va a hacer a las corporaciones aún más poderosas de lo que ya son, no conseguiría el respaldo público que necesita».

Recuerda: si creas un dios, te conviertes en uno. Krueger afirma que hay una línea de pensamiento en Silicon Valley según la cual construir inteligencia artificial es una forma de acumular enormes cantidades de poder. (Es uno de los ejes del manifiesto Situational Awareness, de Aschenbrenner). «Ya sabes, vamos a tener este poder divino y tendremos que decidir qué hacer con él», dice Krueger. «Muchos piensan que, si llegan primero, podrán básicamente dominar el mundo».

«Están poniendo muchísimo esfuerzo en vender su visión de un futuro con AGI, y les está funcionando bastante bien porque tienen muchísimo poder», añade.

Goertzel, por su parte, casi lamenta lo exitoso que ha sido este posible «cónclave». De hecho, empieza a echar de menos estar en los márgenes. «En mi generación, hacía falta mucha visión para querer trabajar en AGI, y había que ser muy terco», recuerda. «Ahora es casi lo que tu abuela te recomienda hacer para conseguir trabajo, en vez de estudiar empresariales».

«Es desconcertante que todo esto se haya aceptado tan ampliamente», dice. «Casi me dan ganas de trabajar en otra cosa que no esté haciendo todo el mundo». Lo dice medio en broma (creo): «Obviamente, terminar de desarrollar la AGI es más importante que satisfacer mi preferencia por estar en la frontera».

Pero sigo sin tener claro qué es exactamente eso que están «terminando de construir». ¿Qué significa para la tecnología en general que nos dejemos seducir por estos cuentos? En muchos sentidos, creo que toda la idea de la AGI se basa en una visión distorsionada de lo que deberíamos esperar de la tecnología, e incluso de lo que es la inteligencia en primer lugar. Si se reduce a lo esencial, el argumento a favor de la AGI parte de la premisa de que una tecnología—la inteligencia artificial—ha mejorado mucho y muy rápido, y seguirá mejorando. Pero si dejamos de lado las objeciones técnicas—¿y si no sigue mejorando?—nos queda la idea de que la inteligencia es una commodity que se puede aumentar con más datos, más compute o una red neuronal más grande. Y no lo es.

La inteligencia no es una cantidad que se pueda subir como el volumen. Las personas inteligentes pueden ser brillantes en un área y torpes en otras. Algunos premios Nobel son pésimos tocando el piano o cuidando de sus hijos. Y algunos muy inteligentes insisten en que la AGI llegará el año que viene.

Es difícil no preguntarse qué será lo próximo que nos atrapará.

Antes de terminar nuestra llamada, Goertzel me habló de un evento al que acababa de asistir en San Francisco sobre conciencia artificial y parapsicología: «ESP, precognición y esas cosas».

«Ahí es donde estaba la AGI hace 20 años», dijo. «Todo el mundo pensaba que era una locura total».