Este reportaje forma parte del paquete El fin del ‘hype’ de la IA de MIT Technology Review, una serie que busca reajustar las expectativas sobre qué es la IA, qué permite y hacia dónde nos dirigimos.

La desilusión era inevitable. Cuando OpenAI lanzó a finales de 2022 una aplicación web gratuita llamada ChatGPT, alteró el rumbo de toda una industria (y de varias economías mundiales). Millones de personas empezaron a conversar con sus ordenadores, y los ordenadores respondieron. Nos fascinó, y quisimos más.

Y lo obtuvimos. Las tecnológicas se apresuraron para no quedarse atrás, presentando productos rivales que se superaban con cada nueva versión: voz, imágenes, vídeo. En una carrera sin tregua, las compañías de IA han vendido cada lanzamiento como un gran avance, reforzando la creencia generalizada de que esta tecnología no dejaría de mejorar. Los defensores nos aseguraban que el progreso era exponencial. Publicaban gráficos para mostrar cuánto habíamos avanzado desde los modelos del año anterior: “¡Mira cómo sube la línea!”. La IA generativa parecía capaz de todo.

Pues bien, 2025 ha sido el año del ajuste de cuentas.

Para empezar, los directivos de las principales compañías de IA hicieron promesas que no podían cumplir. Nos aseguraron que la IA generativa sustituiría a los trabajadores de oficina, inauguraría una era de abundancia, impulsaría descubrimientos científicos y ayudaría a encontrar nuevas curas contra las enfermedades. El FOMO (miedo a quedarse fuera, de la expresión en ingles Fear of Missing Out) se extendió por las economías del mundo, al menos en el Norte Global, y llevó a los CEO a deshacer sus planes estratégicos para sumarse a la carrera.

Fue entonces cuando el brillo comenzó a apagarse. Aunque la tecnología se presentó como una herramienta universal capaz de renovar procesos obsoletos y reducir costes, varios estudios publicados este año sugieren que las empresas no están logrando que el supuesto polvo mágico de la IA funcione. Encuestas y análisis de organismos como la Oficina del Censo de EE UU y la Universidad de Stanford revelan que la adopción empresarial de herramientas de IA se está estancando. Y cuando se prueban, muchos proyectos se quedan atascados en la fase piloto. Sin una adopción masiva en la economía, no está claro cómo las grandes compañías de IA recuperarán las cifras astronómicas que ya han invertido en esta carrera.

Al mismo tiempo, las actualizaciones de la tecnología base han dejado de ser los saltos cualitativos que solían ser.

El ejemplo más sonado fue el accidentado lanzamiento de GPT-5 en agosto. OpenAI, la firma que encendió (y en gran medida sostuvo) el actual auge, se preparaba para presentar una nueva generación de su tecnología. Llevaba meses alimentando las expectativas. “Experto a nivel doctorado en cualquier cosa”, presumía el CEO Sam Altman. En otra ocasión, Altman publicó simplemente una imagen de la Estrella de la Muerte de Star Wars, que los seguidores de OpenAI interpretaron como símbolo de poder absoluto: ¡Próximamente! Las expectativas eran enormes.

Y, sin embargo, cuando llegó, GPT-5 pareció ser… ¿más de lo mismo? Lo que siguió fue el mayor cambio de percepción desde la aparición de ChatGPT hace tres años. “La era de los avances que rompen los límites ha terminado”, anunció Yannic Kilcher, investigador en IA y popular youtuber, en un vídeo publicado dos días después del lanzamiento: “La IA general no va a llegar. Parece que estamos en la era Samsung Galaxy de los LLM”.

Muchos (incluido yo) han hecho la analogía con los teléfonos. Durante una década, los smartphones fueron la tecnología de consumo más emocionante del mundo. Hoy, los nuevos productos de Apple o Samsung llegan con poca fanfarria. Mientras los superfans analizan mejoras mínimas, para la mayoría el iPhone de este año se parece demasiado al del año pasado. ¿Es ahí donde estamos con la IA generativa? ¿Y es un problema? Claro, los smartphones se normalizaron. Pero también cambiaron la forma en que funciona el mundo.

Conviene aclarar que los últimos años han estado llenos de momentos genuinamente “¡Wow!”, desde los saltos espectaculares en la calidad de los modelos de generación de vídeo hasta la capacidad de resolución de problemas de los llamados modelos de razonamiento, pasando por las victorias en competiciones internacionales de los últimos modelos de programación y matemáticas. Pero esta tecnología asombrosa apenas tiene unos años y, en muchos aspectos, sigue siendo experimental. Sus éxitos vienen acompañados de grandes matices.

Quizá debamos reajustar nuestras expectativas.

El gran reinicio

Seamos prudentes: el péndulo del hype al antihype puede oscilar demasiado. Sería precipitado descartar esta tecnología solo porque se ha vendido en exceso. La reacción instintiva cuando la IA no cumple lo prometido es decir que el progreso se ha estancado. Pero eso es no entender cómo funcionan la investigación y la innovación tecnológica. El avance siempre ha sido irregular. Hay caminos por encima, por debajo y alrededor de los muros.

Tomemos distancia del lanzamiento de GPT-5. Llegó justo después de una serie de modelos notables que OpenAI había presentado en los meses previos, incluidos o1 y o3 (modelos de razonamiento pioneros que introdujeron un nuevo paradigma en la industria) y Sora 2, que volvió a elevar el listón en generación de vídeo. Eso no suena a un choque contra el muro.

¡La IA es realmente buena! Basta mirar Nano Banana Pro, el nuevo modelo de generación de imágenes de Google DeepMind capaz de convertir un capítulo de un libro en una infografía, y mucho más. Está ahí, gratis, en tu teléfono.

Y, sin embargo, no podemos evitar preguntarnos: cuando desaparezca el factor sorpresa, ¿qué quedará? ¿Cómo veremos esta tecnología dentro de uno o cinco años? ¿Pensaremos que valió la pena el coste colosal, tanto financiero como ambiental?, tanto financiero como ambiental?

Con esa idea en mente, aquí van cuatro claves para entender el estado de la IA al cierre de 2025: el inicio de una corrección de expectativas muy necesaria.

01: Los LLM no lo son todo

En cierto modo, lo que necesita corregirse no es la IA en su conjunto, sino el hype en torno a los grandes modelos de lenguaje (LLM, por sus siglas en inglés). Hoy está claro que los LLM no son la puerta hacia la inteligencia artificial general (IAG) esa tecnología hipotética que algunos insisten en que algún día podrá realizar cualquier tarea cognitiva que hace un humano.

Incluso un evangelista de la IAG como Ilya Sutskever, científico jefe y cofundador de la startup Safe Superintelligence y exdirector científico y cofundador de OpenAI, subraya ahora las limitaciones de los LLM, una tecnología en cuya creación tuvo un papel decisivo. Los LLM son muy buenos aprendiendo a realizar tareas concretas, pero no parecen aprender los principios que hay detrás de esas tareas, dijo Sutskever en una entrevista con Dwarkesh Patel en noviembre.

Es la diferencia entre aprender a resolver mil problemas de álgebra y aprender a resolver cualquier problema de álgebra. “Lo que creo que es más fundamental es que estos modelos generalizan de forma dramáticamente peor que las personas”, afirmó Sutskever.

Es fácil imaginar que los LLM pueden hacerlo todo porque su uso del lenguaje resulta muy convincente. Sorprende lo bien que esta tecnología imita la forma en que escribimos y hablamos. Y estamos programados para ver inteligencia en cosas que se comportan de cierta manera, esté ahí o no. En otras palabras, hemos construido máquinas con comportamiento humano y no podemos resistir la tentación de ver una mente humana detrás.

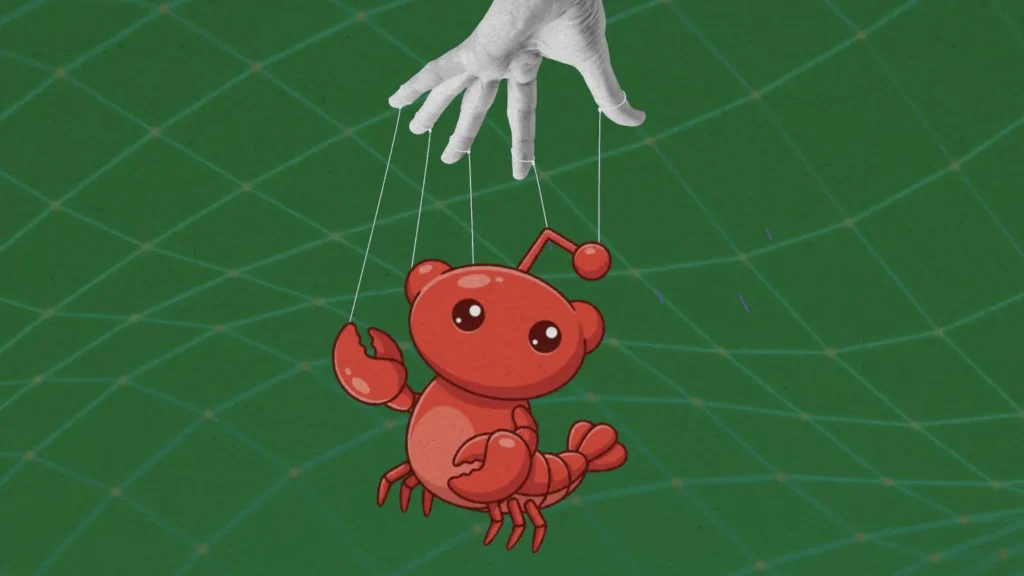

Es comprensible. Los LLM forman parte de la vida cotidiana desde hace apenas unos años. Pero en ese tiempo, el marketing ha explotado nuestra percepción incierta sobre lo que la tecnología puede hacer, inflando expectativas y acelerando el hype. A medida que convivamos con ella y la entendamos mejor, esas expectativas deberían volver a tierra.

02: La IA no es una solución rápida para todos tus problemas

En julio, investigadores del MIT publicaron un estudio que se convirtió en argumento central para los desilusionados. El titular era contundente: el 95% de las empresas que habían probado la IA no encontraron ningún valor en ella.

Otros estudios respaldaron esa idea. En noviembre, una investigación de Upwork (plataforma que conecta a empresas con trabajadores independientes) reveló que los agentes impulsados por los principales LLM de OpenAI, Google DeepMind y Anthropic no lograron completar muchas tareas básicas por sí solos.

Muy lejos queda la predicción de Altman. “Creemos que, en 2025, veremos los primeros agentes de IA incorporarse a la fuerza laboral y cambiar de forma sustancial la productividad de las empresas», escribió en su blog personal en enero.

Pero lo que se pasa por alto en el estudio del MIT es que la medida de éxito era bastante limitada. Ese 95% de fracaso corresponde a empresas que intentaron implementar sistemas de IA a medida y no lograron escalarlos más allá de la fase piloto en seis meses. No debería sorprender que muchos experimentos con tecnología experimental no funcionen de inmediato.

Además, esa cifra no incluye el uso de LLM por parte de empleados fuera de los proyectos oficiales. Los investigadores del MIT hallaron que alrededor del 90% de las compañías encuestadas tenían una especie de economía sumergida de IA, donde los trabajadores usaban cuentas personales de chatbots. Pero el valor de esa economía no se midió.

Cuando el estudio de Upwork analizó cómo funcionaban los agentes trabajando junto a personas que sabían lo que hacían, las tasas de éxito se dispararon. La conclusión parece ser que mucha gente está descubriendo por sí misma cómo la IA puede ayudarles en su trabajo.

Esto coincide con lo que señala Andrej Karpathy, investigador y divulgador (y creador del término vibe coding): los chatbots son mejores que el humano promedio en muchas cosas (dar consejos legales, corregir errores, resolver matemáticas de secundaria), pero no son mejores que un experto. Karpathy sugiere que esta puede ser la razón por la que los chatbots han triunfado entre consumidores individuales, ayudando a no expertos con tareas cotidianas, pero no han revolucionado la economía, lo que requeriría superar a empleados cualificados en sus puestos.

Eso puede cambiar. Por ahora, no te sorprendas de que la IA no haya tenido (todavía) el impacto laboral que prometían sus defensores. La IA no es una solución rápida y no puede sustituir a los humanos. Pero hay mucho en juego. Las formas en que la IA podría integrarse en los flujos de trabajo y procesos empresariales aún se están probando.

03: ¿Estamos en una burbuja? (Y si es así, ¿qué tipo de burbuja?)

Si la IA es una burbuja, ¿se parece a la de las hipotecas subprime de 2008 o a la burbuja de internet del año 2000? Porque hay una gran diferencia.

La burbuja de las subprime arrasó con buena parte de la economía, porque cuando estalló no dejó nada salvo deuda e inmuebles sobrevalorados. La burbuja puntocom acabó con muchas empresas y provocó ondas expansivas en todo el mundo, pero dejó tras de sí el internet incipiente: una red internacional de cables y un puñado de startups, como Google y Amazon, que se convirtieron en gigantes tecnológicos.

Claro que quizá estemos en una burbuja distinta. Al fin y al cabo, hoy no existe un modelo de negocio claro para los LLM. No sabemos cuál será la aplicación estrella, o si llegará a existir.

Y muchos economistas están preocupados por las cantidades sin precedentes que se están invirtiendo en la infraestructura necesaria para construir capacidad y atender la demanda prevista. ¿Qué pasa si esa demanda no se materializa? Súmale la extraña circularidad de muchos acuerdos (con Nvidia pagando a OpenAI para que pague a Nvidia, y así sucesivamente) y no sorprende que haya tantas opiniones sobre lo que viene.

Algunos inversores se muestran tranquilos. En una entrevista en noviembre con el pódcast Technology Business Programming Network, Glenn Hutchins, cofundador de Silver Lake Partners, una de las mayores firmas de capital privado, dio varias razones para no preocuparse. “Cada uno de estos centros de datos (casi todos) tiene una contraparte solvente que está contratada para asumir toda la producción para la que fueron diseñados”, dijo. En otras palabras, no se trata de “constrúyelo y vendrán”: los clientes ya están asegurados.

Y añadió que una de esas contrapartes solventes es Microsoft. “Microsoft tiene la mejor calificación crediticia del mundo”, afirmó Hutchins. “Si firmas un acuerdo con Microsoft para que se lleve la producción de tu centro de datos, Satya responde”.

Muchos CEO mirarán atrás a la burbuja puntocom para aprender sus lecciones. Aquí va una: las empresas que quebraron entonces no tenían dinero para resistir. Las que sobrevivieron al desplome prosperaron.

Con esa lección en mente, hoy las compañías de IA intentan abrirse camino en lo que podría ser (o no) una burbuja. Mantenerse en la carrera, no quedarse atrás. Aun así, es una apuesta desesperada.

Pero hay otra lección: empresas que parecen secundarias pueden convertirse en unicornios en tiempo récord. El caso de Synthesia lo demuestra. Esta firma desarrolla herramientas para generar avatares corporativos. Nathan Benaich, cofundador de la firma de capital riesgo Air Street Capital, admite que cuando oyó hablar de la compañía hace unos años, en plena alarma por los deepfakes, no tenía claro para qué servía su tecnología ni veía mercado para ella.

“No sabíamos quién pagaría por sincronización labial y clonación de voz”, reconoce. “Resulta que había mucha gente dispuesta a pagar por ello”. Hoy Synthesia cuenta con unos 55.000 clientes corporativos y factura alrededor de 150 millones de dólares al año. En octubre, la empresa fue valorada en 4.000 millones.

04: ChatGPT no fue el principio, y no será el final

ChatGPT fue la culminación de una década de avances en deep learning, la tecnología que sustenta toda la IA moderna. Las semillas del deep learning se plantaron en los años ochenta. El campo, en conjunto, se remonta al menos a la década de 1950. Si medimos el progreso con esa perspectiva, la IA generativa apenas está empezando.

Mientras tanto, la investigación vive un momento febril. Nunca antes hubo tantas propuestas de calidad en las principales conferencias de IA. Este año, los organizadores se vieron obligados a rechazar artículos ya aprobados por los revisores para controlar el volumen. (Al mismo tiempo, servidores de preprints como arXiv se han inundado de trabajos mediocres generados por IA).

“Estamos de vuelta en la era de la investigación”, dijo Sutskever en aquella entrevista con Dwarkesh, al hablar del cuello de botella actual con los LLM. No es un retroceso; es el inicio de algo nuevo.

“Siempre hay muchos hype beasts”, comenta Benaich. Pero cree que eso tiene un lado positivo: el hype atrae el dinero y el talento necesarios para lograr avances reales. “Hace apenas dos o tres años, quienes construían estos modelos eran básicamente frikis de la investigación que dieron con algo que funcionaba más o menos”, señala. “Ahora todo el que es bueno en tecnología está trabajando en esto”.

¿Hacia dónde vamos?

El hype implacable no ha venido solo de las empresas que buscan negocio para sus tecnologías carísimas. Hay una gran cohorte de personas (dentro y fuera del sector) que quiere creer en la promesa de máquinas que leen, escriben y piensan. Es un sueño salvaje con décadas de historia.

Pero el hype nunca fue sostenible, y eso es algo bueno. Ahora tenemos la oportunidad de reajustar expectativas y ver esta tecnología tal como es: evaluar sus capacidades reales, entender sus limitaciones y aprender a aplicarla de forma valiosa (y beneficiosa). “Todavía estamos intentando descubrir cómo invocar ciertos comportamientos desde esta caja negra de información y habilidades, increíblemente multidimensional”, afirma Benaich.

Esta corrección del hype tenía que llegar. Pero conviene saber que la IA no va a desaparecer. Ni siquiera entendemos del todo lo que hemos construido hasta ahora, y mucho menos lo que viene.