Un nuevo modelo de inteligencia artificial desarrollado por la compañía china DeepSeek podría marcar un antes y un después en la capacidad de las máquinas para «recordar».

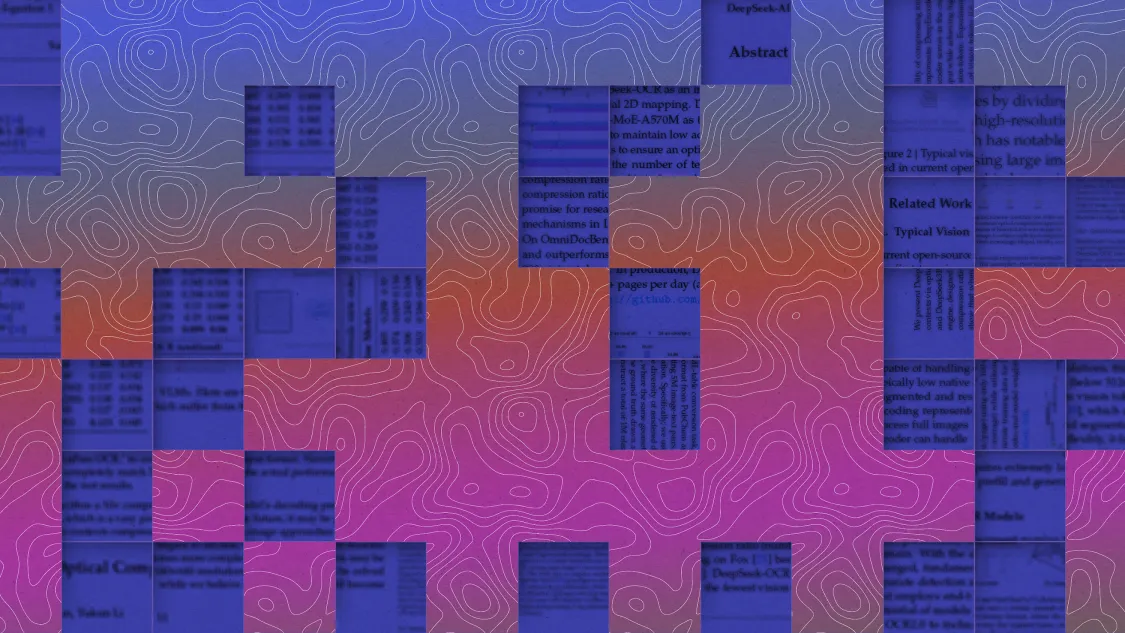

Presentado la semana pasada, el sistema se basa en reconocimiento óptico de caracteres (OCR, por sus siglas en inglés), una tecnología que permite extraer texto de imágenes y convertirlo en palabras legibles por máquinas. Es la misma técnica que utilizan las aplicaciones de escaneo, los traductores de texto en fotos y muchas herramientas de accesibilidad.

Aunque el campo del OCR ya está bastante consolidado y cuenta con sistemas de alto rendimiento, según el artículo publicado por DeepSeek y algunas primeras reseñas, el nuevo modelo se sitúa al nivel de los mejores en las principales métricas de evaluación.

Sin embargo, los investigadores señalan que la verdadera innovación del modelo reside en cómo procesa la información, especialmente en la forma en que almacena y recupera recuerdos. Mejorar la capacidad de «memoria» de los modelos de IA podría reducir la potencia de computación necesaria para su funcionamiento, lo que contribuiría a mitigar la creciente huella de carbono de esta tecnología.

Actualmente, la mayoría de los modelos de lenguaje descomponen el texto en miles de pequeñas unidades llamadas tokens. Estas unidades permiten que los sistemas comprendan el contenido, pero a medida que las conversaciones se alargan, almacenar y procesar estos tokens se vuelve costoso. En interacciones prolongadas, esto puede provocar que la IA olvide información previamente proporcionada o la confunda, un fenómeno que algunos denominan »context rot» o «pérdida de contexto» en español.

Las nuevas técnicas desarrolladas por DeepSeek, y descritas en su último artículo, podrían ofrecer una solución. En lugar de almacenar palabras como tokens, el sistema convierte la información escrita en imágenes, como si tomara una fotografía de las páginas de un libro. Según los investigadores, esto permite conservar casi la misma cantidad de información utilizando muchos menos tokens.

El modelo OCR sirve como banco de pruebas para estas nuevas técnicas que permiten empaquetar más información en los modelos de IA de forma más eficiente.

Además de emplear tokens visuales en lugar de únicamente textuales, el sistema se basa en un tipo de compresión por niveles que recuerda al funcionamiento de la memoria humana: los contenidos más antiguos o menos relevantes se almacenan en una forma ligeramente borrosa para ahorrar espacio. Aun así, los autores del artículo sostienen que esta información comprimida sigue siendo accesible en segundo plano, sin comprometer la eficiencia del sistema.

Durante años, los tokens textuales han sido el estándar en los sistemas de IA. El uso de tokens visuales es poco convencional, y por eso el modelo de DeepSeek está captando rápidamente la atención de la comunidad científica. Andrej Karpathy, exdirector de IA en Tesla y miembro fundador de OpenAI, elogió el artículo en X, afirmando que las imágenes podrían ser mejores que el texto como indicación para los modelos de lenguaje. Los tokens textuales, escribió, podrían ser «ineficientes o simplemente terribles como input«.

Manling Li, profesora adjunta de informática en la Universidad Northwestern (Evanston, EE UU), considera que el artículo ofrece un nuevo marco para abordar los desafíos actuales en la memoria de la IA. «Aunque la idea de usar tokens basados en imágenes para almacenar contexto no es completamente nueva, este es el primer estudio que lleva el concepto tan lejos y demuestra que podría funcionar», afirma Li.

Zihan Wang, doctorando en la misma universidad, cree que esta técnica podría abrir nuevas posibilidades en la investigación y aplicación de la IA, especialmente en el desarrollo de agentes más útiles. El doctorando piensa que, dado que las conversaciones con la IA son continuas, este enfoque podría ayudar a los modelos a recordar más y asistir mejor a los usuarios.

La técnica también puede utilizarse para generar más datos de entrenamiento. Actualmente, los desarrolladores de modelos se están enfrentando a una escasez crítica de texto de calidad para entrenar sus sistemas. Pero según el artículo de DeepSeek, su sistema OCR puede generar más de 200.000 páginas de datos al día utilizando una sola GPU.

No obstante, tanto el modelo como el artículo representan tan solo una primera exploración del uso de tokens visuales en lugar de textuales para la memoria de la IA. Li espera que en el futuro estos tokens se apliquen no solo al almacenamiento, sino también al razonamiento. El próximo paso, según dice, debería ser explorar cómo hacer que la memoria de la IA se desvanezca de forma más dinámica, como cuando recordamos un momento que nos cambió la vida hace años, pero olvidamos lo que comimos ayer. Actualmente, incluso con los métodos de DeepSeek, la IA tiende a recordar de una manera lineal: lo más reciente, pero no necesariamente lo más importante.

A pesar de su insistencia en mantener un perfil bajo, DeepSeek, con sede en Hangzhou, China, se ha labrado una reputación por estar a la vanguardia de la investigación en IA. A comienzos de este año, sorprendió a la industria con el lanzamiento de DeepSeek-R1, un modelo de razonamiento open source que igualó el rendimiento de los sistemas occidentales más avanzados, pero utilizando muchos menos recursos computacionales.