Durante los últimos dos años, OpenAI ha parecido una marca de un solo hombre. Con su estilo mediático y su brillante capacidad para recaudar fondos, el director ejecutivo Sam Altman eclipsa a todos los demás grandes nombres de la empresa. Incluso su fallida destitución terminó con él de vuelta en la cima, y más famoso que nunca. Pero si miramos más allá del carismático líder, podemos hacernos una idea más clara de hacia dónde se dirige esta empresa. Al fin y al cabo, Altman no es quien está desarrollando la tecnología en la que se basa su reputación.

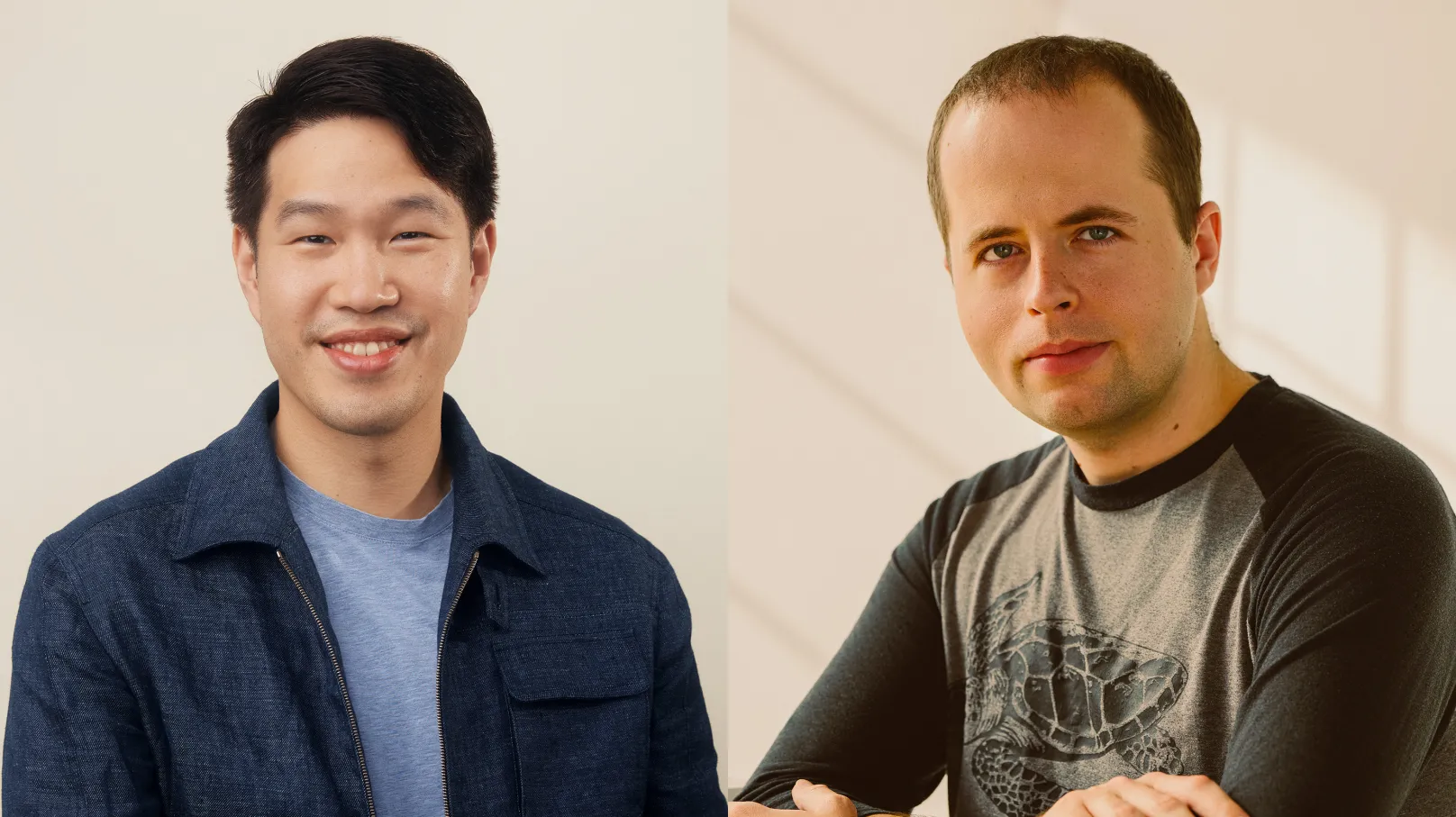

Esa responsabilidad recae en los dos directores de investigación de OpenAI: el director de investigación Mark Chen y el científico jefe Jakub Pachocki. Entre ellos, comparten la función de garantizar que OpenAI se mantenga un paso por delante de rivales tan poderosos como Google.

Me senté con Chen y Pachocki para mantener una conversación exclusiva durante un reciente viaje que ambos realizaron a Londres (Reino Unido), donde OpenAI estableció su primera oficina internacional en 2023. Hablamos sobre cómo gestionan la tensión inherente entre la investigación y el producto. También hablamos sobre por qué creen que la codificación y las matemáticas son la clave para crear modelos más capaces y versátiles; qué quieren decir realmente cuando hablan de AGI; y qué pasó con el equipo de superalineación de OpenAI, creado por el cofundador y antiguo científico jefe de la empresa, Ilya Sutskever, para evitar que una hipotética superinteligencia se revelara, y que se disolvió poco después de que él dimitiera.

En particular, quería hacerme una idea de por dónde van las cosas en vísperas del lanzamiento del producto más importante de OpenAI en meses: GPT-5.

Se ha informado de que el modelo de próxima generación de la empresa se lanzará en agosto. La versión oficial de OpenAI, bueno, la de Altman es que GPT-5 se lanzará pronto. Hay mucha expectación. Los avances que OpenAI logró con GPT-3 y luego con GPT-4 elevaron el listón de lo que se creía posible con esta tecnología. Sin embargo, los retrasos en el lanzamiento de GPT-5 han alimentado los rumores de que OpenAI ha tenido dificultades para crear un modelo que cumpla con sus propias expectativas, por no hablar de las de los demás.

Pero gestionar las expectativas es parte del trabajo de una empresa que durante los últimos años ha marcado la agenda del sector. Y Chen y Pachocki marcan la agenda dentro de OpenAI.

Doble cima

La oficina principal de la empresa en Londres (Reino Unido) se encuentra en St James’s Park, a unos cientos de metros al este del Palacio de Buckingham. Pero me reuní con Chen y Pachocki en una sala de conferencias de un espacio de coworking cerca de King’s Cross, que OpenAI mantiene como una especie de pie a tierra en el corazón del barrio tecnológico de Londres (Google DeepMind y Meta están a solo un o a la vuelta de la esquina). El director de Comunicación de investigación de OpenAI, Laurance Fauconnet, estaba sentado con un ordenador portátil abierto al final de la mesa.

Chen, que vestía un polo granate, tiene un aspecto pulcro, casi preppy. Está acostumbrado a los medios de comunicación y se siente cómodo hablando con los periodistas. (Es él quien coquetea con un chatbot en el vídeo «Introducing GPT-4o»). Pachocki, con una camiseta negra con el logotipo de un elefante, tiene más el aspecto de un hacker de película. Mira mucho sus manos cuando habla.

La pareja forma un tándem más compacto de lo que parece a primera vista. Pachocki resumió sus funciones. Chen da forma y dirige los equipos de investigación, dijo. «Yo soy responsable de establecer la hoja de ruta de la investigación y nuestra visión técnica a largo plazo».

«Los roles son fluíos «, añade Chen. «Los dos somos investigadores, tiramos de los hilos técnicos. Lo que vemos que podemos tirar y arreglar, eso es lo que hacemos».

Chen se incorporó a la empresa en 2018, tras trabajar como operador cuantitativo en la firma de Wall Street Jane Street Capital, donde desarrolló modelos de aprendizaje automático para el comercio de futuros. En OpenAI, encabezó la creación de DALL-E, el revolucionario modelo de generación de imágenes de la empresa. A continuación, trabajó en la incorporación del reconocimiento de imágenes a GPT-4 y dirigió el desarrollo de Codex, el modelo de codificación generativa que impulsa GitHub Copilot.

Pachocki dejó su carrera académica en informática teórica para unirse a OpenAI en 2017 y sustituyó a Sutskever como científico jefe en 2024. Junto con Sutskever, es uno de los principales arquitectos de los denominados modelos de razonamiento de OpenAI, especialmente o1 y o3, diseñados para abordar tareas complejas en ciencia, matemáticas y codificación.

Cuando nos reunimos, estaban muy animados, recién salidos de la euforia de dos nuevas victorias consecutivas para la tecnología de su empresa.

El 16 de julio, uno de los grandes modelos lingüísticos de OpenAI quedó en segundo lugar en la final del AtCoder World Tour, una de las competiciones de programación más duras del mundo. El 19 de julio, OpenAI anunció que uno de sus modelos había obtenido resultados de medalla de oro en la Olimpiada Internacional de Matemáticas de 2025, uno de los concursos de matemáticas más prestigiosos del mundo.

El resultado matemático fue noticia, no solo por el notable logro de OpenAI, sino porque su rival Google DeepMind reveló dos días después que uno de sus modelos había obtenido la misma puntuación en la misma competición. Google DeepMind había seguido las reglas de la competición y había esperado a que los organizadores verificaran los resultados antes de hacer ningún anuncio; OpenAI, en cambio, había corregido sus propias respuestas.

Para Chen y Pachocki, el resultado habla por sí solo. De todos modos, lo que más les emociona es la victoria en programación. «Creo que se subestima bastante», me dijo Chen. Una medalla de oro en la Olimpiada Internacional de Matemáticas te sitúa entre los 20 y 50 mejores competidores, explicó. Pero en el concurso AtCoder, el modelo de OpenAI quedó entre los dos primeros: «Alcanzar un nivel de rendimiento humano realmente diferente es algo sin precedentes».

¡Adelante, adelante, adelante!

A la gente de OpenAI todavía le gusta decir que trabaja en un laboratorio de investigación. Pero la empresa es muy diferente de lo que era antes del lanzamiento de ChatGPT hace tres años. La empresa compite ahora con las empresas tecnológicas más grandes y ricas del mundo y está valorada en 300.000 millones de dólares (unos 276.000 millones de euros). La investigación innovadora y las demostraciones llamativas ya no son suficientes. Necesita lanzar productos y ponerlos en manos de la gente, y vaya si lo hace.

OpenAI ha mantenido una racha de nuevos lanzamientos: ha publicado importantes actualizaciones de su serie GPT-4, ha lanzado una serie de modelos generativos de imágenes y vídeos, y ha introducido la posibilidad de hablar con ChatGPT con la voz. Hace seis meses, inició una nueva ola de los denominados modelos de razonamiento con el lanzamiento de o1, al que pronto siguió o3. Y la semana pasada presentó al público su agente Operator, que utiliza un navegador. Ahora afirma que más de 400 millones de personas utilizan sus productos cada semana y envían 2.500 millones de solicitudes al día.

La nueva directora general de aplicaciones de OpenAI, Fidji Simo, tiene previsto mantener el impulso. En un memorándum dirigido a la empresa, dijo a los empleados que está deseando «ayudar a que las tecnologías de OpenAI lleguen a más personas en todo el mundo», donde «abrirán más oportunidades para más personas que cualquier otra tecnología en la historia«. Es de esperar que sigan apareciendo nuevos productos.

Le pregunté cómo OpenAI compagina la investigación abierta y el desarrollo de productos. «Es algo en lo que llevamos pensando mucho tiempo, desde mucho antes de ChatGPT», respondió Pachocki. «Si realmente nos tomamos en serio la creación de inteligencia artificial general, está claro que habrá mucho que hacer con esta tecnología a lo largo del camino, muchos caminos que se pueden tomar y que darán lugar a grandes productos». En otras palabras, hay que seguir sacudiendo el árbol y cosechar lo que se pueda.

Un tema de conversación que surge con la gente de OpenAI es que sacar al mundo modelos experimentales era una parte necesaria de la investigación. El objetivo era que la gente se diera cuenta de lo buena que se había vuelto esta tecnología. «Queremos educar a la gente sobre lo que se avecina para poder participar en lo que será un debate social muy difícil», me dijo Altman en 2022. Los creadores de esta extraña nueva tecnología también sentían curiosidad por saber para qué podría servir: OpenAI estaba ansiosa por ponerla en manos de la gente para ver qué harían con ella.

¿Sigue siendo así? Respondieron al unísono. «¡Sí! «, dijo Chen. «Hasta cierto punto», dijo Pachocki. Chen se rio: «No, continúa».

«No diría que la investigación se repite en el producto», dijo Pachocki. «Pero ahora que los modelos están al límite de las capacidades que pueden medirse con los parámetros clásicos y muchos de los retos a los que nos hemos enfrentado durante mucho tiempo están empezando a desaparecer, nos encontramos en un punto en el que lo que realmente importa es lo que los modelos pueden hacer en el mundo real».

Como enfrentarse a humanos en concursos de programación. La persona que venció al modelo de OpenAI en el concurso AtCoder de este año, celebrado en Japón, fue un programador llamado Przemysław Dębiak, también conocido como Psyho. El concurso consistía en una maratón de resolución de acertijos en la que los participantes tenían 10 horas para encontrar la forma más eficiente de resolver un complejo problema de programación. Tras su victoria, Psyho publicó en X: «Estoy completamente agotado… Apenas estoy vivo».

Chen y Pachocki tienen fuertes vínculos con el mundo de la programación competitiva. Ambos han participado en concursos internacionales de programación en el pasado y Chen es entrenador del equipo de la Olimpiada Informática de Estados Unidos. Les pregunté si ese entusiasmo personal por la programación competitiva influye en su percepción de la importancia de que un modelo funcione bien en un reto de este tipo.

Ambos se rieron. «Por supuesto», dijo Pachocki. «Psyho es una leyenda. Ha sido el competidor número uno durante muchos años. Además, es amigo mío, solíamos competir juntos en estos concursos». Dębiak también trabajó con Pachocki en OpenAI.

Cuando Pachocki competía en concursos de programación, prefería aquellos que se centraban en problemas más cortos con soluciones concretas. Pero a Dębiak le gustaban los problemas más largos y abiertos, sin una respuesta correcta obvia.

«Solía burlarse de mí diciendo que el tipo de concurso que me gustaba se automatizaría mucho antes que los que le gustaban a él», recuerda Pachocki. «Así que me tomé muy en serio el rendimiento de este modelo en la última competición».

Pachocki me contó que se quedó pegado a la retransmisión en directo desde Tokio (Japón) hasta altas horas de la madrugada, viendo cómo su modelo quedaba en segundo lugar: «Psyho resiste por ahora».

«Llevamos un tiempo haciendo un seguimiento del rendimiento de los LLM en concursos de programación», explica Chen. «Hemos visto cómo han ido mejorando hasta superar mi nivel y el de Jakub. Es algo parecido a cuando Lee Sedol jugaba al Go».

Lee es el maestro de Go que perdió una serie de partidas contra AlphaGo, el modelo de juego de DeepMind, en 2016. Los resultados sorprendieron a la comunidad internacional de Go y llevaron a Lee a abandonar el juego profesional. El año pasado declaró al New York Times: «Perder contra la IA, en cierto sentido, significó que todo mi mundo se derrumbaba… Ya no pude disfrutar del juego». Sin embargo, a diferencia de Lee, Chen y Pachocki están encantados de haber sido superados.

Sin embargo, ¿por qué debería importarnos al resto estas victorias en un ámbito tan específico? Está claro que esta tecnología, diseñada para imitar y, en última instancia, sustituir a la inteligencia humana, está siendo desarrollada por personas cuya idea de la inteligencia máxima es destacar en un concurso de matemáticas o defenderse frente a un programador legendario. ¿Es un problema que esta visión de la inteligencia se incline hacia el extremo matemático y analítico de la escala?

«Quiero decir, creo que tienes razón en que, egoístamente, queremos crear modelos que nos aceleren«, me dijo Chen. «Lo vemos como un factor muy rápido para progresar».

El argumento que esgrimen investigadores como Chen y Pachocki es que las matemáticas y la programación son la base de una forma de inteligencia mucho más general, capaz de resolver una amplia gama de problemas de formas que quizá ni se nos habrían ocurrido. «Estamos hablando de programación y matemáticas«, dijo Pachocki. «Pero en realidad se trata de creatividad, de generar ideas novedosas, de conectar ideas de diferentes ámbitos«.

Fíjese en las dos competiciones recientes: «En ambos casos, había problemas que requerían un pensamiento muy difícil y fuera de lo común. Psyho pasó la mitad de la competición de programación pensando y luego se le ocurrió una solución realmente novedosa y muy diferente de todo lo que había visto nuestro modelo».

«Esto es realmente lo que buscamos», continuó Pachocki. «¿Cómo conseguimos que los modelos descubran este tipo de conocimientos novedosos? ¿Cómo avanzamos realmente en nuestro conocimiento? Creo que ya son capaces de hacerlo de forma limitada. Pero creo que esta tecnología tiene el potencial de acelerar realmente el progreso científico«.

Volví a la pregunta de si el enfoque en las matemáticas y la programación era un problema, admitiendo que tal vez esté bien si lo que estamos construyendo son herramientas que nos ayuden a hacer ciencia. No necesariamente queremos que los grandes modelos lingüísticos sustituyan a los políticos y tengan habilidades sociales, sugerí.

Chen puso cara de extrañeza y miró al techo: «¿Por qué no? «.

Lo que falta

OpenAI se fundó con un nivel de arrogancia que destacaba incluso para los estándares de Silicon Valley, alardeando de su objetivo de crear una IGA cuando hablar de esto todavía parecía una locura. OpenAI sigue tan entusiasmada como siempre con la IGA y ha hecho más que la mayoría para convertirla en una preocupación generalizada que mueve miles de millones de dólares. Sin embargo, aún no se ha conseguido. Pregunté a Chen y Pachocki qué creían que faltaba.

«Creo que la forma de imaginar el futuro es estudiar en profundidad la tecnología que vemos hoy en día», dijo Pachocki. «Desde el principio, OpenAI ha considerado el aprendizaje profundo por como una tecnología muy misteriosa y claramente muy potente, con mucho potencial. Hemos intentado comprender sus limitaciones. ¿Qué puede hacer? ¿Qué no puede hacer? «.

Según Chen, en la vanguardia actual se encuentran los modelos de razonamiento, que descomponen los problemas en pasos más pequeños y manejables, pero incluso estos tienen límites: «Sabes, tienes estos modelos que saben muchas cosas, pero no pueden encadenar ese conocimiento. ¿Por qué? ¿Por qué no pueden hacerlo de la misma manera que los humanos?».

OpenAI está dedicando todos sus recursos a responder a esa pregunta.

«Probablemente todavía estemos en los inicios de este paradigma del razonamiento«, me dijo Pachocki. «En realidad, estamos pensando en cómo conseguir que estos modelos aprendan y exploren a largo plazo y que realmente aporten ideas muy nuevas«.

Chen insistió en este punto: «Realmente no considero que el razonamiento esté acabado. Definitivamente, no lo hemos resuelto. Hay que leer mucho texto para obtener una aproximación de lo que saben los humanos».

OpenAI no revela qué datos utiliza para entrenar sus modelos ni da detalles sobre su tamaño y forma, solo que está trabajando duro para que todas las etapas del proceso de desarrollo sean más eficientes.

Esos esfuerzos les hacen confiar en que las llamadas leyes de escala, que sugieren que los modelos seguirán mejorando cuanto más se les exija, no dan señales de romperse.

«No creo que haya pruebas de que las leyes de escalado hayan dejado de funcionar en ningún sentido», insistió Chen. «Siempre ha habido cuellos de botella, ¿no? A veces tienen que ver con la forma en que se construyen los modelos. A veces tienen que ver con los datos. Pero, en el fondo, se trata simplemente de encontrar la investigación que permita superar el cuello de botella actual».

La fe en el progreso es inquebrantable. Mencioné algo que Pachocki había dicho sobre la IGA en una entrevista con Nature en mayo: «Cuando me incorporé a OpenAI en 2017, todavía era uno de los más escépticos de la empresa». Parecía dudoso.

«No estoy seguro de que fuera escéptico sobre el concepto«, dijo. «Pero creo que lo era… «. Hizo una pausa y miró sus manos sobre la mesa frente a él. «Cuando me incorporé a OpenAI, esperaba que los plazos fueran más largos para llegar al punto en el que nos encontramos ahora».

Fíjese en las dos competiciones recientes: «En ambos casos, hubo problemas que requirieron un pensamiento muy duro y fuera de lo común. Psyho pasó la mitad de la competición de programación pensando y luego se le ocurrió una solución realmente novedosa y bastante diferente de todo lo que nuestro modelo había analizado».

«Esto es realmente lo que buscamos», continuó Pachocki. «¿Cómo conseguimos que los modelos descubran este tipo de conocimientos novedosos? ¿Cómo avanzamos realmente en nuestro conocimiento? Creo que ya son capaces de hacerlo de forma limitada. Pero creo que esta tecnología tiene el potencial de acelerar realmente el progreso científico».

Volví a la pregunta de si el enfoque en las matemáticas y la programación era un problema, admitiendo que tal vez esté bien si lo que estamos construyendo son herramientas que nos ayuden a hacer ciencia. No necesariamente queremos que los grandes modelos lingüísticos sustituyan a los políticos y tengan habilidades sociales, sugerí.

Chen puso cara de extrañeza y miró al techo: «¿Por qué no? «.