Ha sido un gran año para la generación de vídeos. En los últimos nueve meses, OpenAI hizo público Sora, Google DeepMind lanzó Veo 3 y la startup de vídeo Runway lanzó Gen-4. Todos ellos pueden producir videoclips que son (casi) imposibles de distinguir de las imágenes reales filmadas o de la animación CGI. Este año también Netflix estrenó un efecto visual de IA en su serie The Eternaut, la primera vez que se utiliza la generación de vídeo para hacer televisión para el gran público.

Por supuesto, los clips que se ven en los vídeos de demostración están cuidadosamente seleccionados para mostrar los modelos de una empresa en su máxima expresión. Pero con la tecnología en manos de más usuarios que nunca —Sora y Veo 3 están disponibles en las aplicaciones ChatGPT y Gemini para los suscriptores de pago—, incluso el cineasta más ocasional puede ahora crear algo extraordinario.

La desventaja es que los creadores compiten con la basura de la IA, y las redes sociales se están llenando de noticias falsas. La generación de vídeo también consume una gran cantidad de energía, muchas veces más que la generación de texto o imágenes.

Con los vídeos generados por IA por todas partes, dediquemos un momento a hablar de la tecnología que los hace funcionar.

¿Cómo se genera un vídeo?

Supongamos que eres un usuario ocasional. Actualmente hay una serie de herramientas de alta gama que permiten a los creadores de vídeos profesionales insertar modelos de generación de vídeos en sus flujos de trabajo. Pero la mayoría de la gente utilizará esta tecnología en una aplicación o a través de un sitio web. Ya sabes cómo funciona: «Hola, Gemini, hazme un vídeo de un unicornio comiendo espaguetis. Ahora haz que su cuerno despegue como un cohete». El resultado puede ser impredecible y, por lo general, tendrás que pedirle al modelo que repita la operación una o diez veces antes de obtener más o menos lo que querías.

Entonces, ¿qué ocurre entre bastidores? ¿Por qué es impredecible y por qué consume tanta energía? La última ola de modelos de generación de vídeo se conoce como transformadores de difusión latente. Sí, es un nombre bastante complicado. Analicemos cada parte por separado, empezando por la difusión.

¿Qué es un modelo de difusión?

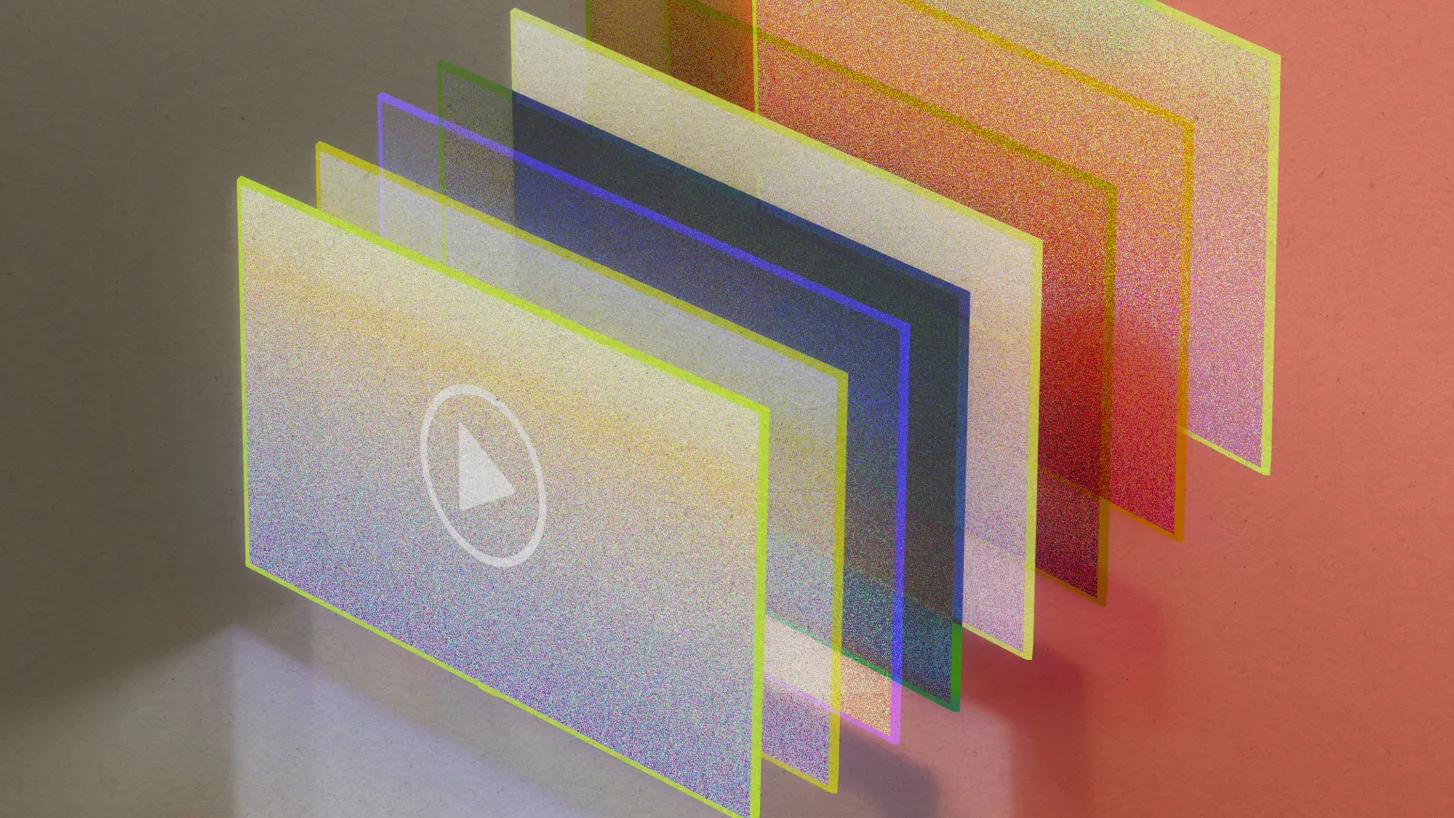

Imagina que coges una imagen y le añades una salpicadura aleatoria de píxeles. Coge esa imagen salpicada de píxeles y vuelve a salpicarla una y otra vez. Hazlo suficientes veces y habrás convertido la imagen inicial en un caos aleatorio de píxeles, como la estática de un televisor antiguo.

Un modelo de difusión es una red neuronal entrenada para invertir ese proceso, convirtiendo el ruido estático aleatorio en imágenes. Durante el entrenamiento, se le muestran millones de imágenes en diversas etapas de pixelación. Aprende cómo cambian esas imágenes cada vez que se les añaden nuevos píxeles y, por lo tanto, cómo deshacer esos cambios.

El resultado es que, cuando se le pide a un modelo de difusión que genere una imagen, este comienza con un conjunto aleatorio de píxeles y, paso a paso, convierte ese conjunto en una imagen más o menos similar a las imágenes de su conjunto de entrenamiento.

Pero usted no quiere cualquier imagen, sino la imagen que ha especificado, normalmente con una indicación de texto. Por eso, el modelo de difusión se combina con un segundo modelo, como un modelo de lenguaje grande (LLM) entrenado para emparejar imágenes con descripciones de texto, que guía cada paso del proceso de limpieza, empujando al modelo de difusión hacia imágenes que el modelo de lenguaje grande considera una buena coincidencia con la indicación.

Un apunte: este LLM no saca de la nada los vínculos entre el texto y las imágenes. La mayoría de los modelos actuales de texto a imagen y de texto a vídeo se entrenan con grandes conjuntos de datos que contienen miles de millones de pares de texto e imágenes o texto y vídeo extraídos de Internet (una práctica que disgusta mucho a muchos creadores). Esto significa que lo que se obtiene de estos modelos es una destilación del mundo tal y como se representa en Internet, distorsionado por los prejuicios (y la pornografía).

Es más fácil imaginar los modelos de difusión trabajando con imágenes. Pero la técnica se puede utilizar con muchos tipos de datos, incluidos el audio y el vídeo. Para generar clips de película, un modelo de difusión e e debe limpiar secuencias de imágenes (los fotogramas consecutivos de un vídeo) en lugar de una sola imagen.

¿Qué es un modelo de difusión latente?

Todo esto requiere una enorme cantidad de computación (es decir, energía). Por eso, la mayoría de los modelos de difusión utilizados para la generación de vídeo utilizan una técnica llamada difusión latente. En lugar de procesar datos sin procesar —los millones de píxeles de cada fotograma de vídeo—, el modelo funciona en lo que se conoce como espacio latente, en el que los fotogramas de vídeo (y el texto de entrada) se comprimen en un código matemático que captura solo las características esenciales de los datos y descarta el resto.

Algo similar ocurre cada vez que se transmite un vídeo por Internet: el vídeo se envía desde un servidor a la pantalla en un formato comprimido para que llegue más rápido y, cuando llega, el ordenador o el televisor lo convierten de nuevo en un vídeo que se puede ver.

Así pues, el último paso consiste en descomprimir el resultado del proceso de difusión latente. Una vez que los fotogramas comprimidos de estática aleatoria se han convertido en los fotogramas comprimidos de un vídeo que la guía LLM considera adecuado para la indicación del usuario, el vídeo comprimido se convierte en algo que se puede ver.

Con la difusión latente, el proceso de difusión funciona más o menos como lo haría para una imagen. La diferencia es que los fotogramas de vídeo pixelados son ahora codificaciones matemáticas de esos fotogramas en lugar de los propios fotogramas. Esto hace que la difusión latente sea mucho más eficiente que un modelo de difusión típico. (Aun así, la generación de vídeo sigue consumiendo más energía que la generación de imágenes o texto. Simplemente, implica una cantidad de cálculo impresionante).

¿Qué es un transformador de difusión latente?

¿Sigues conmigo? Hay una pieza más en el rompecabezas: cómo asegurarse de que el proceso de difusión produzca una secuencia de fotogramas que sean coherentes, manteniendo los objetos, la iluminación, etc., de un fotograma a otro. OpenAI lo consiguió con Sora combinando su modelo de difusión con otro tipo de modelo llamado transformador. Esto se ha convertido ahora en un estándar en el vídeo generativo.

Los transformadores son excelentes para procesar secuencias largas de datos, como palabras. Eso los ha convertido en el ingrediente especial de los grandes modelos de lenguaje, como el GPT-5 de OpenAI y el Gemini de Google DeepMind, que pueden generar secuencias largas de palabras con sentido, manteniendo la coherencia a lo largo de muchas docenas de frases.

Pero los vídeos no están hechos de palabras. En su lugar, los vídeos se cortan en trozos que pueden tratarse como si lo fueran. El enfoque que ideó OpenAI fue dividir los vídeos tanto en el espacio como en el tiempo. «Es como si tuvieras una pila con todos los fotogramas del vídeo y cortaras pequeños cubos de ella», explica Tim Brooks, investigador principal de Sora.

El uso de transformadores junto con modelos de difusión aporta varias ventajas. Dado que están diseñados para procesar secuencias de datos, los transformadores también ayudan al modelo de difusión a mantener la coherencia entre los fotogramas a medida que los genera. Esto permite producir vídeos en los que los objetos no aparecen y desaparecen, por ejemplo.

Y como los vídeos se cortan en cubos, su tamaño y orientación no importan. Esto significa que la última generación de modelos de generación de vídeo puede entrenarse con una amplia gama de vídeos de ejemplo, desde clips cortos verticales grabados con un teléfono hasta películas cinematográficas en pantalla panorámica. La mayor variedad de datos de entrenamiento ha mejorado mucho la generación de vídeo con respecto a hace solo dos años. También significa que ahora se puede pedir a los modelos de generación de vídeo que produzcan vídeos en una variedad de formatos.

¿Qué hay del audio?

Un gran avance de Veo 3 es que genera vídeo con audio, desde diálogos sincronizados con los labios hasta efectos de sonido y ruido de fondo. Es una novedad en los modelos de generación de vídeo. Como dijo el director ejecutivo de Google DeepMind, Demis Hassabis, en la Google I/O de este año: «Estamos saliendo de la era silenciosa de la generación de vídeo».

El reto consistía en encontrar una forma de alinear los datos de vídeo y audio para que el proceso de difusión funcionara en ambos al mismo tiempo. El gran avance de Google DeepMind fue una nueva forma de comprimir el audio y el vídeo en un único dato dentro del modelo de difusión. Cuando Veo 3 genera un vídeo, su modelo de difusión produce el audio y el vídeo juntos en un proceso sincronizado, lo que garantiza que el sonido y las imágenes estén sincronizados.

Usted ha dicho que los modelos de difusión pueden generar diferentes tipos de datos. ¿Funcionan así también los LLM?

No, o al menos no todavía. Los modelos de difusión se utilizan con mayor frecuencia para generar imágenes, vídeo y audio. Los modelos de lenguaje grandes, que generan texto (incluido código informático), se construyen utilizando transformadores. Pero las líneas se están difuminando. Hemos visto cómo los transformadores se combinan ahora con modelos de difusión para generar vídeos. Y este verano, Google DeepMind reveló que estaba construyendo un modelo de lenguaje grande experimental que utilizaba un modelo de difusión en lugar de un transformador para generar texto.

Aquí es donde las cosas empiezan a complicarse: aunque la generación de vídeo (que utiliza modelos de difusión) consume mucha energía, los modelos de difusión en sí mismos son, de hecho, más eficientes que los transformadores. Por lo tanto, al utilizar un modelo de difusión en lugar de un transformador para generar texto, el nuevo LLM de Google DeepMind podría ser mucho más eficiente que los LLM existentes. ¡Esperamos ver más modelos de difusión en un futuro próximo!