Google DeepMind ha permitido sintetizar voces que suenan casi como humanas, en distintos tonos e idiomas. Aunque la potencia computacional necesaria es tan grande que no se aplicará de momento

Probablemente, la última vez que oyó cómo un ordenador convertía un texto en un discurso oral, la máquina se atropellase y sonase bastante enlatada. La división de aprendizaje de máquinas de Google, DeepMind, ha desarrollado un nuevo sistema de síntesis de voz con inteligencia artificial que podría mejora la situación.

Lograr que un ordenador produzca el sonido de una voz que parezca humana no es nuevo. Tal vez el enfoque más común sea simplemente emplear una enorme selección de fragmentos de diálogos grabados con anterioridad con la voz de una única persona. Bajo la técnica de síntesis concatenativa, estos fragmentos se unen para generar sonidos, palabras y frases más grandes. Por eso, gran parte de las voces generadas por ordenador a menudo sufren fallos, cambios de entonación absurdos y errores de pronunciación.

Por su parte, el enfoque rival emplea modelos matemáticos para recrear sonidos conocidos que se emparejan para formar palabras y frases. Aunque es menos propenso a errores, este enfoque paramétrico acaba sonando robótico. Pero ambos tienen algo en común: se basan en juntar trozos de sonidos en lugar de generar la onda de sonido al completo desde cero.

Crédito: Google DeepMind.

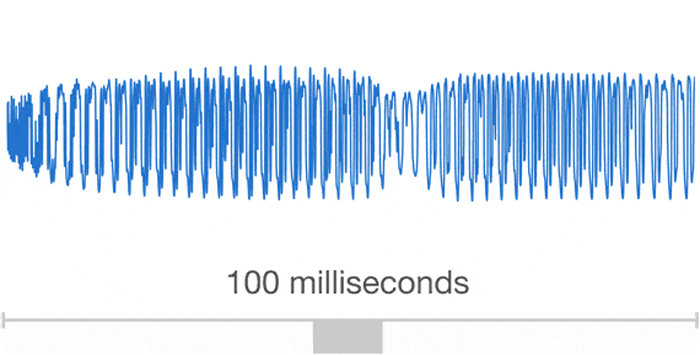

Y eso es justo lo que está haciendo DeepMind. Las redes neuronales se alimentan con grabaciones de voces humanas reales y sus características lingüísticas y fonéticas correspondientes, lo que permite a la máquina identificar patrones que relacionan ambas cosas. Después se le proporciona un nuevo hilo de características acústicas generado a partir de una línea de texto, y entonces intenta generar el sonido bruto desde cero. Primero produce una muestra de la onda de sonido, y después la siguiente y así sucesivamente.. En cada paso emplea los datos sobre las ondas anteriores para ayudar a generar las siguientes.

Los resultados suenan muy bien, como puede comprobarse aquí. En comparación con los otros dos enfoques, suena bastante más humano.

Pero hay una pega. La técnica requiere un montón de potencia computacional. Puesto que WaveNet tiene que crear la onda de sonido al completo, debe emplear sus procesos de red neuronal para generar 16.000 muestras por cada segundo de audio que genere (e incluso entonces, el sonido sólo es el equivalente de la calidad de sonido de la voz enviada por llamadas de teléfono o de voz sobre IP). Según una fuente de DeepMind que habló con el Financial Times, eso significa que no será empleado en ninguno de los productos de Google de momento.

Aun así, no es el único problema de lenguaje al que se enfrentan los ordenadores. Interpretar un discurso oral y escrito es increíblemente difícil para los sistemas de inteligencia artificial. A este ritmo, cuando los ordenadores por fin tengan fuerzas para reflexionar de forma verdaderamente inteligente, también podrán contárnoslo con estilo.

(Para saber más: DeepMind, Financial Times,)