Inteligencia Artificial

Los robots empiezan a imitar a los bebés para aprenderse las leyes de la física

Las máquinas han de poder predecir cómo se comportarán objetos dentro del mundo real, qué pasará por ejemplo si colocan un vaso lleno boca abajo o si empujan un sofá contra una pared

Los niños aprenden rápidamente a predecir qué pasará si ponen un vaso lleno de zumo boca abajo. Los robots, en cambio, no tienen ni idea.

Investigadores del Instituto Allen para la Inteligencia Artificial (Ai2) de Seattle (EEUU) han desarrollado un programa informático que demuestra cómo las máquinas determinan cómo es probable que se comporten los objetos captados por una cámara. Esto podría conseguir que los robots y otras máquinas sean menos propensos a los errores, y ayudaría a que a los coches autónomos naveguen solos en entornos desconocidos de forma más segura.

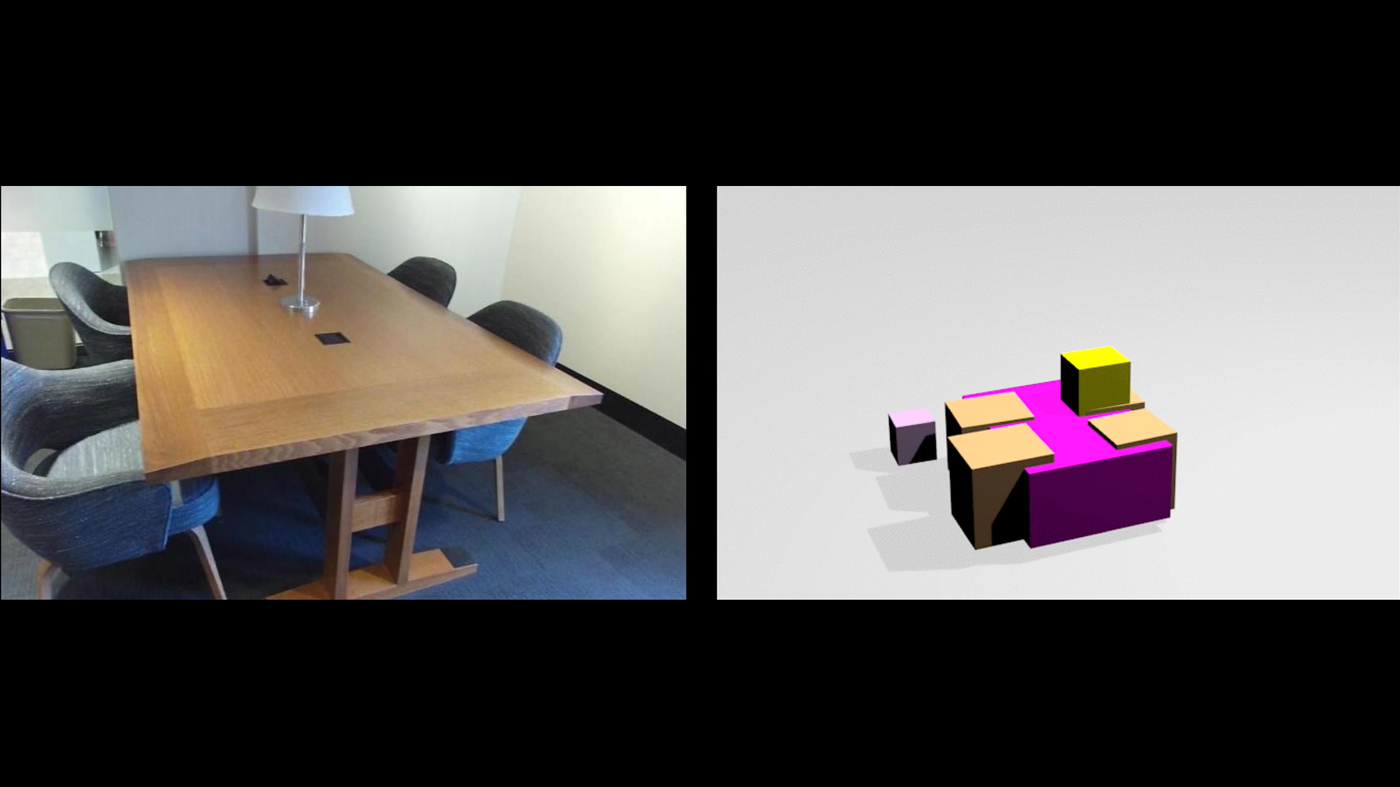

El sistema, desarrollado por Roozbeh Mottaghi y unos compañeros, saca conclusiones sobre las propiedades físicas de una escena gracias a una combinación de aprendizaje de máquinas y modelados en 3D. Los investigadores convirtieron más de 10.000 imágenes en escenas presentadas en un formato simplificado con el uso de un motor de física en 3D. Las imágenes en 3D fueron creadas por voluntarios mediante la plataforma de crowdsourcing Mechanical Turk de Amazon.

Los investigadores introdujeron las imágenes además de sus representaciones en 3D en un ordenador que ejecutaba una gran red neuronal de aprendizaje profundo. La red aprendió gradualmente a asociar una escena con determinadas fuerzas y movimientos sencillos. Cuando al sistema se le enseñaron imágenes desconocidas, podía sugerir las varias fuerzas que podrían estar en juego.

Aunque no funciona a la perfección, la mayoría de las veces el ordenador llega a una conclusión sensata. Para una imagen de una grapadora sobre una mesa, por ejemplo, el programa puede entender que la grapadora podría deslizarse por la superficie de la mesa y caer de repente al suelo. Para una imagen de una mesita baja y un sofá, sabe que la mesa podría ser empujada sobre el suelo hasta dar con el sofá.

"El objetivo es aprender la dinámica del motor de física. Hay que inferirlo todo a partir de la imagen visualizada", explica Mottaghi.

Este trabajo podría resultar especialmente útil para robots que necesiten interpretar rápidamente una escena para poder actuar en consecuencia. Incluso un robot equipado con un escáner 3D a menudo tendría que inferir la física de la escena que percibe. Y sería poco práctico hacer que aprenda cómo hacerlo todo mediante ensayo y error. Mottaghi explica: "La recopilación de datos para esto es muy difícil. Si llevo mi robot a una tienda, no puede empujar objetos y recopilar datos; sería muy costoso".

Este programa forma parte de un esfuerzo más grande llamado Proyecto Platón, dirigido a equipar las máquinas con inteligencia visual que vaya más allá del sencillo reconocimiento y la categorización de objetos. Un proyecto relacionado, también parte de Proyecto Platón, permite a un ordenador reconocer una fuerza física ya en juego: por ejemplo, cómo un esquiador se desplazará montaña abajo, o cómo una pelota de fútbol volará por los aires tras ser pateada.

En los últimos años, los ordenadores han mejorado mucho su análisis de imágenes gracias a los avances del aprendizaje profundo, un hardware más potente y grandes conjuntos de datos de imágenes etiquetadas. Después de alimentarse de muchos ejemplos, ahora pueden describir o contestar preguntas sobre una escena (ver El software de Google dice que en esa foto sale "un grupo de jóvenes jugando al frisbee" y Facebook ya sabe decirte qué sale en una foto). Para un entendimiento más profundo, un ordenador necesita comprender cómo funciona el mundo físico.

El investigador de la Universidad de Nueva York (EEUU) Brendan Lake, que está especializado en el modelado de capacidades cognitivas humanas, dice que el trabajo de Ai2 es un importante paso en esa dirección.

Lake afirma: "El entendimiento real de una escena no va solo de reconocer objetos. Cuando la gente mira una foto de una escena, cuenta una historia: ¿qué objetos hay, por qué están allí y qué pasará después? Entender la física es una pieza clave de contar esta historia".

Pero según el experto, la percepción humana incluye muchos más razonamientos, algo que podría ralentizar los progresos de la robótica y la visión de máquinas durante algún tiempo. "Estos progresos son emocionantes, pero aún no pueden competir con la capacidad humana de entender la física", dice, y concluye: "Las personas podemos entender un abanico muchísimo más amplio de eventos físicos, y podemos predecirlos con precisión en nuevos tipos de escenas".